【HDFS数据一致性进阶】:网络分区挑战与一致性保证方法

发布时间: 2024-10-29 14:20:14 阅读量: 43 订阅数: 22

# 1. HDFS数据一致性的基础概念

Hadoop分布式文件系统(HDFS)是大数据存储的核心组件,它设计用于运行在普通硬件上,提供高吞吐量的数据访问。在分布式系统中,数据一致性是保证数据可靠性和系统稳定性的关键因素。

## HDFS数据一致性的含义

在HDFS中,数据一致性的含义主要是确保数据副本之间保持同步。当用户写入数据到HDFS时,系统会创建数据的多个副本来提高容错性和可用性。一致性保证了无论从哪个节点读取数据,用户都将获得最新的、不变的数据副本。

## 数据一致性模型的重要性

HDFS的数据一致性模型对于理解整个文件系统的操作至关重要。它帮助系统确定在写操作后多久副本之间需要同步,以及在发生故障时如何恢复数据状态。HDFS通过一系列内部机制来维护数据一致性,这是保障大数据处理正确性的基石。理解数据一致性的基本原理对于优化和故障排查都有着直接的影响。

```mermaid

flowchart LR

A[数据写入] -->|副本同步| B[副本一致性]

B --> C[数据读取]

C -->|返回结果| D[用户]

D -->|一致性保证| E[系统稳定性]

```

本章将详细介绍HDFS数据一致性的基础知识,为深入探讨其在网络分区等复杂场景下的表现奠定基础。

# 2. 网络分区对数据一致性的影响

## 2.1 网络分区的定义及影响

### 2.1.1 分区容错性问题的概述

在分布式系统中,网络分区(Network Partitioning)是一个系统设计者和运维人员必须面对的现实问题。网络分区可以简单地理解为网络中的一些节点无法与其他节点通信,导致原本应该统一的数据视图被分割成几个孤立的区域。分区容错性是分布式系统必须考虑的重要特性之一,它是指系统即便在网络分区的情况下,仍能继续提供服务,并最终达成一致性。

分区容错性的挑战在于它和一致性、可用性之间存在着著名的CAP定理(一致性、可用性、分区容错性),指出在任意时刻,一个分布式系统只能满足以上三个属性中的两个。这要求设计者在系统设计初期就需要确定这三者之间的权衡策略。

### 2.1.2 网络分区对分布式系统的影响

网络分区会对分布式系统的多个层面造成影响,最直观的就是对数据一致性的破坏。当分区发生时,各个分区内的节点无法了解其他分区内的最新数据状态,可能会产生数据的不一致。具体来说:

- 一些操作可能会在一个分区被成功执行,而在其他分区却未被应用。

- 如果没有有效的同步机制,不同分区的用户可能会得到不一致的数据视图。

- 在极端情况下,部分操作可能会被延迟或者阻塞,影响系统的可用性。

数据一致性问题会严重影响分布式系统的整体运行。因此,在设计和实施分布式系统时,需要特别考虑网络分区对一致性的影响,并采取适当的策略来减轻这种影响。

## 2.2 HDFS中的数据一致性模型

### 2.2.1 强一致性与最终一致性

Hadoop分布式文件系统(HDFS)作为一款分布式存储系统,必须解决网络分区带来的数据一致性问题。HDFS采用了最终一致性的模型,允许数据在分区时暂时不一致,但保证在一定时间内最终达到一致的状态。

- **强一致性**:要求系统对所有的操作都必须严格按照先发生的事情顺序来保持数据状态的一致性,无论系统是否发生分区。

- **最终一致性**:仅要求系统在没有新的更新操作后,经过一段时间能够保证达到一致的状态,但在等待期间允许系统是不一致的。

HDFS选择最终一致性而不是强一致性主要是基于实际应用中的性能考量,即在保证系统可用性和性能的同时,通过一些机制来保证数据最终的准确性。

### 2.2.2 HDFS中数据副本同步的挑战

HDFS通过在不同的数据节点上保存数据副本来保证数据的高可用性和容错性。在正常运行状态下,HDFS通过数据副本的同步机制来保证数据的一致性。然而网络分区使得数据副本间的同步变得复杂。

当网络分区发生时,各个数据副本之间无法实时通信。此时,数据更新操作可能会导致副本之间的数据不一致。HDFS对此采取的策略是:

- 在网络分区发生时,HDFS优先保证数据的可用性,允许数据的读取和写入。

- 等网络分区恢复后,HDFS通过一系列的同步和校验机制来解决数据不一致的问题。

由于网络分区的不确定性,HDFS不能保证分区期间数据副本的强一致性,因此HDFS的设计哲学是尽量减少分区发生的概率和影响,同时确保在网络分区解决后能快速恢复数据的一致性。

# 3. HDFS数据一致性的保证机制

## 3.1 HDFS的读写协议

### 3.1.1 写操作的数据一致性保证

在Hadoop分布式文件系统(HDFS)中,写操作涉及将数据写入多个数据节点(DataNode),以确保数据的高可用性和容错性。HDFS通过一种特殊的写入协议来保证数据的一致性。以下是HDFS保证写操作一致性的关键要素:

1. **写入流程**:首先,客户端向名称节点(NameNode)发起写操作请求。NameNode负责管理文件系统的元数据,并决定数据应写入哪些DataNode(称为副本放置策略)。写操作通常涉及将数据首先写入一个临时文件,然后将这些临时文件合并成最终文件,这个过程在HDFS中被称为“追加”和“完成”。

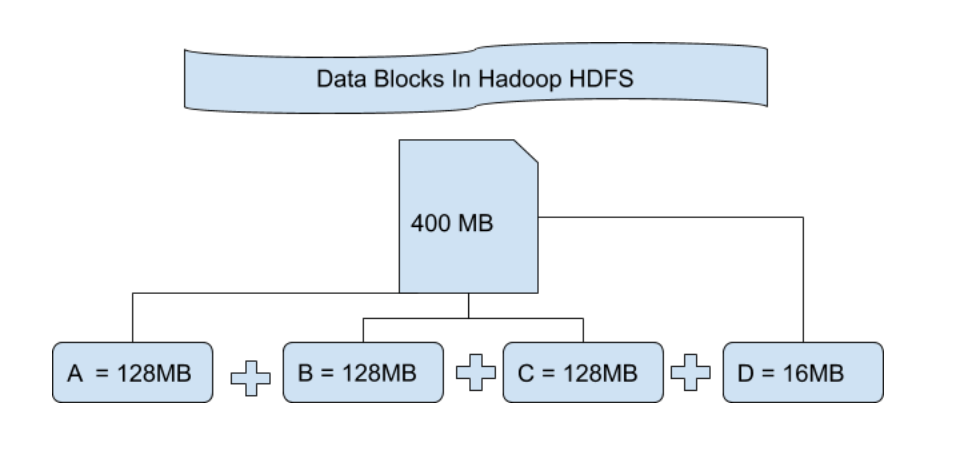

2. **数据副本策略**:HDFS默认采用3个副本的策略(可配置),确保在数据节点失败的情况下数据不会丢失。写操作成功完成需要至少一个数据节点成功接收数据。

3. **写确认**:客户端会接收到一个包含所有数据节点的写入确认列表。当至少一个数据副本成功写入后,客户端才会收到写操作成功的响应。

4. **一致性模型**:HDFS采用的

0

0