HDFS安全校验进阶篇:应对大规模数据完整性挑战的黄金策略

发布时间: 2024-10-29 19:29:28 阅读量: 26 订阅数: 19

# 1. HDFS安全校验的基础概念和重要性

Hadoop分布式文件系统(HDFS)作为大数据存储的核心组件,在保障数据安全方面扮演着重要角色。数据安全校验是确保存储在HDFS上的数据没有损坏、未被篡改或者不完整的重要手段。本章将先介绍HDFS安全校验的一些基础概念,然后再探讨其重要性。

## 1.1 HDFS安全校验的基本概念

HDFS安全校验主要关注于两个方面:数据完整性校验和访问控制。数据完整性校验确保数据在存储、传输过程中保持原始状态,没有发生错误或损坏。访问控制则是对数据访问权限的管理和控制。它们共同保障了数据的保密性、完整性和可用性。

## 1.2 数据完整性校验的必要性

数据完整性校验对于避免数据丢失或损坏至关重要。在大数据环境中,数据的规模巨大,且数据在多个节点间频繁移动,这增加了数据损坏的风险。通过校验可以及时发现和纠正数据问题,保证数据的可靠性,这对于数据驱动的决策和分析具有基础性的影响。

## 1.3 访问控制的必要性

HDFS通过其权限模型确保只有授权用户才能访问和操作数据。这是防止未授权访问和数据泄露的关键安全措施。访问控制策略能够确保数据的安全,防止恶意操作和数据篡改,同时也能保护用户隐私。

总结来说,HDFS安全校验不仅保证了数据的完整性,还确保了数据的安全性和访问权限的控制,这对于构建一个稳定和安全的大数据环境是不可或缺的。接下来的章节我们将深入探讨HDFS数据完整性校验的具体实现机制及其优化措施。

# 2. HDFS的数据完整性校验机制

## 2.1 HDFS校验的基础算法和原理

### 2.1.1 校验算法的选择和应用

在分布式文件系统Hadoop中,HDFS为确保数据的可靠性和完整性,采用了特定的校验算法。选择合适的校验算法对保证大规模数据存储环境下的数据准确性至关重要。

最常用的校验算法之一是MD5,它通过计算数据块的散列值来确保数据的一致性。但是,HDFS通常采用的是CRC32校验和算法,因为它在计算和验证速度上相对于MD5等哈希函数更优,特别适合分布式存储系统中大规模数据块的校验需求。

在HDFS中,每个数据块都维护一个32位的CRC校验和,文件被分割成多个块时,每个块都会有一个对应的CRC校验和。当数据写入HDFS时,系统会计算出数据块的CRC值并存储。读取数据时,系统会对读取的数据块重新计算CRC,并与存储在元数据中的值进行比对,确保数据未在传输或存储过程中被篡改或损坏。

```java

import java.util.zip.Checksum;

public class CRC32Example {

public static void main(String[] args) throws Exception {

// 创建一个CRC32对象实例

CRC32 crc = new CRC32();

// 数据缓冲区

byte[] data = "HDFS Data Integrity Check".getBytes();

// 更新数据并计算CRC

crc.update(data, 0, data.length);

// 获取CRC32校验和

long checksumValue = crc.getValue();

System.out.println("CRC32 value: " + checksumValue);

}

}

```

上述Java代码演示了如何使用CRC32算法计算数据的校验和。首先,创建了一个CRC32实例,然后使用update方法输入数据,最后通过getValue方法获取CRC32校验和的值。

### 2.1.2 校验过程的详细解析

HDFS数据校验的过程分为写入校验和读取校验两个阶段。详细步骤如下:

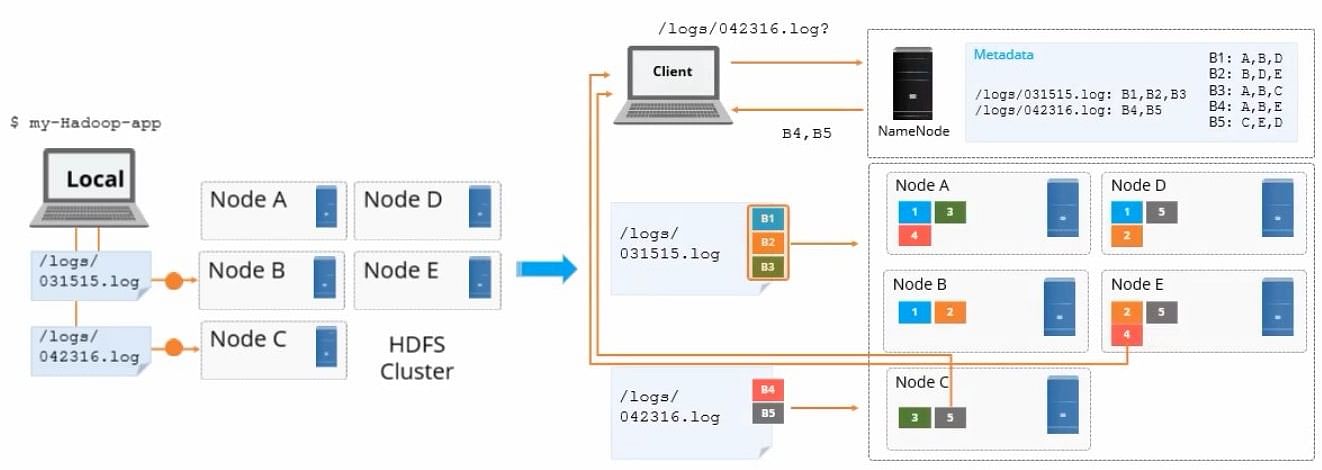

1. **写入校验**:当客户端将数据写入HDFS时,NameNode会为文件分配数据块并指定存储的DataNode。在将数据块写入DataNode的同时,客户端也会计算每个数据块的CRC32校验和,并将校验和信息一并发送到DataNode。

2. **校验和存储**:DataNode接收到数据块和校验和后,会将数据存储在本地,并把校验和信息写入到本地的元数据文件中。这个过程确保了数据块在写入阶段的完整性和一致性。

3. **读取校验**:当客户端从HDFS读取数据时,DataNode会发送数据块以及校验和给客户端。客户端负责进行CRC校验,一旦发现不匹配,即认为数据块损坏。

4. **自动修复**:HDFS会在后台运行DataNode,通过心跳机制检测DataNode的状态,一旦发现数据块损坏,会自动触发复制机制,从其他正常副本中复制未损坏的数据块。

```java

public class HdfsDataIntegrity {

// 伪代码,展示数据读取时的校验过程

public void readAndVerifyData(String filePath) throws Exception {

FileSystem fs = ... // 获取FileSystem实例

FSDataInputStream input = fs.open(new Path(filePath));

CRC32 crc32 = new CRC32();

// 读取数据块并更新CRC校验和

byte[] buffer = new byte[4096];

while (true) {

int bytesRead = input.read(buffer);

if (bytesRead == -1) break;

crc32.update(buffer, 0, bytesRead);

}

// 获取校验和并与HDFS中的校验和比对

long actualChecksum = crc32.getValue();

long expectedChecksum = ... // 从HDFS元数据中获取预期的校验和

if (actualChecksum == expectedChecksum) {

System.out.println("Data integrity verified successfully.");

} else {

System.out.println("Data corruption detected.");

}

}

}

```

上述Java伪代码演示了在客户端读取数据时如何进行数据完整性校验。它通过读取数据并更新CRC32校验和,最后将计算出的校验和与HDFS元数据中存储的值进行比较。如果两者匹配,说明数据块在传输或存储过程中未被破坏。

## 2.2 HDFS的数据校验策略和实现

### 2.2.1 数据块级别的校验策略

在HDFS中,数据以块的形式存储,每个块有一个唯一的块标识符和校验和。HDFS将数据块存储在多个DataNode上以提供冗余,确保了数据的高可用性和容错能力。块级别的校验策略是HDFS中保障数据完整性的关键机制。

DataNode在接收到来自客户端的数据块和相应的CRC32校验和后,会将数据写入本地文件系统,并将校验和保存在本地。在数据块写入过程中,DataNode会周期性地计算每个块的校验和,并与从客户端接收到的校验和进行对比。如果在任一阶段发现校验不一致,DataNode将触发数据块的重新复制。

```java

public class BlockLevelIntegrityCheck {

public static void main(String[] args) throws Exception {

// 模拟一个数据块

byte[] dataBlock = ... // 假设这是从客户端接收到的数据块

long expectedChecksum = ... // 假设这是数据块预期的校验和

// 创建CRC32实例用于计算校验和

CRC32 crc32 = new CRC32();

```

0

0