【R语言shiny数据管道优化法】:高效数据流管理的核心策略

发布时间: 2024-11-10 01:10:02 阅读量: 31 订阅数: 49

# 1. R语言Shiny应用与数据管道简介

## 1.1 R语言与Shiny的结合

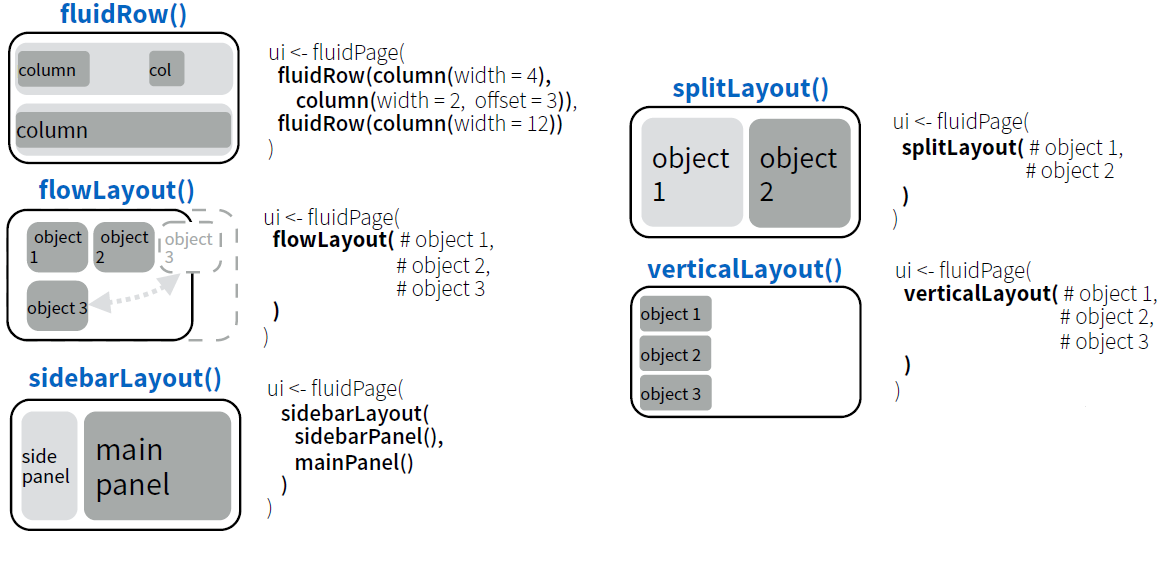

R语言以其强大的统计分析能力而在数据科学领域广受欢迎。Shiny,作为一种基于R语言的Web应用框架,使得数据分析师和数据科学家能够通过简单的代码,快速构建交互式的Web应用。Shiny应用的两大核心是UI界面和服务器端脚本,UI负责用户界面设计,而服务器端脚本则处理数据和逻辑。

## 1.2 数据管道的概念及其重要性

数据管道(Data Pipeline)是指将数据从源头移动到目的地的一系列操作,确保数据的提取、转换、加载(ETL)过程高效且稳定。在Shiny应用中,数据管道是构建反应式数据处理流程的基础,它允许我们实时响应用户输入,动态更新数据。

## 1.3 Shiny与数据管道的整合

将数据管道的概念应用于Shiny,可实现高度动态和交互式的用户体验。数据管道帮助我们组织和优化数据处理流程,使得Shiny应用可以高效地处理复杂的数据集。接下来的章节,我们将深入探讨数据管道的基础理论、实践应用、优化策略,以及在高级场景中的应用和安全维护。

# 2. 数据管道的基础理论与实践

## 2.1 数据管道的概念框架

### 2.1.1 什么是数据管道

数据管道,是一个用于传输数据流的概念模型,它描述了数据从一个源点移动到目的地的过程。在软件领域,数据管道通常被用来自动化数据从源系统流向目标系统的流程,可以处理数据的收集、传输、转换、清洗和加载等一系列操作。

在IT行业中,数据管道是数据工程的核心概念,特别是在大数据处理领域,数据管道能够帮助开发者有效地管理大量数据的流动,提高数据处理效率。数据管道的设计和实现需要考虑到数据的一致性、可靠性、效率和可扩展性。

### 2.1.2 数据管道的重要性与优势

数据管道的重要性在于其简化了数据处理流程,提高了数据处理的效率和可靠性。使用数据管道,企业可以实现数据的实时处理和分析,快速响应业务变化。

数据管道的优势体现在:

- **自动化处理**:数据管道支持自动化处理数据的整个生命周期,减少人工干预。

- **可扩展性**:良好的数据管道设计允许系统随数据量的增长而进行扩展。

- **实时处理**:数据管道可以设计为实时处理数据,为企业提供即时的数据洞察。

- **数据整合**:数据管道能够整合来自不同源的数据,为数据分析提供统一视图。

- **容错能力**:数据管道支持数据的重新处理和恢复,提高了系统的鲁棒性。

## 2.2 数据管道在Shiny中的实现

### 2.2.1 Shiny的反应式编程基础

Shiny是R语言的一个用于构建交互式Web应用的框架。它的核心是反应式编程模型,允许开发者以声明式的方式构建用户界面和后端逻辑。反应式编程是数据管道中不可或缺的一部分,因为它提供了构建动态用户界面的能力。

在Shiny中,反应式表达式和反应式值是反应式编程的基础。反应式表达式可以自动侦测输入值的变化,并且在变化时重新计算。例如,一个简单的反应式表达式可以是:

```r

library(shiny)

ui <- fluidPage(

sliderInput("num", "Choose a number", 1, 100, 50),

textOutput("square")

)

server <- function(input, output) {

output$square <- renderText({ input$num ^ 2 })

}

shinyApp(ui = ui, server = server)

```

在这个例子中,`input$num` 是一个反应式值,`renderText` 中的代码块会根据 `input$num` 的改变自动重新计算输出。

### 2.2.2 构建简单数据管道的示例

构建一个数据管道通常涉及多个步骤,包括数据提取、转换、加载(ETL)。在Shiny中,我们可以利用反应式编程创建一个简单的数据管道:

```r

library(shiny)

ui <- fluidPage(

selectInput("dataset", "Choose a dataset:", choices = c("mtcars", "iris")),

tableOutput("data")

)

server <- function(input, output) {

dataset <- reactive({

switch(input$dataset,

"mtcars" = mtcars,

"iris" = iris)

})

output$data <- renderTable({

dataset()

})

}

shinyApp(ui = ui, server = server)

```

在上述示例中,用户可以从下拉菜单中选择一个数据集(`mtcars` 或 `iris`)。`reactive` 函数创建了一个反应式数据管道,当用户选择不同的数据集时,反应式表达式会自动更新并显示新的数据表。这只是一个非常基础的实现,但展示了如何在Shiny中使用反应式编程构建简单的数据管道。

## 2.3 数据管道中的数据处理

### 2.3.1 数据转换技术

在数据管道中,数据转换是一项重要的工作,其目的是将原始数据转换为更适合分析的格式。在R语言中,我们可以使用 `dplyr` 包提供的函数进行数据转换。

例如,我们可以对数据进行过滤、排序、分组、聚合等操作。这里是一个使用 `dplyr` 进行数据转换的例子:

```r

library(dplyr)

mtcars %>%

filter(cyl == 4) %>%

arrange(mpg) %>%

group_by(gear) %>%

summarise(mean_mpg = mean(mpg))

```

该代码段使用管道操作符 `%>%` 将 `mtcars` 数据集传递给 `filter` 函数,过滤出气缸数为4的车辆,然后按 `mpg` 排序,并按 `gear` 分组,最后计算每组的平均 `mpg`。

### 2.3.2 数据清洗与验证方法

数据清洗是数据预处理的重要环节,目的在于提高数据质量,使数据更加准确和可靠。在R中,我们可以使用 `tidyr` 包来辅助数据清洗工作。

比如,使用 `tidyr` 的 `pivot_longer` 和 `pivot_wider` 函数来转换数据的格式,或者使用 `drop_na` 函数去除数据中的缺失值。在数据验证方面,我们可以定义一些规则来检查数据的一致性和完整性。

```r

library(tidyr)

# 将宽格式数据转换为长格式

mtcars_long <- mtcars %>%

pivot_longer(cols = -c(cyl, vs), names_to = "variable", values_to = "value")

# 检查数据中是否包含NA值

if(any(is.na(mtcars_long))) {

print("数据中包含缺失值。")

}

```

在上面的代码中,`pivot_longer` 函数将 `mtcars` 数据集中的除 `cyl` 和 `vs` 列以外的其他列转换为两列,其中一列是变量名 `variable`,另一列是对应的值 `value`。接着,我们通过检查 `any(is.na(mtcars_long))` 来判断数据集 `mtcars_long` 是否包含任何NA值。

通过这些步骤,数据经过了初步的清洗和验证,从而提高了数据管道中数据的质量。

# 3. 数据管道的优化策略

## 3.1 优化数据管道的理论基础

### 3.1.1 识别性能瓶颈

在数据管道的设计和实现中,性能瓶颈的识别是至关重要的步骤。性能瓶颈会导致数据处理的延迟,降低整个系统的响应速度和效率。识别性能瓶颈涉及对数据流、计算资源消耗、内存使用情况等进行深入分析。通常,性能瓶颈出现在数据读写操作、数据转换过程、以及数据加载和卸载过程。

为了识别性能瓶颈,可以使用分析工具来监控数据管道各环节的执行时间和资源消耗。例如,R语言中可以使用`profvis`包来分析Shiny应用的性能,并通过`shiny`包中的`reactiveLog`函数来记录反应式表达式的执行情况。以下是使用`profvis`包进行性能分析的基本步骤:

```r

# 安装并加载profvis包

install.packages("profvis")

library(profvis)

# 运行Shiny应用并进行性能分析

profvis({

# 这里放置Shiny应用代码

})

```

分析结束后,`profvis`会生成一个交互式的性能分析报告,其中可以直观地看到各个反应式表达式、函数调用的执行时间,这有助于开发者快速定位性能瓶颈。

### 3.1.2 理解数据流的并发和依赖

数据流的并发和依赖关系是数据管道优化的重要因素。理解数据流中的依赖关系有助于设计更加高效的数据处理序列。在Shiny应用中,数据流通常是反应式的,意味着数据的任何变化都会触发相关计算。因此,合理的并发执行可以显著提升整体性能,而依赖关系则决定了数据处理的顺序。

为了优化依赖关系,可以采取如下措施:

- **最小化依赖范围**:通过将数据处理过程拆分成更小的、相互独立的模块,减少模块之间的依赖关系,从而减少不必要的数据更新和计算。

- **控制反应式表达式的触发**:合理使用`isolate()`函数或其他反应式绑定函数来避免不必要的数据流触发。

- **利用Shiny的`observe`和`reactive`结构**:它们分别用于监听数据变化和响应数据变化,有助于开发者控制数据流的执行时机和顺序。

## 3.2 实践中的优化技术

### 3.2.1 高效的反应式表达式写法

反应式表达式是构建数据管道的基础,其写法直接影响数据处理的效率。为了提升效率,开发者应遵循以下原则:

- **尽量使用延迟加载**:利用`reactive`而不是`observe`

0

0