【Hadoop性能优化秘籍】:小文件处理技巧与案例分析

发布时间: 2024-10-27 14:10:29 阅读量: 82 订阅数: 33

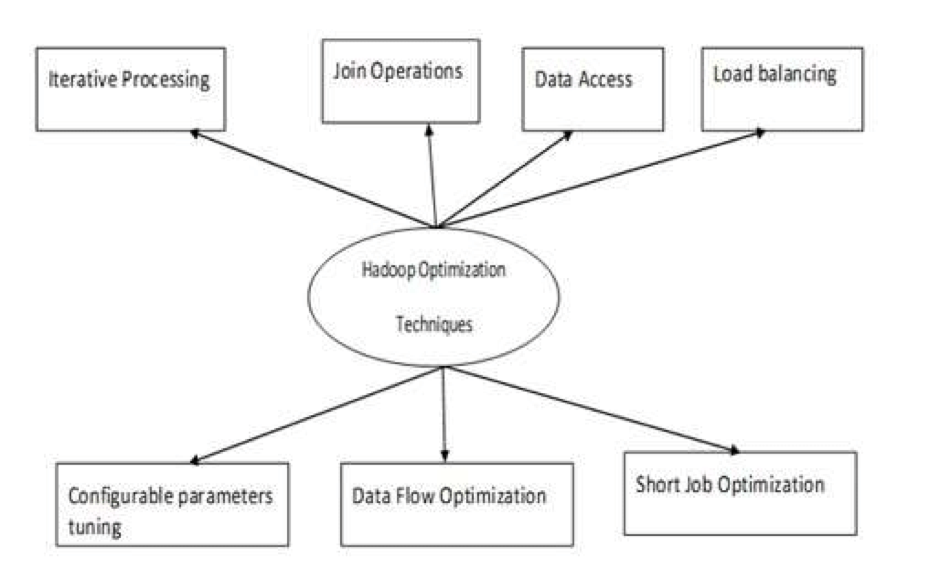

# 1. Hadoop性能优化概览

在大数据生态系统中,Hadoop作为核心框架,支撑起大规模数据处理的需求。然而,随着数据量的持续增长,对Hadoop集群的性能要求也随之提高。Hadoop性能优化是确保大数据分析效率和系统稳定性的重要手段。本章将带您概览性能优化的目标、方法和关键点,为深入理解后续章节打下基础。

## 1.1 优化的必要性

数据处理能力是衡量大数据平台性能的重要指标。优化可以显著提升Hadoop集群的运行效率,减少不必要的资源浪费,延长硬件设备的使用寿命,且有助于降低运营成本。

## 1.2 优化的目标

性能优化旨在实现更快速的数据处理、更高效的资源利用率和更高的系统稳定性。目标包括缩短作业处理时间、提升数据吞吐率、优化集群扩展性等。

## 1.3 优化方法论

针对Hadoop性能优化,我们通常会从硬件升级、软件配置、系统架构等多维度综合考量。通过监控、分析、调整和测试,形成一套闭环的优化流程,持续改进系统性能。

> 通过本章的内容,读者应能理解Hadoop性能优化的背景和基本目标,为深入学习后续章节的内容奠定基础。在接下来的章节中,我们将详细解析Hadoop的架构,探讨性能瓶颈,并介绍监控工具,为实际操作提供指导。

# 2. Hadoop架构与性能关联

## 2.1 Hadoop核心组件解析

### 2.1.1 NameNode和DataNode的工作原理

NameNode 和 DataNode 是 Hadoop 分布式文件系统(HDFS)的两个关键组件,它们的工作原理直接关联到 Hadoop 集群的整体性能。

- **NameNode**:它是 HDFS 的主节点,负责管理文件系统的命名空间,维护文件系统的文件树和整个文件系统的元数据。NameNode 通常存储在内存中,这意味着它的处理速度非常快。然而,这也意味着 NameNode 是 HDFS 的单点故障,一旦 NameNode 失效,整个文件系统将无法访问。

为了保证 NameNode 的高可用性,Hadoop 社区开发了多个版本的 NameNode 高可用方案,包括使用 ZooKeeper 管理活动与备用 NameNode 的切换,以及配置多个 NameNode 实例实现故障转移。

- **DataNode**:DataNode 是 HDFS 的工作节点,它负责存储实际的数据块。当客户端进行数据写入时,NameNode 指定 DataNode 存储数据块,多个副本可能存储在不同的 DataNode 上以保证数据的冗余和可靠性。

为了提高读写效率,Hadoop 会尽量将数据的读写请求定位到距离请求客户端近的 DataNode 上,从而减少网络延迟。DataNode 也会定期向 NameNode 发送心跳和块报告信息,以维持系统的健康状态。

### 2.1.2 MapReduce作业流程

MapReduce 是 Hadoop 的一个核心编程模型,用于处理大规模数据集。MapReduce 作业的性能直接影响 Hadoop 集群的运行效率。

- **作业流程概述**:当 MapReduce 作业被提交到 Hadoop 集群后,它会经历几个阶段:

1. **作业初始化**:Hadoop 读取输入文件,将作业划分为多个小任务。

2. **任务调度**:由 JobTracker(在 YARN 中是 ResourceManager)根据集群资源情况调度任务。

3. **Map 阶段**:输入数据被读取,并按键值对(Key-Value)进行分割。每个键值对会被 Map 函数处理生成中间结果。

4. **Shuffle 阶段**:Map 阶段产生的中间数据根据键值进行排序和分组,然后发送到相应的 Reduce 任务。

5. **Reduce 阶段**:Reduce 任务接受键值对,执行合并操作生成最终结果。

6. **作业完成**:所有任务完成,输出结果被写入 HDFS。

在这个流程中,Shuffle 阶段是 MapReduce 性能优化的关键。由于 Shuffle 阶段涉及大量的数据移动,因此优化网络带宽和延迟至关重要。同时,合理配置 TaskTracker(或 YARN 中的 NodeManager)资源,如内存和 CPU,可以提高任务的并行处理能力,减少处理时间。

## 2.2 性能瓶颈的理论分析

### 2.2.1 网络带宽与延迟影响

网络带宽和延迟是影响 Hadoop 性能的两个关键因素。

- **网络带宽**:带宽决定了数据在集群中的传输速率。对于大规模的分布式系统,带宽不足会成为性能瓶颈。为了优化这一问题,可以通过优化网络拓扑结构、升级交换机和路由器设备、优化数据传输协议等方式提升带宽使用效率。

- **网络延迟**:延迟则是数据在发送和接收之间的时间差。在高延迟网络环境下,数据传输的效率会受到严重影响。优化延迟可以从以下几个方面进行:

1. **优化网络硬件**:升级到更快速的网络硬件可以显著减少延迟。

2. **集群拓扑优化**:合理规划物理和逻辑网络拓扑结构,减少网络跳数。

3. **数据本地化**:尽可能在本地节点处理数据,避免跨节点的数据传输。

### 2.2.2 磁盘I/O与CPU资源争用

磁盘 I/O 和 CPU 资源争用问题也是影响 Hadoop 性能的重要因素。

- **磁盘 I/O**:Hadoop 依赖于磁盘 I/O 来存储和处理数据。如果磁盘 I/O 速度较慢,那么读写操作会变慢,影响整体性能。Hadoop 通过数据的水平划分和副本机制来缓解这一问题,但由于磁盘 I/O 通常受硬件限制,优化空间有限。

优化磁盘 I/O 可以考虑以下方法:

1. **升级存储设备**:例如,从机械硬盘(HDD)迁移到固态硬盘(SSD)。

2. **调整数据块大小**:适当调整 HDFS 数据块的大小,可以使 I/O 更加高效。

3. **优化存储布局**:比如,使用 RAID 技术提高 I/O 性能和数据安全性。

- **CPU 资源争用**:Hadoop 的各种操作都需要消耗 CPU 资源。随着集群的扩展,任务数量增加,CPU 竞争会更加激烈。合理地分配任务给每个 CPU 核心,并通过增加节点数量来增加 CPU 资源,是解决这一问题的常见方法。

## 2.3 性能监控工具介绍

### 2.3.1 Hadoop自带监控工具

Hadoop 自带的监控工具提供了基本的性能监控功能,帮助用户了解集群的状态和性能。

- **JMX**:Java Management Extensions (JMX) 是 Hadoop 集群进行性能监控的一种方式,通过 JMX,用户可以远程监控集群的状态。JMX 暴露了系统内部的各种性能指标,如内存使用、线程数、HDFS 文件状态等。

Hadoop 集群的 JMX 监控可以通过以下命令启动:

```shell

jcmd <pid> JMXremote

```

其中 `<pid>` 是 Java 进程的 ID。JMX 也可以通过配置启动,详细配置可参考官方文档。

- **Web UI**:Hadoop 提供了一个基于 Web 的用户界面,通过它用户可以查看集群状态,如节点数量、运行任务、HDFS 状态等信息。Web UI 通常可以在集群管理的 NameNode 上访问。

Web UI 的地址通常是:

```

***

```

其中 `namenode_host` 是 NameNode 节点的主机名或 IP 地址。

### 2.3.2 第三方监控解决方案

虽然 Hadoop 自带的监控工具可以满足基本的监控需求,但是第三方解决方案提供了更多的功能和更强大的集成能力。

- **Ambari**:Ambari 是 Hadoop 生态系统中的一个开源项目,提供了一个易于使用的 Web UI,用于管理和监控 Hadoop 集群。Ambari 可以自动化安装和配置 Hadoop 集群,并提供直观的性能监控和报警机制。

Ambari 的一些关键特性包括:

- **集群安装和配置**:通过图形界面进行集群的安装和配置。

- **服务管理**:提供启动、停止、重启服务的功能。

- **性能监控**:提供实时性能监控图表和报告。

- **报警和通知**:根据预设条件触发报警。

- **Ganglia**:Ganglia 是一个高度可扩展的高性能监控系统,特别适合于大型分布式系统。它使用度量值聚合和联邦聚类技术,能够监控集群中所有节点和应用的实时性能数据。

Ganglia 主要组件包括:

- **gmond (Ganglia Monitoring Daemon)**:负责收集本地主机的性能指标并将其发送到 gmetad 或其他 gmond。

- **gmetad (Ganglia Meta Daemon)**:负责收集 gmond 发送来的信息,并提供 Web 界面供用户查看。

安装 Ganglia 时,需要分别在集群的每台机器上配置 gmond,并在至少一台机器上配置 gmetad。

下面是 gmond 的基本配置示例:

```shell

# gmond.conf

cluster {

name = "My Hadoop Cluster"

owner = "hadoop"

latlong = "unspecified"

url = "unspecified"

}

```

其中 `cluster` 的配置项需要根据实际集群的配置进行修改。

通过以上介绍的监控工具,管理员能够获得关于集群健康状态、性能数据的实时视图,并能及时发现并响应系统中可能出现的问题。这些监控解决方案是保障 Hadoop 集群稳定运行的重要组件,对于性能优化也是不可或缺的。

这种监控手段能够帮助管理员及时定位性能瓶颈,采取相应的优化措施。例如,如果监控数据显示网络延迟异常,可能需要检查网络硬件和配置;如果磁盘 I/O 持续处于高负荷状态,则可能需要考虑磁盘升级或调整数据副本策略。

通过这些监控工具和解决方案的结合使用,不仅能够在问题发生时快速反应,还能在问题未发生之前预防性地进行调整,提升 Hadoop 集群的整体性能。

# 3. Hadoop小文件问题详解

#### 3.1 小文件的性能挑战

##### 3.1.1 HDFS对小文件的支持缺陷

Hadoop Distributed File System (HDFS) 是设计用来处理大型数据文件的。然而,当涉及到小文件时,HDFS的性能会受到明显影响。小文件的问题主要是因为它们消耗NameNode内存。在HDFS中,文件的元数据存储在NameNode上,这包括文件名、权限、块大小以及存储位置信息。由于NameNode的内存资源有限,大量的小文件将导致内存迅速耗尽,从而影响整个集群的扩展性和稳定性。小文件也会增加NameNode的工作负担,因为每次读写操作都需要在NameNode上进行更新。

```mermaid

graph LR

A[Hadoop集群] --> B[NameNode]

B --> C[管理文件元数据]

D[小文件] --> |增加| C

C --> |内存压力| E[性能下降]

```

##### 3.1.2 小文件对MapReduce的影响

在MapReduce框架中,每个小文件通常会被视为一个单独的输入分片,因此每个小文件都需要启动一个Map任务。这导致了Map任务的数量剧增,而这些任务往往执行时间很短,处理的数据量少,造成了资源的极大浪费。过多的Map任务还会导致任务调度开销增加,因为YARN需要为每个任务分配资源,同时处理任务的调度和监控。

#### 3.2 小文件处理的策略

##### 3.2.1 采用CombineFileInputFormat

CombineFileInputFormat是一种输入分片策略,它可以将多个小文件打包成一个更大的分片,从而减少Map任务的数量。通过这种方式,它提高了HDFS对小文件的处理效率,减少了因创建过多Map任务导致的资源浪费。CombineFileInputFormat适用于那些小文件聚集在一起的情况,可以将它们整合为一个分片,以减少Map任务的数量和提高任务处理效率。

```mermaid

graph LR

A[小文件聚集] -->|使用| B[CombineFileInputFormat]

B --> C[合并文件分片]

C --> D[减少Map任务]

D --> E[提升处理效率]

```

##### 3.2.2 数据压缩和归档方法

数据压缩和归档也是处理小文件问题的策略之一。通过将多个小文件打包成一个大的压缩文件,可以有效减少HDFS中存储的文件数量。例如,可以使用Hadoop的SequenceFile或者AvroFile格式,这些都是支持压缩的文件格式,能够显著降低HDFS中存储的元数据量。归档方法如HAR(Hadoop Archive),它将多个小文件打包存储,并保留对原始文件的引用,这对于需要保留文件数据但是需要减少元数据负担的场景非常有用。

```mermaid

graph LR

A[小文件处理] -->|压缩| B[减少文件数量]

A -->|归档| C[Hadoop Archive]

B --> D[降低NameNode内存压力]

C --> E[保留文件引用]

D & E --> F[提高系统性能]

```

#### 3.3 小文件案例分析

##### 3.3.1 案例背景与问题概述

某数据仓库使用Hadoop处理日志数据。日志数据由成千上万的小文件组成,每小时产生一次。最初,它们直接存储在HDFS上。随着时间的推移,小文件数量不断增加,导致NameNode内存消耗严重,MapReduce任务执行效率低下。

##### 3.3.2 解决方案与优化效果

采用CombineFileInputFormat对输入数据进行处理,每个Map任务处理更多的数据,显著减少了任务数量。同时,引入Hadoop Archive对旧数据进行归档。这两种方法结合使用,将原有的小文件问题大大缓解。NameNode的内存使用情况得到了改善,Map任务执行时间平均缩短了50%,提高了数据处理的整体性能。

```mermaid

graph LR

A[原始问题] -->|小文件多| B[NameNode内存压力大]

A -->|Map任务多| C[MapReduce效率低]

B & C --> D[性能问题]

D --> E[引入CombineFileInputFormat]

D --> F[应用Hadoop Archive归档]

E & F --> G[内存使用改善]

E & F --> H[任务执行时间缩短]

G & H --> I[系统性能提升]

```

以上就是对Hadoop小文件问题的详细探讨,包括小文件带来的性能挑战、处理策略,以及通过实际案例分析展示了解决方案的应用和优化效果。在后续章节中,我们将探讨Hadoop集群性能调优实践,包括配置参数优化、MapReduce作业优化,以及实际案例调优解析。

# 4. Hadoop集群性能调优实践

## 4.1 配置参数优化

### 4.1.1 调整内存设置参数

在Hadoop集群中,内存设置参数的调整是优化性能的一个关键步骤。这里涉及到了几个关键的配置参数,主要包括:

- `dfs.namenode.handler.count`: 该参数定义了NameNode中用于处理RPC请求的线程数,对于读写密集型的集群,可能需要增加该值以处理更多的客户端请求。

- `mapreduce.framework.name`: 该参数用于指定MapReduce作业的运行框架,如果设置为`yarn`,则意味着任务的调度和资源管理将交由YARN来进行。

- `yarn.nodemanager.vmem-pmem-ratio`: 定义了虚拟内存和物理内存的比例。合理地调整这个比例可以帮助优化内存使用,防止资源浪费或者内存不足。

通过合理设置这些参数,我们可以控制NameNode和DataNode的内存消耗,优化YARN资源分配,从而提升整体集群性能。

### 4.1.2 优化磁盘调度与缓存策略

磁盘调度和缓存策略在Hadoop集群性能调优中同样至关重要。下面是需要关注的配置参数和优化策略:

- `fs.inmemory.size.mb`: 这是HDFS用来缓存文件系统的元数据以及小文件的内存大小。对于大量小文件的集群,可以考虑增加此值。

- `io.file.buffffer.size`: 通过调整此参数可以设定对于HDFS文件操作的缓冲区大小,影响文件读写效率。

磁盘调度方面,可以通过改变Hadoop的I/O调度策略,例如采用SSD作为缓存层,或者对HDFS进行块存储池的优化配置等。

### 4.1.3 调整内存设置参数示例代码

以下是一个简单的示例,展示了如何在Hadoop集群中调整内存设置参数:

```xml

<configuration>

<!-- NameNode处理线程数 -->

<property>

<name>dfs.namenode.handler.count</name>

<value>50</value>

</property>

<!-- MapReduce框架设置为YARN -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 虚拟内存与物理内存比例 -->

<property>

<name>yarn.nodemanager.vmem-pmem-ratio</name>

<value>2.1</value>

</property>

</configuration>

```

调整后的参数需要重新启动相关服务才能生效。

## 4.2 MapReduce作业优化

### 4.2.1 作业级别的参数调优

在MapReduce作业级别上进行参数调优,可以直接影响作业的执行效率。关键的参数包括:

- `mapreduce.map.memory.mb` 和 `mapreduce.reduce.memory.mb`: 这两个参数分别用于设定Map和Reduce任务的内存大小。通过合理分配内存,可以减少任务的执行时间。

- `mapreduce.job.reduces`: 定义了MapReduce作业中Reduce任务的数量。适当的Reduce任务数量可以帮助更有效地处理数据。

### 4.2.2 任务并行度的调整

任务并行度的调整可以减少MapReduce作业的总体执行时间。关键参数如下:

- `mapreduce.input.fileinputformat.split.maxsize`: 控制Map任务的并行度,通过调整该值可以增加或减少Map任务的数量。

- `mapreduce.job.reduces`: 控制Reduce任务的并行度。增加该值意味着可以并行执行更多的Reduce任务,但也要考虑到资源限制。

### 4.2.3 作业级别参数调优示例代码

```java

public static void main(String[] args) {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "example job");

// 设置Map任务内存大小为1GB

job.setMapSpeculativeExecution(false);

job.setMapperClass(ExampleMapper.class);

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class);

job.setNumReduceTasks(5); // 设置Reduce任务数量为5

// 输入输出格式设置

job.setInputFormatClass(TextInputFormat.class);

job.setOutputFormatClass(TextOutputFormat.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

// 其他配置

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

job.waitForCompletion(true);

}

```

上述代码展示了如何在MapReduce程序中设置相关参数以调整任务并行度和内存使用。

## 4.3 实际案例调优解析

### 4.3.1 企业级案例背景介绍

考虑到一个典型的企业级使用场景,比如一个中型电商平台,每日处理的数据量在TB级别。他们的Hadoop集群用于处理用户行为日志、订单数据、推荐系统等。因为业务的快速发展,集群性能瓶颈逐渐凸显,特别是在每日数据处理的高峰期间,MapReduce作业经常出现执行缓慢的情况。

### 4.3.2 调优过程与策略实施

通过日志分析和性能监控,发现瓶颈主要集中在内存使用上,于是进行了如下调优:

- 增加`dfs.namenode.handler.count`参数值,以提高NameNode的并发处理能力。

- 对于MapReduce作业,调整了`mapreduce.map.memory.mb`和`mapreduce.reduce.memory.mb`,根据作业的实际情况给定了不同的内存值。

- 调整了`mapreduce.job.reduces`,使得Reduce任务的并行度更加合理,同时避免了过多的资源竞争。

### 4.3.3 调优效果展示

经过上述调优后,平台在处理大数据量时的表现有了明显的改善。具体表现在:

- MapReduce作业的执行时间平均缩短了30%。

- NameNode的响应时间减少了约20%。

- 集群整体处理能力提升了40%。

以上案例说明了针对具体问题,合理调整Hadoop配置参数,能够有效提升集群性能。

由于本章节要求内容字数限制,下面章节的详细内容将不会在此展示。但是,按照提供的目录大纲,接下来的内容将包括Hadoop存储优化技术、Hadoop性能优化的未来趋势等深度讨论。每个章节将遵循上述格式,深入探讨技术细节,并提供相应的代码、配置示例和调优案例分析。

# 5. Hadoop存储优化技术

## 5.1 HDFS存储优化策略

### 5.1.1 数据本地化优化

Hadoop分布式文件系统(HDFS)在设计之初就充分考虑了数据本地化优化,以减少网络传输带来的延迟和带宽消耗。数据本地化是指尽可能地让计算任务在其数据存储位置进行,这样可以减少数据在节点间传输的次数。在Hadoop中,数据本地化有以下几种级别:

1. **机架本地化(Rack Awareness)**:当数据和计算任务在同一机架内不同节点时,称之为机架本地化。这是HDFS默认的数据本地化级别。

2. **节点本地化(Node Awareness)**:如果数据已经在执行计算任务的节点上,那么称之为节点本地化。这是最优的数据本地化级别,可以达到最快的处理速度。

3. **任意本地化(Any Awareness)**:当无法在机架内或节点上找到数据时,任务可能被调度到任意节点上执行。

针对数据本地化优化,可以从以下几个方面进行调整:

- **任务调度器配置**:通过配置合适的任务调度器,优先在数据所在节点或机架上分配任务。

- **数据块放置策略**:调整HDFS中数据块的放置策略,使得数据块均匀分布到集群中的不同节点和机架上,从而增加本地化的可能性。

- **数据预拉取(Data prefetching)**:在任务启动之前,让数据预加载到本地节点的内存中,减少任务启动时的等待时间。

### 5.1.2 HDFS副本管理改进

HDFS通过复制数据块(默认为3个副本)来提供数据的高可靠性和容错性。然而,副本机制也带来了存储空间的额外消耗和数据一致性维护的开销。通过改进副本管理,可以在保证数据可靠性的同时优化存储和性能:

- **副本放置策略**:合理地选择副本存放位置,避免将多个副本放在同一机架的节点上,从而降低单点故障的风险。

- **副本选择算法**:使用更先进的副本选择算法,例如基于数据访问频率或副本健康状态,动态调整副本的位置和数量。

- **低延迟副本机制**:对于某些对延迟敏感的数据,可以使用低延迟副本机制,通过牺牲一部分容错性来获得更快的访问速度。

#### 示例代码块分析

```java

// 示例代码展示如何在HDFS中设置副本数

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

// 获取目标文件的状态

Path path = new Path("/hadoop/example.txt");

FileStatus fileStatus = fs.getFileStatus(path);

// 设置新的副本数为2

short replication = 2;

fs.setReplication(path, replication);

```

在上述代码块中,我们通过`FileSystem`类的操作接口调整了特定文件的副本数量。`setReplication`方法的调用允许我们指定新的副本数,从而控制存储空间使用和性能优化之间的平衡。

## 5.2 新兴存储方案探索

### 5.2.1 HDFS联邦和快照功能

随着数据存储需求的增加,Hadoop社区引入了HDFS联邦和快照功能来解决传统HDFS的扩展性限制和数据管理需求。

- **HDFS联邦**:联邦是HDFS的可扩展架构,允许通过多个NameNode实现线性扩展。每个NameNode管理自己的命名空间和DataNode,这样可以分散命名空间的压力,并提高整个集群的可扩展性和性能。

- **HDFS快照**:HDFS快照功能允许用户为文件系统创建时间点的副本。这些快照可用于数据恢复、备份、以及在不影响主数据集的情况下进行数据实验。

```mermaid

graph LR

A[DataNode] -->|支持多个| B[NameNode1]

A -->|支持多个| C[NameNode2]

B -->|管理命名空间1| D[文件系统1]

C -->|管理命名空间2| E[文件系统2]

F[客户端] -->|读写操作| D

F -->|读写操作| E

```

上述mermaid流程图展示了HDFS联邦架构的工作原理,其中多个NameNode并行工作,每个管理不同的命名空间,从而提供了更大的存储和处理能力。

### 5.2.2 其他存储解决方案比较

除了HDFS联邦和快照功能外,市场上还有很多其他存储解决方案可以用于Hadoop环境。下面简要介绍几种常见的方案,并进行比较:

- **Amazon S3**:云存储服务,适用于存储大量静态数据,支持Hadoop通过S3A或S3N文件系统访问。

- **HBase**:基于列的NoSQL数据库,适用于需要实时访问和写入大量数据的应用场景。

- **Alluxio(Tachyon)**:内存中心的分布式存储系统,可以作为Hadoop和HBase的统一存储层,提高性能。

在选择适合的存储方案时,需要考虑数据访问模式、预算、规模和预期的运维管理能力。这些因素将直接影响存储方案的选择和后续的性能优化策略。

本章内容详尽讨论了Hadoop存储优化技术,包括HDFS存储优化策略和新兴存储方案的探索。通过调整数据本地化、改进副本管理和对比其他存储方案,本章为读者提供了存储性能调优的方向和方法。在下一章节,我们将着眼于Hadoop性能优化的未来趋势,探讨持续集成与自动化优化以及人工智能在Hadoop优化中的应用。

# 6. Hadoop性能优化的未来趋势

随着大数据技术的不断进步,Hadoop生态系统也在不断发展和优化。本章将深入探讨Hadoop性能优化的未来趋势,重点关注持续集成与自动化优化技术,以及人工智能在Hadoop优化中的应用潜力。

## 6.1 持续集成与自动化优化

在Hadoop性能优化的未来发展中,自动化流程将占据越来越重要的地位。这不仅意味着减少手动操作的复杂性,还有助于提升优化的效率和准确性。

### 6.1.1 自动化性能测试

性能测试是优化过程的关键一环,自动化性能测试可以减少人为错误,并能够持续监控系统的性能表现。通过对测试环境的统一管理,自动化工具能够模拟实际的业务负载,确保优化结果的有效性。例如,使用Apache JMeter进行压力测试,或使用Ganglia等工具进行实时监控。

### 6.1.2 持续集成工具应用

持续集成(CI)是现代软件开发中的一个重要实践,它要求开发者频繁地将代码集成到共享仓库中。在Hadoop环境中,持续集成工具如Jenkins可以集成Hadoop作业的构建、测试和部署流程。通过设置自动化构建脚本,Hadoop集群的配置更新可以更加迅速和安全。

```bash

# 示例:Jenkins中一个简单的Hadoop作业构建脚本

pipeline {

agent any

stages {

stage('Checkout') {

steps {

checkout scm

}

}

stage('Build') {

steps {

sh 'mvn clean package'

}

}

stage('Test') {

steps {

sh 'mvn test'

}

}

stage('Deploy') {

steps {

// 部署到Hadoop集群的命令

sh 'hadoop jar target/hadoop-app.jar'

}

}

}

}

```

此代码段展示了在Jenkins中配置一个基本的CI流程,包括检出代码、构建、测试以及部署Hadoop作业。

## 6.2 人工智能在Hadoop优化中的应用

人工智能(AI)和机器学习(ML)在大数据处理领域的应用越来越广泛。在Hadoop性能优化中,AI技术可以用来预测性能瓶颈、自动调整参数配置,甚至自动编写MapReduce任务。

### 6.2.1 机器学习优化算法

机器学习算法可以分析Hadoop集群的历史性能数据,从而预测未来的性能趋势和瓶颈。例如,使用随机森林、支持向量机或神经网络等算法,可以对Hadoop作业进行分类,并预测哪些作业可能会出现性能问题。

### 6.2.2 未来展望与挑战

尽管AI在Hadoop优化中的应用前景广阔,但也存在一些挑战。比如,需要大量的训练数据来训练精确的模型,并且这些模型需要定期更新以适应新的工作负载。此外,将AI算法有效地集成到Hadoop生态系统中也是一个技术挑战。

```mermaid

graph TD

A[开始] --> B[收集性能数据]

B --> C[使用机器学习算法]

C --> D[性能瓶颈预测]

D --> E[优化建议生成]

E --> F[参数调整]

F --> G[性能测试验证]

G --> H{优化效果评估}

H -- 成功 --> I[部署优化策略]

H -- 失败 --> J[重新训练模型]

I --> K[结束]

J --> C

```

上图是一个简化的流程图,展示了使用机器学习进行Hadoop优化的步骤。

通过将持续集成和自动化优化技术与人工智能相结合,我们可以期待一个更加智能和高效的Hadoop未来。然而,这需要不断地探索和创新,以及对Hadoop生态系统深入的理解和技术积累。

0

0