【Hadoop NameNode保护】:小文件影响下的应对措施

发布时间: 2024-10-27 14:44:31 阅读量: 31 订阅数: 27

高可用性的HDFS:Hadoop分布式文件系统深度实践

# 1. Hadoop NameNode的基本概念和作用

## Hadoop NameNode的基本概念

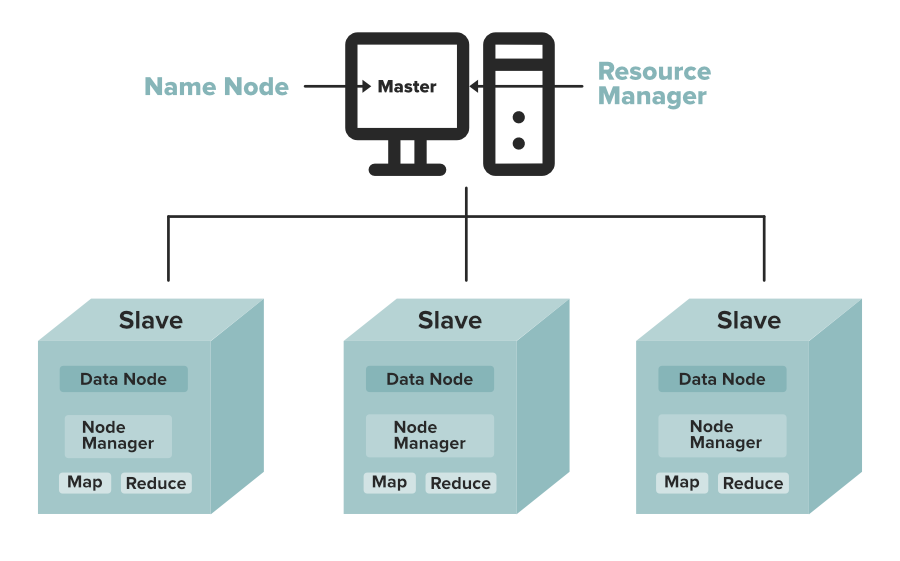

Hadoop NameNode是Hadoop分布式文件系统(HDFS)的核心组件之一,负责管理文件系统的命名空间以及客户端对文件的访问。NameNode维护了整个文件系统的元数据,包括文件和目录信息,以及文件到数据节点(DataNode)的映射关系。元数据包括文件系统的结构信息,但不包括实际的数据。

## Hadoop NameNode的核心作用

在HDFS架构中,NameNode是协调者和管理者,承担着多项关键职责:

- **元数据存储**:保存所有文件目录和文件属性,如权限、修改时间、访问时间等。

- **命名空间管理**:处理创建、删除和重命名文件以及目录的操作。

- **客户端请求处理**:响应客户端发起的文件读写请求。

由于Hadoop的分布式特性,NameNode通过一系列机制保证了系统的高可用性,如Secondary NameNode和Checkpoint Node等,它们用于定期合并编辑日志和文件系统元数据,减少主NameNode的负载。

Hadoop NameNode是整个Hadoop生态系统中的关键组成部分,它的稳定运行对于保证数据的可靠存储与高效访问具有决定性作用。下一章节将深入探讨Hadoop小文件问题,并阐述其对NameNode的具体影响。

# 2. ```

# 第二章:小文件问题的理论分析

## 2.1 Hadoop小文件问题的定义和影响

### 2.1.1 小文件问题的定义

在Hadoop生态系统中,小文件问题通常指的是大量小文件存储在Hadoop Distributed File System(HDFS)上所引发的一系列问题。小文件通常定义为那些远小于HDFS块大小(默认为128MB或256MB)的文件。这些文件的大小可能只有几KB到几MB不等。由于HDFS的设计初衷是优化大规模文件的存储和处理,小文件带来的碎片化存储和NameNode内存压力会严重影响集群的性能和可扩展性。

### 2.1.2 小文件问题对NameNode的影响

HDFS的NameNode需要为存储在集群中的每一个文件和目录维护元数据信息。随着小文件数量的增加,NameNode内存中存储的元数据数量也会剧增。由于NameNode内存的限制,这会导致NameNode的内存耗尽,最终影响整个Hadoop集群的稳定性和性能。此外,过多的小文件会导致过多的NameNode心跳和数据块报告(block report)请求,增加了网络负载并可能导致NameNode成为瓶颈。

## 2.2 小文件问题的产生原因和机制

### 2.2.1 HDFS文件存储机制与小文件问题

HDFS设计为存储大文件提供了优化。每个文件被切分成一个或多个块(block),这些块存储在数据节点(DataNode)上,而NameNode负责管理文件的命名空间和存储的元数据。对于小文件,HDFS为了保证容错性,每个小文件都将占据一个完整的块,这样就导致了存储空间的浪费。同时,每个小文件都需要元数据记录,从而导致NameNode内存的压力。

### 2.2.2 应用场景与小文件问题的关联性

小文件问题在数据采集和日志文件等场景中尤为突出。例如,在日志处理或实时数据分析场景中,每个日志项或消息往往被存储为单独的文件。由于这些文件通常很小,它们会迅速累积成大量的小文件,使得HDFS在处理这些小文件时效率极低。这类场景对实时性要求较高,小文件问题的存在不仅拖慢了处理速度,还增加了系统维护的复杂性。

## 2.3 理论分析的意义和应用前景

### 2.3.1 理论分析在实际应用中的重要性

深入理解小文件问题的理论基础有助于设计更加合理和高效的大数据存储策略。理论分析能够揭示问题的根本原因,并帮助开发者和系统管理员预测和避免潜在的性能瓶颈。在实践中,对小文件问题的深入理解可以指导我们采取适当的优化措施,从而保证大数据系统的高效稳定运行。

### 2.3.2 小文件问题解决方向的探索

针对小文件问题,目前已有多种解决方案和策略被提出和实施。包括但不限于使用文件合并工具、调整HDFS配置参数、开发专门的自动化工具等。理论分析有助于我们评估这些解决方案的有效性,并为将来可能出现的新技术指明方向。随着分布式计算技术的不断发展,对于小文件问题的理解和解决方法也将不断创新和进步。

接下来的章节中,我们将进一步探索Hadoop NameNode保护的实践策略,并通过实际案例分析展示如何在实践中应对小文件问题。

```

# 3. Hadoop NameNode保护的实践策略

在本章节中,我们将深入探讨Hadoop NameNode保护的具体实践策略。这包括了针对小文件存储的优化策略,NameNode保护的具体技术手段,以及实践策略的案例分析。通过对这些策略和案例的详细讨论,我们将了解如何在现实环境中实现有效的NameNode保护。

## 3.1 优化小文件存储的策略

### 3.1.1 文件合并技术的运用

在Hadoop生态系统中,小文件存储问题一直是影响集群性能和资源利用率的关键因素之一。文件合并技术作为一种有效的解决手段,可以帮助我们合并多个小文件为少数几个较大的文件,从而减轻NameNode的负担并提高整体性能。

#### 实现方法

一个简单且常用的方法是使用MapReduce的Map阶段对文件进行合并操作。Map任务会读取原始的小文件,并在Map阶段将它们的键值对输出为中间键值对。Reducer阶段将相同键的值进行合并,最终输出为较大的文件。

```java

public class FileMergeJob {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "File Merge Job");

job.setJarByClass(FileMergeJob.class);

job.setMapperClass(MergeMapper.class);

job.setReducerClass(MergeReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(Text.class);

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

class MergeMapper extends Mapper<LongWritable, Text, Text, Text> {

private Text fileContent = new Text();

private Text fileNameKey = new Text();

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// Use file name as key and content as value

fileNameKey.set(value.toString()

```

0

0