【提升数据处理效率】:Hadoop中小文件存储优化技术

发布时间: 2024-10-27 14:21:39 阅读量: 30 订阅数: 26

# 1. Hadoop中小文件存储问题概述

## 1.1 Hadoop存储挑战

在大数据处理的背景下,Hadoop生态系统面临着一个普遍的问题:处理大量的小文件。小文件问题不仅影响存储效率,还对数据处理速度产生显著的负面影响。本章将概述小文件存储问题,并探讨其背后的原因以及对Hadoop性能的具体影响。

## 1.2 小文件定义

小文件通常指的是那些在Hadoop分布式文件系统(HDFS)中占用较少存储空间的文件,常常被定义为小于HDFS块大小(默认为128MB)的文件。这些小文件在Hadoop集群中广泛存在,尤其是在日志分析和Web数据收集等场景中。

## 1.3 小文件影响

小文件的存在会导致NameNode的内存压力增大,因为HDFS需要为每个文件维护元数据。随着小文件数量的增加,NameNode的内存可能耗尽,从而影响到整个集群的性能和稳定性。接下来的章节将深入探讨这些问题,并提供相应的优化策略。

# 2. 理论基础 - Hadoop文件系统和小文件问题

### 2.1 Hadoop分布式文件系统(HDFS)原理

#### 2.1.1 HDFS的设计目标与架构

Hadoop分布式文件系统(HDFS)是一个高度容错性的系统,适合在廉价硬件上运行。它设计用来支持大文件存储,并能够提供高吞吐量的数据访问,特别适用于大规模数据集的应用。

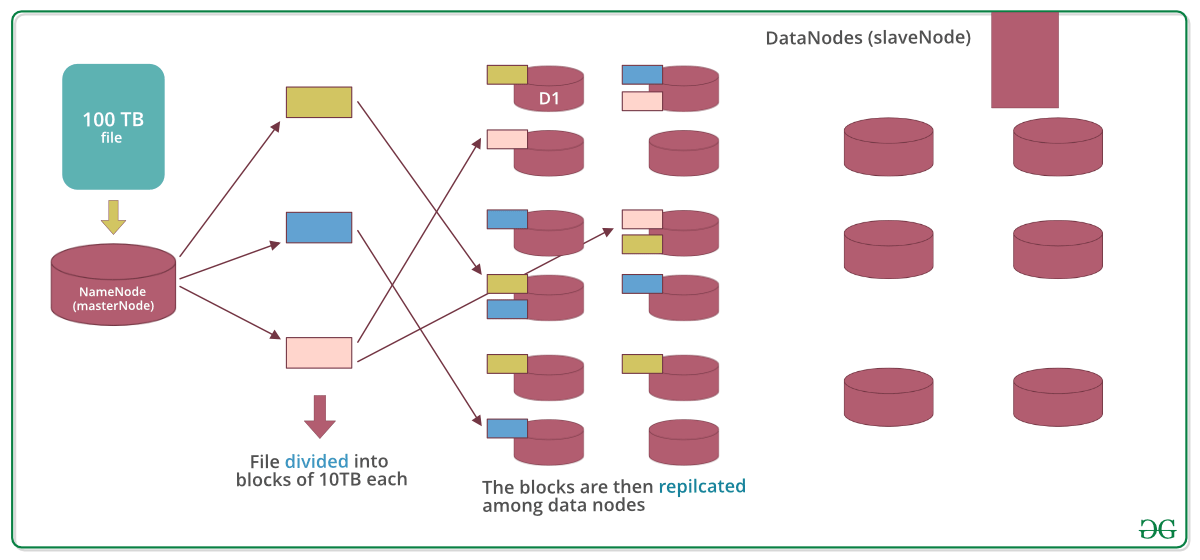

HDFS采用主/从(Master/Slave)架构,分为以下两个主要组成部分:

- NameNode(主节点):负责管理文件系统的命名空间,维护文件系统树及整个树内所有的文件和目录。此外,NameNode也记录每一个文件中各个块所在的DataNode节点。

- DataNode(数据节点):实际存储数据的节点,负责处理文件系统客户端的读/写请求,同时执行数据块的创建、删除等操作。

#### 2.1.2 HDFS中的文件存储机制

在HDFS中,文件被切分成一个或多个块(block),默认大小为128MB(Hadoop 2.x之前为64MB)。这些块被独立存储在多个DataNode上。为了保证数据的可靠性和容错性,HDFS会对每个块做复制,复制的数量(即副本数)可以在创建文件时设置,并可动态调整。默认副本数为3,意味着每个数据块会被存储在不同的DataNode上。

HDFS采用懒惰写入策略,当文件被写入时,先存储在本地缓冲区。当缓冲区满或用户明确调用关闭文件时,数据会被复制到DataNode。

### 2.2 小文件存储问题的成因和影响

#### 2.2.1 小文件定义和产生的原因

小文件在Hadoop语境下通常指的是那些比HDFS块大小小得多的文件。对于默认块大小为128MB的HDFS来说,小文件可能只有几KB或几十MB。

小文件可能由以下原因产生:

- 应用程序设计:某些应用程序可能生成大量的小文件,例如日志文件、某些类型的数据库文件。

- 数据导入方式:如果数据导入到HDFS时没有适当的预处理,会导致大量小文件的产生。

- 不合理的数据分割:数据在处理过程中被划分成许多小部分,但没有合并,导致大量的小文件。

#### 2.2.2 小文件对Hadoop性能的影响

小文件问题对Hadoop集群的性能产生显著影响,原因包括:

- NameNode的内存压力:在HDFS中,所有的文件系统元数据(如文件名、权限、块映射等)都存储在NameNode的内存中,小文件会导致NameNode的内存资源被大量消耗。

- 降低数据的读写效率:小文件意味着更多数量的块,导致更多的元数据操作和网络通信开销。

- 增加NameNode的负载:NameNode需要处理更多的块创建和删除请求,这会增加其负载,从而影响整体系统的稳定性。

### 2.3 传统存储优化方法的局限性

#### 2.3.1 合并小文件的技术方案

为了解决小文件问题,传统上会采取一些技术方案来合并小文件:

- 使用Hadoop Archive:Hadoop Archive是一个高度压缩的文件容器,它可以通过合并多个小文件到一起减少NameNode的内存消耗。

- 自定义MapReduce作业:编写MapReduce作业来读取小文件,并在Map阶段输出较大的文件块。

#### 2.3.2 传统方案的优缺点分析

虽然这些技术方案可以缓解小文件问题,但它们也存在一些局限性:

- 性能问题:传统方案在执行时可能需要大量的计算资源和时间,尤其是对大规模数据集。

- 兼容性:一些优化方案可能需要对现有系统进行较大的改动,导致在新旧Hadoop版本间的兼容性问题。

- 管理复杂度:维护和管理这些方案可能需要额外的工作量,增加了运维的复杂性。

接下来,我们将深入了解在Hadoop生态系统中是如何通过实践来解决这些问题的。第三章将详细介绍小文件存储优化技术实践,其中包含在Hadoop 3.x中引入的新优化技术,以及如何使用现有的工具进行小文件处理。

# 3. 小文件存储优化技术实践

随着大数据处理需求的增长,对Hadoop性能的优化成为研究和实践的热点。在众多优化策略中,小文件存储优化尤其引人关注。第三章专注于解决Hadoop中小文件存储问题的技术实践,展示一系列实用的技术方案和工具。

## 3.1 Hadoop生态系统中的解决方案

Hadoop生态系统提供了多种工具来应对小文件存储问题,其中一些已经在Hadoop 3.x版本中得到了显著改进。

### 3.1.1 Hadoop 3.x中的小文件存储优化技术

Hadoop 3.x版本引入了多种新特性来缓解小文件存储问题。其中,最引人注目的是对HDFS的扩展性增强,这为处理大规模小文件提供了新的可能性。

- **Erasure Coding**: 通过将数据编码成多个片段并分别存储,可以在不牺牲数据可靠性的前提下减少对NameNode内存的需求。

- **HDFS Federation**: 引入了多个NameNode来管理命名空间,从而提高了系统的扩展性和容错性。

- **支持更大的文件**: 通过引入大页(Large Pages)和更高效的内存管理,增加了对大文件的支持,间接提升了小文件处理效率。

### 3.1.2 兼容旧版本Hadoop的小文件处理工具

对于仍在使用旧版本Hadoop的用户,市场上也存在许多第三方工具和解决方案来缓解小文件问题。

- **Apache Hadoop Archive (HAR)**: 是一个旧的但广泛使用的技术,它可以帮助归档小文件到更少的HDFS块中,以减少NameNode内存消耗。

- **Sqoop和Flume**: 用于数据导入和收集的工具,能够将小文件批量导入到HDFS的更大文件中。

## 3.2 基于HDFS的文件合并工具使用

Hadoop本身提供了一些文件合并工具,可以帮助用户处理分散的小文件问题。

### 3.2.1 Hadoop Archive工具的原理和应用

Hadoop Archive工具能够将小文件打包成HAR文件,这些HAR文件在HDFS中占据更少的块,从而减少NameNode的负担。

- **压缩和打包**: HAR工具将多个小文件打包成一个大的HAR文件,并且可以进行压缩,以节省存储空间。

- **访问性能**: 虽然HAR文件可能会牺牲一些随机访问性能,但是在处理大量小文件时,可以通过减少元数据的数量来提升性能。

```bash

hadoop archive -archiveName name.har -p /user/hadoop/input /user/hadoop/output

```

在上述命令中,`-archiveName` 参数指定HAR文件的名称和位置,`-p` 参数后跟的是原始小文件所在的路径,以及它们被打包后存放在HDFS上的位置。

### 3.2.2 文件合并的实际操作步骤

合并文件操作需要多个步骤,并要考虑到文件的组织方式和访问模式。

1. **收集数据**: 将相关的小文件集中到一个目录下。

2.

0

0