XGBoost回归分析中的模型融合:打造更强大的预测模型,提升数据挖掘准确性

发布时间: 2024-08-20 04:03:47 阅读量: 48 订阅数: 30

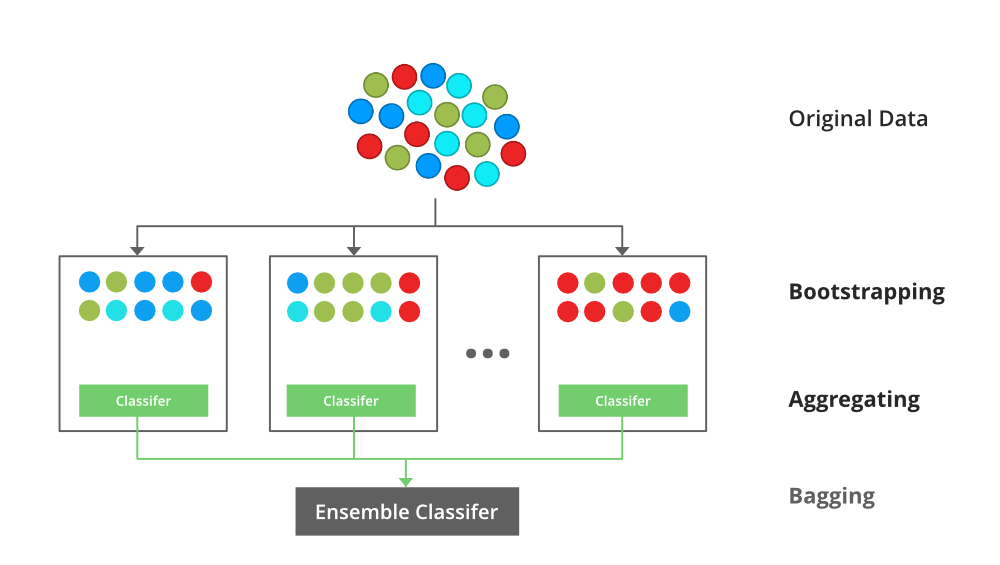

# 1. 模型融合概述**

### 1.1 模型融合的概念和优势

模型融合是一种机器学习技术,它通过组合多个模型的预测结果来提高整体预测性能。它通过利用不同模型的优势,弥补它们的不足,从而获得比单个模型更准确和鲁棒的预测。

### 1.2 模型融合的类型和方法

模型融合有多种类型,包括:

* **加权平均法:**根据每个模型的预测置信度或权重,对模型预测结果进行加权平均。

* **投票法:**根据每个模型的预测结果,进行多数表决或加权投票。

* **堆叠法:**将多个模型的预测结果作为输入特征,构建一个新的元模型进行最终预测。

# 2. XGBoost回归分析基础

### 2.1 XGBoost算法原理和特点

**2.1.1 梯度提升决策树**

XGBoost是一种基于梯度提升算法的机器学习模型,它通过构建一系列决策树来预测目标变量。每个决策树都基于前一个决策树的预测误差进行训练,从而逐步减少整体预测误差。

**2.1.2 正则化和特征选择**

XGBoost算法引入了正则化项,包括L1正则化和L2正则化,以防止过拟合。L1正则化通过惩罚模型中特征的绝对值来实现特征选择,而L2正则化通过惩罚模型中特征的平方值来实现特征选择。

### 2.2 XGBoost回归模型构建和评估

**2.2.1 数据预处理和特征工程**

在构建XGBoost回归模型之前,需要对数据进行预处理和特征工程,包括数据清洗、缺失值处理、特征缩放和特征选择。

**2.2.2 模型超参数调优**

XGBoost算法具有大量的超参数,需要通过调优来获得最佳模型。常用的超参数包括:

* `n_estimators`:决策树的数量

* `max_depth`:决策树的最大深度

* `learning_rate`:学习率

* `reg_alpha`:L1正则化参数

* `reg_lambda`:L2正则化参数

**2.2.3 模型评估和选择**

模型构建完成后,需要对模型进行评估,常用的评估指标包括:

* 均方根误差(RMSE)

* 平均绝对误差(MAE)

* R平方值(R2)

通过比较不同模型的评估指标,选择性能最佳的模型。

```python

import xgboost as xgb

# 构建XGBoost回归模型

model = xgb.XGBRegressor(n_estimators=100, max_depth=5, learning_rate=0.1, reg_alpha=0.1, reg_lambda=0.1)

# 训练模型

model.fit(X_train, y_train)

# 预测结果

y_pred = model.predict(X_test)

# 评估模型

rmse = np.sqrt(mean_squared_error(y_test, y_pred))

mae = mean_a

```

0

0