计算机组成原理:案例分析与问题解决实战演练指南

发布时间: 2024-12-14 06:14:56 阅读量: 5 订阅数: 14

平凡的探索: 单片机工程师与教师的思考

参考资源链接:[计算机组成原理课后习题及答案-唐朔飞(完整版).ppt](https://wenku.csdn.net/doc/645f3404543f8444888ac128?spm=1055.2635.3001.10343)

# 1. 计算机组成原理概述

## 1.1 计算机的基本概念

计算机是一种能够按照指令执行一系列操作,并能够处理数据的电子设备。它是现代信息技术的核心,通过预设的程序,对输入的数据进行加工处理,最终输出结果。这个处理过程涉及到数据的输入、处理、存储和输出等基本功能,而这正是计算机系统的四个基本组成部分。

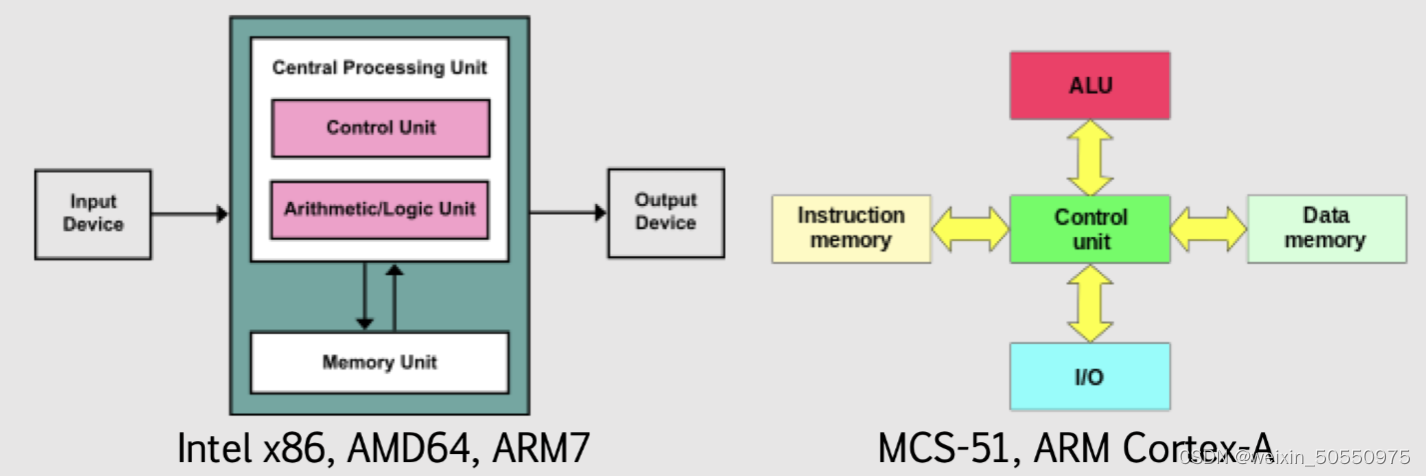

## 1.2 计算机组成结构

在计算机组成结构方面,最基础的五个部分包括:中央处理器(CPU)、存储器(Memory)、输入设备(Input Device)、输出设备(Output Device)以及外部设备(External Device)。它们各自扮演着重要的角色,相互协作完成各种计算任务。

## 1.3 计算机的工作原理

计算机的工作原理基于冯·诺伊曼架构,主要功能是执行指令。计算机在执行程序时,CPU 从存储器中取出指令,解析指令,并执行指令规定的操作。存储器则用来存放程序和数据。输入输出设备分别负责数据的输入与结果的输出。这个过程通过数据总线进行数据交换,指令总线传递执行指令,地址总线则指定数据交换的位置。

```mermaid

flowchart LR

A[输入设备] -->|数据| CPU[中央处理器]

CPU -->|控制信号| M[存储器]

CPU -->|控制信号| O[输出设备]

M -->|数据| CPU

M -->|数据| O

```

这个流程图简明地展示了计算机内部各部分的交互关系,清晰地体现了计算机的基本工作原理。

# 2. 数据表示与处理机制

## 2.1 数制和编码基础

### 2.1.1 二进制与十六进制转换

在现代计算机系统中,二进制是最基本的数据表示形式,而十六进制常用于简化二进制的显示,便于人们阅读和理解。理解二进制与十六进制之间的转换机制对于软件开发和硬件设计都有重要意义。

二进制与十六进制之间的转换遵循一组简单的规则。每一位十六进制数可以直接转换为一个四位的二进制数,反之亦然。例如,十六进制的 'A' 可以转换为二进制的 '1010',而二进制的 '1010' 对应的十六进制数是 'A'。

这里提供一个二进制转十六进制的转换示例:

```python

def binary_to_hex(binary_string):

hex_string = ''

# 以4位二进制为一个单位进行分割,不足补0

for i in range(0, len(binary_string), 4):

hex_digit = binary_string[i:i+4]

# 将4位二进制转换为对应的十进制数,再转换为十六进制字符

hex_string += format(int(hex_digit, 2), 'x')

return hex_string.upper()

binary_number = '110101011010'

hex_number = binary_to_hex(binary_number)

print(f"二进制数 {binary_number} 转换为十六进制为 {hex_number}")

```

在该代码块中,我们将一个长的二进制字符串转换为十六进制表示。代码逻辑是:从左到右,每次取出4位二进制数,转换为相应的十六进制字符,直到整个字符串被处理完毕。每一步都用 `int()` 函数将二进制数转为十进制数,然后用 `format()` 函数将十进制数转为十六进制字符,并使用 `'x'` 来得到小写的十六进制表示。最后,使用 `upper()` 函数将结果转换为大写形式,因为通常十六进制数在计算机中以大写形式表示。

通过上述方法,二进制数 '110101011010' 被转换成了十六进制数 'D5A'。

### 2.1.2 字符编码标准(ASCII与Unicode)

在计算机中,字符编码是一种将字符和数字序列对应起来的方法。两种广泛使用的字符编码标准是ASCII(American Standard Code for Information Interchange)和Unicode。

ASCII是基于英文字符的编码标准,它使用7位二进制数表示128个不同的字符。但是,随着计算机技术的全球化,ASCII标准无法满足表示所有语言字符的需求,因此出现了Unicode编码。

Unicode旨在为世界上所有的字符提供唯一的编码,它可以表示超过14万个字符,支持几乎所有的语言和符号。Unicode可以使用多种编码形式,包括UTF-8、UTF-16和UTF-32。

对于程序员来说,正确处理字符编码至关重要。例如,在Python 3中,默认的字符串类型是Unicode:

```python

text = "你好,世界!"

encoded_text = text.encode('utf-8')

decoded_text = encoded_text.decode('utf-8')

print(encoded_text) # 打印字节序列

print(decoded_text) # 打印解码后的字符串

```

在上述代码中,首先创建了一个Unicode字符串,然后使用UTF-8编码将其转换为字节序列。之后,我们使用相同的编码格式将字节序列解码回原始的字符串。这展示了字符编码在数据处理和传输过程中的重要作用。

## 2.2 数据的运算与逻辑操作

### 2.2.1 整数与浮点数的运算规则

整数和浮点数是计算机中使用的两种主要的数值类型,它们在计算机内部有不同的表示方法和运算规则。

整数在计算机中是以二进制形式表示的,可以直接进行加减乘除等基础运算。对于有符号整数,通常使用补码来表示负数。例如,一个8位的整数范围通常是从-128到127。

浮点数则采用IEEE浮点数表示标准,它包含了符号位、指数位和尾数位。IEEE 754标准定义了浮点数的存储方式和运算规则,常见的格式有单精度(32位)和双精度(64位)。

浮点数运算不同于整数运算,因为涉及到规格化、舍入和溢出等特殊情况。对于编程人员而言,了解浮点数的表示和运算规则是避免数据不精确和处理复杂数值计算的关键。

### 2.2.2 逻辑门电路与布尔代数基础

在数字电路中,逻辑门电路是构建更复杂电路的基本单元。这些门电路根据布尔代数的规则执行基本的逻辑运算。

基本的逻辑门包括与门(AND)、或门(OR)、非门(NOT)、异或门(XOR)等。这些门电路可以组合起来执行更复杂的逻辑操作。

布尔代数是逻辑电路设计的基础,它提供了一套运算规则,类似于常规代数,但用于处理逻辑运算。布尔代数中的主要操作包括AND、OR和NOT,它们分别对应于乘法、加法和取反操作。

例如,假设我们有两个布尔变量 A 和 B,那么它们的AND、OR和XOR运算可以表示为:

- AND: A AND B 或者 A * B

- OR: A OR B 或者 A + B

- XOR: A XOR B 或者 A ⊕ B

利用布尔代数原理,可以简化逻辑表达式,从而优化逻辑电路的设计。在硬件设计和编程中,理解布尔代数对于实现有效的逻辑控制和决策结构至关重要。

# 3. 中央处理器(CPU)设计与工作原理

CPU作为计算机系统的核心部件,它负责解释计算机程序指令以及处理数据。了解CPU的结构组成、指令执行周期、性能指标与优化策略对于系统设计和性能调优至关重要。

## 3.1 CPU的结构组成

CPU由多个组件构成,它们共同工作以实现指令的获取、解码和执行。主要组成部分包括控制单元(CU)、算术逻辑单元(ALU)以及寄存器组。

### 3.1.1 控制单元、算术逻辑单元和寄存器

#### 控制单元

控制单元(CU)负责协调和控制CPU中各个部分的工作,确保数据的正确流动和指令的正确执行。CU解释指令并生成控制信号,这些信号指导其他CPU组件的活动。

#### 算术逻辑单元

算术逻辑单元(ALU)是CPU中用于处理算术和逻辑运算的部分。ALU执行所有算术运算,如加法和减法,以及逻辑操作,比如与、或、非等操作。

#### 寄存器

寄存器是CPU内部的高速存储单元,用于暂存指令、数据和地址。CPU中的寄存器分为多种类型,包括累加器、指令寄存器

0

0