YOLOv5实战指南:从安装配置到模型训练,一站式入门指南

发布时间: 2024-08-16 02:51:50 阅读量: 47 订阅数: 50

# 1. YOLOv5简介和安装**

YOLOv5(You Only Look Once version 5)是一种先进的实时目标检测算法,以其速度和精度而闻名。它由Ultralytics团队开发,是YOLO算法家族的最新版本。

**安装YOLOv5**

1. 克隆YOLOv5 GitHub存储库:`git clone https://github.com/ultralytics/yolov5`

2. 安装依赖项:`pip install -r requirements.txt`

3. 下载预训练权重:`wget https://github.com/ultralytics/yolov5/releases/download/v6.1/yolov5s.pt`

**环境要求**

* Python 3.8或更高版本

* PyTorch 1.10或更高版本

* CUDA 11.3或更高版本

* NVIDIA GPU(推荐)

# 2. YOLOv5模型训练

### 2.1 数据集准备和预处理

#### 2.1.1 数据集的收集和筛选

1. **收集数据:**从各种来源收集图像和标注数据,如COCO、VOC、ImageNet等数据集。

2. **筛选数据:**移除质量差、标注错误或不相关的图像。确保数据集具有足够的多样性,涵盖各种场景、目标和光照条件。

#### 2.1.2 数据增强技术

1. **随机裁剪和缩放:**随机裁剪图像并调整其大小,以增加模型对不同图像尺寸的鲁棒性。

2. **随机翻转和旋转:**水平或垂直翻转图像,并应用随机旋转,以增强数据的多样性。

3. **颜色抖动:**调整图像的亮度、对比度和饱和度,以模拟真实世界的照明变化。

4. **马赛克数据增强:**将图像划分为多个区域,并随机混合这些区域,以创建更具挑战性的训练样本。

### 2.2 模型配置和训练

#### 2.2.1 模型结构和参数设置

1. **选择模型结构:**YOLOv5提供多种模型结构,如YOLOv5s、YOLOv5m和YOLOv5l。选择适合任务复杂性和计算资源的模型。

2. **设置超参数:**调整超参数,如学习率、批处理大小和训练轮数,以优化模型性能。

#### 2.2.2 训练过程和超参数优化

1. **训练过程:**使用随机梯度下降算法训练模型,并使用交叉熵损失函数和IOU损失函数。

2. **超参数优化:**使用网格搜索或贝叶斯优化等技术优化超参数,以提高模型精度。

### 2.3 训练结果评估和优化

#### 2.3.1 模型评估指标和方法

1. **平均精度(mAP):**衡量模型在不同IOU阈值下的平均检测精度。

2. **召回率和准确率:**评估模型检测目标的能力和预测的准确性。

#### 2.3.2 模型优化策略

1. **模型剪枝:**移除模型中不重要的权重和神经元,以减少模型大小和计算成本。

2. **知识蒸馏:**将训练好的大型模型的知识转移到较小的学生模型,以提高学生模型的性能。

3. **对抗训练:**使用对抗样本训练模型,以提高其对对抗攻击的鲁棒性。

# 3. YOLOv5模型部署

### 3.1 模型导出和转换

#### 3.1.1 模型格式转换和优化

训练好的YOLOv5模型需要导出为部署平台兼容的格式。常用的模型格式包括ONNX、TensorRT和OpenVINO。

**ONNX (Open Neural Network Exchange)**是一种开放的模型格式,可跨多个深度学习框架进行互操作。要将YOLOv5模型导出为ONNX格式,可以使用以下命令:

```

python export.py --weights weights/best.pt --include onnx --output onnx/best.onnx

```

**TensorRT (Tensor Runtime)**是NVIDIA开发的高性能推理引擎。它可以优化模型以在NVIDIA GPU上实现低延迟和高吞吐量。要将YOLOv5模型导出为TensorRT格式,可以使用以下命令:

```

python export.py --weights weights/best.pt --include engine --output engine/best.engine

```

**OpenVINO (Open Visual Inference & Neural Network Optimization)**是英特尔开发的推理引擎。它可以优化模型以在英特尔CPU和GPU上实现高性能。要将YOLOv5模型导出为OpenVINO格式,可以使用以下命令:

```

python export.py --weights weights/best.pt --include openvino --output openvino/best.xml

```

#### 3.1.2 模型部署平台选择

模型部署平台的选择取决于部署环境和性能要求。以下是一些常见的部署平台:

* **CPU:**适用于低功耗、低成本的部署。

* **GPU:**适用于高性能、高吞吐量的部署。

* **云平台:**适用于可扩展、弹性的部署。

* **边缘设备:**适用于低功耗、实时推理的部署。

### 3.2 模型部署和推理

#### 3.2.1 实时推理和批处理推理

**实时推理**是指对单个输入图像或视频帧进行推理。这通常用于交互式应用程序,如目标检测和跟踪。

**批处理推理**是指对一批输入图像或视频帧进行推理。这通常用于提高吞吐量和减少延迟。

#### 3.2.2 部署环境的优化和调优

部署环境的优化和调优可以提高模型推理的性能和效率。以下是一些常见的优化技术:

* **批处理大小:**调整批处理大小以平衡延迟和吞吐量。

* **线程数:**调整线程数以利用多核CPU或GPU。

* **内存管理:**优化内存分配和释放以减少开销。

* **硬件加速:**利用GPU或其他硬件加速器以提高推理速度。

# 4. YOLOv5应用实践

### 4.1 目标检测和跟踪

#### 4.1.1 实时目标检测和跟踪系统

YOLOv5在实时目标检测和跟踪领域有着广泛的应用。其高精度和实时性使其成为构建目标检测和跟踪系统的理想选择。

**系统架构**

一个典型的实时目标检测和跟踪系统包括以下组件:

- **目标检测器:**负责检测图像或视频帧中的目标。

- **跟踪器:**负责将目标从一帧跟踪到下一帧,并维护其身份。

- **用户界面:**用于显示检测和跟踪结果,并允许用户与系统交互。

**实现**

使用YOLOv5构建实时目标检测和跟踪系统涉及以下步骤:

1. **训练目标检测模型:**使用YOLOv5训练一个目标检测模型,以检测感兴趣的目标。

2. **集成跟踪器:**将跟踪器集成到系统中,例如Kalman滤波器或多目标跟踪算法。

3. **开发用户界面:**创建用户界面,以显示检测和跟踪结果,并允许用户配置系统参数。

#### 4.1.2 多目标跟踪和关联算法

在多目标跟踪中,需要将目标从一帧跟踪到下一帧,并维护其身份。这可以通过使用关联算法来实现。

**关联算法**

常用的关联算法包括:

- **匈牙利算法:**一种求解指派问题的算法,可用于关联目标。

- **卡尔曼滤波器:**一种用于预测目标状态的算法,可用于关联目标。

- **互信息:**一种衡量两个随机变量之间依赖性的度量,可用于关联目标。

**实现**

在YOLOv5中,可以使用以下代码实现多目标跟踪:

```python

import numpy as np

from yolov5.utils.plots import plot_one_box

from yolov5.utils.datasets import LoadImages

from yolov5.models.experimental import attempt_load

# 加载模型

model = attempt_load("yolov5s.pt")

# 加载数据集

dataset = LoadImages("data/images", img_size=640)

# 跟踪器

tracker = KalmanFilter()

# 遍历数据集

for path, img, im0s in dataset:

# 目标检测

preds = model(img)

# 关联目标

tracks = tracker.update(preds)

# 绘制结果

for track in tracks:

bbox = track.bbox

plot_one_box(bbox, im0s, label=track.id, color=(0, 255, 0))

# 显示结果

cv2.imshow("Tracking", im0s)

cv2.waitKey(1)

```

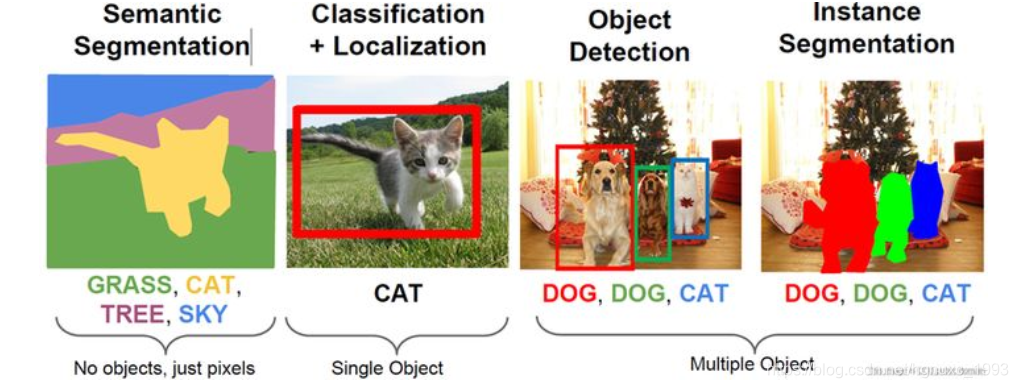

### 4.2 图像分类和分割

#### 4.2.1 图像分类模型的训练和部署

YOLOv5也可以用于图像分类任务。通过移除目标检测头并添加分类头,可以将YOLOv5模型转换为图像分类模型。

**模型转换**

```python

import torch

from yolov5.models.common import Conv

# 加载YOLOv5模型

model = attempt_load("yolov5s.pt")

# 移除目标检测头

model.head = Conv(model.head.in_channels, 1000, 1) # 1000为类别数

# 保存分类模型

torch.save(model.state_dict(), "classifier.pt")

```

**部署**

```python

import torch

from torchvision import transforms

# 加载分类模型

model = torch.load("classifier.pt")

# 预处理图像

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.485, 0.456, 0.406), (0.229, 0.224, 0.225))

])

# 分类图像

img = transform(Image.open("image.jpg"))

output = model(img.unsqueeze(0))

# 获取预测结果

_, predicted = torch.max(output.data, 1)

print(f"Predicted class: {predicted}")

```

#### 4.2.2 图像分割模型的应用和扩展

YOLOv5还可以用于图像分割任务。通过添加分割头,可以将YOLOv5模型转换为图像分割模型。

**模型转换**

```python

import torch

from yolov5.models.common import Conv

# 加载YOLOv5模型

model = attempt_load("yolov5s.pt")

# 添加分割头

model.head = Conv(model.head.in_channels, 2, 1) # 2为分割类别数

# 保存分割模型

torch.save(model.state_dict(), "segmenter.pt")

```

**应用**

```python

import torch

from torchvision import transforms

# 加载分割模型

model = torch.load("segmenter.pt")

# 预处理图像

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.485, 0.456, 0.406), (0.229, 0.224, 0.225))

])

# 分割图像

img = transform(Image.open("image.jpg"))

output = model(img.unsqueeze(0))

# 获取分割结果

segmentation = output.argmax(1).squeeze().numpy()

```

# 5.1 模型压缩和加速

在实际应用中,模型的部署往往会受到设备性能的限制。为了在资源受限的设备上部署YOLOv5模型,模型压缩和加速技术至关重要。

### 5.1.1 模型量化和剪枝

**模型量化**

模型量化是一种将浮点模型转换为定点模型的技术,从而减少模型的存储和计算开销。YOLOv5支持多种量化方法,例如:

- **INT8量化:**将浮点权重和激活值转换为8位整数。

- **FP16量化:**将浮点权重和激活值转换为16位浮点数。

**代码块:**

```python

import torch

from torch.quantization import quantize_dynamic

# 加载浮点模型

model = torch.hub.load('ultralytics/yolov5', 'yolov5s')

# 量化为INT8

quantized_model = quantize_dynamic(model, {torch.nn.Linear}, dtype=torch.qint8)

```

**参数说明:**

- `model`:需要量化的浮点模型。

- `quantize_dynamic`:用于量化的函数。

- `{torch.nn.Linear}`:指定要量化的层类型(线性层)。

- `dtype=torch.qint8`:指定量化类型为INT8。

**逻辑分析:**

该代码加载预训练的YOLOv5模型,并使用动态量化技术将其量化为INT8格式。量化后的模型具有更小的存储和计算开销,同时保持与浮点模型相当的精度。

**模型剪枝**

模型剪枝是一种移除模型中冗余权重的技术,从而减小模型的大小。YOLOv5支持多种剪枝方法,例如:

- **L1剪枝:**根据权重绝对值的大小移除权重。

- **L2剪枝:**根据权重平方和的大小移除权重。

**代码块:**

```python

import torch

from torch.nn.utils import prune

# 加载浮点模型

model = torch.hub.load('ultralytics/yolov5', 'yolov5s')

# L1剪枝

prune.l1_unstructured(model, name="conv1", amount=0.2)

```

**参数说明:**

- `model`:需要剪枝的浮点模型。

- `prune.l1_unstructured`:用于L1剪枝的函数。

- `name="conv1"`:指定要剪枝的层名称(卷积层)。

- `amount=0.2`:指定剪枝比例(移除20%的权重)。

**逻辑分析:**

该代码加载预训练的YOLOv5模型,并对名为“conv1”的卷积层进行L1剪枝。剪枝后的模型具有更小的尺寸,同时保持与浮点模型相当的精度。

### 5.1.2 边缘设备上的模型部署

在边缘设备(如移动设备、嵌入式系统)上部署YOLOv5模型时,需要考虑设备的计算能力和存储限制。以下是一些优化模型部署的策略:

- **选择轻量级模型:**YOLOv5提供了多种轻量级模型,例如YOLOv5s和YOLOv5n,这些模型具有较小的尺寸和较低的计算复杂度。

- **使用量化和剪枝技术:**如前所述,量化和剪枝可以减小模型的尺寸和计算开销。

- **使用移动部署框架:**PyTorch Mobile和TensorFlow Lite等移动部署框架可以优化模型部署,减少模型加载时间和内存占用。

- **使用边缘计算平台:**AWS Greengrass和Azure IoT Edge等边缘计算平台可以提供云计算资源,帮助在边缘设备上部署和管理模型。

**代码块:**

```python

import torch

from torch.jit import trace

# 加载浮点模型

model = torch.hub.load('ultralytics/yolov5', 'yolov5s')

# 导出为TorchScript

traced_model = torch.jit.trace(model, torch.rand(1, 3, 640, 640))

# 使用PyTorch Mobile部署

torch.jit.save(traced_model, "yolov5s.pt")

```

**参数说明:**

- `model`:需要部署的浮点模型。

- `torch.jit.trace`:用于导出TorchScript模型的函数。

- `torch.rand(1, 3, 640, 640)`:用于生成输入张量的随机数据。

- `torch.jit.save`:用于保存TorchScript模型的函数。

**逻辑分析:**

该代码将预训练的YOLOv5s模型导出为TorchScript格式,该格式可以被PyTorch Mobile等移动部署框架优化。这有助于在边缘设备上部署模型,同时减少模型加载时间和内存占用。

# 6. YOLOv5研究前沿**

**6.1 YOLOv5算法的最新进展**

YOLOv5算法自提出以来,不断更新迭代,在模型结构、训练算法和优化器方面都有了显著的进展。

**6.1.1 模型结构创新和优化**

* **Cross-Stage Partial Connections (CSP):**CSP将卷积层分为多个阶段,每个阶段只连接部分特征图,减少了计算量和参数量。

* **Spatial Attention Module (SAM):**SAM通过空间注意力机制,增强了模型对目标区域的关注能力。

* **Path Aggregation Network (PAN):**PAN将不同尺度的特征图融合,提高了模型的多尺度检测能力。

**6.1.2 训练算法和优化器的改进**

* **Mosaic数据增强:**Mosaic数据增强将多张图像随机组合成一张,增加了训练数据的多样性。

* **自适应学习率优化器 (AdamW):**AdamW优化器加入了权重衰减项,防止模型过拟合。

* **梯度累积:**梯度累积将多个批次的梯度累积起来再更新,适用于大批量训练。

**6.2 YOLOv5在不同领域的应用**

YOLOv5算法凭借其高效性和准确性,在医疗影像分析、自动驾驶和机器人视觉等领域得到了广泛的应用。

**6.2.1 医疗影像分析**

* **疾病诊断:**YOLOv5用于识别和分类X光、CT和MRI图像中的病变。

* **医学图像分割:**YOLOv5可以分割出医学图像中的不同组织和器官。

**6.2.2 自动驾驶和机器人视觉**

* **目标检测:**YOLOv5用于检测道路上的行人、车辆和障碍物。

* **环境感知:**YOLOv5帮助机器人感知周围环境,进行导航和避障。

0

0