传感器融合新玩法:OpenCV车距检测与其他传感器强强联手

发布时间: 2024-08-14 03:41:18 阅读量: 22 订阅数: 36

OPENCV目标跟踪_opencv_目标检测_cmu车辆检测以及跟踪程序采用光流法opencv_车辆检测_光流法_VC++

# 1. 传感器融合概述**

传感器融合是一种将来自多个传感器的数据结合起来,以获得更准确、更全面的信息的处理技术。在自动驾驶领域,传感器融合至关重要,因为它可以弥补单个传感器局限性的不足,并提供对周围环境的更全面理解。

传感器融合系统通常涉及以下步骤:

- **数据采集:**从多个传感器收集数据,如摄像头、雷达和激光雷达。

- **数据预处理:**对原始数据进行校准、滤波和转换,以使其适合融合。

- **数据融合:**使用算法将来自不同传感器的数据融合在一起,生成一个统一的表示。

- **信息提取:**从融合后的数据中提取有意义的信息,例如障碍物检测、定位和环境感知。

# 2. OpenCV车距检测理论与实践**

## 2.1 OpenCV图像处理基础

### 2.1.1 图像获取和预处理

**图像获取:**

- 使用摄像头或图像文件读取图像。

- OpenCV函数:`cv2.VideoCapture()`、`cv2.imread()`

**图像预处理:**

- 调整图像大小:`cv2.resize()`

- 灰度转换:`cv2.cvtColor()`

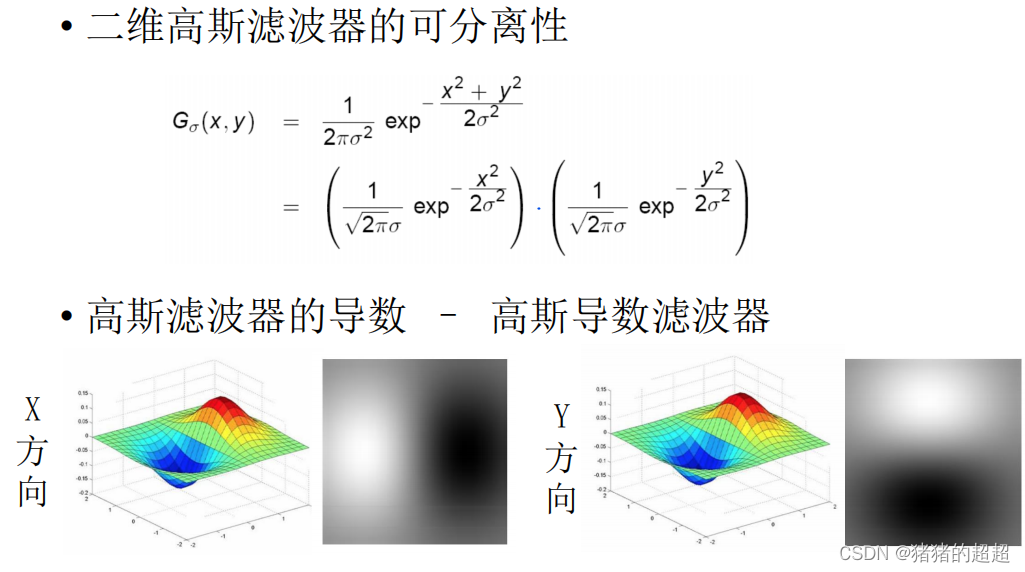

- 高斯滤波:`cv2.GaussianBlur()`

- 边缘检测:`cv2.Canny()`

### 2.1.2 图像分割和特征提取

**图像分割:**

- 将图像分割成不同区域。

- OpenCV函数:`cv2.threshold()`, `cv2.findContours()`

**特征提取:**

- 从图像中提取有意义的信息。

- OpenCV函数:`cv2.SURF()`, `cv2.SIFT()`

## 2.2 车距检测算法

### 2.2.1 单目视觉法

**原理:**

- 使用单个摄像头估计车距。

- 通过图像处理和几何计算确定目标车辆在图像中的位置。

**代码示例:**

```python

import cv2

def single_camera_car_distance(image):

"""

计算图像中车辆的距离。

参数:

image:输入图像。

返回:

距离(米)。

"""

# 图像预处理

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

blur = cv2.GaussianBlur(gray, (5, 5), 0)

# 边缘检测

edges = cv2.Canny(blur, 100, 200)

# 轮廓检测

contours, _ = cv2.findContours(edges, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

# 找到最大轮廓(目标车辆)

max_contour = max(contours, key=cv2.contourArea)

# 计算轮廓的中心点

M = cv2.moments(max_contour)

cx = int(M['m10'] / M['m00'])

cy = int(M['m01'] / M['m00'])

# 已知目标车辆的宽度和图像中像素的宽度,计算距离

vehicle_width = 1.7 # 米

image_width = image.shape[1]

distance = (vehicle_width * image_width) / (2 * cx)

return distance

```

### 2.2.2 双目视觉法

**原理:**

- 使用两个摄像头估计车距。

- 通过三角测量计算目标车辆与摄像头的距离。

**代码示例:**

```python

import cv2

import numpy as np

def stereo_vision_car_distance(left_image, right_image):

"""

计算图像中车辆的距离。

参数:

left_image:左摄像头图像。

right_image:右摄像头图像。

返回:

距离(米)。

"""

# 立体校正

stereo = cv2.StereoBM_create()

disparity = stereo.compute(left_image, right_image)

# 视差到深度转换

focal_length = 500 # 像素

baseline = 0.1 # 米

depth = (focal

```

0

0