车距检测与目标跟踪强强联手:OpenCV实战案例

发布时间: 2024-08-14 03:33:23 阅读量: 30 订阅数: 30

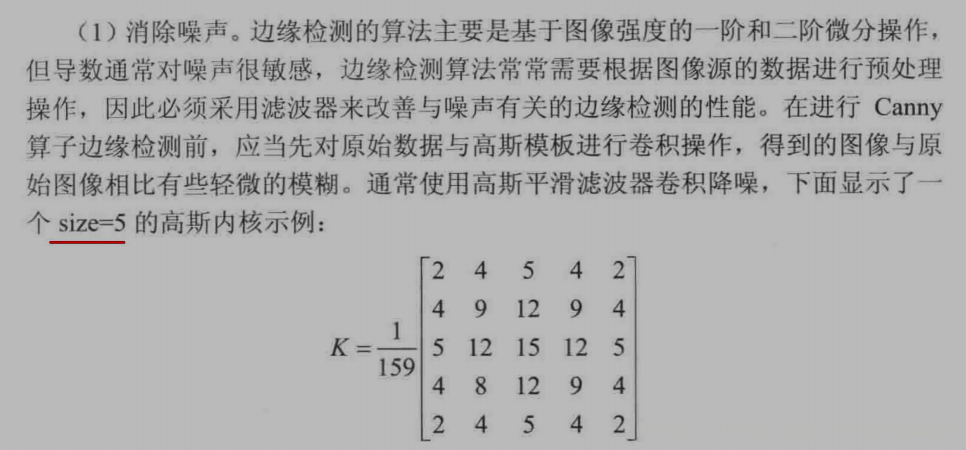

# 1. 车距检测与目标跟踪概述

车距检测和目标跟踪是自动驾驶系统中的关键技术,旨在感知周围环境并实时跟踪目标。本概述将介绍车距检测和目标跟踪的基本概念、技术分类和应用场景。

**车距检测**

车距检测技术用于测量车辆与周围目标之间的距离,为自动驾驶系统提供安全驾驶所需的空间感知信息。主要技术包括激光雷达、计算机视觉和传感器融合。

**目标跟踪**

目标跟踪技术用于持续跟踪目标的位置和运动状态,为自动驾驶系统提供连续的感知信息。常见的跟踪算法包括基于帧差法、光流法和粒子滤波。

# 2. 车距检测技术

车距检测技术是自动驾驶系统中一项关键技术,它能够准确测量车辆与前方目标之间的距离,为车辆控制和安全决策提供重要信息。目前,车距检测技术主要分为激光雷达技术、计算机视觉算法和传感器融合技术。

### 2.1 激光雷达原理与应用

激光雷达(LiDAR)是一种主动光学传感器,通过发射激光束并测量反射光的时间差来确定目标的距离。激光雷达具有以下优点:

- **高精度:**激光雷达可以提供厘米级的距离测量精度,满足自动驾驶系统对车距检测的高精度要求。

- **全天候工作:**激光雷达不受光照条件的影响,可以在白天、夜晚和恶劣天气条件下工作。

- **三维点云数据:**激光雷达不仅可以测量距离,还可以生成目标的三维点云数据,为环境感知提供丰富的信息。

#### 2.1.1 激光雷达的测距原理

激光雷达的测距原理基于光速不变的原理。激光雷达发射器发射激光脉冲,当激光脉冲照射到目标后,一部分激光会被反射回来。激光雷达接收器接收反射光,并测量从激光脉冲发射到反射光接收的时间差。根据光速和时间差,可以计算出目标与激光雷达之间的距离。

#### 2.1.2 激光雷达的数据处理

激光雷达采集到的原始数据是点云数据,包含大量三维点。为了提取车距信息,需要对点云数据进行以下处理:

- **滤波:**去除噪声点和无效点。

- **分割:**将点云数据分割成不同的目标。

- **聚类:**将同一目标的点聚类在一起。

- **特征提取:**提取目标的几何特征,如尺寸、形状和运动状态。

### 2.2 计算机视觉算法

计算机视觉算法利用摄像头采集的图像数据来估计车距。计算机视觉算法主要包括图像处理、目标检测和识别三个步骤。

#### 2.2.1 图像处理基础

图像处理是计算机视觉算法的基础,主要包括以下步骤:

- **图像增强:**提高图像的对比度和清晰度。

- **图像分割:**将图像分割成不同的区域。

- **特征提取:**提取图像中目标的特征,如边缘、纹理和颜色。

#### 2.2.2 目标检测与识别

目标检测是确定图像中目标的位置和大小,目标识别是识别目标的类别。目标检测和识别算法主要包括:

- **滑动窗口算法:**在图像中滑动一个窗口,并对窗口内的图像区域进行分类。

- **深度学习算法:**使用卷积神经网络(CNN)等深度学习模型对图像进行特征提取和分类。

### 2.3 传感器融合技术

传感器融合技术将来自不同传感器的数据进行融合,以获得更加准确和可靠的车距信息。传感器融合技术主要包括以下步骤:

#### 2.3.1 传感器融合的优势

传感器融合技术具有以下优势:

- **互补性:**不同传感器具有不同的优点和缺点,通过融合可以弥补各自的不足。

- **冗余性:**当一个传感器出现故障时,其他传感器可以提供冗余信息,提高系统的可靠性。

- **精度提升:**通过融合来自不同传感器的信息,可以提高车距检测的精度。

#### 2.3.2 传感器融合算法

传感器融合算法主要包括:

- **卡尔曼滤波:**一种基于贝叶斯估计的递归滤波算法,可以融合来自不同传感器的测量数据,并估计目标的真实状态。

- **粒子滤波:**一种蒙特卡罗方法,通过生成大量粒子来估计目标的分布,并融合来自不同传感器的测量数据来更新粒子分布。

# 3.1 跟踪算法分类

目标跟踪算法可根据其采用的技术分为以下几类:

#### 3.1.1 基于帧差法的跟踪算法

基于帧差法的跟踪算法通过计算相邻帧之间的差异来检测和跟踪目标。它通过计算当前帧与前一帧之间的像素差异来生成差异图。差异图中亮度较高的区域表示目标运动或变化的区域。

```python

import cv2

# 读取视频

cap = cv2.VideoCapture('video.mp4')

# 初始化帧差法

fgbg = cv2.createBackgroundSubtractorMOG2()

while True:

# 读取帧

ret, frame = cap.read()

if not ret:

break

# 应用帧差法

fgmask = fgbg.apply(frame)

# 阈值化帧差图

_, thresh = cv2.threshold(fgmask, 127, 255, cv2.THRESH_

```

0

0