XGBoost自然语言处理:文本分类与情感分析实战

发布时间: 2024-11-20 22:52:38 阅读量: 9 订阅数: 11

# 1. XGBoost与自然语言处理概述

## 1.1 XGBoost与NLP的联结

XGBoost是一种高效的机器学习算法,主要用于结构化数据的分类和回归任务。近年来,它也被成功地引入到自然语言处理(NLP)中,以解决诸如文本分类、情感分析等复杂任务。自然语言处理是计算机科学和人工智能领域中用于理解和处理人类语言的技术和方法。XGBoost在处理自然语言时,通常会结合文本向量化技术,将文本转换为模型能够处理的数值特征向量。

## 1.2 XGBoost在NLP中的优势

XGBoost在NLP任务中的优势主要体现在其高效的计算性能和强大的泛化能力。其核心优势包括高效的并行学习能力、处理稀疏数据的能力、灵活的特征选择和模型调优。这些特性使得XGBoost在处理大规模文本数据时,能够有效减少过拟合,同时维持较好的训练速度和预测准确性。对于需要大量特征工程和调整的NLP任务来说,这些优势尤其重要。

## 1.3 应用XGBoost于NLP的挑战与前景

虽然XGBoost在NLP任务中表现出色,但在实际应用中仍面临一些挑战。例如,如何有效地将非结构化的文本数据转换为结构化的数值特征,以及如何调整XGBoost的参数来适应特定的NLP场景。随着算法和硬件技术的发展,以及对NLP任务理解的深化,XGBoost在处理自然语言方面的应用前景十分广阔。此外,探索XGBoost与深度学习技术的结合,有可能带来新的突破,例如在端到端的NLP任务中作为深度学习模型的辅助工具。

# 2. XGBoost模型的基础理论与实现

## 2.1 XGBoost模型简介

### 2.1.1 XGBoost的发展背景

XGBoost,即极端梯度提升(eXtreme Gradient Boosting),是由陈天奇等人在分布式机器学习社区(DMLC)中开发的开源机器学习库。它起初是为了提供一个高效且灵活的梯度提升框架,能够利用多台计算机的计算能力来处理大规模数据集。XGBoost的开发始于2014年,而其后迅速在众多数据科学竞赛中取得成功,尤其是在Kaggle竞赛中,XGBoost被广泛应用,并且获奖选手中绝大多数使用了XGBoost作为其主要模型。

在设计之初,XGBoost考虑了多种场景的需求,包括数据集大小、特征维度、以及模型复杂度等。因此,它的特点之一是高度可扩展性和灵活性。它支持多种功能,例如并行学习、剪枝处理、缺失值处理等,且由于其优化的性能,使得它在资源受限的情况下也能运行高效。

### 2.1.2 XGBoost的主要特点

XGBoost的主要特点包括:

- **高效性**:支持并行处理,能够利用所有可用的核心,并且在分布式环境下也能保持高效的性能。

- **灵活性**:支持自定义损失函数,且可以处理各种数据类型。

- **正则化**:通过引入正则项,减少了模型复杂度,从而增加了模型的泛化能力。

- **容错性**:提供自动的缺失值处理,并且在数据预处理方面的需求较少。

- **可解释性**:提供了特征重要性的评估,方便用户理解模型的决策过程。

## 2.2 XGBoost的工作原理

### 2.2.1 梯度提升决策树(GBDT)

梯度提升决策树(Gradient Boosted Decision Tree,简称GBDT)是一种迭代的决策树算法,通过不断地添加新模型来改进整个模型集。GBDT中的每个模型都是通过关注之前模型预测不足的地方来训练的,进而逐渐减少残差(即预测误差)。

具体来说,GBDT的每个基学习器(通常为决策树)都试图通过学习前一个模型预测的残差来改进整体模型的性能。这种方式称为梯度提升,因为它是在损失函数的梯度方向上进行优化的。

### 2.2.2 XGBoost的优化目标和算法流程

XGBoost作为一种实现GBDT算法的工具,它的优化目标是在训练过程中最小化下面的目标函数:

\[Obj = \sum_{i=1}^{n} l(y_i, \hat{y_i}) + \sum_{k=1}^{K} \Omega(f_k)\]

这里,\(l\)表示损失函数,用来衡量模型预测值\(\hat{y_i}\)与实际值\(y_i\)之间的差异。而\(\Omega\)是一个正则化项,用来控制模型复杂度,防止过拟合,其中\(f_k\)表示第k个决策树模型。

为了优化该目标函数,XGBoost使用了一个贪心的算法来构建树模型,该算法涉及以下关键步骤:

1. 初始化模型,通常是一个常数。

2. 对于每一轮迭代:

a. 对每个样本计算负梯度,即损失函数关于预测值的导数。

b. 基于这些负梯度构建一棵新的树,选择分割特征和分割点。

c. 使用一个学习率(也称为收缩率)来控制新树的影响。

3. 更新原始预测值,添加新树的预测结果。

4. 重复以上步骤直到满足停止条件。

## 2.3 XGBoost模型的数学基础

### 2.3.1 损失函数与梯度计算

在XGBoost中,损失函数的设计对模型的性能有很大影响。损失函数反映了模型预测值与真实值之间的差异,因此它直接影响到梯度提升的优化过程。

损失函数通常被设定为可微分的凸函数,以保证数学上的优化问题是有解的。对于回归问题,常见的损失函数有均方误差(MSE)或对数损失(Log Loss);对于分类问题,则使用二元或多元对数损失。

梯度计算是通过损失函数对预测值的导数来完成的,这一步涉及到计算预测值对各个参数(模型的权重和偏置)的偏导数。XGBoost能够自动计算损失函数关于预测值的导数,这是其核心优势之一。

### 2.3.2 正则化项的作用与效果

正则化项在XGBoost模型中起到了防止过拟合、提升模型泛化能力的关键作用。XGBoost的正则化项包括两个部分:一个是对树的复杂度的惩罚,另一个是对叶子节点权重的L1和L2惩罚。

树的复杂度惩罚项为\(\gamma T\),其中\(\gamma\)是一个超参数,\(T\)是树中叶子节点的个数。L1和L2惩罚项可以表示为\(\frac{1}{2} \lambda ||w||^2\)和\(\lambda ||w||\),其中\(w\)是叶子节点权重的向量,\(\lambda\)是对应L1和L2的超参数。

通过调整正则化项中的参数,可以控制模型的复杂度和泛化能力。在实践中,通过交叉验证来选择最佳的正则化参数,以达到最佳的预测性能。

接下来,我们将深入探讨XGBoost在NLP中的应用,特别是在文本分类和情感分析任务中的具体应用案例。

# 3. 文本分类的XGBoost应用实践

文本分类作为自然语言处理(NLP)领域的一个重要任务,它的目标是根据文本内容将其分配到一个或多个类别中。XGBoost作为一个高效的机器学习算法,在处理结构化数据方面有着突出的表现,但其在文本分类任务中的应用同样值得关注。接下来,我们将深入探讨XGBoost如何应用于文本分类,并通过实战案例进行分析。

## 3.1 文本分类任务概述

### 3.1.1 文本分类的定义和重要性

文本分类(Text Classification)是指将文本数据自动分配到一个或多个类别中的过程。在机器学习中,文本分类广泛应用于垃圾邮件检测、情感分析、新闻分类、话题识别等领域。随着互联网和社交媒体的发展,文本数据量呈指数级增长,文本分类技术在信息过滤、自动摘要、知识提取等方面显得尤为重要。

### 3.1.2 常见的文本分类算法

文本分类算法大体可以分为两类:基于规则的方法和基于机器学习的方法。基于规则的方法依赖于预定义的关键词或词组,操作简单但扩展性和准确性有限。基于机器学习的方法则更为强大,它们可以从大量文本数据中学习模式和特征。常见的算法包括朴素贝叶斯(Naive Bayes)、支持向量机(SVM)、随机森林(Random Forest)、以及深度学习方法如卷积神经网络(CNN)和循环神经网络(RNN)。XGBoost作为机器学习算法的一种,在处理非结构化数据时,通常会将文本数据进行向量化处理,然后构建分类模型。

## 3.2 XGBoost在文本分类中的使用

### 3.2.1 数据预处理与特征提取

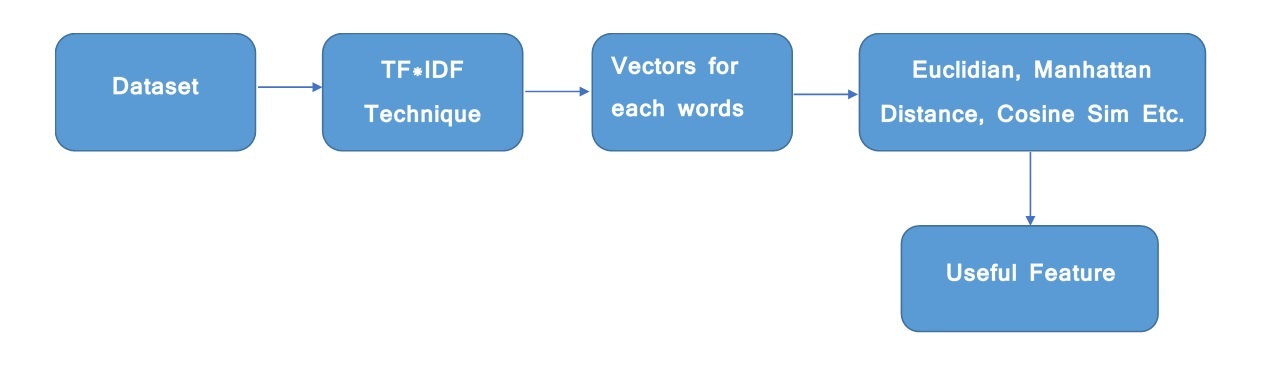

在使用XGBoost进行文本分类之前,首先需要进行数据预处理,这包括文本清洗(去除无用字符、标点等),分词(将文本切分为单词或词组),以及去除停用词等步骤。接下来,通常采用词袋模型(Bag of Words)或TF-IDF(Term Frequency-Inverse Document Frequency)技术将文本转换为向量形式,这些向量可以作为XGBoost模型的输入。

下面的代码段展示了如何使用Python的`sklearn`库进行TF-IDF变换:

```python

from sklearn.feature_extraction.text import TfidfVectorizer

# 示例文本数据

text_data = [

"XGBoost is a great tool for text classification",

"Machine learning models are powerful",

"Text classification can be achieved by XGBoost"

]

# 创建TF-IDF变换器实例,并拟合文本数据

vectorizer = TfidfVectorizer()

tfidf_matrix = vectorizer.fit_transform(text_data)

# 查看TF-IDF矩阵

print(tfidf_matrix.toarray())

# 输出对应的词汇表

feature_names = vectorizer.get_feature_names_out()

print(feature_names)

```

该代码段首先导入了`TfidfVectorizer`类,然后创建了一个向量化器的实例。通过调用`fit_transform`方法,可以将文本数据转换为TF-IDF矩阵,并打印出来。`feature_names`变量包含了转换后的特征名称,即词汇表。在实际应用中,我们会处理包含大量文本样本的完整数据集。

### 3.2.2 XGBoost模型参数调优与训练

使用XGBoost模型进行文本分类时,需要对其参数进行细致的调整以达到最佳性能。主要涉及的参数包括学习率(`learning_rate`)、树的深度(`max_depth`)、正则化项(`reg_alpha`和`reg_lambda`)以及子样本比例(`subsample`)等。通常会利用交叉验证和网格搜索(GridSearchCV)等方法来寻找最佳的参数组合。

```python

import xgboost as xgb

from sklearn.model_selection import train_test_split, GridSearchCV

# 假设X_tfidf和y已经是TF-IDF处理后的特征矩阵和对应的标签

X_train, X_test, y_train, y_test = train_test_split(tfidf_matrix, text_labels, test_size=0.2)

# 创建XGBoost分类器

```

0

0