XGBoost模型部署全记录:从训练到生产环境的无缝过渡

发布时间: 2024-11-20 22:26:27 阅读量: 36 订阅数: 40

xgboost.libpath.XGBoostLibraryNotFound: Cannot find XGBoost Library in the candidate path, did you i

# 1. XGBoost模型概述

XGBoost(eXtreme Gradient Boosting)是一种高性能的分布式梯度提升库。它被广泛应用于机器学习领域中,尤其是在数据科学竞赛和工业项目中取得了巨大成功。XGBoost通过引入正则化项到目标函数,不仅提升了模型的预测准确性,还有效防止了过拟合。此外,它还支持并行化学习,能在多个CPU核心上自动执行,大大加快了模型的训练速度。XGBoost的易用性和灵活性使其成为了数据科学工具箱中的一个关键工具。在接下来的章节中,我们将深入探讨XGBoost的内部工作机制、如何训练和调优模型,以及评估模型的性能,并介绍在生产环境中部署XGBoost的策略和应用案例。

# 2. XGBoost模型训练与调优

## 2.1 XGBoost算法原理

### 2.1.1 XGBoost的基本概念

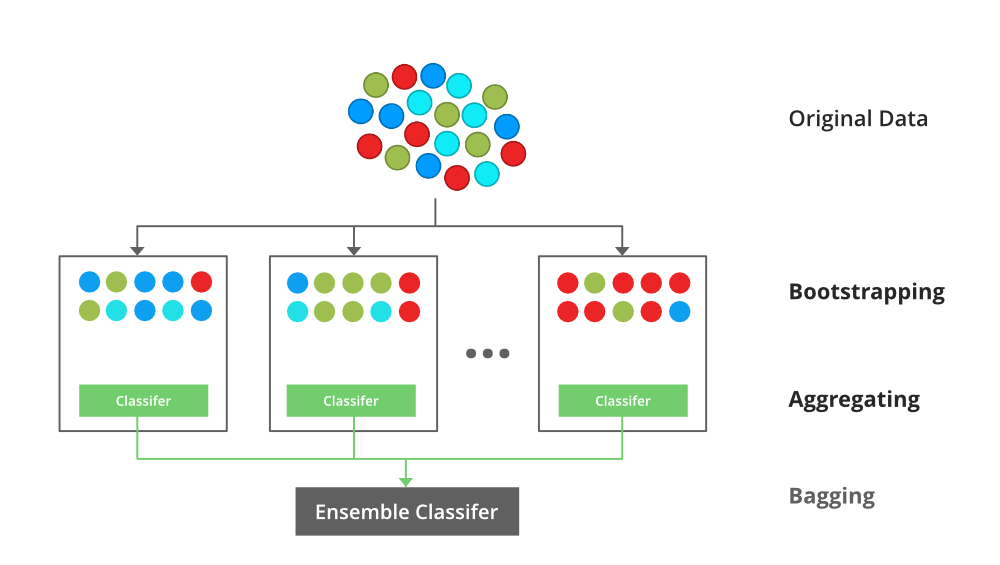

XGBoost(eXtreme Gradient Boosting)是一种高效的、可扩展的梯度提升决策树(Gradient Boosting Decision Tree, GBDT)算法。它是由陈天奇在2014年提出的,并迅速在数据科学竞赛和工业应用中成为主流工具。XGBoost是一种集成学习方法,它通过结合多个弱学习器(通常是决策树),构建一个强大的预测模型。XGBoost相较于传统的梯度提升算法,提供了更多的正则化项,并利用了二阶泰勒展开式来优化损失函数,从而增加了模型的泛化能力,减少了过拟合的风险。

XGBoost 的核心优势包括:

- **高效性**:通过并行化和优化的算法实现快速训练。

- **可扩展性**:能够处理大规模数据,支持分布式和内存计算。

- **灵活性**:可以用于处理不同类型的结构化数据,包括分类、回归、排序等任务。

- **可调性**:提供了大量的超参数供调优,可以实现精细的模型调整。

- **正则化**:在损失函数中加入了正则项,有效防止过拟合。

### 2.1.2 树模型的构建过程

在XGBoost中,模型由多个决策树组成。每个树都会尝试纠正前一个树的错误,梯度提升的过程可以视为一个优化问题,目标是最小化损失函数。XGBoost采用加法模型来不断添加树来拟合负梯度,从而实现模型的逐步优化。

具体来说,XGBoost模型的构建过程可以分为以下几个步骤:

1. **损失函数定义**:XGBoost使用损失函数来衡量模型预测值和真实值之间的差异。对于一个给定的数据集,其损失函数可以表达为:

\[ L(\phi) = \sum_{i=1}^{n} l(y_i, \hat{y}_i) + \sum_{k} \Omega(f_k) \]

其中,\(l\) 是单个样本的损失,\(\hat{y}_i\) 是预测值,\(\Omega(f_k)\) 是第 \(k\) 棵树的复杂度,用于控制模型的复杂度从而防止过拟合。

2. **树的生成**:在每一步,通过计算损失函数对每个特征的偏导数来得到一个残差,这个残差可以视为当前模型的伪梯度。然后基于这些伪梯度构建一棵新的决策树。

3. **模型更新**:在得到新的树后,模型会更新为之前所有树的累加和加上新树。即:

\[ \hat{y}_i^{(t)} = \hat{y}_i^{(t-1)} + f_t(x_i) \]

其中,\(\hat{y}_i^{(t)}\) 是第 \(t\) 次迭代后的预测值。

4. **正则化处理**:XGBoost对树的生成加入了正则化项,以防止树的深度过大,从而控制模型复杂度。

5. **迭代优化**:重复以上过程,直到达到预设的迭代次数或模型性能不再有显著提升。

通过这个过程,XGBoost逐步构建出一个强大的预测模型,同时通过正则化控制模型复杂度,提高了模型的泛化能力。

# 3. 模型评估与选择

## 3.1 评估指标和交叉验证

### 3.1.1 常见的评估指标

在机器学习项目中,选择合适的评估指标对于模型的评估至关重要。不同的问题和业务场景,决定了评估指标的选择差异。对于分类问题,常用指标包括准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F1得分、ROC曲线下的面积(AUC)等。对于回归问题,常用的有均方误差(MSE)、均方根误差(RMSE)、R平方值(R²)等。在实际操作中,根据问题的性质和业务需求,可以使用一个或多个指标来评估模型的性能。

准确率虽然是一个直观的评估指标,但有时不能充分反映模型的性能,尤其是在类别不平衡的数据集上。此时,精确率和召回率能够提供更全面的性能评估。例如,在垃圾邮件检测中,我们更关心的是如何不漏掉任何一封垃圾邮件(高召回率),即使这可能导致一些正常邮件被误判为垃圾邮件(较低的精确率)。而F1得分则是精确率和召回率的调和平均,提供了一个单一的指标来平衡两者。

对于XGBoost模型,我们通常使用内置的评估函数来进行模型的评估。例如,在Python的`xgboost`库中,可以直接通过`cv`函数来进行交叉验证,并计算每一次迭代的评估指标。

```python

import xgboost as xgb

from sklearn.datasets import load_digits

# 加载数据

data = load_digits()

X, y = data.data, data.target

# 定义参数

params = {'max_depth':3, 'eta':0.1}

# 使用交叉验证来计算F1得分

cv_results = xgb.cv(params, xgb.DMatrix(X, label=y), num_boost_round=50,

nfold=5, metrics='mlogloss', early_stopping_rounds=10)

print(cv_results)

```

### 3.1.2 交叉验证技术及其应用

交叉验证是一种模型评估方法,它通过将数据集分成k个子集来反复训练和测试模型,可以有效地利用有限的数据来评估模型的泛化能力。其中,k折交叉验证是最常用的一种方法。每一轮中,模型在一个子集上训练,在剩余的子集上测试。通过这种方式,可以降低模型评估对特定训练集/测试集划分的依赖性。

在Python中,交叉验证通常可以通过`cross_val_score`函数或`GridSearchCV`等工具来实现。例如,使用`GridSearchCV`进行交叉验证:

```python

from sklearn.model_selection import GridSearchCV

# 设置XGBoost模型参数

param_grid = {

'max_depth': [3, 5, 7],

'n_estimators': [50, 100, 200]

```

0

0