Fluent使用手册:日志收集与分析技巧

发布时间: 2024-12-03 15:06:59 阅读量: 7 订阅数: 11

参考资源链接:[FLUENT6.3使用手册:Case和Data文件解析](https://wenku.csdn.net/doc/10y3hu7heb?spm=1055.2635.3001.10343)

# 1. Fluent框架概述

## 1.1 Fluent框架简介

Fluent是一个开源的、轻量级、高性能的分布式日志处理系统,最初由Twitter开发,旨在提供一个统一的平台来处理日志数据。它以插件形式支持多种日志源,并能将收集的日志数据发送至各种存储后端。Fluent框架的核心是使用消息流的方式高效地处理数据,并且支持数据的过滤、转换和路由等功能。

## 1.2 Fluent的架构与组件

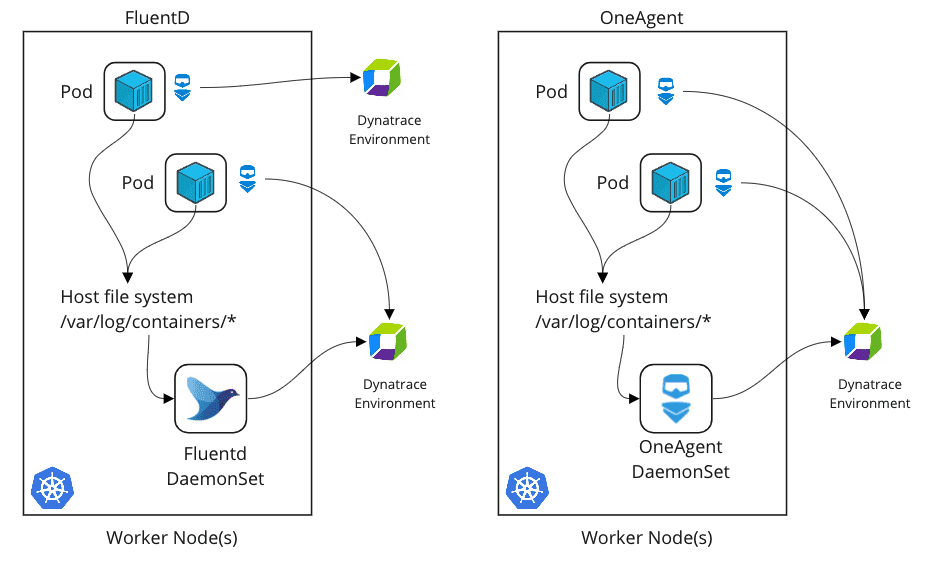

Fluent的架构采用流式处理模式,具有高度模块化的特点。主要组件包括Fluentd、Fluent Agent、Fluent Bit和Output插件。Fluentd是中心化的日志收集器,Fluent Agent和Fluent Bit则可以看做是轻量级代理,通常部署在数据源所在的服务器上。Output插件负责将处理后的数据输出到各种存储系统。这样的设计使得Fluent可以灵活应对不同规模的部署需求。

## 1.3 Fluent的适用场景

Fluent适用于多种日志处理场景,如监控、性能分析、安全审计等。它可以集成到现有的IT基础设施中,为复杂系统的日志管理提供支持。此外,Fluent对于动态和静态环境下的日志收集都有良好的支持,无论是物理机、虚拟机还是容器环境。

# 2. 日志收集的实践技巧

日志收集是任何系统运维和数据分析的基础。合理地收集、存储和分析日志数据,可以帮助我们监控系统运行状态,诊断问题,甚至进行业务分析。在本章中,我们将深入了解Fluent框架在日志收集方面的实践技巧,包括理论基础、Fluent的配置与部署、以及如何使用Fluent实现高级日志收集方法。

## 2.1 日志收集的理论基础

### 2.1.1 日志的分类与重要性

在进行日志收集之前,我们需要理解日志的分类以及每种日志的重要性。日志通常可以分为系统日志、应用日志和安全日志。

系统日志记录了操作系统层面的活动,如启动和关闭事件、硬件错误或网络问题。应用日志则记录了应用程序的运行情况,如用户操作、错误代码或事务处理。安全日志则关注系统安全事件,如登录尝试、权限变更等。

每种类型的日志都对系统健康性和安全性监控扮演着关键角色。理解它们之间的差异有助于更好地设计日志收集策略,确保重要信息不被遗漏。

### 2.1.2 日志收集的基本流程

日志收集的基本流程包括以下步骤:

1. 日志生成:应用程序和系统组件生成日志记录。

2. 日志聚合:将分散的日志收集到中心位置,通常使用日志聚合系统,如Fluentd。

3. 日志处理:清洗和预处理日志,以便进一步分析。

4. 日志存储:将处理后的日志持久化存储。

5. 日志分析:使用各种工具对日志数据进行分析。

6. 日志可视化:将日志数据转换成图表或报表以便更好地理解。

7. 日志报警:根据分析结果设置警报机制,以便及时响应。

理解这个流程有助于我们理解日志收集的每个环节,以及如何优化这一流程以提高效率。

## 2.2 Fluent的配置与部署

### 2.2.1 Fluent的安装与配置

Fluentd以其灵活性和轻量级闻名,可以有效地聚合日志数据并发送到多种存储后端。安装Fluentd非常简单,可以通过包管理器进行安装,例如在Ubuntu上可以使用以下命令:

```sh

$ sudo gem install fluentd

```

接下来,我们需要创建Fluentd的配置文件`/etc/fluent/fluent.conf`。这个文件定义了如何读取日志源、过滤日志以及如何输出到目的地。

一个基本的配置示例如下:

```xml

<match pattern>

@type forward

port 24224

</match>

```

在这个配置中,我们设置了一个名为`pattern`的匹配模式,将日志以TCP方式转发到`port 24224`。这只是 Fluentd 配置的一个基础示例,实际上,Fluentd的配置可以非常复杂,支持大量的插件和过滤规则。

### 2.2.2 Fluent采集器的部署策略

部署Fluent采集器时需要考虑以下因素:

- 可伸缩性:确保采集器可以根据日志量的增长而扩展。

- 容错性:设置多个采集器实例以防单点故障。

- 安全性:配置合适的认证和加密机制,确保数据传输安全。

- 性能:优化配置,以减少对系统资源的消耗。

Fluent采集器的部署策略应该结合具体的使用场景和需求。例如,对于大规模的系统,可以考虑使用Fluentd的集群模式,通过配置负载均衡来提高系统的可用性和可靠性。

## 2.3 高级日志收集方法

### 2.3.1 多数据源日志聚合

在企业级环境中,系统通常由不同的服务和组件构成,这些组件会产生不同格式的日志数据。因此,如何将多数据源的日志进行有效聚合是一个挑战。

使用Fluentd,我们可以定义多个输入源,并将它们输出到统一的日志存储。例如,配置多个`<source>`标签来指定不同的日志文件路径,并通过`<match>`标签将这些数据统一输出到Elasticsearch、S3或其他存储后端。

### 2.3.2 日志的富集与标签化

日志富集是指添加额外信息到日志条目中,以提供上下文信息。例如,我们可以添加主机名、时间戳、日志级别等元信息。这些信息有助于更好地理解和搜索日志。

标签化是将日志进行分类的过程,可以通过修改Fluentd的配置文件来实现。标签化允许后续通过标签来过滤和搜索日志数据,比如:

```xml

<match **>

@type elasticsearch

host elasticsearch.example.com

port 9200

logstash_format true

logstash_prefix fluentd

</match>

```

在这个配置中,所有的日志都被标记并发送到Elasticsearch中,其中`logstash_prefix`定义了日志数据在Elasticsearch中的索引前缀。

通过多数据源日志聚合和日志的富集与标签化,Fluentd能够极大地提高日志处理的灵活性和效率,从而满足复杂的日志管理需求。

# 3. 日志分析的实践应用

## 3.1 日志格式与解析技巧

### 3.1.1 日志格式的标准与自定义

日志格式化是日志分析的关键步骤。标准的日志格式可以提高日志数据的可用性,并为后续的数据分析、存储和查询提供便利。常见的日志格式有Apache日志格式、Syslog格式等。这些格式化规范为日志信息的组织提供了模板,使得日志事件的一致性和可预测性得到保证。

自定义日志格式通常要求日志记录器(logger)提供足够的灵活性,允许用户指定日志输出的结构和内容。例如,使用JSON格式记录日志时,可以根据需要包含时间戳、日志级别、消息、请求ID、源文件位置等字段。这样做的好处是数据结构清晰,便于程序解析和数据的长期存储。

在实际应用中,考虑到不同日志收集工具的兼容性和解析能力,通常会采用多种标准和自定义格式相结合的方法。例如,在Fluent框架中,可以轻松配置日志的输出格式,以满足不同的日志处理需求。

```json

{

"time": "2023-04-01T12:00:00Z",

"level": "INFO",

"message": "User login succeeded.",

"request_id": "6789",

"source_file": "app/main.go"

}

```

### 3.1.2 正则表达式在日志解析中的应用

正则表达式是处理文本和数据的强大工具,尤其在日志解析中扮演着重要角色。通过定义模式,正则表达式可以帮助我们从非结构化或半结构化的文本数据中提取出结构化信息。

在处理日志文件时,利用正则表达式可以快速定位并提取出错误代码、异常堆栈跟踪、用户行为事件等关键数据。以下示例展示了如何使用正则表达式来解析一个日志条目,从中提取时间和日志级别。

```regex

(?P<time>\d{4}-\d{2}-\d{2}T\d{2}:\d{2}:\d{2}Z)\s+(?P<level>\w+)\s+(?P<msg>.+)

```

在上面的正则表达式中,定义了三个命名捕获组:`time`、`level` 和 `msg`,分别对应日志的时间戳、日志级别和消息内容。当这个表达式应用于一段日志文本时,可以按照这些预定义的模式提取信息。

## 3.2 实时日志分析的工具与方法

### 3.2.1 流式处理技术介绍

流式处理技术是一种实时处理数据流的方法,主要用于处理实时数据,如实时日志。流式处理允许用户从数据源中连续不断地获取数据,并对其进行实时分析,最终实现对数据流的实时响应。

Apache Kafka、Apache Flink、Apache Storm和Spark Streaming是流式处理技术的典型代表。这些工具通常与消息队列、数据流处理框架紧密集成,支持大规模数据的实时处理,能够在数据到达时立即进行分析,为下游系统提供实时决策支持。

流式处理不仅仅是数据的“管道”,它还包括对数据进行复杂

0

0