Hadoop在机器学习中的应用:构建高效的数据分析流程

发布时间: 2024-10-27 23:41:29 阅读量: 40 订阅数: 49

大数据开发实战案例:构建高效数据分析平台.zip

# 1. Hadoop与机器学习简介

## 1.1 Hadoop的起源与定义

Hadoop是由Apache软件基金会开发的一个开源框架,它的出现源于Google发表的三篇关于大规模数据处理的论文,分别是关于GFS(Google File System)、MapReduce编程模型和BigTable的数据模型。Hadoop旨在提供一个可靠、可扩展的分布式系统基础架构,用于存储和处理大数据。

## 1.2 机器学习的基础概念

机器学习是人工智能的一个分支,它让计算机通过算法,从大量数据中学习并做出预测或决策,而无需进行明确的程序设计。机器学习算法通常可分为监督学习、非监督学习、半监督学习和强化学习等类别。

## 1.3 Hadoop与机器学习的结合

在大数据时代,Hadoop为机器学习提供了处理和分析大规模数据集的能力。通过其生态中的MapReduce和YARN等组件,可以在Hadoop上实现分布式机器学习算法,从而提升算法的处理速度和规模,尤其是在特征提取、数据预处理和模型训练等关键步骤。

Hadoop的出现使得原本在有限数据量上运行的机器学习模型得以在海量数据集上进行训练,增强了机器学习的准确性和应用范围。同时,它也推动了大数据分析与机器学习的交叉融合,为数据科学家和工程师提供了强大的工具。随着对大数据分析需求的不断增长,Hadoop与机器学习的结合变得愈发紧密,已成为大数据技术和人工智能领域不可或缺的一部分。

# 2. Hadoop生态系统概览

### 2.1 Hadoop的核心组件

#### 2.1.1 HDFS的存储原理

Hadoop Distributed File System(HDFS)是Hadoop的核心组件之一,专门用于在普通硬件上存储大规模数据集。HDFS的设计理念来源于Google的GFS论文,它采用主从(Master/Slave)架构,由一个NameNode和多个DataNode构成。

- **NameNode(主节点)**:负责管理文件系统的元数据,维护文件系统的命名空间,记录每个文件中各个块所在的DataNode节点信息。

- **DataNode(数据节点)**:实际存储数据,为文件提供块存储服务。数据以块为单位存储在节点上,每个块默认大小为128MB(可以通过配置更改)。

HDFS通过冗余存储来保证数据的高可用性和容错性。每个块会有多个副本存储在不同的DataNode上(默认3个副本)。副本的存储策略允许Hadoop在部分节点失败的情况下继续工作,提高了系统的容错性。

```bash

# HDFS的一个简单操作示例:查看文件系统状态

hdfs dfs -ls /

```

此命令会列出HDFS根目录下的所有文件和文件夹。在执行时,会与NameNode进行交互来获取元数据,并与DataNode通信以展示数据块的存储状态。

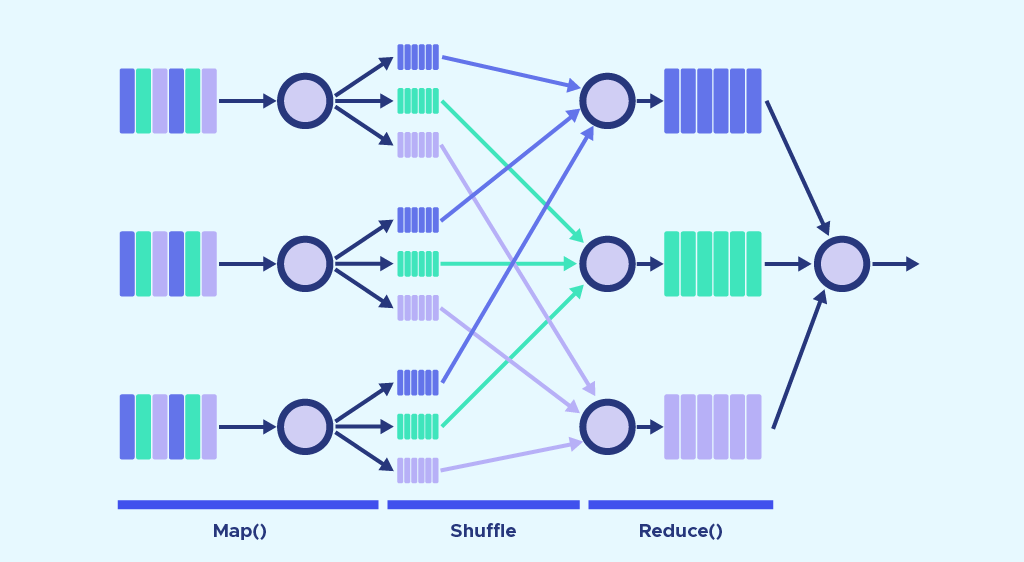

#### 2.1.2 MapReduce的工作流程

MapReduce是一种编程模型,用于处理和生成大数据集。用户通过定义map和reduce两个函数,让MapReduce框架自动处理数据的分割、任务调度、容错和排序等复杂过程。

- **Map阶段**:输入数据被分割成一系列可并行处理的子任务,Map函数处理这些子任务,并输出中间键值对(key-value pairs)。

- **Shuffle阶段**:框架自动处理Map输出的中间数据,将具有相同key的数据分组,然后传递给Reduce函数。

- **Reduce阶段**:Reduce函数处理所有具有相同key的中间数据,输出最终结果。

```java

// 一个简单的MapReduce示例代码片段,用于统计单词出现的次数

public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

```

在上述代码中,`TokenizerMapper`类用于将文本拆分成单词,并为每个单词计数。`IntSumReducer`类则将具有相同单词的所有计数合并成一个总数。MapReduce框架将自动处理数据的分配和合并工作。

### 2.2 Hadoop的周边工具

#### 2.2.1 Hive与数据仓库

Hive是建立在Hadoop之上的数据仓库工具,它提供了一个类SQL查询语言——HiveQL,让熟悉SQL的用户能够轻松进行数据的查询、汇总和分析。

- **数据存储**:Hive将表数据存储在HDFS中,并通过元数据存储描述表结构信息。

- **查询处理**:HiveQL语句被翻译成MapReduce任务,这些任务随后在Hadoop集群上执行。

- **性能优化**:Hive支持索引、分区和桶等技术来优化查询性能。

```sql

-- HiveQL的一个简单查询示例:选择数据仓库中员工表的记录数

SELECT COUNT(*) FROM employees;

```

#### 2.2.2 Pig的高级数据流语言

Pig是一个高层次的数据流语言和执行框架,用于简化MapReduce编程。Pig的脚本语言叫做Pig Latin,它将数据分析转化为一系列数据转换过程。

- **数据处理**:Pig Latin提供加载(LOAD)、存储(STORE)、过滤(FILTER)、映射(MAP)、排序(ORDER BY)等多种操作。

- **脚本执行**:Pig将Pig Latin脚本转化为一系列的MapReduce任务,然后提交到Hadoop执行。

```pig

-- Pig Latin的一个简单转换示例:过滤出员工表中薪资超过50000的记录

filtered_employees = FILTER employees BY salary > 50000;

```

#### 2.2.3 HBase的非关系型数据库特性

HBase是构建在Hadoop之上的分布式NoSQL数据库,适用于需要快速随机访问超大规模数据集的场景。HBase提供稀疏的、多维的映射存储,其数据模型类似于Google的BigTable。

- **数据模型**:HBase使用行键、列族和时间戳来存储数据。数据以列的形式存储,并可以随时添加新的列。

- **集群架构**:HBase集群由一个或多个RegionServer节点组成,每个RegionServer负责管理一部分数据。HBase使用ZooKeeper进行节点之间的协调。

- **数据访问**:数据通过API或HBase Shell进行访问,支持Get、Scan、Put和Delete等操作。

```java

// 使用HBase Java API的一个简单操作示例:插入数据

Configuration config = HBaseConfiguration.create();

HTable table = new HTable(config, "employees");

Put put = new Put(Bytes.toBytes("row1"));

put.add(Bytes.toBytes("info"), Bytes.toBytes("name"), Bytes.toBytes("Alice"));

table.put(put);

```

在上面的Java代码中,我们创建了一个名为“employees”的HBase表

0

0