Hadoop集群性能优化:解决大数据处理中的瓶颈问题

发布时间: 2024-10-27 22:37:07 阅读量: 248 订阅数: 30

Hadoop集群高可用与性能优化

# 1. Hadoop集群性能优化概述

大数据分析的需求促使Hadoop集群成为处理海量数据的核心工具,但随着数据量的增长,集群的性能问题逐渐凸显。性能优化作为提升Hadoop效率的关键手段,已成为系统管理员和开发者的必修课。

性能优化不仅关注单一组件,还涉及整个集群的各个层面。从硬件选择到软件配置,再到集群使用策略,优化的目的是使Hadoop集群在满足业务需求的同时,实现资源的最大化利用和成本的最小化。

在接下来的章节中,我们将深入探讨Hadoop集群架构及其性能瓶颈,硬件和软件层面的优化策略,以及如何运用高级技术对Hadoop集群进行优化。了解这些知识,将有助于IT从业者在实际工作中更有效地管理Hadoop集群,为用户提供稳定和快速的数据处理服务。

# 2. 理解Hadoop集群的架构和瓶颈

## 2.1 Hadoop集群的主要组件和工作原理

Hadoop集群是一个高度可扩展的分布式存储和计算平台,它被设计用来处理大量的数据。了解其主要组件和工作原理对于识别和解决性能瓶颈至关重要。

### 2.1.1 HDFS的工作原理和性能影响因素

Hadoop分布式文件系统(HDFS)是Hadoop的核心组件之一,它提供高吞吐量的数据访问,非常适合于大规模数据集的存储。HDFS的设计是基于高容错性的,它将大文件分割成块(blocks),默认情况下每个块的大小是128MB。

#### HDFS的架构

HDFS由一个NameNode和多个DataNodes组成。NameNode是中心服务器,负责管理文件系统的命名空间和客户端对文件的访问。DataNode则负责存储实际的数据块,并在文件写入时接收数据并存储。客户端通过与NameNode通信来获取数据块的位置信息,然后直接从DataNode读取或写入数据。

#### HDFS性能影响因素

HDFS的性能主要受以下几个因素影响:

- **数据块大小**:数据块的大小直接影响I/O性能和网络传输效率。较大的数据块可以减少寻址次数,但增加了单次失败的风险和内存消耗。

- **副本策略**:副本数会影响数据的可靠性和读取性能。增加副本可以提高容错能力,但也增加了存储和I/O开销。

- **NameNode的内存**:NameNode的内存大小限制了它可以管理的文件系统的大小和复杂性。内存不足会导致性能瓶颈和系统不稳定性。

### 2.1.2 MapReduce的工作原理和性能影响因素

MapReduce是一种编程模型,用于处理和生成大数据集。用户可以通过编写Map和Reduce函数来实现复杂的处理逻辑。

#### MapReduce的工作流程

MapReduce作业通常分为两个阶段:Map阶段和Reduce阶段。在Map阶段,输入数据被分割成独立的块,这些块可以并行处理。Map函数处理数据块,生成中间键值对。在Reduce阶段,Map阶段的输出被分组并传给Reduce函数进行汇总。

#### MapReduce性能影响因素

MapReduce性能影响因素主要包括:

- **Map任务数量**:Map任务的数量应与集群的Map槽位(slot)数量相匹配。过多的Map任务会导致上下文切换和调度开销增大。

- **Shuffle过程**:Shuffle过程负责数据的排序、分组和传输,是影响MapReduce性能的关键。优化Shuffle阶段可以显著提高性能。

- **资源分配**:合理的资源分配(CPU、内存和硬盘I/O)可以保证MapReduce作业高效运行。

## 2.2 常见的性能瓶颈和诊断方法

### 2.2.1 网络瓶颈的识别与解决

网络瓶颈是影响Hadoop集群性能的常见问题之一。当网络带宽不足或网络配置不合理时,会严重影响数据传输效率。

#### 网络瓶颈的识别

识别网络瓶颈通常可以通过监控网络流量和使用网络诊断工具来完成。使用如`iftop`、`nethogs`等工具可以监控实时的网络流量,并识别出导致网络拥堵的节点。

#### 解决网络瓶颈的策略

解决网络瓶颈的策略包括:

- 升级网络硬件,如使用更快的网络接口卡和交换机。

- 优化网络配置,例如调整TCP缓冲区大小,以减少延迟。

- 优化数据布局,例如采用数据本地化策略,减少跨网络的数据传输。

### 2.2.2 硬盘I/O瓶颈的识别与解决

硬盘I/O瓶颈通常是由于磁盘读写能力不足,无法满足高并发数据访问需求引起的。

#### 硬盘I/O瓶颈的识别

通过监控工具(如`iostat`)可以观察到磁盘的读写速率和队列长度。如果发现读写速率长时间处于高位,或者队列长度明显增长,则可能存在I/O瓶颈。

#### 解决硬盘I/O瓶颈的策略

解决硬盘I/O瓶颈的策略包括:

- 使用更快的磁盘,比如从机械硬盘(HDD)升级到固态硬盘(SSD)。

- 优化数据分布,使用RAID技术增加读写效率。

- 减少磁盘I/O竞争,比如增加数据块大小或调整副本数量。

### 2.2.3 CPU和内存资源瓶颈的识别与解决

CPU和内存资源瓶颈通常发生在计算密集型任务或者内存消耗大的场景中。

#### CPU和内存瓶颈的识别

CPU和内存资源瓶颈的识别可以通过系统监控工具(如`top`、`htop`、`vmstat`)来进行。这些工具可以提供实时的资源使用数据,帮助我们了解CPU和内存的使用情况。

#### 解决CPU和内存瓶颈的策略

解决CPU和内存瓶颈的策略包括:

- 优化应用程序,提高代码效率,减少不必要的资源消耗。

- 增加资源分配,通过增加CPU核心数或内存容量来提高处理能力。

- 采用资源管理工具(如YARN)进行资源调度优化,确保关键任务有足够的资源。

在后续章节中,我们将深入探讨如何通过硬件优化策略和软件配置调整来进一步提升Hadoop集群的性能,并介绍一些高级优化技术,以实现更高效的集群资源利用和任务处理。

# 3. Hadoop集群的硬件优化策略

## 3.1 选择合适的硬件配置

### 3.1.1 CPU的选择和优化

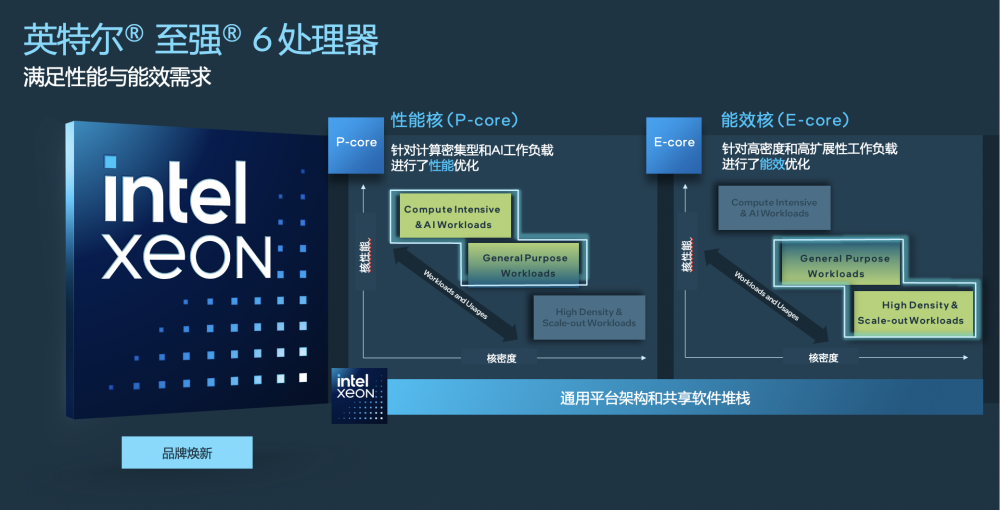

在Hadoop集群中,CPU是处理数据任务的主力。选择合适的CPU对提升集群性能至关重要。在选择CPU时,应考虑以下因素:

- **核心数量**:更多的核心意味着可以同时处理更多的任务。但并非核心越多性能就越好,需要与集群的任务类型和工作负载相匹配。

- **时钟频率**:CPU的时钟频率越高,单个任务的处理速度越快,但高频处理器可能会产生更多的热量。

- **指令集**:支持高级指令集的CPU可以提高数据处理效率,如AVX指令集可加速数据密集型应用。

为了优化CPU性能,可以采取以下措施:

- **核心分配策略**:合理分配CPU核心给不同的Hadoop守护进程,例如DataNode和TaskTracker,确保它们可以获得足够的资源。

- **超线程技术**:通过启用超线程技术,让每个物理核心可以同时处理多个线程,提高CPU利用率。

- **节能管理**:根据集群的负载动态调整CPU的工作状态,避免资源浪费。

```shell

# 示例:使用lscpu命令查看CPU信息

$ lscpu

Architecture: x86_64

CPU op-mode(s): 32-bit, 64-bit

Byte Order: Little Endian

CPU(s): 48

On-line CPU(s) list: 0-47

Thread(s) per core: 2

Core(s) per socket: 12

Socket(s): 2

NUMA node(s): 2

```

在上述代码块中,通过执行`lscpu`命令,我们可以获取当前服务器CPU的详细配置信息,从而为集群的CPU选择和优化提供依据。

### 3.1.2 内存的选择和优化

内存是影响Hadoop集群性能的另一个关键因素。内存的大小直接关系到能否快速处理大量数据。

- **容量**:内存容量越大,能够缓存的数据就越多,可以减少磁盘I/O操作,提高数据处理速度。

- **类型**:目前DDR3和DDR4是主流,DDR4由于其低功耗和高频率特性,通常优于DDR3。

- **配置策略**:正确配置JVM堆内存大小,避免内存溢出或不足。

为了优化内存性能,可以执行以下操作:

- **内存分页**:合理配置Hadoop的内存分页设置,如设置合理的`dfs.datanode.max.locked.memory`。

- **交换空间**:当物理内存不足时,系统会使用交换空间,这会显著降低性能,因此应尽量避免使用交换空间。

- **垃圾回收机制**:优化Java虚拟机的垃圾回收策略,以减少因内存管理导致的延迟。

```java

// 示例:Java虚拟机内存配置

-Xmx3072m -Xms3072m -Xmn512m -XX:+UseConcMarkSweepGC

```

在上述代码块中,通过配置Java参数,我们可以设置虚拟机的最大和初始堆内存为3GB,并且指定使用并发标记清除垃圾回收器来优化内存管理。

### 3.1.3 磁盘的选择和优化

磁盘是数据存储和读写的物理介质,其性能直接影响到Hadoop集群的I/O性能。

- **类型**:HDD和SSD是常见的磁盘类型。SSD由于其高读写速度,能够显著提升Hadoop集群的性能,尤其是在随机I/O场景。

- **容量与速度**:磁盘容量需要足够大以存储大量数据,而转速越快的磁盘,读写速度也越快。

- **RAID技术**:通过使用RAID技术,可以提供磁盘冗余和/或提升性能。

为了优化磁盘性能,可以采取以下措施:

- **磁盘类型选择**:根据业务需求选择合适类型的磁盘,对于高性能要求的场景推荐使用SSD。

- **分区策略**:对Hadoop集群的数据存储进行合理的分区管理,以平衡存储负载。

- **磁盘维护**:定期进行磁盘检测和维护,包括检查坏道、进行磁盘碎片整理等。

```shell

# 示例:使用df命令查看磁盘使用情况

$ df -h

Filesystem Size Used Avail Use% Mounted on

/dev/sda1 99G 71G 29G 71% /

/dev/sdb1 146G 113G 34G 77% /data

```

通过上述`df`命令,我们可以查看到各个磁盘的使用情况,为集群的磁盘性能优化提供数据支持。

## 3.2 网络架构的设计和优化

### 3.2.1 高速网络解决方案

高速网络能够显著降低数据传输时间,对于大型Hadoop集群来说至关重要。

- **网络速度**:选择10Gbps或更高带宽的网络设备可以有效减少数据传输延迟。

- **交换机选择**:高性能交换机可以提供更少的数据包丢失率和更快的数据传输速度。

- **冗余设计**:采用冗余网络设计可以提升网络的稳定性和可靠性。

为了优化网络性能,可以执行以下操作:

- **链路聚合**:将多个物理网络链路绑定成一个逻辑链路,以提高带宽和容错能力。

- **网络配置优化**:根据业务场景调整TCP/IP参数,如增大TCP缓冲区大小。

- **网络监控**:实施网络监控工具,如Wireshark或Nagios,来及时发现并处理网络问题。

```shell

# 示例:配置网络接口的链路聚合

$ cat /etc/network/interfaces

auto bond0

iface bond0 inet static

address ***.***.*.**

netmask ***.***.***.*

slaves eth0 eth1

bond-mode 4

bond-miimon 100

```

在上述代码块中,我们配置了网络接口bond0作为链路聚合接口,通过绑定eth0和eth1两个物理网卡来提供高带宽和冗余。

### 3.2.2 网络拓扑的优化

优化网络拓扑结构,可以有效提高数据传输效率和降低延迟。

- **扁平化拓扑**:较短的网络路径可以减少跳数,提高数据包传输速度。

- **核心-分布层拓扑**:这种层次化设计可以为大量节点之间的通信提供有效支持。

- **数据中心互联**:对于多数据中心的集群,需要优化数据中心之间的互联,例如通过高速光纤链路连接。

为了优化网络拓扑,可以采取以下措施:

- **负载均衡**:在网络设备上实施负载均衡,分散流量压力,避免单点过载。

- **拓扑优化工具**:使用网络拓扑优化工具,如Cisco的Optimized Edge Routing (OER)。

- **QoS策略**:在网络设备上实施QoS策略,保证关键数据流优先级。

```mermaid

graph LR

A[Client] -->|请求数据| B[边缘路由器]

B --> C[核心交换机]

C -->|数据包| D[数据中心1]

C -->|数据包| E[数据中心2]

D --> F[Hadoop集群1]

E --> G[Hadoop集群2]

```

在上述mermaid格式流程图中,我们描绘了一个基于核心-分布层拓扑的网络结构,它展示了从客户端到不同数据中心Hadoop集群的路径。

综上所述,通过对硬件配置的精挑细选和网络架构的科学设计,可以有效优化Hadoop集群的性能。硬件是集群的基础,而网络则是数据流动的动脉。只有两者合理搭配,才能真正发挥出集群的潜能。

# 4. Hadoop集群的软件优化实践

## 4.1 Hadoop配置参数的调优

### 4.1.1 HDFS参数调优

在Hadoop集群中,HDFS是存储数据的核心组件,而其性能直接影响整个集群的效率。对HDFS进行参数调优,通常涉及块大小、副本数量和读写缓存等关键参数的调整。

#### 关键参数和优化策略

- `dfs.block.size`:HDFS的块大小是影响读写性能的重要参数。较大的块大小可以减少NameNode的元数据负担,同时提高大型文件的读写性能,但会增加单次故障的数据损失量。需要根据实际数据集的大小和访问模式来调整。

- `dfs.replication`:这个参数设置数据的副本数量。更多的副本可以提高数据的可靠性,但同时会消耗更多的存储空间和增加写入延迟。如果集群硬件资源充足,且对数据可靠性有较高要求,可以适当增加副本数。

- `dfs.namenode.handler.count`:NameNode的线程池大小。这个参数决定了NameNode可以同时处理多少个客户端请求。适当的增加此值可以提高系统的并发处理能力,但过大的值会导致NameNode的内存消耗过高。

下面是一个简单的代码块,展示如何在`hdfs-site.xml`配置文件中调整这些参数:

```xml

<configuration>

<!-- 设置块大小为256MB -->

<property>

<name>dfs.block.size</name>

<value>***</value>

</property>

<!-- 设置副本数量为3 -->

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<!-- 增加NameNode处理器数量 -->

<property>

<name>dfs.namenode.handler.count</name>

<value>200</value>

</property>

</configuration>

```

### 4.1.2 MapReduce参数调优

MapReduce是处理大规模数据集的编程模型。优化MapReduce性能,主要关注内存管理、任务调度和数据本地化等方面。

#### 关键参数和优化策略

- `mapreduce.framework.name`:此参数决定MapReduce作业运行在哪个调度器上,默认是`yarn`。通常使用YARN来提高资源利用率和调度灵活性。

- `mapreduce.jobhistory.address`和`mapreduce.jobhistory.webapp.address`:设置作业历史服务器的地址和端口,这对于作业的监控和故障排查至关重要。

- `mapreduce.task.io.sort.factor`和`mapreduce.task.io.sort.mb`:这两个参数决定了Map输出排序阶段的内存使用。适当增加这些值可以减少磁盘I/O操作,提高排序速度。

下面是一个配置YARN和MapReduce的代码示例:

```xml

<configuration>

<!-- 使用YARN作为资源管理器 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 设置作业历史服务器地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>*.*.*.*:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>*.*.*.*:19888</value>

</property>

<!-- 调整排序内存参数 -->

<property>

<name>mapreduce.task.io.sort.factor</name>

<value>100</value>

</property>

<property>

<name>mapreduce.task.io.sort.mb</name>

<value>256</value>

</property>

</configuration>

```

通过对HDFS和MapReduce参数进行细致的调整,可以显著提高Hadoop集群的读写效率和计算能力。优化是一个持续的过程,需要根据实际应用负载和业务需求不断调整和测试。

# 5. Hadoop集群的高级优化技术

随着大数据处理需求的增长,对Hadoop集群性能的要求也越来越高。本章节深入探讨了利用Hadoop生态系统中的高级工具以及分布式计算框架进行性能调优的策略。我们将介绍如何使用Hive和Pig优化技术,Spark与Hadoop的集成优化,以及Tez、Impala和Flink等分布式计算框架的性能调优方法。

## 5.1 使用Hadoop生态系统工具进行优化

### 5.1.1 Hive和Pig的优化技术

#### Hive优化技术

Apache Hive是一个建立在Hadoop上的数据仓库框架,它提供了一个类SQL语言——HiveQL——来帮助用户进行数据查询。Hive的优化可以从多个维度入手,包括但不限于查询优化、执行计划优化和存储格式优化。

- **查询优化**

查询优化主要涉及转换复杂的HiveQL语句为更高效的执行计划。例如,通过展开视图、重写子查询、合并过滤条件等方式来减少MapReduce作业的数量,提高查询效率。

```sql

-- HiveQL示例:优化前

SELECT * FROM (SELECT user_id, COUNT(*) as purchase_count FROM purchases GROUP BY user_id) subquery WHERE subquery.purchase_count > 1;

-- HiveQL示例:优化后

SELECT user_id, COUNT(*) as purchase_count FROM purchases GROUP BY user_id HAVING purchase_count > 1;

```

在上述优化中,我们将原查询中的子查询和过滤条件合二为一,减少了不必要的MapReduce作业。

- **执行计划优化**

利用Hive的执行计划功能可以查看和分析查询的执行计划,并通过添加特定的提示(hint)来改变执行策略。如使用分区剪裁(Partition Pruning)、动态分区插入(Dynamic Partition Insert)等策略来优化执行计划。

```sql

-- HiveQL示例:使用分区剪裁

SELECT * FROM purchases WHERE year = 2021;

```

上述查询语句利用了分区剪裁,只加载与`year=2021`相关的数据部分,而不是整个表。

- **存储格式优化**

Hive支持多种数据存储格式,包括TextFile、SequenceFile、RCFile和ORCFile。ORCFile因压缩和编码效率高、处理速度快成为最推荐的存储格式。

```sql

-- 创建ORC格式的表

CREATE TABLE purchases_orc (id INT, name STRING) STORED AS ORC;

```

#### Pig优化技术

Pig是一个高级的数据流语言和执行框架,用于处理大规模数据集。Pig Latin是Pig的数据处理语言,对Pig拉丁语的查询优化主要通过加载和转换数据时的更优策略实现。

- **MapReduce任务优化**

通过减少MapReduce的启动次数,优化自定义函数(UDF)的使用效率和数据倾斜问题,可以显著提高Pig的执行性能。

```pig

-- Pig Latin示例:减少MapReduce任务

A = LOAD 'input.txt' USING PigStorage(',') AS (field1:chararray, field2:long);

B = FOREACH A GENERATE TOINT(field1) * field2;

STORE B INTO 'output.txt' USING PigStorage(',');

```

在上述示例中,通过使用`FOREACH`而不是`FILTER`,避免了不必要的MapReduce任务的启动。

- **数据压缩**

数据压缩可以减少I/O负载和加快网络传输,Pig允许使用内置压缩(比如gz和bz2)和自定义压缩算法。

```pig

-- Pig Latin示例:数据压缩

A = LOAD 'input.txt' USING PigStorage(',') AS (field1:chararray, field2:long);

B = FOREACH A GENERATE field1, field2;

STORE B INTO 'output.txt' USING PigStorage(',', '压缩算法');

```

### 5.1.2 Spark与Hadoop集成优化

Apache Spark是一个快速的分布式计算系统,它可以与Hadoop集成,使用HDFS作为数据存储。Spark的优势在于它能够使用内存计算,提供比传统MapReduce更快的数据处理速度。

- **内存管理优化**

Spark应用中的内存管理对于性能至关重要。通过优化内存分配,合理地配置`spark.executor.memory`和`spark.memory.fraction`参数,可以确保高效的内存使用。

```scala

// Spark配置示例

val conf = new SparkConf()

.setMaster("local[4]")

.setAppName("SparkHadoopIntegration")

.set("spark.executor.memory", "2g")

.set("spark.memory.fraction", "0.8")

```

- **持久化策略优化**

通过使用持久化(或称为RDD的存储级别),可以将数据缓存在内存中,避免重复计算和磁盘I/O,加快数据访问速度。

```scala

// Spark代码示例:持久化策略

val inputRDD = sc.textFile("hdfs://path/to/input")

inputRDD.persist(StorageLevel.MEMORY_AND_DISK)

```

- **执行模式优化**

Spark支持多种执行模式,如独立模式、YARN模式、Mesos模式和本地模式。选择合适的执行模式对系统资源的优化至关重要。

```bash

# Spark提交作业示例

spark-submit --class com.example.MySparkApp --master yarn --deploy-mode cluster /path/to/my-app.jar

```

## 5.2 分布式计算框架的性能调优

### 5.2.1 Tez和Impala的性能优化

Tez是一个建立在YARN上的分布式数据处理框架,它允许复杂的DAG(有向无环图)作业优化执行,而非简单地使用MapReduce的两个阶段模式。Tez可以与Hive、Pig、Presto等工具集成使用。

- **作业优化策略**

Tez通过执行计划优化和任务调度优化,提升了DAG作业的执行效率。通过合理配置Tez的执行参数,例如`tez.runtime.io.sort.factor`和`tez.runtime.memory.manager.allocation.factor`,可以进一步优化作业性能。

```xml

<!-- Tez配置示例 -->

<property>

<name>tez.runtime.io.sort.factor</name>

<value>100</value>

<description>设置排序时使用的缓冲区数量</description>

</property>

<property>

<name>tez.runtime.memory.manager.allocation.factor</name>

<value>0.95</value>

<description>设置内存管理器的分配因子</description>

</property>

```

Impala是Cloudera开发的分布式SQL查询引擎,针对Hadoop数据仓库设计,提供低延迟的查询处理能力。

- **查询性能优化**

优化Impala查询性能,可以调整集群资源分配,如内存和CPU,以及合理配置Impala的`Query Planner`参数。此外,定期维护表统计信息和使用分区也有助于性能提升。

```sql

-- Impala Shell示例:调整表结构的统计信息

INVALIDATE METADATA;

ANALYZE TABLE table_name COMPUTE STATS;

```

### 5.2.2 Flink与Hadoop的结合优化

Apache Flink是一个开源流处理框架,用于高性能、高吞吐量的数据流处理应用程序。

- **流处理与批处理优化**

Flink支持实时流处理和批处理,通过统一的执行模型实现高度优化的数据处理。针对与Hadoop结合的情况,Flink可以利用HDFS作为数据存储。

```scala

// Flink代码示例:读取HDFS中的数据进行批处理

val env = StreamExecutionEnvironment.getExecutionEnvironment

val text = env.readTextFile("hdfs://path/to/input.txt")

val counts = text.flatMap(_.split(" "))

.map((_, 1))

.keyBy(0)

.sum(1)

counts.print()

env.execute("HDFS File Read")

```

- **状态管理和检查点优化**

Flink的状态管理和检查点机制是其容错的关键。通过合理的状态后端选择和检查点间隔设置,可以提升容错性能,减少故障恢复时间。

```scala

// Flink状态后端配置示例

val config = ExecutionConfig()

config.setStateBackend(new RocksDBStateBackend("hdfs://path/to/checkpoints"))

```

通过上述高级优化技术,可以显著提高Hadoop集群的性能。这些优化手段不仅提高了处理效率,还为大数据分析提供了更好的灵活性和可扩展性。

在下一章节中,我们将讨论具体的Hadoop集群优化案例,通过实际业务场景中的性能瓶颈分析和优化策略实施来进一步展示优化技术的实际应用效果。

# 6. Hadoop集群优化案例分析

## 6.1 实际业务场景中的性能瓶颈分析

在处理大规模数据集时,Hadoop集群的性能瓶颈往往显现出不同的特征。案例分析是优化过程中的关键一环,因为只有准确地识别出瓶颈,我们才能有针对性地实施优化措施。对于Hadoop集群来说,性能瓶颈可能来自于多个方面:

- 网络I/O:大量数据在网络中的传输可能会导致网络饱和,从而影响整体性能。

- 硬盘I/O:磁盘读写速度慢,尤其是随机读写,会成为限制集群性能的瓶颈。

- CPU和内存资源:集群中的节点如果处理能力不足,将无法有效处理任务。

在具体分析时,我们应该:

- 检查网络流量和延迟,确认是否有网络拥堵。

- 利用监控工具检查磁盘I/O的读写速度,特别是磁盘队列长度。

- 使用操作系统工具监控CPU和内存的使用率,查看是否存在资源争用。

通过上述方法,我们可以识别出实际业务场景中的性能瓶颈,从而为接下来的优化策略提供依据。

## 6.2 优化策略实施与效果评估

### 6.2.1 实施步骤和方法

在确定了性能瓶颈之后,接下来就需要执行具体的优化策略。以下是优化步骤的概括:

1. **硬件升级或更换:** 如果瓶颈在于硬件资源不足,如CPU性能低下或内存容量不足,考虑升级硬件配置。

2. **软件配置调整:** 修改Hadoop的配置文件,如`hdfs-site.xml`、`mapred-site.xml`和`yarn-site.xml`,对相关的参数进行调整。

3. **代码优化:** 对于MapReduce作业,优化代码逻辑以减少不必要的数据传输和处理时间。

4. **使用更高效的算法:** 对于特定的业务场景,考虑更换更高效的处理算法。

在优化过程中,可以使用Hadoop集群提供的多种工具进行性能监控和调优,例如:

- 使用`hdfs dfsadmin -report`命令来检查HDFS的健康状况。

- 使用`yarn node -list`命令来监控各个节点的状态。

- 使用`mapred job -list`命令来跟踪MapReduce作业的执行情况。

### 6.2.2 优化效果的监控和评估指标

优化后,我们需要对集群性能进行持续监控,以确保优化措施有效,并及时发现新的瓶颈。评估优化效果的关键指标包括:

- **任务执行时间:** 优化前后任务完成的时间对比。

- **资源利用率:** CPU、内存和磁盘的使用率是否有所改善。

- **网络延迟:** 网络传输的速度是否提升。

- **吞吐量:** 集群每秒处理的数据量。

可以通过定期生成Hadoop的性能报告,或使用第三方监控工具来获取这些指标。优化效果的评估需要建立在持续监控和周期性的性能测试之上,这样我们才能确保优化措施达到预期效果,并进行进一步的调整。

通过以上章节的内容,我们深入探讨了Hadoop集群优化的理论与实践,从架构理解到案例分析,相信能够为读者提供丰富的知识和可行的解决方案。在IT领域中,理论与实践相结合,才能不断推动技术的创新与进步。

0

0