尾递归在并行计算中的应用:多核处理器性能提升的策略

发布时间: 2024-09-13 01:05:36 阅读量: 34 订阅数: 21

scala课程:Scala用于统计计算和数据科学短期课程

# 1. 尾递归与并行计算基础

## 1.1 尾递归概念简介

尾递归是一种特定形式的递归调用,其中递归调用是函数体中最后一个操作,使得编译器优化成为可能。与传统的递归不同,尾递归的优化可以避免增长调用栈,这在处理大量数据时尤为重要。

## 1.2 并行计算的定义

并行计算是指同时使用多个计算资源解决计算问题的过程。在计算机科学中,这通常意味着使用多核处理器或多个处理器来执行程序的不同部分,以减少总体运行时间。

## 1.3 尾递归与并行计算的关系

尾递归的优化与并行计算在某些方面相辅相成。在多核处理器上,能够将尾递归函数并行化,可以进一步提高效率和性能。理解两者的基本概念是深入研究尾递归并行化的前提。

### 代码示例:

```python

# Python中尾递归的简单示例

def tail_recursive_factorial(n, accumulator=1):

if n == 0:

return accumulator

return tail_recursive_factorial(n-1, accumulator * n)

```

在这个例子中,尽管Python不直接支持尾递归优化,但我们可以看到尾递归的结构。一个支持尾调用优化的语言(如Erlang或某些编译器优化的函数式语言),可以有效地优化这种类型的递归,避免栈溢出,并在多核环境中并行化。

# 2. 尾递归的理论基础

### 2.1 尾递归的定义与原理

尾递归是一种特殊的递归调用方式,在函数的最后一步中直接返回函数自身的调用结果,而不是返回一个函数调用的结果。这种递归方式对于编译器来说具有优化的潜力,因为它允许编译器重用当前函数调用的栈帧,避免了递归调用中不断增加的调用栈。

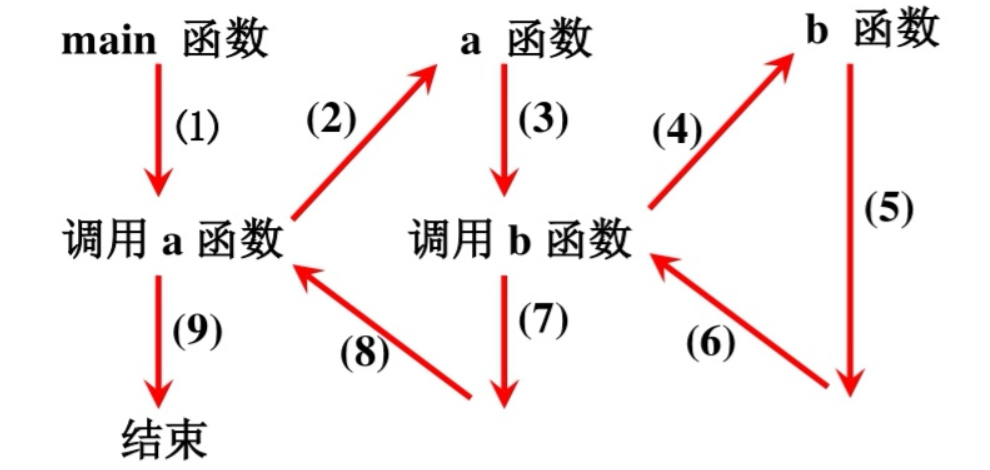

#### 2.1.1 递归的分类

递归可以分为直接递归和间接递归。直接递归是指函数直接调用自身,间接递归则是通过一个或多个其他函数间接调用自身。尾递归总是属于直接递归,因为它的逻辑结构要求函数在结束之前调用自身。了解递归的分类有助于我们识别哪些递归形式可以被优化。

#### 2.1.2 尾递归的特性

尾递归的特性中最重要的是它使得递归的执行效率得到了提高。因为每次递归调用都可以复用当前的栈帧,尾递归比普通的递归调用有更少的调用栈空间占用,从而避免了栈溢出的风险。这种特性让尾递归特别适合于递归深度大和需要高度优化的应用场景。

### 2.2 尾递归优化的必要性

#### 2.2.1 递归调用栈的问题

在没有尾调用优化的情况下,每一次递归调用都会消耗一定的栈空间,当递归深度足够大时,就会导致栈溢出。例如,在处理大规模数据集时,递归深度可能轻易达到几千甚至上万次,如果没有优化,这样的递归程序几乎是不可运行的。

#### 2.2.2 尾调用优化的机制

尾调用优化机制通过编译器优化技术实现,当检测到一个函数调用是尾递归时,编译器可以将该函数的当前栈帧重用于新的函数调用,而不是创建一个新的栈帧。这样可以显著减少内存的使用,防止栈溢出。大多数现代编译器如GCC、Clang和ECMAScript引擎都提供了对尾递归优化的支持。

### 2.3 尾递归在单核环境下的性能分析

#### 2.3.1 基准测试方法论

为了评估尾递归的性能,我们需要构建基准测试。基准测试通常包括一系列不同深度和复杂度的递归函数,并记录它们的执行时间和内存消耗。在测试时,我们可以在相同的硬件和操作系统环境下执行这些函数,并使用专业的性能分析工具来收集数据。

#### 2.3.2 性能测试结果与分析

测试结果表明,在支持尾调用优化的编译器和环境中,尾递归可以显著降低栈空间的使用,且执行时间也比普通递归更短。这说明在单核环境下,尾递归不仅在理论上有优势,在实际性能上也有明显提升。但值得注意的是,在不支持尾调用优化的环境中,尾递归并不比普通递归有优势,甚至可能因为额外的调用栈管理而更慢。

通过以上内容的讨论,我们可以清晰地了解到尾递归不仅是一种理论上的优化技术,而且在实际的编程实践中,也具有明显的性能优势。在接下来的章节中,我们将探讨并行计算与多核处理器,看看尾递归如何在并行计算领域中发挥作用。

# 3. 并行计算与多核处理器

## 3.1 并行计算的基本概念

### 3.1.1 并行与并发的区别

并行计算和并发计算是现代计算机科学中的核心概念,它们通常被用来描述多个计算任务同时执行的过程。但是,这两个术语虽然相似,却有着本质的区别。并发是指两个或多个事件在同一时间间隔内发生,不必同时发生,例如在单核处理器上通过时间片轮转技术模拟出的多任务环境。相比之下,并行是指两个或多个事件在同一时刻同时发生,这通常需要多核处理器或多台机器来实现。

**并发 (Concurrency)**:

- 事件可以相互穿插进行,不一定需要同时进行。

- 在单核 CPU 上模拟出来的“并行”。

- 需要通过多线程或多进程,以及相应的调度机制来实现。

- 例如,操作系统中的进程和线程调度。

**并行 (Parallelism)**:

- 事件真实地同时发生。

- 需要多核 CPU 或多个处理单元来支持。

- 可以通过多线程或多进程实现,但更强调硬件级别的同时执行。

- 例如,在超级计算机或具有多个 GPU 的工作站上执行的运算。

理解并发与并行的区别,对于设计高效的并行程序和优化系统性能至关重要。随着多核处理器的普及,软件开发者和系统架构师需要更加关注如何利用并行性来提高计算效率和响应速度。

### 3.1.2 并行计算的模型和策略

并行计算模型和策略是描述如何有效地组织和管理计算任务以利用多个处理器的核心概念。并行计算模型根据抽象级别和设计目标,可以分为以下几类:

- 数据并行(Data Parallelism):在这种模型中,相同的操作被应用于不同的数据集上。例如,矩阵乘法中,可以将矩阵分成多个块,并在每个块上并行执行乘法操作。

- 任务并行(Task Parallelism):任务并行侧重于将计算任务分解为可以同时执行的子任务。这些子任务可以是不同类型的,例如在图像处理中,一边执行滤波,一边执行边缘检测。

- 流水线并行(Pipelined Parallelism):流水线并行模型模拟生产流水线,每个处理阶段负责计算的一部分,并将结果传递给下一个阶段,直到最终完成。

- 粗粒度并行(Coarse-Grained Parallelism):在粗粒度并行中,任务被划分成相对较大的单元,每个单元的执行时间较长。

- 细粒度并行(Fine-Grained Parallelism):细粒度并行模型将任务划分为很小的单元,这些单元之间有大量的交互和同步要求。

不同的并行策略和模型需要根据具体应用场景和硬件环境来选择。例如,在多核处理器上实现并行计算时,要考虑到线程的创建和销毁成本、数据同步和通信开销等因素。并行计算策略的选择将直接影响程序的性能和可扩展性。

## 3.2 多核处理器的架构与工作原理

### 3.2.1 多核处理器的核心设计

多核处理器是指在一个物理芯片上集成了两个或多个独立的处理核心的处理器。每个核心都有自己的算术逻辑单元(ALU)、控制单元(CU)、寄存器和缓存等资源,可以独立执行计算任务。这种设计的核心优点在于能提供更高的性能和更低的功耗

0

0