【K-means初始化问题解决之道】:K-means++算法的专业解析

发布时间: 2024-12-15 18:53:18 阅读量: 17 订阅数: 15

K-means.rar_K._k-means聚类算法

参考资源链接:[K-means聚类算法详解及应用](https://wenku.csdn.net/doc/2fg9jjg6qn?spm=1055.2635.3001.10343)

# 1. K-means算法的原理与挑战

K-means算法是数据挖掘与机器学习中用于聚类分析的一种基础且广为使用的算法。它的核心思想是将数据集中的样本点划分到若干个簇中,使得每个样本点都属于离它最近的簇中心。

## 1.1 算法的目标函数

K-means算法的目标函数是通过最小化每个簇内点到其簇中心的距离的平方和来实现的,即最小化惯性距离。数学上,这可以表示为:

\[ J = \sum_{i=1}^{k}\sum_{x \in C_i} ||x - \mu_i||^2 \]

其中,\( J \) 是惯性,\( k \) 是簇的数量,\( C_i \) 是第 \( i \) 个簇,\( x \) 是簇内的数据点,\( \mu_i \) 是簇 \( C_i \) 的中心。

## 1.2 算法的迭代过程

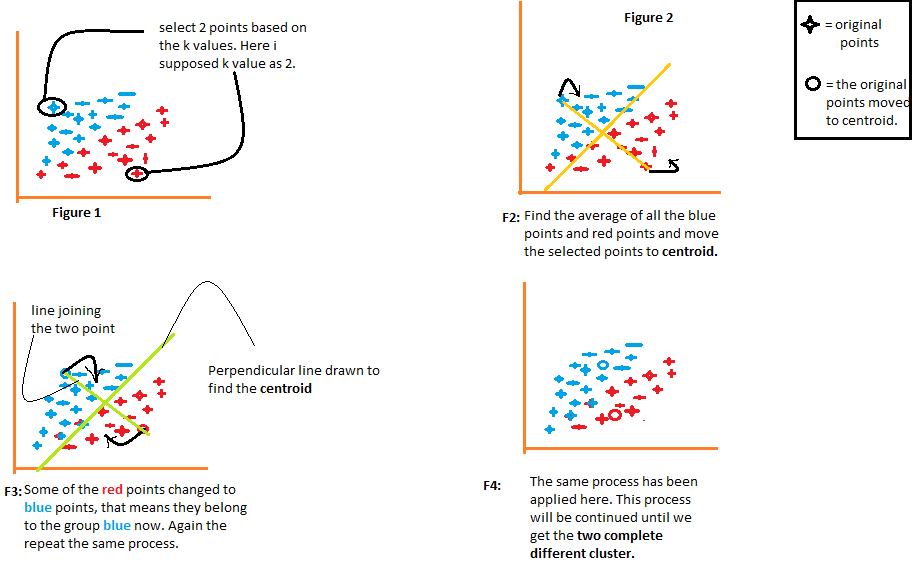

K-means算法开始时随机选择 \( k \) 个数据点作为初始簇中心,然后重复以下步骤直至收敛:

1. 将每个数据点分配到最近的簇中心。

2. 重新计算每个簇的中心位置。

3. 重复步骤1和2直到簇中心不再发生变化或达到预设的迭代次数。

这个过程通俗易懂,但面临挑战,如对初始值敏感导致局部最优、无法处理非球形簇、对噪声和孤立点敏感等问题,这些挑战促使了改进型算法如K-means++的提出。

# 2. K-means++算法的理论基础

## 2.1 K-means算法的数学模型

### 2.1.1 聚类的目标函数

K-means算法是经典的聚类分析方法,其核心思想是通过迭代将数据点划分为K个聚类,使得每个数据点都属于其最近的聚类中心,从而使得聚类内部的相似度高,而聚类间的差异大。数学上,这种思想被描述为最小化目标函数,通常表示为:

\[ J = \sum_{i=1}^{k} \sum_{x \in C_i} || x - \mu_i ||^2 \]

其中,\(J\)代表目标函数,\(K\)代表聚类的数量,\(C_i\)是第\(i\)个聚类,\(x\)是数据点,\(\mu_i\)是第\(i\)个聚类的中心,\(||x - \mu_i||^2\)代表数据点到聚类中心的欧几里得距离的平方。

为了最小化目标函数\(J\),K-means算法通过反复的迭代过程来调整聚类中心的位置。每一轮迭代包括两个步骤:一是将每个数据点分配给最近的聚类中心,二是更新聚类中心为属于该聚类的所有点的均值。

### 2.1.2 算法的迭代过程

K-means算法的迭代过程可以分为以下几个步骤:

1. **初始化**:随机选择\(K\)个数据点作为初始聚类中心。

2. **分配**:对于每一个数据点\(x\),计算它与每一个聚类中心\(\mu_i\)的距离,将其分配到最近的聚类中心,形成\(K\)个聚类。

3. **更新**:重新计算每个聚类的中心,即为该聚类内所有点的均值。

4. **重复**:重复步骤2和3直到聚类中心不再发生变化,或者达到预设的迭代次数,或者聚类内点的分配不再改变。

## 2.2 K-means++算法的创新点

### 2.2.1 初始化策略的改进

K-means++算法是K-means算法的一个改进版本,其主要的创新点在于更加智能的初始化策略。K-means++算法试图让初始聚类中心更加均匀地分散在数据空间中,以期达到更快的收敛速度和更稳定的聚类结果。

K-means++初始化策略的步骤如下:

1. 从数据集中随机选择一个点作为第一个聚类中心。

2. 对于数据集中的每个点\(x\),计算它到最近的已选择聚类中心的距离\(D(x)\)。

3. 选择一个新的点作为下一个聚类中心,选择概率与\(D(x)^2\)成正比。

4. 重复步骤2和3,直到选择了\(K\)个聚类中心。

通过这种方式,K-means++算法倾向于选择距离现有聚类中心较远的新中心,这有助于增加聚类中心之间的距离,从而提升算法的性能。

### 2.2.2 初始化的理论优势

K-means++算法的初始化方法具有理论上的优势,这一点已经在数学上得到了证明。研究表明,与传统的随机初始化相比,K-means++的初始化策略可以显著降低目标函数\(J\)的期望值,即算法能够更快地收敛到一个较好的局部最小值。

具体来说,K-means++算法的初始化能够使得在随后的迭代过程中,每个数据点被正确分类的概率更大。这种初始化方式与随机初始化相比,很大程度上减少了“坏”的初始化,即初始聚类中心选择不当导致的迭代次数增多和收敛速度慢的问题。

该算法的理论优势让K-means++在实际应用中通常比传统的K-means算法表现更加出色,尤其是当数据集较大时,初始化的影响会被放大,K-means++的优势也更加明显。

# 3. K-means++算法的实践应用

## 3.1 K-means++算法的代码实现

### 3.1.1 算法流程的详细步骤

在本章节中,我们将详细了解K-means++算法在实际操作中如何被实现。K-means++算法流程是对传统K-means算法的改进,在初始质心选择上采用了更加智能的方法。下面是算法的详细步骤:

1. **选择初始质心**:不同于K-means随机选择初始质心的方式,K-means++首先随机选择一个数据点作为第一个质心,然后计算每个点到最近质心的距离,并按照概率选择下一个质心。这样选择的质心既考虑了数据的分布,又保留了一定的随机性。

2. **分配数据点**:每个数据点根据与各个质心的欧几里得距离被分配到最近的质心所代表的簇中。

3. **更新质心**:在数据点被分配到簇之后,重新计算每个簇的质心,通常这是簇内所有点的均值。

4. **迭代**:重复执行步骤2和3,直到质心不再发生变化或达到预定的迭代次数。

### 3.1.2 代码实现的关键点

实现K-means++算法的关键在于初始质心的选择策略和质心更新逻辑。以下是一个简单的Python代码实现,展示了算法的步骤:

```python

import numpy as np

from sklearn.preprocessing import StandardScaler

# 定义K-means++算法

def kmeans_plusplus(X, k):

# X: 数据集

# k: 簇的数量

# 标准化数据

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# 随机选择第一个质心

centers = [X_scaled[np.random.choice(range(len(X_scaled)))]]

for _ in range(k - 1):

# 计算每个点到最近质心的

```

0

0