【R语言决策树构建全攻略】:party包的终极实战手册

发布时间: 2024-11-02 04:17:40 阅读量: 37 订阅数: 38

《R语言数据挖掘》第五章+R的决策树:数据预测.ppt

# 1. R语言与决策树基础

在数据分析和机器学习领域,决策树是一种广泛使用的预测模型,因其模型的直观性和易于解释而受到青睐。本章将重点介绍决策树的基本概念,并概述如何在R语言环境中运用它来解决问题。首先,我们会探索决策树的起源和它的基本构成,包括树的根节点、内部节点、分支和叶节点。随后,我们将简单回顾R语言的相关知识,这将帮助读者们快速进入下一章的内容,在那里我们会具体学习如何使用R语言的`party`包来构建和应用决策树。

接下来,我们会深入了解决策树的工作原理,即通过递归地将数据集分割为更小的子集,最终形成一棵可以进行分类或回归预测的树。通过这个过程,决策树能够学习数据中的规律并作出预测,这一过程不仅适合于数据科学家,对于想要在日常工作中使用高级数据分析技术的IT从业者也同样适用。在本章的最后,我们会简要介绍决策树的一些限制,比如过度拟合的问题以及如何通过剪枝等技术来改善这些问题,为下一章详细解析`party`包打下基础。

# 2. party包简介与安装

## 2.1 party包概述

在统计学和机器学习领域,决策树作为一种重要的预测建模方法,在分类和回归任务中都得到了广泛的应用。party包是R语言中一个功能强大的决策树构建工具,它提供了一种称为条件推断树(Conditional Inference Trees)的算法。与传统决策树不同,条件推断树在每一个分割点的选择上都是基于统计测试的结果,这使得模型在预测性能和稳定性方面都有很好的表现。

party包的一个显著特点是它对分类变量和连续变量的处理非常灵活,能够自动处理分类变量的多级分类问题,并且在树的构建过程中不需要预设任何参数。此外,party包还提供了交叉验证和多种树模型的优化手段,可以帮助用户快速构建高准确度的预测模型。

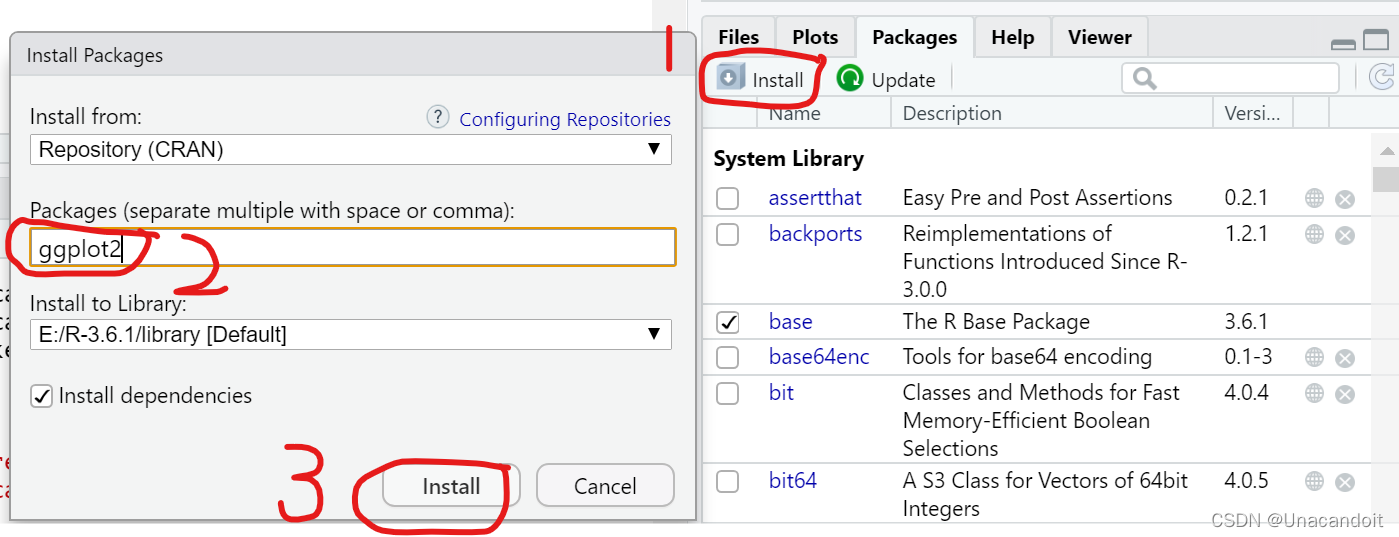

## 2.2 安装party包

在安装party包之前,请确保您的R环境已经安装好,并且可以正常访问CRAN(The Comprehensive R Archive Network)仓库。以下是安装party包的步骤:

```r

# 安装party包

install.packages("party")

# 加载party包以供使用

library(party)

```

安装完成后,您可以使用`library()`函数加载party包,以便在R中使用它提供的函数和功能。

## 2.3 party包的主要功能

party包不仅提供了构建决策树的`ctree()`函数,还包括了用于树模型可视化和解释的函数,如`plot()`和`varimp()`等。这些函数让模型的解读和结果的展示变得更加直观和容易。

在本章的后续部分,我们将深入探讨如何使用party包构建决策树模型,以及如何解读和优化这些模型。让我们从导入数据集和前期处理开始,逐步深入到决策树模型的构建过程中去。

```r

# 示例:导入数据集iris

data(iris)

# 查看数据集的结构

str(iris)

```

接下来,我们将逐步深入到使用party包构建决策树的具体步骤中,从数据处理到模型构建,再到模型评估和优化。通过这一系列的分析,您将能够掌握如何利用party包解决实际问题。

# 3. 使用party包构建决策树

## 3.1 基于party包的决策树构建过程

### 3.1.1 导入数据集和前期处理

在开始构建决策树之前,我们需要导入数据集并进行前期处理。这一阶段的关键步骤包括数据的读取、处理缺失值、编码类别变量以及特征选择。以`party`包为例,我们通常使用R语言的`read.csv()`函数来读取CSV格式的数据集。处理缺失值的常用方法包括删除含有缺失值的行或列,或者使用中位数、均值等填充缺失值。对于类别变量,我们可能需要将其转换为因子(factor)类型,以便`ctree()`函数可以正确处理。

```R

# 导入数据集

data <- read.csv("path/to/your/data.csv")

# 处理缺失值

# 方法一:删除含有缺失值的行

data <- na.omit(data)

# 方法二:用中位数填充数值型特征的缺失值

for (i in 1:ncol(data)) {

if (is.numeric(data[, i])) {

data[is.na(data[, i]), i] <- median(data[, i], na.rm = TRUE)

}

}

# 方法三:用众数填充类别型特征的缺失值

for (i in 1:ncol(data)) {

if (is.factor(data[, i])) {

mode_val <- names(sort(table(data[, i]), decreasing = TRUE))[1]

data[is.na(data[, i]), i] <- mode_val

}

}

# 将类别型特征转换为因子类型

data$factor_column <- as.factor(data$factor_column)

# 特征选择(可选)

# 例如:使用相关系数进行特征选择

cor_matrix <- cor(data[, -target_column])

selected_features <- names(sort(abs(cor_matrix[target_column, ]), decreasing = TRUE))

# 选取特征子集

data <- data[, c(selected_features, target_column)]

```

在此代码块中,我们首先导入了数据集,并使用`na.omit()`函数删除了含有缺失值的行。接着,我们分别对数值型特征和类别型特征的缺失值进行了处理。最后,我们通过计算特征与目标变量的相关系数来进行特征选择,并选取了与目标变量相关性最高的特征。

### 3.1.2 使用ctree()函数构建树模型

`ctree()`函数是`party`包中的核心函数,用于构建条件推断树。它的优势在于能够处理类别变量和连续变量,并自动选择最佳的分割点。在构建模型之前,需要确保数据集中的分类变量已经被正确地编码为因子类型。

```R

library(party)

# 使用ctree()函数构建决策树模型

model <- ctree(response ~ ., data = data)

# 输出决策树的详细信息

print(model)

# 可视化决策树

plot(model, main = "Decision Tree Visualization")

```

在上述代码中,我们首先加载

0

0