机器学习算法详解:从线性回归到深度学习,掌握机器学习核心技术

发布时间: 2024-08-25 09:08:56 阅读量: 24 订阅数: 35

# 1. 机器学习基础

机器学习是人工智能的一个子领域,它赋予计算机从数据中学习的能力,而无需明确编程。机器学习算法可以根据历史数据中的模式和关系,对新数据做出预测或决策。

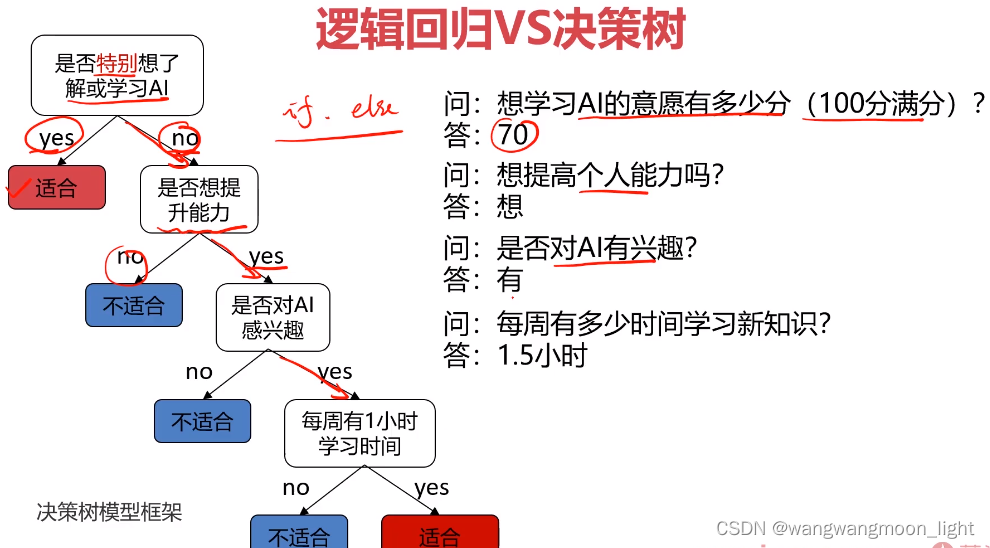

机器学习算法分为监督学习和非监督学习两大类。监督学习算法使用带有已知标签或输出的数据进行训练,而非监督学习算法则使用未标记的数据。监督学习算法的典型示例包括线性回归、逻辑回归和决策树,而非监督学习算法的示例包括聚类算法和降维算法。

# 2. 监督学习算法**

监督学习算法是机器学习中最基础和重要的算法类型之一,它主要用于解决分类和回归问题。在监督学习中,算法会从标记的数据中学习,并建立一个模型来预测新数据的输出。

**2.1 线性回归**

线性回归是一种用于预测连续变量的监督学习算法。它假设输入变量和输出变量之间存在线性关系,并通过最小化平方误差来找到最佳拟合线。

**2.1.1 线性回归模型**

线性回归模型可以表示为:

```

y = β0 + β1x1 + β2x2 + ... + βnxn + ε

```

其中:

* y 是输出变量

* x1, x2, ..., xn 是输入变量

* β0, β1, ..., βn 是模型参数

* ε 是误差项

**2.1.2 线性回归的求解方法**

线性回归模型的参数可以通过最小化平方误差来求解,即:

```

min Σ(y - ŷ)^2

```

其中:

* y 是真实输出

* ŷ 是预测输出

求解该优化问题的方法有很多,其中最常用的是最小二乘法。

**代码块:**

```python

import numpy as np

import pandas as pd

from sklearn.linear_model import LinearRegression

# 准备数据

data = pd.read_csv('data.csv')

X = data[['x1', 'x2']]

y = data['y']

# 训练模型

model = LinearRegression()

model.fit(X, y)

# 预测新数据

new_data = pd.DataFrame({'x1': [10], 'x2': [20]})

y_pred = model.predict(new_data)

# 输出预测结果

print(y_pred)

```

**逻辑分析:**

* 该代码块使用最小二乘法训练了一个线性回归模型,并使用新数据进行了预测。

* `LinearRegression()`函数用于创建线性回归模型。

* `fit()`方法用于训练模型,传入输入数据和输出数据。

* `predict()`方法用于使用训练好的模型对新数据进行预测。

**参数说明:**

* `data.csv`:包含训练数据的CSV文件。

* `x1`、`x2`:输入变量的列名。

* `y`:输出变量的列名。

* `model`:训练好的线性回归模型。

* `new_data`:包含新数据的DataFrame。

* `y_pred`:预测输出。

# 3. 非监督学习算法

非监督学习算法是一种机器学习算法,它从未标记的数据中学习模式和结构。与监督学习算法不同,非监督学习算法不需要预先定义的目标变量或输出。相反,它们根据数据的相似性或差异性将数据点分组或转换。

### 3.1 聚类算法

聚类算法是将数据点分组到称为簇的相似组中的非监督学习算法。每个簇中的数据点彼此相似,但与其他簇中的数据点不同。聚类算法广泛用于数据探索、客户细分和异常检测。

**3.1.1 K-Means聚类**

K-Means聚类是一种流行的聚类算法,它将数据点分配到K个簇中,其中K是一个预先定义的数字。该算法通过以下步骤工作:

1. **初始化:**随机选择K个数据点作为初始簇中心。

2. **分配:**将每个数据点分配到距离其最近的簇中心。

3. **更新:**计算每个簇的平均值,并将簇中心更新为这些平均值。

4. **重复:**重复步骤2和3,直到簇中心不再改变。

**代码块:**

```python

import numpy as np

from sklearn.cluster import KMeans

# 数据点

data = np.array([[1, 2], [3, 4], [5, 6], [7, 8], [9, 10]])

# 创建K-Means模型

kmeans = KMeans(n_clusters=2)

# 拟合模型

kmeans.fit(data)

# 获取簇标签

labels = kmeans.labels_

# 打印簇标签

print(labels)

```

**逻辑分析:**

* `n_clusters`参数指定要创建的簇数。

* `fit()`方法将模型拟合到数据。

* `labels_`属性包含每个数据点的簇标签。

**3.1.2 层次聚类**

层次聚类是一种聚类算法,它创建一棵称为树状图的层次结构,其中每个节点代表一个簇。该算法通过以下步骤工作:

1. **初始化:**将每个数据点视为一个单独的簇。

2. **合并:**找到距离最近的两个簇,并将其合并为一个新的簇。

3. **重复:**重复步骤2,直到所有数据点都被合并到一个簇中。

**代码块:**

```python

import numpy as np

from sklearn.cluster import AgglomerativeClustering

# 数据点

data = np.array([[1, 2], [3, 4], [5, 6], [7, 8], [9, 10]])

# 创建层次聚类模型

clustering = AgglomerativeClustering(n_clusters=2)

# 拟合模型

clustering.fit(data)

# 获取簇标签

labels = clustering.labels_

# 打印簇标签

print(labels)

```

**逻辑分析:**

* `n_clusters`参数指定要创建的簇数。

* `fit()`方法将模型拟合到数据。

* `labels_`属性包含每个数据点的簇标签。

### 3.2 降维算法

降维算法是将高维数据转换为低维表示的非监督学习算法。这可以简化数据可视化、提高算法效率并减少过拟合。

**3.2.1 主成分分析(PCA)**

PCA是一种降维算法,它通过找到数据中方差最大的方向来创建低维表示。该算法通过以下步骤工作:

1. **计算协方差矩阵:**计算数据点的协方差矩阵,该矩阵表示数据点之间的相关性。

2. **计算特征值和特征向量:**计算协方差矩阵的特征值和特征向量。

3. **选择主成分:**选择具有最大特征值的特征向量作为主成分。

**代码块:**

```python

import numpy as np

from sklearn.decomposition import PCA

# 数据点

data = np.array([[1, 2], [3, 4], [5, 6], [7, 8], [9, 10]])

# 创建PCA模型

pca = PCA(n_c

```

0

0