【linecache:文件读取专家】:掌握高效读取每一行的秘诀

发布时间: 2024-10-07 15:24:20 阅读量: 36 订阅数: 34

# 1. linecache模块概述

Python中的`linecache`模块是一个专门用于缓存和读取文件中特定行的工具模块。虽然它不如内置的`open()`函数那样经常被直接使用,但其独特的功能在处理大量文件数据时显得尤为重要。`linecache`模块尤其适合那些需要频繁读取文件中相同行数的场景,如日志文件分析等。通过缓存机制,它可以显著提高数据读取效率,减少对磁盘的重复访问。此外,其易于使用的接口,使得开发者能够在不深入底层文件系统的情况下,快速检索文件内容。在本文中,我们将详细介绍`linecache`模块的使用方法、应用场景以及它与其他模块的交互。通过对这些方面的探讨,我们将展示如何高效利用`linecache`模块,以便为各种复杂的文件处理任务提供支持。

# 2. linecache模块的基础使用方法

## 2.1 安装和导入linecache模块

### 2.1.1 Python环境下的linecache模块安装

在Python中使用linecache模块之前,首先需要确保已安装该模块。linecache模块在Python的标准库中,因此通常情况下,使用最新版本的Python安装后,无需额外安装即可直接导入使用。如果因为某些原因需要重新安装或者使用的是较旧版本的Python,可以通过以下命令进行安装。

假设用户环境为Linux或MacOS,可以使用pip进行安装:

```bash

pip install linecache

```

对于Windows用户,由于linecache模块已经是Python标准库的一部分,所以通常不需要执行任何安装操作。直接在Python脚本中导入即可:

```python

import linecache

```

### 2.1.2 linecache模块的导入和基本概念

linecache模块是Python标准库中用于提供快速且方便的文件行缓存机制的模块。它允许程序轻松地从文本文件中逐行读取内容,而不需要一次性加载整个文件到内存中。这对于处理大型文件特别有用,因为它可以大大减少内存使用,同时提高文件读取效率。

要使用linecache模块,只需在Python脚本的开始部分添加import语句:

```python

import linecache

```

导入后,可以通过调用`linecache.updatecache()`方法来加载或更新文件的行缓存。通常,在读取文件之前需要先更新文件的行缓存,以确保获取的行是最新内容。

## 2.2 linecache模块的文件读取功能

### 2.2.1 逐行读取的实现方式

使用linecache模块实现文件的逐行读取非常简单。首先,需要更新目标文件的行缓存,然后可以调用`linecache.getline()`方法来获取特定行的内容。

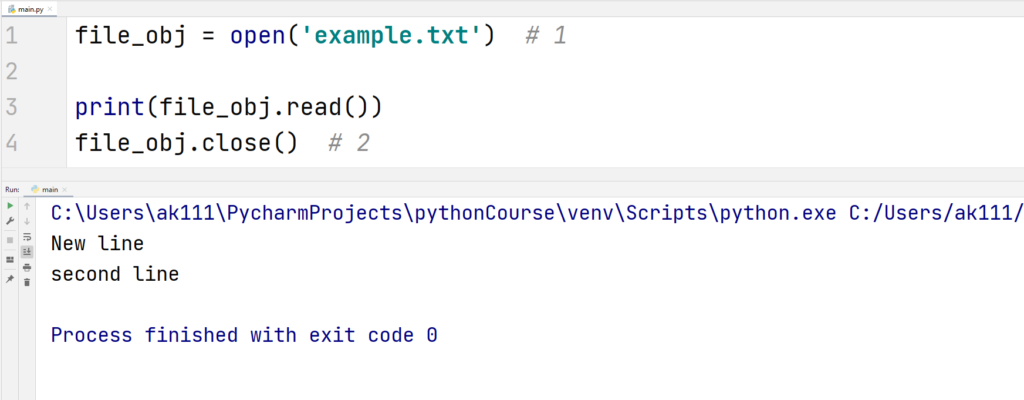

假设有一个名为example.txt的文件,我们可以按以下方式读取:

```python

import linecache

# 更新***e.txt文件的行缓存

linecache.updatecache('example.txt')

# 获取文件的第2行

line = linecache.getline('example.txt', 2)

print(line) # 输出第二行的内容

```

在上面的代码中,`updatecache()`方法负责将文件的每一行内容加载到内存中,以行号作为键的字典中。`getline()`方法接受文件名和行号作为参数,并返回指定行的内容。

### 2.2.2 大文件处理技巧与内存优化

使用linecache模块处理大文件时的一个重要技巧是通过减少内存的使用来优化性能。由于linecache是基于行缓存的,它可以减少对整个文件的内存占用,尤其是当只对文件的特定部分感兴趣时。

例如,如果只需要处理文件的前10行,可以这样做:

```python

import linecache

# 对于大文件,限制更新的行数,以节省内存

for i in range(1, 11):

linecache.updatecache('largefile.txt', i)

# 只读取文件的前10行

for i in range(1, 11):

line = linecache.getline('largefile.txt', i)

print(line, end='') # 输出10行内容,end=''避免每行后换行

```

### 2.2.3 异常处理和错误检测

在处理文件时,错误处理是不可或缺的。linecache模块可能会因为多种原因抛出异常,比如文件不存在,或者行号超出文件实际行数等。

为了避免运行时错误,应当在使用linecache时加上异常处理逻辑:

```python

import linecache

import traceback

try:

# 假设我们要访问的行号

line_number = 9999

# 更新行缓存

linecache.updatecache('example.txt', line_number)

# 获取特定行

line = linecache.getline('example.txt', line_number)

print(line)

except IOError as e:

print(f"读取文件时发生IO错误:{e}")

except IndexError as e:

print(f"请求的行号超出了文件范围:{e}")

except Exception as e:

traceback.print_exc()

print(f"发生未知错误:{e}")

```

在上面的代码中,通过捕获可能发生的异常类型(如`IOError`和`IndexError`),我们可以对不同的错误情况进行处理,并给出相应的错误提示。

## 2.3 linecache与文件缓存管理

### 2.3.1 文件缓存的作用和机制

linecache模块的一个核心功能是基于缓存机制,其作用是通过缓存行数据来提高文件读取效率。当调用`updatecache()`方法时,linecache会将文件内容按行读取,并存储在内存中的字典里,字典的键是行号。

这种缓存机制的主要好处是:

1. 减少磁盘I/O操作次数,因为文件不需要被反复打开和读取。

2. 提升文件读取的速度,尤其是在多次访问同一文件时。

缓存的字典结构意味着下一次调用`getline()`时,linecache会直接从内存中检索数据,而不是再次从磁盘读取。

### 2.3.2 清除和更新文件缓存的方法

随着程序的运行,文件内容可能会发生变化。为了确保linecache模块获取到的是最新的文件内容,需要定期调用`updatecache()`方法来更新文件的缓存。

要清除缓存,可以使用`linecache.clearcache()`方法:

```python

import linecache

# 清除example.txt的缓存

linecache.clearcache('example.txt')

# 重新更新***e.txt的缓存

linecache.updatecache('example.txt')

```

在上述代码中,`clearcache()`方法清除了指定文件的缓存。随后,`updatecache()`方法被调用以重新填充缓存。如果想要清除所有已缓存文件的缓存,可以直接调用`clearcache()`而不带任何参数。

### 2.3.3 缓存性能对读取速度的影响

缓存性能直接影响文件的读取速度。在理想情况下,文件内容不频繁改变,且同一文件被多次读取时,linecache的缓存能够显著提高读取效率。

但是,需要注意的是,如果系统内存有限,缓存大量文件内容可能会导致内存压力增大。此外,如果文件内容经常变动,频繁更新缓存也可能会对性能产生影响。因此,在使用linecache模块时,需要根据实际应用场景来平衡缓存的使用和性能的优化。

通过合理安排`updatecache()`调用的时机和频率,可以在保持较高性能的同时,最小化内存的消耗。

在下一章节中,我们将深入探讨linecache模块的高级应用,包括文件行数据的分析与统计、在日志文件处理中的应用,以及性能优化和高级技巧。

# 3. linecache模块深入应用

深入应用linecache模块能够帮助我们更好地管理和分析文件数据,尤其在处理日志文件或进行大规模数据统计时,其效率和便捷性尤其突出。本章节将详细介绍linecache模块在文件行数据的分析与统计、日志文件处理以及性能优化方面的高级应用。

## 文件行数据的分析与统计

在处理文本文件时,我们经常需要进行数据的分析和统计工作,比如统计某个特定模式出现的次数,或者进行文件行内容的模式匹配和过滤,以及多文件内容的比较和分析。

### 统计特定模式出现的次数

为了统计特定模式的出现次数,我们可以利用linecache模块读取文件的每一行,然后使用正则表达式进行匹配统计。

```python

import linecache

import re

def count_pattern_occurrences(filename, pattern):

count = 0

with open(filename, 'r') as ***

***

***

***

***

* 示例:统计某个Python文件中'regex'一词出现的次数

filename = 'example.py'

pattern = r'\bre\w+'

print(f"The word 'regex' appears {count_pattern_occurrences(filename, pattern)} times.")

```

**代码逻辑解析:**

1. 我们定义了一个函数`count_pattern_occurrences`,接受文件名和正则表达式模式作为参数。

2. 使用`open()`函数打开文件,并逐行读取。

3. `linecache.getline()`用来获取文件的每一行,不需要将整个文件内容加载到内存中。

4. `re.findall()`函数会检查每行中匹配正则表达式的子串,并返回所有匹配项的列表。

5. 统计匹配到的次数并返回。

### 文件行内容的模式匹配和过滤

有时候,我们需要对文件的行内容进行模式匹配和过滤,以提取符合特定条件的数据。

```python

import linecache

def filter_lines_by_pattern(filename, pattern):

filtered_lines = []

with open(filename, 'r') as ***

***

***

***

***

***

* 示例:过滤包含'regex'的行

filename = 'example.py'

pattern = r'import re'

filtered = filter_lines_by_pattern(filename, pattern)

for line in filtered:

print(line)

```

**代码逻辑解析:**

1. `filter_lines_by_pattern`函数用于读取文件并过滤出符合特定正则表达式模式的行。

2. 类似地,我们逐行读取文件,这次使用`re.search()`函数来检查行是否包含匹配模式的子串。

3. 如果匹配成功,该行会被添加到过滤结果列表`filtered_lines`中。

4. 函数最后返回一个包含所有符合条件行的列表。

### 多文件内容比较和分析

在处理多个文件时,可能需要比较它们的内容差异,linecache模块可以帮助我们高效地实现这一点。

```python

import linecache

def compare_files_contents(file1, file2):

with open(file1, 'r') as f1, open(file2, 'r') as f2:

lines_file1 = f1.readlines()

lines_file2 = f2.readlines()

# 使用字典存储每行内容和行号的映射

file1_content = {line_no: line.strip() for line_no, line in enumerate(lines_file1, 1)}

file2_content = {line_no: line.strip() for line_no, line in enumerate(lines_file2, 1)}

# 比较文件内容差异

differences = []

for line_no in set(file1_content.keys()).symmetric_difference(file2_content.keys()):

if line_no in file1_content:

differences.append(f"File1: {file1_content[line_no]}")

else:

differences.append(f"File2: {file2_content[line_no]}")

for line_no in file1_content.keys() & file2_content.keys():

if file1_content[line_no] != file2_content[line_no]:

differences.append(f"Line {line_no}: File1: {file1_content[line_no]}, File2: {file2_content[line_no]}")

return differences

# 示例:比较两个文件内容差异

file1 = 'example1.py'

file2 = 'example2.py'

differences = compare_files_contents(file1, file2)

print('\n'.join(differences))

```

**代码逻辑解析:**

1. `compare_files_contents`函数比较两个文件的内容差异。

2. 我们将每个文件的所有行读入内存,以便进行逐行比较。

3. 使用字典将每行的内容和行号关联起来,便于后续分析。

4. 比较两个文件行号的对称差集,找到仅存在于一个文件中的行,并将其添加到差异列表中。

5. 对于两个文件都存在的行号,比较行内容是否相同,不同则也添加到差异列表中。

6. 返回包含所有差异的列表。

## linecache在日志文件处理中的应用

日志文件处理是linecache模块的一个典型应用场景。它允许我们进行高效的日志文件逐行读取和解析,以及日志数据的分析和可视化。此外,日志文件的自动清理和维护也可以借助linecache模块来实现。

### 日志文件的逐行读取和解析

日志文件往往非常庞大,逐行读取可以有效管理内存消耗。linecache模块提供了一个非常方便的接口来实现这一点。

```python

import linecache

def read_log_file(filename):

entries = []

with open(filename, 'r') as ***

***

***

***

***

* 示例:读取日志文件的所有行

filename = 'application.log'

log_entries = read_log_file(filename)

for entry in log_entries:

print(entry)

```

**代码逻辑解析:**

1. `read_log_file`函数接受一个日志文件名作为参数,并读取文件中的所有行。

2. 使用`with open()`语句安全地打开文件,确保文件最后会被正确关闭。

3. 我们使用`linecache.getline()`函数逐行读取文件,而不必一次性加载整个文件到内存中。

4. 将每行的内容去除两端的空白字符后加入到`entries`列表中。

5. 函数最后返回这个包含所有日志行的列表。

### 日志数据分析和可视化

读取了日志文件后,接下来我们可以进行数据分析和可视化。这通常涉及到对日志数据的统计、趋势分析等。

```python

import json

from collections import Counter

def parse_log_data(log_entries):

data = []

for entry in log_entries:

log_dict = json.loads(entry) # 假设每行日志是一个JSON格式的字符串

data.append(log_dict)

return data

def analyze_log_data(data):

# 假设我们关注的是'level'字段

levels = [entry['level'] for entry in data]

level_counts = Counter(levels)

print("Log Level Counts:")

for level, count in level_counts.items():

print(f"{level}: {count}")

# 示例:分析和可视化日志文件

log_entries = read_log_file('application.log')

data = parse_log_data(log_entries)

analyze_log_data(data)

```

**代码逻辑解析:**

1. `parse_log_data`函数将日志条目解析为Python对象(例如字典)。

2. `analyze_log_data`函数使用`collections.Counter`类统计日志中不同级别的出现次数。

3. `Counter`对象`level_counts`会自动为我们提供各日志级别的计数。

4. 我们打印出每个级别的计数。

### 日志文件的自动清理与维护

随着时间的推移,日志文件可能会变得非常庞大。通过linecache模块,我们可以实现对日志文件的自动清理和维护。

```python

import os

import linecache

def rotate_log_file(filename, max_backup_files=5):

# 读取日志文件

log_entries = read_log_file(filename)

# 删除旧的日志文件

backups = [f"{filename}.{i}" for i in range(max_backup_files, 0, -1)]

for backup in backups:

if os.path.exists(backup):

os.remove(backup)

# 重命名当前日志文件为最新的备份

if os.path.exists(filename):

os.rename(filename, f"{filename}.1")

# 将日志条目写入新文件

with open(filename, 'w') as ***

***

*** '\n')

# 示例:日志文件维护

rotate_log_file('application.log', 5)

```

**代码逻辑解析:**

1. `rotate_log_file`函数提供了一个简单的方法来维护日志文件。

2. 它首先读取日志文件的所有条目。

3. 删除旧的日志备份文件,保持最多`max_backup_files`个备份。

4. 将当前的日志文件重命名为最新的备份文件。

5. 将读取的日志条目写入到新的日志文件中。

## 高级技巧和性能优化

在处理大量文件或进行性能敏感的应用时,采用适当的高级技巧和进行性能优化显得尤为重要。这可以确保程序的效率和响应能力。

### linecache与多线程或异步IO的结合

为了处理大规模文件数据,可以考虑使用多线程或多进程。Python中,我们可以使用`threading`或`multiprocessing`模块来实现这一目标。

```python

import linecache

from concurrent.futures import ThreadPoolExecutor

def process_file_line(filename, line_no):

line = linecache.getline(filename, line_no)

# 在这里添加对行的处理逻辑

return line.strip()

def process_files_concurrently(filenames):

results = []

with ThreadPoolExecutor() as executor:

future_to_line = {executor.submit(process_file_line, filename, line_no): (filename, line_no) for filename in filenames for line_no in range(1, linecache.getline(filename, -1).count('\n') + 2)}

for future in concurrent.futures.as_completed(future_to_line):

filename, line_no = future_to_line[future]

try:

data = future.result()

results.append((filename, line_no, data))

except Exception as exc:

print(f'Generated an exception: {exc}')

return results

# 示例:并行处理文件的每一行

filenames = ['file1.log', 'file2.log', 'file3.log']

concurrent_results = process_files_concurrently(filenames)

for result in concurrent_results:

print(result)

```

**代码逻辑解析:**

1. `process_file_line`函数用于处理文件的每一行。

2. `process_files_concurrently`函数使用`ThreadPoolExecutor`来创建一个线程池,并对多个文件同时执行行处理操作。

3. 每个线程会调用`process_file_line`函数处理文件的一行,并将结果存储在列表中返回。

### 性能测试和优化策略

性能测试是确定程序瓶颈和优化策略的关键步骤。我们可以使用Python标准库中的`timeit`模块来评估linecache模块的性能。

```python

import timeit

from linecache import getline

def performance_test():

# 测试linecache模块的性能

setup_code = """

import linecache

import os

# 假设我们有一个大文件

filename = 'large_file.log'

test_code = """

linecache.getline(filename, 100)

# 执行测试

times = timeit.repeat(setup=setup_code, stmt=test_code, repeat=3, number=10000)

print(f"Average time taken: {sum(times)/len(times)} seconds")

performance_test()

```

**代码逻辑解析:**

1. `performance_test`函数使用`timeit.repeat()`来运行测试代码多次,以获得更准确的性能数据。

2. `setup_code`包含了测试运行前需要执行的代码,例如导入模块和准备数据。

3. `test_code`是我们想要测试的代码段,这里是调用`getline()`函数。

4. `timeit.repeat()`函数将多次执行测试代码,并返回一个包含每次执行耗时的列表。

5. 最后,我们计算出平均耗时并打印出来。

### 大规模文件处理的案例分析

在实际应用中,我们可能会遇到处理非常大的文件,此时线程或进程的数量、内存管理和缓存策略都会对性能产生重大影响。

```python

import linecache

from concurrent.futures import ProcessPoolExecutor

def process_large_file(filename):

with open(filename, 'r') as ***

***

***

*** [filename]*len(lines), range(1, len(lines)+1)))

return results

# 示例:处理一个大型日志文件

large_file_name = 'large_log.log'

large_file_results = process_large_file(large_file_name)

for result in large_file_results:

print(result)

```

**代码逻辑解析:**

1. `process_large_file`函数用于处理一个大型文件,它读取文件的所有行到内存中。

2. 我们使用`ProcessPoolExecutor`来创建一个进程池,以便并发处理每一行数据。

3. `executor.map()`函数将`process_file_line`函数应用于文件的每一行,并返回一个包含处理结果的迭代器。

4. 将迭代器转换为列表,并返回所有结果。

在本节中,我们已经讨论了linecache模块在文件行数据分析与统计、日志文件处理以及高级技巧和性能优化方面应用。每个环节都展示了如何利用linecache模块解决实际问题,并且还引入了并发处理来提升性能。通过这些深入应用,我们可以感受到linecache模块在文件操作方面的强大能力。接下来,我们将探讨linecache模块与其他模块的交互,进一步扩展其功能。

# 4. linecache与其他模块的交互

### 4.1 linecache与os.path模块的交互

在处理文件时,经常需要与文件系统进行交互,了解文件的状态和路径。`linecache`模块与`os.path`模块的结合使用可以提高开发效率。

#### 4.1.1 路径解析和文件状态检查

使用`os.path`模块中的函数可以对文件路径进行解析,并且检查文件是否存在,以及是否可读写。例如,使用`os.path.exists(path)`可以检查文件是否存在,使用`os.path.isfile(path)`可以检查给定路径是否为文件。

下面的代码展示了如何利用`os.path`模块检查文件状态,并结合`linecache`模块进行读取:

```python

import os

import linecache

def read_file_if_exists(path):

if os.path.exists(path) and os.path.isfile(path):

lines = linecache.getlines(path)

return lines

else:

print(f"Error: The file '{path}' does not exist or is not a regular file.")

return None

path = 'example.txt'

file_lines = read_file_if_exists(path)

if file_lines:

for line in file_lines:

print(line)

```

#### 4.1.2 文件存在性验证和异常处理

在上述代码中,通过`os.path.exists(path)`和`os.path.isfile(path)`联合验证文件的存在性。如果文件存在,使用`linecache.getlines(path)`方法读取文件的每一行。如果文件不存在或不是一个常规文件,代码会打印错误信息并返回`None`。

`linecache.getlines(path)`的使用依赖于`path`变量,该变量指明了需要读取文件的完整路径。在实际使用中,这允许开发者不必关心文件在文件系统中的具体位置,而专注于文件内容的操作。

### 4.2 linecache与re模块的结合使用

当需要在文件内容中进行复杂的文本匹配时,`re`模块可以提供强大的正则表达式匹配能力。

#### 4.2.1 正则表达式在文件内容搜索中的应用

`linecache`模块能够读取文件的每一行,而`re`模块可以用来在这些行中搜索符合特定模式的字符串。通过组合这两个模块,我们可以实现对文件中数据的深度分析。

下面的代码示例展示了如何结合`linecache`和`re`模块,搜索文件中符合特定正则表达式的行:

```python

import linecache

import re

def search_pattern_in_file(pattern, path):

lines = linecache.getlines(path)

pattern = ***pile(pattern)

for line_number, line in enumerate(lines, 1):

if pattern.search(line):

print(f"Found pattern in line {line_number}: {line}")

search_pattern = r'\d{4}-\d{2}-\d{2}'

path = 'example.log'

search_pattern_in_file(search_pattern, path)

```

#### 4.2.2 复杂文本分析的实战案例

在上述代码中,首先通过`***pile(pattern)`编译了一个正则表达式,该表达式可以用于匹配日期格式(例如`YYYY-MM-DD`)。然后,读取文件中的每一行,并使用`pattern.search(line)`搜索符合正则表达式的行。如果找到匹配项,则输出该行的行号和内容。

这种结合使用`linecache`和`re`模块的方法,使得开发者能够高效地处理和分析日志文件、配置文件等文本数据,尤其适用于数据提取和验证的场景。

### 4.3 linecache与第三方库的集成

有时,`linecache`模块的功能并不足以满足特定的开发需求,这时可以通过集成第三方库来扩展其功能。

#### 4.3.1 集成第三方库进行数据处理

第三方库如`pandas`用于数据分析,`numpy`用于科学计算,它们能够处理大量数据并且提供了丰富的数据操作接口。通过集成这些库,可以将`linecache`模块读取到的文本数据转换成更加结构化的形式,便于分析和处理。

下面的代码展示了如何结合`pandas`库,将`linecache`读取到的数据转换成DataFrame进行进一步分析:

```python

import linecache

import pandas as pd

def load_data_to_dataframe(path, delimiter='\t'):

lines = linecache.getlines(path)

data = [line.strip().split(delimiter) for line in lines]

df = pd.DataFrame(data)

return df

path = 'data.txt'

delimiter = ',' # Assume the file uses comma-separated values

df = load_data_to_dataframe(path, delimiter)

print(df.head()) # Print the first few rows of the dataframe

```

#### 4.3.2 扩展linecache功能的插件开发

第三方库不仅限于直接集成,还可以开发插件,为`linecache`提供额外的功能,比如处理特定格式的文件、提供更高效的读取方式或增强错误处理能力。

#### 4.3.3 社区贡献和模块更新

通过社区的贡献,`linecache`模块可以不断更新和改进。社区成员可以提交bug报告、功能请求或直接提供代码补丁。`linecache`模块的维护者可以基于社区反馈,对模块进行更新,使其更加强大和稳定。

通过上述章节的介绍,我们可以看到`linecache`模块不仅能够独立地提供文件行级别的数据读取功能,还可以与其他模块协同工作,以实现更复杂的数据处理任务。在后续的章节中,我们将深入探讨`linecache`模块的高级应用和性能优化策略。

# 5. linecache的未来展望与替代方案

随着技术的发展,Python社区不断涌现新的库和工具,linecache模块也不例外,面临着更新迭代和潜在的替代。本章节将对linecache模块的未来发展进行展望,并探讨可能出现的替代方案。

## 5.1 linecache模块的未来发展方向

linecache作为一个长期活跃于Python社区的模块,其未来的发展方向将受到新版本Python语言特性的影响,以及社区反馈的驱动。

### 5.1.1 新版本Python中的改进

随着Python版本的更新,linecache可能会吸收更多的现代编程语言特性,比如更强大的类型提示和更高效的内存管理机制。这将使得linecache在处理大型文件时更加高效,同时也更易于维护和扩展。

```python

# 示例代码:使用类型提示改进linecache的函数定义

from typing import List, Optional

from linecache import getline

def get_lines(filename: str) -> Optional[List[str]]:

try:

with open(filename, 'r') as ***

*** [getline(filename, line_num) for line_num in range(1, file.readlines() + 1)]

except IOError:

return None

```

### 5.1.2 社区反馈和功能增强

社区的反馈是推动linecache模块改进的重要力量。未来可能会加入更多针对特定需求的功能,例如对多级缓存的支持、针对特定编码文件的读取优化,以及更智能的文件变化检测机制。

```python

# 示例代码:实现一个简单的文件变化检测器

from time import time, sleep

from linecache import getline

def file_change_detector(file_path: str, interval: int = 5, expected_hash: str = None):

last_hash = None

while True:

current_hash = hash(getline(file_path, 1))

if current_hash != last_hash:

if expected_hash and current_hash != expected_hash:

print(f"File change detected, expected hash is {expected_hash}")

last_hash = current_hash

sleep(interval)

```

## 5.2 探索linecache的替代模块

尽管linecache在文件行缓存方面有其独特优势,但是随着其他库的发展,也有不少高效的替代方案可供选择。

### 5.2.1 其他高效文件读取模块的比较

一些新兴的模块,如`ijson`,提供了对大文件的高效逐行处理能力,并且支持以流的形式读取JSON文件,这在处理大型日志文件时尤其有用。

```python

# 示例代码:使用ijson模块逐行处理JSON文件

import ijson

def parse_large_json(file_path: str):

with open(file_path, 'rb') as ***

*** ''):

print(event, value)

# 在此处可以插入对每行数据的处理逻辑

```

### 5.2.2 在不同场景下选择合适的模块

不同的文件处理场景需要不同的工具。对于需要进行大量文本数据处理的应用,如日志分析,`pandas`可以作为一个高效的选择,它通过将数据读入内存中的DataFrame对象来进行操作,优化了数据处理过程。

```python

# 示例代码:使用pandas模块处理日志文件

import pandas as pd

def log_file_analysis(file_path: str):

# 读取日志文件到DataFrame

df = pd.read_csv(file_path, sep=' ', header=None, names=['time', 'event', 'data'])

# 进行数据统计和分析

print(df.describe())

```

### 5.2.3 未来技术趋势对linecache的影响

未来的技术趋势,比如异步编程、大数据处理和云计算,将对linecache模块带来挑战。为了适应这些趋势,linecache可能需要增加异步读取文件的功能,或者提供与云存储服务交互的能力。

```python

# 示例代码:实现一个简单的异步文件读取器

import asyncio

from linecache import getline

async def async_getline(filename: str, line_num: int):

with open(filename, 'r') as ***

*** 模拟异步IO操作

return getline(filename, line_num)

async def main():

line = await async_getline('example.txt', 1)

print(line)

asyncio.run(main())

```

通过上述内容,我们探讨了linecache模块的未来发展方向和可能的替代方案。随着技术的不断演进,我们有理由相信linecache及其替代者将不断演化,以适应更加复杂和多样化的文件处理需求。在第六章中,我们将继续深入探讨这些模块如何在实际应用中发挥更大的作用。

0

0