【学习率调整秘籍】:PyTorch图像识别模型性能大提升

发布时间: 2024-12-11 22:54:18 阅读量: 13 订阅数: 15

基于pytorch图像识别模型训练(源码+使用说明)

# 1. 学习率在图像识别中的重要性

## 1.1 学习率的基本概念

在深度学习模型训练过程中,学习率是一个调节模型权重更新速度的超参数。它是用来决定在反向传播过程中参数更新的步长大小。一个合适的学习率可以加速模型的收敛过程,提高训练效率,而不合适的学习率可能导致训练过程震荡或者收敛过慢。

## 1.2 学习率对模型性能的影响

学习率直接影响到模型参数的更新幅度,从而影响模型学习的速度和质量。一个较高的学习率可能导致模型无法收敛,而一个过低的学习率则可能使得训练过程过于缓慢,甚至陷入局部最优解。因此,合理地选择和调整学习率对于提高图像识别模型的性能至关重要。

## 1.3 学习率选择的挑战与对策

选择一个合适的学习率是一个具有挑战性的任务,因为不同的模型、数据集和任务可能需要不同的学习率值。通常,可以通过实验和一些启发式方法(如学习率范围测试)来确定一个好的学习率。在实践中,还可以采用动态学习率调整策略,如学习率衰减或周期性调整,以获得更好的训练效果。

# 2. PyTorch学习率调整策略的理论基础

## 2.1 学习率的概念与作用

### 2.1.1 介绍学习率在模型训练中的角色

学习率是深度学习中一个至关重要的超参数,它控制着参数在每次迭代中更新的步长。在模型训练过程中,学习率直接影响到模型优化的方向和速度,因而对最终的性能有着举足轻重的影响。

在优化过程中,学习率决定了参数更新的幅度。如果学习率设置过大,可能会导致模型在最优解附近震荡,甚至发散;而如果学习率设置过小,虽然可以保证收敛,但会导致训练速度缓慢,甚至陷入局部最优。因此,合理的选择学习率,是模型训练过程中的关键步骤。

### 2.1.2 学习率对模型性能的影响分析

学习率对模型训练过程中的收敛速度和最终性能有着直接的影响。一个合适的学习率能够使模型快速收敛到全局最优解,而一个不当的学习率设置则可能导致模型的性能下降。

- **收敛速度**:较高的学习率可能使模型快速接近最优解,但同时存在过冲的风险,导致训练过程不稳定。相反,较低的学习率会使得模型的训练过程稳定,但收敛速度可能较慢。

- **局部最优与全局最优**:学习率太大可能使模型无法收敛,或陷入局部最优。而小学习率有助于精细搜索,增加找到全局最优解的可能性。

- **超参数调优**:优化学习率的过程本身就是一种超参数调优的过程。选择合适的学习率是实现模型调优的重要手段。

## 2.2 学习率调整方法概述

### 2.2.1 常见的学习率调整策略

在PyTorch中,学习率调整策略多种多样,它们各有优势和适用场景。常见的学习率调整策略包括:

- **固定学习率**:在整个训练过程中保持学习率不变。这是一种简单直接的方法,适用于快速原型设计和测试。

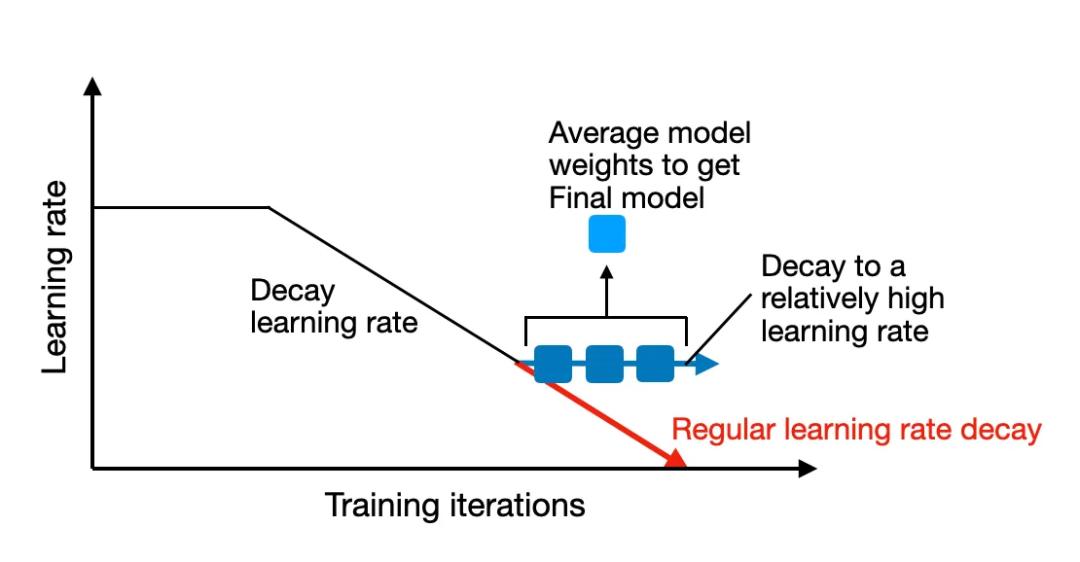

- **学习率衰减**:随着训练的进行逐渐减小学习率。此策略使得模型在开始时能够快速探索参数空间,在后期则进行精细调整。

- **学习率预热**:在训练初期逐渐增加学习率,以避免模型陷入局部最优或加速收敛。

- **周期性学习率调整**:周期性地调整学习率,这通常与学习率衰减策略结合使用,用于在训练过程中引入学习率的周期性波动。

### 2.2.2 不同策略的理论比较与选择

选择学习率调整策略时,需要根据问题的复杂性、数据集的特点以及模型的规模来进行权衡。

- **固定学习率**适用于数据简单、模型易优化的场景,对于需要快速验证想法的情况尤为方便。

- **学习率衰减**则更适用于大多数实际的深度学习任务,因为它可以在训练过程中提供更好的性能,尤其是在训练时间较长的情况下。

- **学习率预热**适用于难以训练的模型,或者当模型在初期容易陷入局部最优时。

- **周期性学习率调整**策略通过引入周期性学习率的波动,可以防止模型过早地陷入局部最小值,适用于复杂的优化问题。

## 2.3 PyTorch中的学习率调度器

### 2.3.1 学习率调度器的分类与应用场景

PyTorch提供了多种学习率调度器,这些调度器可以在训练过程中自动调整学习率。常用的学习率调度器包括:

- **StepLR**:在指定的步数后将学习率按固定比例进行衰减。

- **MultiStepLR**:在预设的几个特定的步数后进行学习率的衰减。

- **ExponentialLR**:以指数形式衰减学习率。

- **CosineAnnealingLR**:以余弦退火的方式调整学习率,常用于训练周期较长的情况。

- **ReduceLROnPlateau**:当验证集上的性能不再提高时,自动减少学习率。

### 2.3.2 如何在PyTorch中使用学习率调度器

在PyTorch中,使用学习率调度器需要首先定义一个优化器,然后根据需要选择一个调度器并传入优化器作为参数。以下是一个简单的例子:

```python

import torch.optim as optim

from torch.optim.lr_scheduler import StepLR

# 假设已经定义了模型参数 optimizer

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)

# 实例化学习率调度器

scheduler = StepLR(optimizer, step_size=30, gamma=0.1)

# 在训练循环中使用调度器

for epoch in range(num_epochs):

train(...) # 训练模型

scheduler.step() # 更新学习率

```

通过上述代码,我们定义了一个每30个epoch将学习率衰减为原来的0.1的学习率调度器。通过调用`step()`方法来在每个epoch结束时更新学习率。

此外,对于`ReduceLROnPlateau`调度器,其使用更为特殊一些,因为它需要根据模型在验证集上的表现来调整学习率。

```python

scheduler = optim.lr_scheduler.ReduceLROnPlateau(optimizer, 'min', patience=10, factor=0.1)

for epoch in range(num_epochs):

train(...) # 训练模型

val_loss = evaluate(...) # 验证模型性能

scheduler.step(val_loss) # 根据验证集损失调整学习率

```

在这个例子中,如果模型在验证集上的损失在10个epoch内没有改善,则学习率会按照0.1的因子降低。`ReduceLROnPlateau`调度器能够根据实际训练情况动态调整学习率,是一种更加智能化的调整方式。

# 3. PyTorch中学习率调整的实践技巧

在掌握了学习率的基础知识和理论之后,接下来将深入实践,探索在PyTorch框架中如何操作学习率调整。PyTorch提供了多种学习率调整方法,可以手动或根据一定的策略动态调整学习率。在本章节中,将介绍一些实用的学习率调整技巧,包括基本的学习率调整实践和一些高级技巧,以及如何将这些技巧与优化算法结合起来,以改善模型训练的效率和性能。

## 3.1 基本学习率调整实践

### 3.1.1 手动设置学习率

手动设置学习率是最基础也是最直接的学习率调整方式。在PyTorch中,可以通过优化器的`param_groups`参数来设置不同的学习率值。下面是一个简单的代码示例,展示了如何为不同的模型参数组设置特定的学习率。

```python

import torch

import torch.optim as optim

from torchvision.models import resnet18

# 构建模型并设置为训练模式

model = resnet18(pre

```

0

0