编码转换之术:django.utils.encoding模块的精妙运用

发布时间: 2024-10-11 03:08:32 阅读量: 14 订阅数: 22

# 1. django.utils.encoding模块概述

## 1.1 django.utils.encoding模块的用途

django.utils.encoding模块是Django框架中负责处理字符编码问题的关键组件。它提供的工具能够帮助开发者以正确的方式处理Python 2与Python 3之间的编码差异,确保字符串和字节序列在Django应用中的正确转换与表示。这个模块主要解决了在Web开发过程中,尤其是在国际化和本地化应用时经常遇到的编码问题。

## 1.2 模块中主要功能的简介

该模块中的主要功能包括但不限于:

- 强制转换字符串和字节序列的函数,如`force_text`和`force_bytes`。

- 智能编码转换的函数`smart_text`,它能够根据不同的上下文自动处理编码。

- 编码错误处理机制,如`smart_str`函数,它在遇到编码错误时提供有用的调试信息。

通过使用这些工具,开发者可以更专注于应用的业务逻辑,而不是花费大量时间解决因编码不一致而引发的问题。

# 2. 理解字符编码与解码的原理

### 2.1 字符编码基础

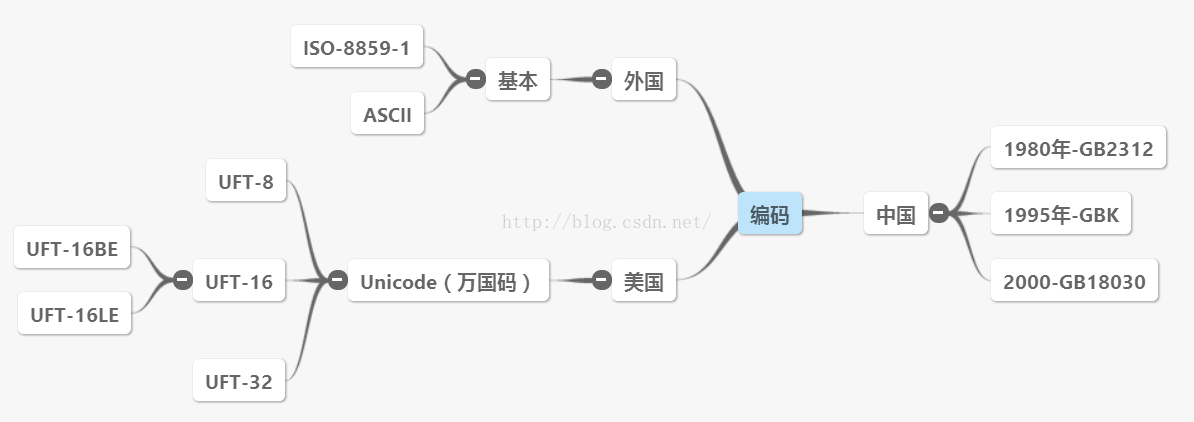

#### 2.1.1 字符编码的历史和发展

字符编码的发展是计算机历史上的一个重要篇章,它是随着计算机技术的发展而逐步形成的。早期的计算机使用的是二进制代码来表示信息,但是人机交互需要人类语言的字符。因此,字符编码应运而生,用来将字符转换为计算机能够理解的二进制形式。

最初的字符编码非常简单,比如ASCII码,它使用了7位二进制数,可以表示128个不同的字符。随着计算机技术的国际交流,ASCII码已经不能满足需求,因此产生了扩展的编码标准,例如ISO-8859-1,它允许使用8位二进制数,可以表示256个字符。

随着网络时代的到来,Unicode编码被提出,旨在为世界上所有的字符提供一个统一的编码标准。Unicode是一个巨大的字符集,支持几乎所有语言的字符,并且使用了更多的二进制位来表示。例如,UTF-8是Unicode的一个编码方式,它通过1到4个字节的变长形式来表示字符,有效地结合了ASCII的兼容性和Unicode的广泛性。

#### 2.1.2 常见字符编码标准

在处理文本数据时,了解常见的字符编码标准是非常重要的。它们包括但不限于:

- ASCII(American Standard Code for Information Interchange):美国信息交换标准代码,使用7位编码表示128个字符。

- ISO-8859-1:西欧语言字符集,可以表示256个字符,是ASCII的扩展。

- UTF-8(8-bit Unicode Transformation Format):可变长度的字符编码,可以根据字符的不同而使用不同的字节数,是Unicode的实现方式之一。

- GB2312/GBK/GB18030:中国国家标准的编码系列,用于中文字符的编码。

- Shift_JIS:日本国家标准的编码方式,用于日文字符的编码。

不同的编码标准适用于不同语言和应用场景,选择合适的编码对于确保信息准确传达至关重要。

### 2.2 字节与字符串的转换机制

#### 2.2.1 字符串与字节序列的关系

在编程中,字符串通常是抽象的,它们代表一系列字符,而字节序列是字符串的具体表示形式,即二进制数据。字符串到字节序列的转换,以及反向过程,是数据交换和存储的基础。

例如,在Python中,字符串默认是以Unicode形式存储的。当需要将字符串存储到文件或通过网络传输时,必须将其转换为字节序列,这通常通过编码过程来完成。相反,接收字节序列数据时,需要对其进行解码,以恢复成原始的字符串形式。

#### 2.2.2 Python中的字符编码转换方法

Python提供了非常丰富的内建函数来进行字符编码的转换。`str.encode()` 方法用于将字符串转换为字节序列,而 `bytes.decode()` 方法则用于将字节序列解码为字符串。在Python 3中,所有的字符串默认都是Unicode字符串,而字节序列则是 `bytes` 类型。

例如,将Unicode字符串转换为UTF-8编码的字节序列:

```python

unicode_str = '你好,世界'

utf8_bytes = unicode_str.encode('utf-8')

print(utf8_bytes) # b'\xe4\xbd\xa0\xe5\xa5\xbd\xef\xbc\x8c\xe4\xb8\x96\xe7\x95\x8c'

```

反过来,将UTF-8编码的字节序列解码回Unicode字符串:

```python

utf8_str = utf8_bytes.decode('utf-8')

print(utf8_str) # 你好,世界

```

### 2.3 编码问题的常见误区

#### 2.3.1 不同编码之间的数据丢失

当不同的字符编码标准之间的数据相互转换时,如果不正确处理,很容易导致数据丢失。例如,如果尝试用ASCII编码来表示一些超出ASCII字符集范围的Unicode字符,那么这些字符就会丢失信息,转换后的结果可能不是预期的。

为了避免这种情况,通常需要采取一些措施:

- 明确指定使用Unicode作为中间格式进行编码转换。

- 确保在转换过程中不会丢失信息,比如在从Unicode转换到其他编码时,需要确保目标编码能够表示所有的源字符。

- 在可能出现字符编码转换的场景中进行错误检测和处理。

下面是一个示例代码,演示了在Python中如何使用错误处理参数来避免编码转换时的错误:

```python

# 假设我们有一个UTF-8编码的字符串,但是我们使用ASCII编码来解码它

utf8_encoded = b'\xe4\xbd\xa0\xe5\xa5\xbd'

try:

ascii_decoded = utf8_encoded.decode('ascii')

except UnicodeDecodeError as e:

print("解码错误:", e) # 输出错误信息,避免程序崩溃

# 处理错误,例如回退到默认编码或者记录日志

```

#### 2.3.2 自动编码检测的局限性

自动编码检测是指尝试自动推断出数据的编码格式,这是一个在处理多种语言数据时非常有用的功能。然而,自动编码检测通常不是百分之百可靠的,因为它依赖于一些启发式算法和统计方法。

当自动编码检测失败时,可能会发生编码错误。例如,某些编码检测工具可能将西欧语言的文本错误地判断为非西方语言的编码,从而导致解码失败。

解决这个问题通常需要人为地介入,例如:

- 对数据的来源进行调查,以确认正确的编码。

- 设置明确的编码规则,对所有输入数据执行预设的编码转换。

- 在应用中实现编码检测失败时的回退机制。

总结这些编码问题的常见误区,重要的是在使用和处理字符编码时要保持警惕和细心,确保编码的正确性和数据的完整性。

# 3. django.utils.encoding模块实战

## 3.1 基本编码工具的使用

### 3.1.1 force_text和force_bytes的对比

在处理Web请求时,Django框架经常需要在Python的字符串和字节序列之间进行转换。`django.utils.encoding`模块中的`force_text`和`force_bytes`函数在这一转换过程中扮演着重要角色。理解这两个函数如何工作,以及它们之间的对比,对于开发一个能够正确处理字符编码的Web应用至关重要。

`force_text`函数通常用于将任意对象转换成一个字符串(Unicode)。当你需要确保得到的是一个Unicode对象时,可以使用`force_text`。例如,Django内部会调用这个函数来获取一个对象的文本表示,比如在处理模板变量的时候。

另一方面,`force_bytes`函数则是用来确保对象是一个字节序列,一般是在需要将字符串转换为字节序列的时候使用。当你处理的是存储在数据库中的原始字节数据,或者是在进行HTTP响应时需要字节序列时,就需要使用这个函数。

这两个函数的区别主要在于处理Unicode编码的字符串时的表现。`force_text`将始终返回一个`unicode`类型的字符串,而`force_bytes`则会根据Django

0

0