深度学习框架Python比较:TensorFlow vs PyTorch(选型秘籍)

发布时间: 2024-12-19 20:20:01 阅读量: 3 订阅数: 5

# 摘要

本文全面介绍了深度学习框架的核心原理与实践,并对比了TensorFlow与PyTorch两大主流框架的性能、易用性及应用案例。通过详尽的案例分析,本研究阐述了TensorFlow的静态数据流图与PyTorch的动态计算图的不同特点,并探讨了如何根据项目需求、技术栈和团队经验进行框架选型。文章进一步分析了深度学习技术的发展趋势,包括自动化机器学习和边缘计算的兴起,以及新框架的市场影响和开源社区的创新贡献。最终,本文为开发者提供了学习路径和未来职业规划的建议,帮助他们在不断演进的技术环境中做出明智的选择。

# 关键字

深度学习;TensorFlow;PyTorch;框架选型;技术趋势;自动化机器学习;边缘计算

参考资源链接:[Python for Data Analysis英文版无水印PDF下载指南](https://wenku.csdn.net/doc/6412b692be7fbd1778d47344?spm=1055.2635.3001.10343)

# 1. 深度学习框架概述

在本章中,我们将介绍深度学习框架的基本概念及其重要性,为读者提供一个关于这些框架在现代AI应用中的角色和价值的全面视角。深度学习框架不仅是算法开发的基础工具,它们还极大地加速了研究和产品开发的进程。

## 1.1 什么是深度学习框架?

深度学习框架是建立在通用编程语言之上的高级接口,旨在简化深度学习模型的设计、训练和部署。它们通过提供抽象层来减少底层细节的复杂性,使研究者和开发者可以更专注于模型结构和创新。

## 1.2 深度学习框架的演变

从早期的Theano,到如今流行的TensorFlow和PyTorch,深度学习框架已经历了快速的发展。这些框架不断演进,以适应日益增长的计算需求和算法复杂性,同时也在易用性和性能之间寻求最佳平衡。

## 1.3 框架选择的重要性

选择合适的深度学习框架对于项目的成功至关重要。开发者需要考虑框架的性能、社区支持、文档质量以及个人或团队的技术栈偏好。此外,框架的未来发展和生态系统的丰富性也是重要的考虑因素。

通过本章,我们将为读者打下坚实的基础,以在后续章节深入了解TensorFlow和PyTorch等具体框架的核心原理与实践。

# 2. TensorFlow核心原理与实践

## 2.1 TensorFlow的基本组件和结构

### 2.1.1 TensorFlow的数据流图概念

TensorFlow是基于数据流图(data flow graphs)来实现数值计算的开源框架。数据流图由节点(node)和边(edge)组成,其中节点代表运算单元,而边则代表节点之间的数据流。这种设计允许构建复杂算法的同时,还能高效利用多核和分布式计算资源。

在TensorFlow中,数据流图描述了计算的逻辑流程,而实际的计算只有在执行 sess.run() 操作时才会发生。这种延迟执行的特性有助于系统优化计算性能,并能有效地进行自动微分计算。

### 2.1.2 张量操作和计算图构建

在TensorFlow中,张量(tensors)是多维数组,其形状(shape)和数据类型(type)在创建时确定。张量操作是构建计算图的基础,TensorFlow提供了丰富的API来进行这些操作。

下面是一个构建基础计算图的代码示例:

```python

import tensorflow as tf

# 创建常量张量

a = tf.constant([1, 2, 3], name='a')

b = tf.constant([4, 5, 6], name='b')

# 张量相加操作

result = tf.add(a, b, name='add')

# 创建一个计算图会话

with tf.Session() as sess:

print(sess.run(result))

```

在这个例子中,`tf.constant` 创建了两个常量张量,`tf.add` 创建了一个表示加法操作的节点,最终通过 `sess.run()` 执行了计算图,并打印了结果。

## 2.2 TensorFlow的高级特性

### 2.2.1 高级API Keras的应用

Keras是一个高级的神经网络API,最初设计为独立的接口,后被整合进TensorFlow成为其高层API。Keras为模型的快速实验提供了便捷的接口,尤其适合深度学习新手和研究人员。

在Keras中,模型可以简单地通过顺序模型(Sequential)或函数式API(Functional API)来构建。下面是使用顺序模型构建一个简单的多层感知器(MLP)的代码:

```python

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

model = Sequential([

Dense(64, activation='relu', input_shape=(784,)),

Dense(64, activation='relu'),

Dense(10, activation='softmax')

])

model.compile(

optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy']

)

```

该模型使用了两个64节点的隐藏层,并通过softmax激活函数输出10个类别的概率。Keras通过简洁的代码抽象了底层的TensorFlow操作,使得实验更加高效。

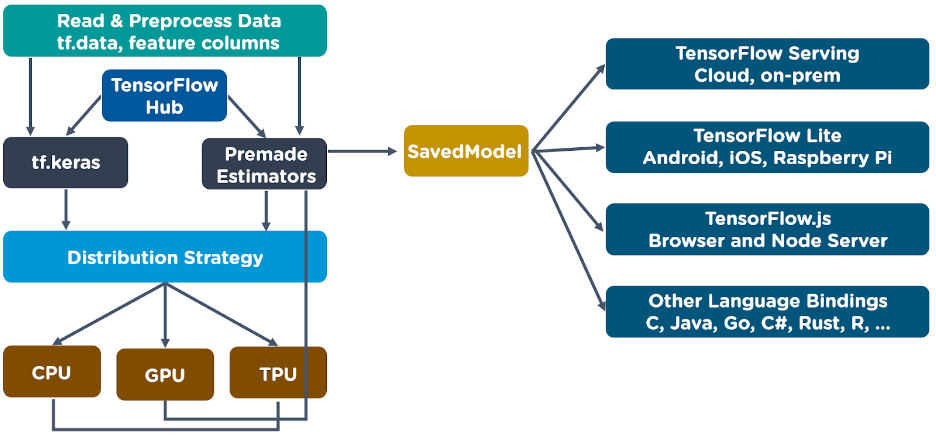

### 2.2.2 分布式训练和部署

TensorFlow支持在多GPU和分布式设置下进行训练。其分布式机制允许将计算任务分散到多个设备和多个服务器上。

在分布式训练中,通常会使用 `tf.distribute.Strategy` API来指定策略,如MirroredStrategy,它将模型在多个GPU之间进行同步训练。下面是分布式训练的一个简单配置示例:

```python

# 定义策略

strategy = tf.distribute.MirroredStrategy()

# 定义一个使用策略的作用域

with strategy.scope():

# 构建模型等操作...

# 进行训练等操作...

```

通过这样的策略配置,开发者可以享受到模型训练时的自动并行计算和自动梯度更新等优势。

### 2.2.3 模型保存与加载

在进行机器学习项目时,经常需要保存和加载模型进行进一步的实验或部署。TensorFlow提供了 `tf.train.Checkpoint` 和 `tf.keras.models.save_model` 等API来进行模型保存。

```python

# 保存模型

model.save('path/to/your/model')

# 加载模型

new_model = tf.keras.models.load_model('path/to/your/model')

```

保存模型时,`model.save` 会保存模型的结构、权重、训练配置以及优化器的状态,确保模型能够被完全复原。

## 2.3 TensorFlow实践案例分析

### 2.3.1 图像识别项目实战

图像识别是深度学习中的一个经典应用。本小节将展示如何使用TensorFlow来构建一个简单的图像分类器。我们将使用Keras API来实现这一目标,因为其简单易用。

首先,需要准备数据集,并进行必要的预处理:

```python

from tensorflow.keras.datasets import cifar10

from tensorflow.keras.utils import to_categorical

# 加载数据集

(x_train, y_train), (x_test, y_test) = cifar10.load_data()

# 数据归一化

x_train, x_test = x_train / 255.0, x_test / 255.0

# 将类别标签进行one-hot编码

y_train, y_test = to_categorical(y_train), to_categorical(y_test)

```

接下来,使用Keras构建模型并进行编译:

```python

from tensorflow.keras import layers, models

# 创建模型

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.Flatten())

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(10, activation='softmax'))

# 编译模型

model.compile(optimizer='adam',

loss='categorical_

```

0

0