【Python机器学习面试揭秘】:深度学习框架TensorFlow和PyTorch,让你更上一层楼

发布时间: 2024-11-16 17:52:05 阅读量: 64 订阅数: 27

知识领域: 机器学习 技术关键词: TensorFlow、PyTorch、机器学习算法

# 1. 机器学习与深度学习框架概述

## 1.1 机器学习与深度学习的基础概念

机器学习(ML)与深度学习(DL)是人工智能领域的核心技术,它们通过算法让计算机可以从大量数据中学习规律,并作出预测或决策。机器学习关注特征工程和算法训练,而深度学习强调通过深度神经网络自动提取数据特征。随着计算能力和大数据的爆发,深度学习得以迅猛发展,成为推动AI进步的关键力量。

## 1.2 深度学习框架的兴起与发展

深度学习框架是构建和训练神经网络的基础,它们封装了复杂的数学运算,简化了模型开发过程。从最初的Theano,到目前流行的TensorFlow、PyTorch等,这些框架在保证性能的同时提供了更高效的抽象级别,大幅降低了深度学习应用的门槛。选择合适的框架,对于项目的成功至关重要。

## 1.3 深度学习框架的重要性和应用场景

深度学习框架的重要性体现在它们为开发者提供了易于使用的API、自动化的梯度计算、模型部署和优化工具等方面。不同的框架有着不同的设计哲学和适用场景,例如,TensorFlow适合生产环境的模型部署,而PyTorch则因其动态计算图和易用性在学术研究领域受到青睐。正确选择框架,可以大大提高开发效率,缩短项目周期。

# 2. TensorFlow深度解析

TensorFlow是Google开发的一个开源的机器学习框架,广泛应用于图像识别、自然语言处理、语音识别等各个领域。作为深度学习领域的重量级工具,其有着强大的社区支持和丰富的资源。本章节将深入解析TensorFlow,从基础理论到高级应用,再到实践案例分析,带你一步步深入TensorFlow的世界。

## 2.1 TensorFlow基础理论与组件

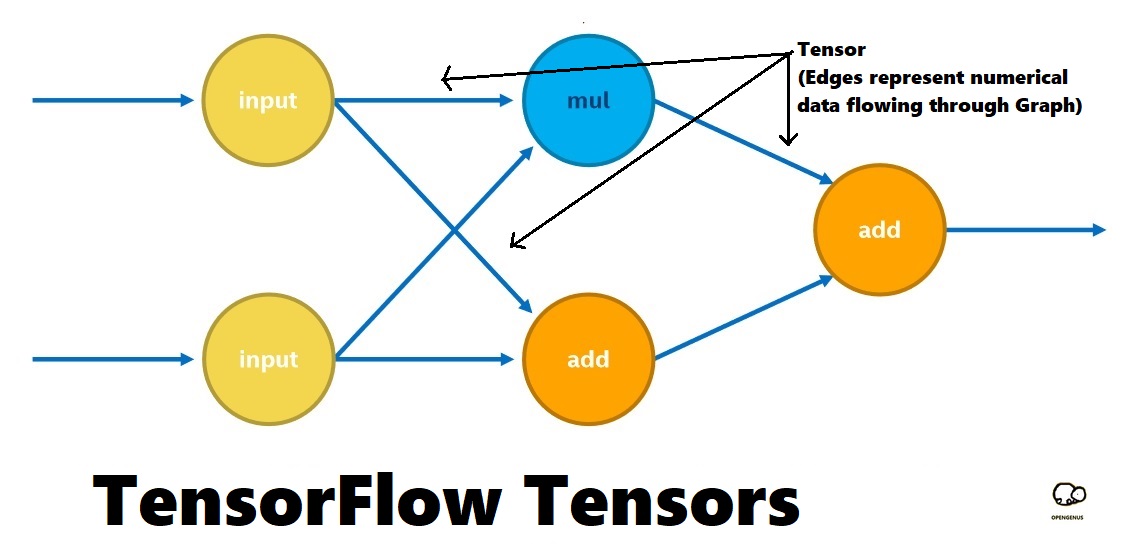

### 2.1.1 TensorFlow的计算图和会话

在TensorFlow中,计算图是一系列相互联系的操作节点。每个节点代表一个数学操作,而节点之间的边代表多维数组(张量)流动的数据。这样的架构使得TensorFlow可以在图形处理单元(GPU)和分布式计算上高效地执行复杂计算。

#### 计算图的构建与执行

```python

import tensorflow as tf

# 构建计算图

a = tf.constant(2)

b = tf.constant(3)

c = tf.add(a, b)

# 创建一个会话

with tf.Session() as sess:

# 运行计算图中的节点

result = sess.run(c)

print(result) # 输出: 5

```

在上述代码中,我们首先导入了TensorFlow库,然后构建了一个简单的计算图,其中包含两个常数节点`a`和`b`,以及一个加法操作节点`c`。通过创建一个会话(`tf.Session()`),我们可以执行计算图,并在会话中获取操作结果。

### 2.1.2 TensorFlow核心概念:张量、操作、变量

#### 张量(Tensor)

张量是TensorFlow中数据的基本单位,可以认为是多维数组。在TensorFlow中,张量不仅仅是一个数值,它还记录了创建它的操作和数据类型等信息。

#### 操作(Operation)

操作或ops是TensorFlow中定义计算的节点。所有张量都是通过执行操作生成的,这些操作可以是简单的加法或者复杂的神经网络层。

#### 变量(Variable)

变量用于存储可训练的参数,例如神经网络的权重和偏置。变量在模型训练过程中会更新,而在模型推理时则保持不变。

```python

# 定义一个变量

W = tf.Variable(tf.random_normal([784, 200]), name="weights")

# 定义一个操作,计算张量W的转置

W_T = tf.transpose(W)

```

在上述代码中,我们定义了一个变量`W`,它是一个随机初始化的784x200的矩阵。我们还定义了一个操作来计算`W`的转置。

## 2.2 TensorFlow高级应用

### 2.2.1 搭建简单的神经网络模型

构建神经网络是深度学习中的核心任务。下面的代码展示了如何使用TensorFlow构建一个简单的全连接层神经网络模型。

```python

# 定义输入数据和标签

x = tf.placeholder(tf.float32, shape=[None, 784])

y = tf.placeholder(tf.float32, shape=[None, 10])

# 定义权重和偏置

W = tf.Variable(tf.random_normal([784, 10]))

b = tf.Variable(tf.zeros([10]))

# 神经网络前向传播

logits = tf.matmul(x, W) + b

# 使用softmax激活函数

prediction = tf.nn.softmax(logits)

# 计算交叉熵损失函数

loss = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(logits=logits, labels=y))

# 优化器配置

optimizer = tf.train.GradientDescentOptimizer(learning_rate=0.5).minimize(loss)

# 初始化所有变量

init = tf.global_variables_initializer()

# 创建会话,并执行训练操作

with tf.Session() as sess:

sess.run(init)

# 假设有一个训练数据集迭代器...

for _ in range(num_epochs):

# 迭代训练...

```

在此段代码中,我们使用占位符`x`和`y`来表示输入和目标标签。我们定义了网络的权重`W`和偏置`b`,并通过矩阵乘法和加法构建了模型的前向传播。损失函数`loss`用于衡量模型预测和实际标签之间的差异,而优化器`optimizer`用于调整模型参数以最小化损失。

### 2.2.2 使用TensorFlow进行数据预处理和增强

在深度学习项目中,数据预处理和增强是非常重要的步骤。它们可以提升模型的泛化能力和性能。

#### 数据标准化

数据标准化是将输入数据的每个特征标准化为具有0均值和单位方差的过程。这有助于模型更快地收敛。

```python

# 假设data是一个二维numpy数组,包含我们的输入数据

data -= np.mean(data, axis=0) # 数据中心化

data /= np.std(data, axis=0) # 数据标准化

```

#### 数据增强

数据增强通过应用随机变化(如旋转、缩放、剪切等)来生成新的训练数据,从而增加模型的鲁棒性。

```python

# TensorFlow提供了tf.image的一些API进行图像数据增强

image = tf.placeholder(tf.float32, shape=[None, height, width, channels])

flipped_image = tf.image.flip_left_right(image) # 水平翻转图像

```

### 2.2.3 利用TensorBoard进行模型可视化和监控

TensorBoard是TensorFlow的可视化工具,可以展示模型结构、实时数据流和性能指标等。

#### 启动TensorBoard

首先,需要在TensorFlow代码中添加日志记录:

```python

# 在初始化变量时设置log_dir

summary_writer = tf.summary.FileWriter('./log', sess.graph)

```

然后,可以使用TensorBoard命令行工具查看:

```

tensorboard --logdir=./log

```

在TensorBoard中,我们可以看到如下的信息:

- 模型计算图的可视化

- 损失函数和准确率的实时变化曲线

- 各个层的权重和激活函数的分布图

通过这些丰富的可视化信息,开发者能够更好地调试和监控模型训练过程。

## 2.3 TensorFlow实践案例分析

### 2.3.1 图像识别项目应用TensorFlow

在图像识别领域,卷积神经网络(CNN)是目前最成功的架构之一。我们可以通过TensorFlow构建和训练一个CNN模型来识别手写数字(MNIST数据集)。

#### 构建CNN模型

```python

# 定义一个简单的CNN模型结构

conv1 = tf.layers.conv2d(inputs=x, filters=32, kernel_size=[5, 5], padding="SAME")

pool1 = tf.layers.max_pooling2d(inputs=conv1, pool_size=[2, 2], strides=2)

conv2 = tf.layers.conv2d(inputs=pool1, filters=64, kernel_size=[5, 5], padding="SAME")

pool2 = tf.layers.max_pooling2d(inputs=conv2, pool_size=[2, 2], strides=2)

```

在上述代码中,我们定义了一个包含两个卷积层和两个池化层的简单CNN结构。该模型结构可以提取输入图像中的特征,并通过池化层降低特征维数。

#### 训练和评估模型

```python

# 构建计算图...

# 初始化所有变量...

with tf.Session() as sess:

sess.run(init)

# 假设train_set是我们的训练数据集

for epoch in range(num_epochs):

for image, label in train_set:

sess.run(optimizer, feed_dict={x: image, y: label})

# 评估模型...

```

在模型训练完成后,我们通常会在验证集或测试

0

0