【Python网络爬虫专家】:反爬虫策略和大规模数据抓取技术,让你轻松应对

发布时间: 2024-11-16 18:17:40 阅读量: 67 订阅数: 28

Python网络爬虫技术 完整教案.docx

# 1. Python网络爬虫基础

网络爬虫是自动化收集网络数据的重要工具,在数据科学、搜索引擎、市场分析等多个领域发挥着重要作用。Python作为一种编程语言,因其简洁的语法和强大的第三方库支持,在网络爬虫开发中极为流行。本章我们将介绍Python网络爬虫的基础知识,从基本概念和工作流程讲起,为您打下坚实的基础。

## 1.1 爬虫基本概念

网络爬虫(Web Crawler),有时称为蜘蛛(Spider)或机器人(Robot),是一种自动化程序,用于浏览互联网并根据一定规则抓取网络信息。Python中的爬虫可以通过各种库实现,最著名的有requests用于网络请求,BeautifulSoup和lxml用于解析HTML和XML文档。

## 1.2 爬虫的工作流程

一个基本的爬虫流程通常包括以下步骤:

1. 发送HTTP请求,获取网页内容。

2. 解析网页文档,提取所需数据。

3. 存储提取的数据,例如保存到数据库或文件中。

以requests和BeautifulSoup为例,下面是简单爬取一个网页标题的Python代码示例:

```python

import requests

from bs4 import BeautifulSoup

# 发送HTTP请求

response = requests.get('***')

# 确保请求成功

if response.status_code == 200:

# 解析网页内容

soup = BeautifulSoup(response.text, 'html.parser')

# 提取网页标题

title = soup.find('title').get_text()

# 打印标题

print(title)

else:

print('网页请求失败')

```

运行上述代码将输出目标网站的标题信息。这只是爬虫的一个非常基础的例子,实际上,在面对更复杂网页和反爬虫机制时,爬虫程序需要更多的策略和技术。在后续章节中,我们将深入了解如何应对这些问题。

# 2. 应对反爬虫策略

### 2.1 识别和分析反爬机制

#### 2.1.1 常见的反爬技术类型

现代网站设计者为了保护数据不被非法爬取,通常会在网站架构中加入各种反爬虫策略。常见的反爬技术类型包括但不限于:

- **IP限制**:当爬虫频繁请求时,服务器会识别并限制来自同一IP的访问。

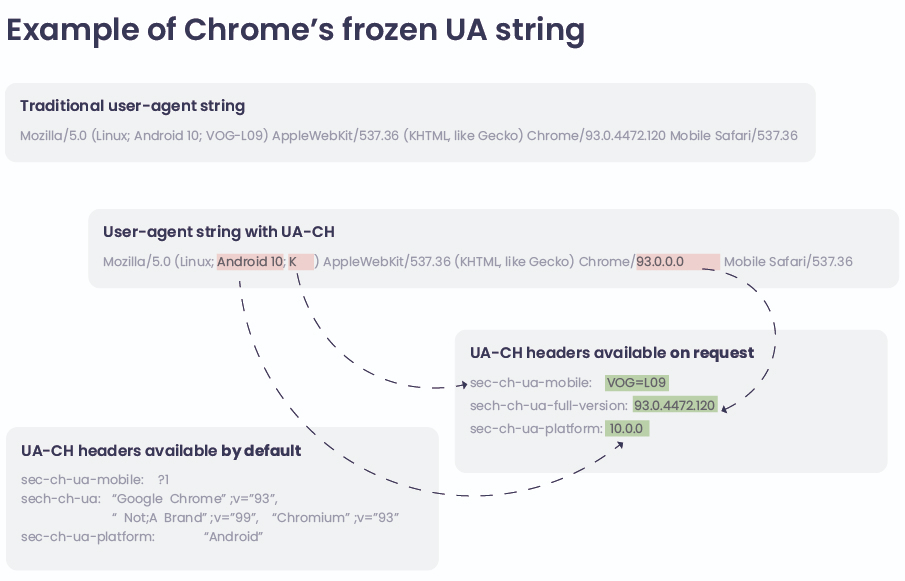

- **用户代理限制**:网站可能会检查访问者使用的用户代理字符串(User-Agent),从而过滤掉非浏览器的请求。

- **验证码**:在用户进行某些操作时,网站要求输入验证码来证明是真实用户在操作。

- **Cookie和Session限制**:网站可能会使用Cookies跟踪用户行为,或者在Session中存储状态信息。

- **动态令牌**:一些网站会在表单中加入动态生成的令牌值,用以验证表单提交的合法性。

#### 2.1.2 分析网站的反爬策略

分析一个网站是否使用了反爬机制,通常需要通过观察网页请求和响应的过程来进行。使用浏览器开发者工具查看网络请求、检查返回的状态码、错误信息、以及响应头部信息等,都可以帮助我们识别反爬策略。

1. **查看响应头**:服务器返回的响应头中,`X-Robots-Tag` 表示是否遵循爬虫协议,`Set-Cookie` 表明服务器是否使用Cookie跟踪用户状态。

2. **检查请求头**:请求头中的`User-Agent`、`Referer`、`Cookies`等字段常被网站用来判断请求是否来自真实浏览器。

3. **动态内容分析**:动态加载的内容通常意味着网站可能使用了JavaScript进行内容的动态渲染,这往往需要相应的执行环境来解析。

4. **异常处理**:响应状态码如`403 Forbidden`或`503 Service Unavailable`可能表明IP被封禁或服务器正忙。

```python

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (compatible; Googlebot/2.1; +***'

}

response = requests.get('***', headers=headers)

if response.status_code == 200:

print("网站访问正常")

else:

print("网站可能存在反爬机制")

```

这段简单的Python代码展示了如何通过改变`User-Agent`来模拟浏览器访问网站,并检查状态码来初步判断网站是否有反爬机制。

### 2.2 实现反反爬虫技术

#### 2.2.1 模拟浏览器行为

为了模拟真实用户的浏览行为,我们可以设置请求头来模仿浏览器,同时加入JavaScript引擎来处理动态内容加载。

```python

from selenium import webdriver

# 设置Chrome选项,模仿浏览器环境

options = webdriver.ChromeOptions()

options.add_argument('user-agent="Mozilla/5.0"') # 设置User-Agent

options.add_argument('disable-blink-features=AutomationControlled') # 防止一些网站检测到自动化行为

driver = webdriver.Chrome(options=options)

# 访问网站

driver.get('***')

# 执行JavaScript

driver.execute_script('window.scrollTo(0, document.body.scrollHeight);')

driver.implicitly_wait(10)

# 获取动态加载的内容

data = driver.page_source

```

#### 2.2.2 使用代理IP和动态IP池

为了避免IP被封禁,使用代理IP是常见的手段。动态IP池可以让我们在IP被封时自动切换到另一个IP继续工作。

```python

import random

import requests

proxies = {

'http': '***',

'https': '***'

}

random.shuffle(proxies) # 随机选择代理

response = requests.get('***', proxies=proxies)

if response.status_code == 200:

print("代理IP访问成功")

else:

print("代理IP访问失败")

```

#### 2.2.3 验证码识别和处理方法

验证码是阻止自动化工具访问的常用方式,处理验证码有多种方法,如OCR技术识别、第三方验证码识别服务等。

```python

# 假设我们有一个OCR库来识别验证码图片

from ocr_library import ocr_image

def recognize_captcha(image_url):

# 下载验证码图片

image_data = requests.get(image_url).content

# 使用OCR识别验证码

captcha_text = ocr_image(image_data)

return captcha_text

captcha_url = '***'

captcha_text = recognize_captcha(captcha_url)

```

### 2.3 高级伪装技巧

#### 2.3.1 用户代理字符串(Headers)的设置

设置合适且随机的用户代理字符串可以有效伪装爬虫,模拟不同设备和浏览器的访问行为。

```python

import uuid

# 生成随机的用户代理字符串

user_agent = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/{} Safari/537.36'.format(uuid.uuid4())

headers = {'User-Agent': user_agent}

```

#### 2.3.2 Cookie和Session的管理

在爬虫中管理Cookie和Session能够帮助我们维持登录状态,模拟正常用户操作。

```python

# 使用requests.Session来管理Cookie

session = requests.Session()

session.get('***')

session.post('***', data={'username': 'user', 'password': 'pass'})

```

#### 2.3.3 JavaScript执行环境的模拟

对于需要执行JavaScript的网站,可以使用Selenium来模拟浏览器环境。

```***

***mon.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

# 使用Selenium等待JavaScript加载完成

driver.get('***')

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, 'dynamic-content'))

)

```

这一章节内容详尽地展示了如何应对网站的反爬虫策略,通过细致的分析、实际操作代码和技巧的介绍,为读者提供了深入理解并应用这些反反爬技术的途径。在下一章节中,我们将继续探讨大规模数据抓取技术,包括分布式爬虫架构设计、高效数据存储解决方案,以及大数据处理和分析的策略。

# 3. 大规模数据抓取技术

大规模数据抓取技术是网络爬虫领域的一个高阶话题,它不仅涉及到数据的抓取,还涉及到数据的有效存储、高效处理和分析。这一章节将深入探讨如何设计和实施大规模数据抓取任务,以确保数据的准确性和可用性。

## 3.1 分布式爬虫架构设计

### 3.1.1 分布式爬虫的工作原理

分布式爬虫是一种能够通过网络节点扩展其抓取能力的爬虫架构。它将任务分散到多个工作节点上,利用集群的力量高效完成数据抓取任务。其工作原理主要分为三个部分:任务调度器负责分配抓取任务;爬虫节点负责执行任务并抓取数据;数据库负责存储抓取的数据。

### 3.1.2 分布式爬虫的关键组件

一个典型的分布式爬虫系统包含以下几个关键组件:

- **调度器(Scheduler)**:负责分发URL给

0

0