【Python并发编程核心解读】:深入线程和进程管理,解决面试难题

发布时间: 2024-11-16 17:38:47 阅读量: 23 订阅数: 40

Python并发编程详解:多线程与多进程及其应用场景

# 1. 并发编程简介与Python并发工具概述

并发编程是一种让计算机能够同时处理多个任务的技术,旨在提高程序的执行效率和响应速度。在现代计算机系统中,CPU、内存、I/O设备等资源的高效利用,往往依赖于良好的并发策略。Python作为一门广泛应用于各个领域的编程语言,提供了丰富的并发工具和库来帮助开发者编写高效的并发程序。

## 1.1 并发编程的重要性

在多核处理器普及的今天,传统的单线程程序无法充分利用CPU资源,而并发编程技术可以让程序更有效地运行在多核上。例如,网络服务可以同时处理多个客户端请求,而桌面应用则可以保持用户界面的响应性,即使在执行复杂的后台任务。

## 1.2 Python并发编程工具

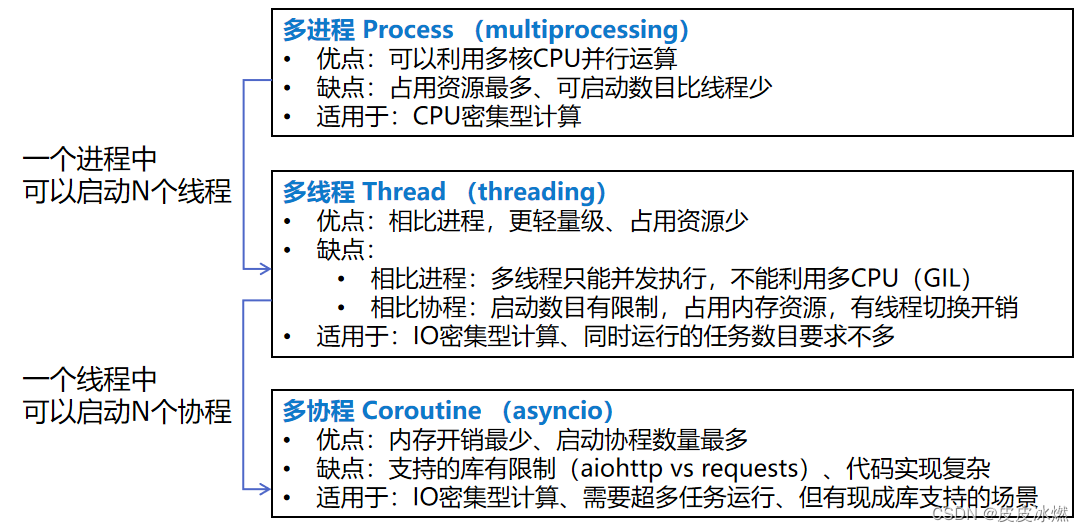

Python提供了线程、进程、异步IO等多种并发工具。线程适合于I/O密集型任务,进程适合于CPU密集型任务,而异步IO则适用于I/O等待时间较长但I/O操作本身较快的场景。后续章节将详细介绍这些工具的使用和管理方法。

通过本章,读者将对并发编程有一个宏观的认识,并了解Python提供的并发工具,为进一步学习打下基础。

# 2. 线程的创建和管理

## 2.1 线程的基本概念和原理

### 2.1.1 线程与进程的区别

线程是操作系统能够进行运算调度的最小单位,它被包含在进程之中,是进程中的实际运作单位。一个进程可以拥有多个线程,每个线程之间共享进程资源。进程与线程的主要区别如下:

- **资源分配**: 进程是资源分配的基本单位,线程不拥有系统资源,但它可以访问其归属进程的资源。

- **调度单位**: 线程是独立调度和分派的基本单位,线程切换比进程切换更快速,因为线程上下文切换只涉及少量的CPU寄存器内容。

- **通信方式**: 同一进程中的线程共享数据,而进程间通信通常需要通过操作系统提供的IPC机制。

- **并发性**: 不同进程可以同时进行,但同一个进程的线程间也可以实现真正的并行。

### 2.1.2 Python中的线程模型

Python的线程模型基于操作系统级别的线程实现。在CPython(Python的标准实现)中,线程由操作系统的本地线程支持,而Python的全局解释器锁(GIL)确保了任何时候只有一个线程在执行Python字节码。不过,即便有GIL的限制,线程仍然是实现I/O密集型任务并发的有用工具。

## 2.2 Python线程的创建与运行

### 2.2.1 使用Thread类创建线程

Python中的`threading`模块提供了一个高级的线程实现。以下是如何使用`Thread`类来创建线程的一个示例:

```python

import threading

import time

def print_numbers():

for i in range(1, 6):

time.sleep(1)

print(i)

thread = threading.Thread(target=print_numbers)

thread.start() # 启动线程

thread.join() # 等待线程结束

```

在此示例中,`print_numbers`函数是线程将要执行的目标函数。我们创建了一个`Thread`对象,并将其`target`参数设置为`print_numbers`函数。调用`start()`方法将启动线程,而`join()`方法将阻塞当前线程直到目标线程完成。

### 2.2.2 线程的启动、运行和终止

在Python中启动线程通常涉及`start()`方法,之后线程的执行取决于其目标函数。终止线程需要小心处理,因为直接终止线程可能导致资源未被正确释放或其他线程状态异常。

要优雅地终止线程,可以在目标函数中加入检查终止条件的逻辑:

```python

import threading

import time

class StoppableThread(threading.Thread):

def __init__(self):

super().__init__()

self._stop_event = threading.Event()

def stop(self):

self._stop_event.set()

def stopped(self):

return self._stop_event.is_set()

def run(self):

while not self.stopped():

# 执行任务...

time.sleep(1)

thread = StoppableThread()

thread.start()

time.sleep(5) # 等待一段时间后停止线程

thread.stop()

thread.join()

```

在这个例子中,我们通过设置一个事件`_stop_event`来控制线程的运行。调用`stop()`方法设置事件,而`stopped()`方法用于检查事件状态。在`run()`方法中,我们使用一个while循环来不断检查是否应该停止线程。线程将在线程的主循环中优雅地终止。

## 2.3 线程间的同步和通信

### 2.3.1 线程同步机制:锁、事件和条件变量

线程同步是并发编程中的一个关键概念。它确保了在多线程环境下,共享资源的访问不会引起数据不一致的问题。Python提供的同步机制包括:

- **锁(Locks)**: 用于控制对共享资源的访问,保证同一时间内只有一个线程可以访问资源。

- **事件(Events)**: 允许一个线程在某个条件发生时,通知其他线程。

- **条件变量(Conditions)**: 类似于事件,但更适用于需要检查某个条件是否满足时使用。

下面使用锁来保护共享资源的一个简单例子:

```python

import threading

# 创建锁

lock = threading.Lock()

def increment(number):

with lock: # 锁的上下文管理器,自动加锁和解锁

number.value += 1

counter = {'value': 0}

threads = []

for _ in range(100):

t = threading.Thread(target=increment, args=(counter,))

threads.append(t)

t.start()

for t in threads:

t.join()

print(counter['value']) # 输出:100

```

### 2.3.2 线程间通信的方法和技巧

在Python中,线程间通信可以使用`queue.Queue`,它是一个线程安全的队列,适用于在生产者和消费者模式下的线程间通信。

以下是使用队列进行线程间通信的一个例子:

```python

import threading

import queue

def producer(q):

for i in range(10):

q.put(i)

print(f'Produced {i}')

def consumer(q):

while not q.empty():

item = q.get()

print(f'Consumed {item}')

q = queue.Queue()

producer_thread = threading.Thread(target=producer, args=(q,))

consumer_thread = threading.Thread(target=consumer, args=(q,))

producer_thread.start()

consumer_thread.start()

producer_thread.join()

consumer_thread.join()

```

在这个例子中,`producer`函数将数据放入队列,而`consumer`函数从队列中取出数据。两个函数分别在独立的线程中运行,实现了线程间的通信。

# 3. 进程的创建和管理

## 3.1 进程的基本概念和原理

### 3.1.1 进程的生命周期

进程是计算机系统进行资源分配和调度的一个独立单位。一个进程的生命周期通常包含创建、就绪、运行、阻塞和终止五个基本状态。

- **创建态**:操作系统为进程分配资源,包括内存空间、系统相关表项等,然后进程的控制块PCB(Process Control Block)被初始化。

- **就绪态**:进程获得除处理机以外的一切所需资源,等待操作系统分配CPU,一旦获得CPU资源,就可以执行。

- **运行态**:进程得到CPU时间片,实际开始执行程序的代码。

- **阻塞态**:进程因等待某个事件发生而暂时停止执行,例如等待I/O操作完成。

- **终止态**:进程执行完毕或因出现错误或故障而被终止。

理解进程的生命周期有助于我们更好地管理进程,包括资源的分配、回收以及进程间的协调工作。

### 3.1.2 Python中的进程模型

Python中通过`multiprocessing`模块实现了进程的创建和管理。该模块提供了一个类似于`threading`模块的接口,允许我们创建多个进程。

Python中的进程模型是基于操作系统的进程管理机制,它通过`Process`类来创建和管理进程。`Process`类的实例代表了一个运行中的进程对象。

```python

import multiprocessing

def worker(name):

print(f"Hello {nam

```

0

0