交叉验证技术在深度学习中的应用:深入应用交叉验证,优化深度学习模型

发布时间: 2024-09-04 04:48:56 阅读量: 134 订阅数: 55

minist+CNN+交叉验证

# 1. 交叉验证技术概述

在机器学习和深度学习领域,交叉验证技术(Cross-Validation)是评估模型泛化能力的核心工具之一。该技术通过将数据集划分为多个子集,并反复使用这些子集进行训练和验证,从而更全面地评估模型性能。交叉验证不仅能有效避免模型过拟合,还可以优化模型选择过程,增强模型在未知数据上的表现。本章将介绍交叉验证的基本概念及其在深度学习中的应用前景,为后续章节深入探讨交叉验证方法和优化实践奠定基础。

# 2. 交叉验证在深度学习中的理论基础

## 2.1 交叉验证的基本概念

### 2.1.1 交叉验证的定义与原理

交叉验证是一种模型评估技术,旨在评估学习模型对未知数据的预测能力。它通过将数据集分成k个大小相等的子集,轮流将k-1个子集作为训练数据集,剩下的一个子集作为验证集。这一过程重复k次,每次选择不同的验证集,最终模型的性能评估是基于所有k次结果的平均。

### 2.1.2 常见的交叉验证方法

在深度学习中,有多种交叉验证的方法,最常见的是K折交叉验证和留一交叉验证。

- **K折交叉验证**:将数据集分为K个大小相等的子集,然后每次留一个子集作为验证集,其余的K-1个子集作为训练集。这种方法较为平衡,能够较为全面地利用数据进行训练和验证。

- **留一交叉验证**:每个子集仅包含一个样本,这种方法接近于完全数据利用,但计算开销非常大。

### 2.1.3 实现交叉验证的策略

在实现交叉验证时,需要遵循以下几个策略:

- 确保每个子集的代表性,以便在不同的训练集和验证集组合中都能反映数据的多样性。

- 对于数据集的划分,需要保证数据的随机性和多样性,避免数据的划分导致的偏差。

- 在深度学习模型训练过程中,可以使用早停法(early stopping)来避免过拟合。

### 2.1.4 交叉验证的适用场景

交叉验证适用于数据量较小且对模型的泛化能力有较高要求的场景。在深度学习中,由于模型参数众多,过拟合风险高,合理的交叉验证策略能够帮助我们更准确地评估模型性能。

## 2.2 交叉验证与深度学习的关系

### 2.2.1 模型泛化能力的重要性

在深度学习中,模型泛化能力是衡量模型好坏的关键指标。泛化能力强的模型能够在未见过的数据上表现良好,而交叉验证技术能够有效地评估模型的泛化能力。通过多次验证,交叉验证提供了一种相对稳定和全面的模型性能评估方法。

### 2.2.2 交叉验证在深度学习中的作用

在深度学习中,交叉验证不仅用于评估模型的性能,还可以帮助我们进行超参数的调优。通过比较不同超参数设置下的交叉验证结果,我们可以选择最佳的超参数组合,以获得最优的模型性能。

## 2.3 交叉验证技术的理论分析

### 2.3.1 交叉验证理论分析的重要性

对交叉验证技术进行理论分析可以帮助我们更好地理解该技术的优势与局限性,从而在实际应用中更加灵活地运用这一技术。

### 2.3.2 理论分析的方法

理论分析的方法包括数学证明、模拟实验等。数学证明可以给出交叉验证一致性和无偏性的理论保证。模拟实验能够验证实际应用中交叉验证的性能和鲁棒性。

### 2.3.3 交叉验证对模型评估的影响

交叉验证改变了单一训练集和验证集组合下模型评估的偶然性,通过对多个组合的评估,交叉验证可以给出一个更加稳定和可靠的性能指标。

## 2.4 交叉验证的应用实例

### 2.4.1 实例:深度学习模型的交叉验证

通过一个深度学习模型的交叉验证实例,我们可以展示交叉验证在实际中的应用效果。以图像分类任务为例,采用CNN模型,利用K折交叉验证方法,可以有效评估模型对图像数据的泛化能力。

### 2.4.2 实例分析:交叉验证优化

通过具体案例的分析,展示了在深度学习任务中如何通过交叉验证来选择更好的超参数设置,进一步优化模型性能。

在下一部分中,我们将深入探讨交叉验证技术在深度学习中的实践应用,进一步了解如何在具体的数据划分策略和算法实现中应用交叉验证,以及如何通过实际案例来优化CNN模型。

# 3. 交叉验证技术在深度学习中的实践

## 3.1 数据划分策略

在进行交叉验证之前,合理地划分数据集是非常关键的一步,它将直接影响模型的泛化能力和交叉验证的效果。深度学习模型通常对数据量的需求较大,因此划分策略的设计需考虑数据的代表性和避免数据泄露。

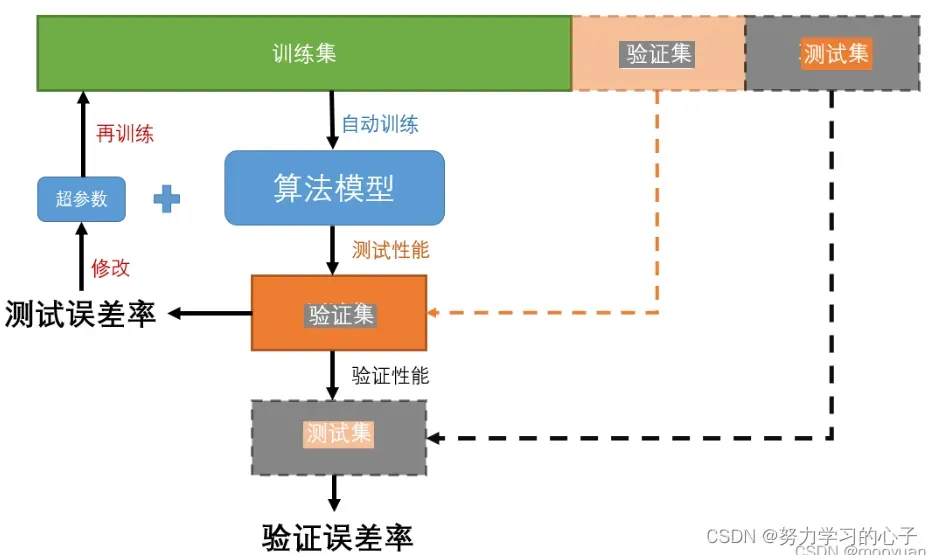

### 3.1.1 训练集、验证集和测试集的划分

在深度学习中,数据通常分为三个集合:训练集、验证集和测试集。

- **训练集**:用于模型学习的样本集合,模型通过这部分数据进行学习,更新其内部参数以最小化损失函数。

- **验证集**:用于模型选择的样本集合,通过验证集评估模型在未见数据上的性能,用于调整模型参数和选择超参数。

- **测试集**:用于评估最终模型性能的样本集合,这部分数据在模型训练和参数选择过程中完全不参与,因此可以较为公正地评估模型的泛化能力。

合理的划分比例是关键。通常情况下,训练集占数据总量的60%-80%,验证集占10%-20%,而测试集占10%-20%。

```python

from sklearn.model_selection import train_test_split

# 假设 X 是特征数据,y 是标签数据

X_train, X_temp, y_train, y_temp = train_test_split(X, y, test_size=0.3, random_state=42)

X_val, X_test, y_val, y_test = train_test_split(X_temp, y_temp, test_size=0.5, random_state=42)

# 训练集、验证集、测试集划分完毕

```

在上述代码块中,我们使用了 `sklearn` 中的 `train_test_split` 函数,将数据集划分为训练集、临时集、验证集和测试集。参数 `test_size=0.3` 指定了测试集和验证集共同占据30%的数据量,再通过一次分割将其中的50%分配给验证集。

### 3.1.2 数据增强与交叉验证

数据增强是对训练数据集进行一系列变换来增加其多样性,从而提高模型泛化能力的策略。图像、音频等数据的增强方法较为常见,如图像旋转、缩放、裁剪等。

在交叉验证中,数据增强可以应用于每个子集上,以提高验证的准确性。

```python

from imgaug import augmenters as iaa

# 定义数据增强操作

seq = iaa.Sequential([

iaa.Fliplr(0.5), # 随机水平翻转

iaa.GaussianBlur(sigma=(0, 0.5)), # 高斯模糊

])

# 应用到数据集上

augmented_data = seq.augment_images(original_data)

```

在上述代码段中,使用了 `imgaug` 库中的 `augmenters` 模块定义了一系列图像增强操作。这些操作通过 `augment_images` 函数应用到原始数据上,生成增强后的数据集。

## 3.2 实现交叉验证的算法

交叉验证的核心思想是通过不同的数据子集划分来评估模型的稳定性和泛化能力。以下两种算法是深度学习中常用的交叉验证方法。

### 3.2.1 K折交叉验证

K折交叉验证(K-fold cross-validation)是将原始数据集随机分为K个子集,每次留出一个子集作为验证集,其余的K-1个子集用于训练模型。这样会重复K次,每次使用不同的子集作为验证集,然后将K次结果的平均值作为最终评估指标。

```python

from sklearn.model_selection import KFold

# 假设 X, y 已经准备妥当

kf = KFold(n_splits=5, random_state=42, shuffle=True)

for train_index, val_index in kf.split(X):

X_train, X_val = X[train_index], X[val_index]

y_train, y_val = y[train_index], y[val_index]

# 训练模型...

```

在这段代码中,我们利用 `sklearn` 的 `KFold` 函数设置5折交叉验证。参数 `n_splits=5` 表示我们把数据分成5份,`shuffle=True` 表示每次分割前会随机打乱数据。

### 3.2.2 留一交叉验证

留一交叉验证(Leave-One-Out cross-validation, LOOCV)是K折交叉验证的特例,即K等于数据集大小。每一轮只留出一个样本作为验证集,其余样本作为训练集。由于其对数据的利用效率

0

0