构建自定义交叉验证函数:为特定问题量身定制解决方案:自定义交叉验证函数,解决特定问题

发布时间: 2024-09-04 05:32:42 阅读量: 103 订阅数: 67

# 1. 交叉验证的基本原理和重要性

## 1.1 交叉验证基本原理

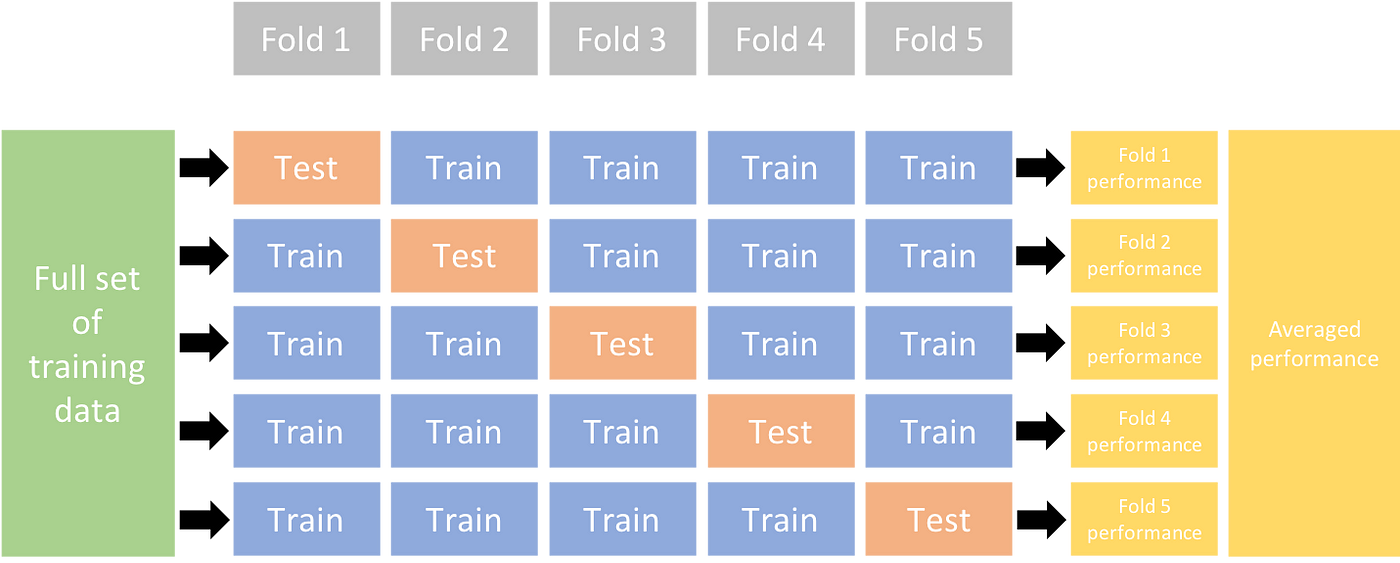

交叉验证是一种统计学方法,用于评估并改善机器学习模型的泛化能力。其核心思想是将原始数据随机划分为k个子集,然后通过k次训练和验证过程,每次留出一个子集作为验证集,其余k-1个作为训练集。这种方法能有效地利用有限的数据,从而提供一个对模型性能更加稳定和准确的估计。

## 1.2 交叉验证的重要性

在模型开发过程中,避免过拟合和选择合适的模型参数至关重要。交叉验证能够通过多次验证来评估模型对未知数据的预测能力,有助于提高模型的泛化性能。同时,它也减少了模型评估过程中数据划分随机性的影响,提升了结果的可靠性,确保了模型评估的稳健性。

# 2. 自定义交叉验证函数的理论基础

## 2.1 交叉验证的概念和类型

### 2.1.1 什么是交叉验证

交叉验证(Cross-Validation)是统计学中一种评估学习算法泛化能力的模型评估方法。在机器学习领域,它通常用于评估一个模型对未知数据的预测能力,从而可以减少模型过拟合的风险。交叉验证通过将数据集分割成几个小的“折”(fold),然后用其中的一部分作为训练集,其余的作为验证集,通过这种方式可以多次重复模型训练和验证的过程,最终得到一个模型性能的平均估计。

### 2.1.2 常见的交叉验证类型及其特点

- 留出法(Holdout Validation):将原始数据集随机分成两部分,一部分用于训练模型(训练集),另一部分用于评估模型(测试集)。这种方法简单易实现,但是不稳定,因为测试结果依赖于数据分割的方式。

- k-折交叉验证(k-Fold Cross-Validation):将数据集分成k个大小相等的互斥子集,每个子集轮流作为验证集,其余k-1个子集用作训练集。这种方法更加稳定,能够更充分地利用数据。

- 留一法(Leave-One-Out Cross-Validation, LOOCV):k-折交叉验证的特例,即k等于样本总数,每次留出一个样本进行验证。这种方法的计算成本很高,但是几乎可以利用所有的数据进行训练。

```mermaid

graph LR

A[开始交叉验证]

A --> B[划分数据集]

A --> C[模型训练]

A --> D[模型验证]

A --> E[参数调优]

B --> B1[留出法]

B --> B2[k-折交叉验证]

B --> B3[留一法]

C --> C1[选择训练集]

D --> D1[评估模型性能]

E --> E1[调整超参数]

A --> F[结束交叉验证]

```

## 2.2 交叉验证在机器学习中的作用

### 2.2.1 避免过拟合

在机器学习中,模型训练的目标是学习到能够准确预测未知数据的模型。交叉验证通过将数据集多次分割并用于训练和验证,能够减少模型对特定数据集的依赖性,从而避免过拟合,确保模型具有良好的泛化能力。

### 2.2.2 模型评估和参数选择

交叉验证不仅可以评估模型的预测性能,还可以用来选择模型的参数。通过比较不同参数设置下的模型性能,可以找到最优的模型配置。例如,在使用支持向量机(SVM)时,可以利用交叉验证选择最佳的核函数类型和惩罚参数C。

## 2.3 自定义交叉验证的理论模型

### 2.3.1 理解特定问题的需求

为了设计有效的交叉验证函数,首先需要深入理解问题领域和数据的特点。比如,时间序列数据的交叉验证需要考虑时间顺序,以避免未来的数据被用来训练模型。

### 2.3.2 设计与问题适配的交叉验证策略

基于对问题的理解,设计交叉验证策略。例如,对于分类问题,可以采用k-折交叉验证;对于回归问题,可能会选择留出法或LOOCV。此外,还需要考虑是否需要对数据进行特殊处理,如标准化、归一化等,以确保交叉验证的有效性。

# 3. 自定义交叉验证函数的实现步骤

## 3.1 设计交叉验证框架

### 3.1.1 定义验证流程和参数

在自定义交叉验证函数之前,首先需要定义整个验证流程和所需的参数。这包括确定数据集如何被划分成训练集和验证集,以及如何组织多次迭代。在机器学习中,交叉验证通常需要以下参数:

- **k**: 表示将数据集划分为多少份,也就是k折交叉验证中的k值。

- **data**: 完整的数据集。

- **model**: 要训练的机器学习模型。

- **scorer**: 评价模型性能的评分器,用于比较不同模型或不同参数下的模型性能。

- **n_iterations**: 迭代次数,即模型训练多少次。

- **random_state**: 随机数种子,用于可重复的结果。

定义这些参数后,可以开始构建交叉验证的框架。

### 3.1.2 实现数据集的划分逻辑

数据集的划分是交叉验证的核心步骤。划分逻辑需要保证每次迭代后,每个数据点都有机会成为验证集的一部分。k折交叉验证将数据划分为k个大小大致相等的互斥子集,然后每次保留一个子集作为验证集,其余k-1个子集作为训练集。重复k次,每次选择不同的训练集和验证集。具体实现可能如下所示:

```python

from sklearn.model_selection import KFold

def k_fold_cross_validation(data, k):

kf = KFold(n_splits=k, shuffle=True, random_state=random_state)

for train_index, validation_index in kf.split(data):

train_data, validation_data = data[train_index], data[validation_index]

# 在这里执行训练和验证过程...

pass

return results

```

在这个函数中,`data`是包含所有特征和标签的完整数据集,`k`是折数,`train_index`和`validation_index`是`KFold.split`方法返回的用于分割数据集的索引。通过循环执行k次,每次使用不同的训练集和验证集。

## 3.2 编写交叉验证函数

### 3.2.1 函数接口设计

自定义交叉验证函数的接口需要清晰定义,并且应该包含执行交叉验证所需的所有参数。函数的主体部分将负责执行交叉验证的迭代过程,并将每次迭代的结果进行聚合。

```python

def custom_cross_validation(data, model, scorer, k=5, random_state=None):

"""

自定义交叉验证函数

参数:

data - 用于交叉验证的数据集。

model - 拟合数据的机器学习模型。

scorer - 用于评分的评分器。

k - k折交叉验证中的k值。

random_state - 随机数种子,用于生成可重复的结果。

返回:

results - 包含每次迭代的评估结果的列表。

"""

# 初始化结果列表

results = []

# 执行交叉验证逻辑

...

return results

```

### 3.2.2 实现迭代过程和结果聚合

在交叉验证函数中,迭代过程是核心。需要在每次迭代中训练模型并评估其性能。结果聚合通常涉及将每次迭代的结果汇总成一个易于理解的格式,比如平均值、标准差等。

```python

for train_index, validation_index in kf.split(data):

# 划分训练集和验证集

train_data, validation_data = data[train_index], data[validation_index]

# 训练模型

model.fit(train_data)

# 预测验证集

predictions = model.p

```

0

0