深度学习技术详解:神经网络、卷积神经网络和循环神经网络

发布时间: 2024-08-10 10:27:24 阅读量: 32 订阅数: 34

tensorflw循环神经网络详解

# 1. 深度学习概述**

深度学习是一种机器学习技术,它使用多层神经网络来学习数据中的复杂模式。与传统机器学习方法不同,深度学习模型不需要手工设计的特征,而是直接从原始数据中学习。

深度学习在图像识别、自然语言处理和语音识别等领域取得了巨大的成功。它已成为人工智能领域最活跃和最有前途的研究领域之一。

深度学习模型通常由多个隐藏层组成,每个隐藏层都包含多个神经元。神经元之间的连接权重是通过训练数据学习的。训练过程涉及使用反向传播算法来最小化模型在训练数据上的损失函数。

# 2. 神经网络基础

神经网络是深度学习的核心,它模拟了人脑的神经元结构和连接方式,通过学习数据中的模式和特征,来执行各种复杂的计算任务。

### 2.1 人工神经元和激活函数

人工神经元是神经网络的基本组成单元,它模仿了生物神经元的结构和功能。一个人工神经元接收多个输入值,并通过一个数学函数(称为激活函数)将这些输入值转换为一个输出值。

常见的激活函数包括:

- Sigmoid 函数:将输入值映射到 0 到 1 之间的范围,用于二分类任务。

- Tanh 函数:将输入值映射到 -1 到 1 之间的范围,用于回归任务。

- ReLU 函数(整流线性单元):将输入值映射到 0 或输入值本身,用于加速训练和防止梯度消失。

### 2.2 神经网络的结构和类型

神经网络由多个神经元层组成,每层的神经元接收前一层神经元的输出作为输入。神经网络的结构可以根据任务的复杂性和数据的大小而变化。

常见的网络结构包括:

- 前馈神经网络:信号只从输入层流向输出层,没有反馈回路。

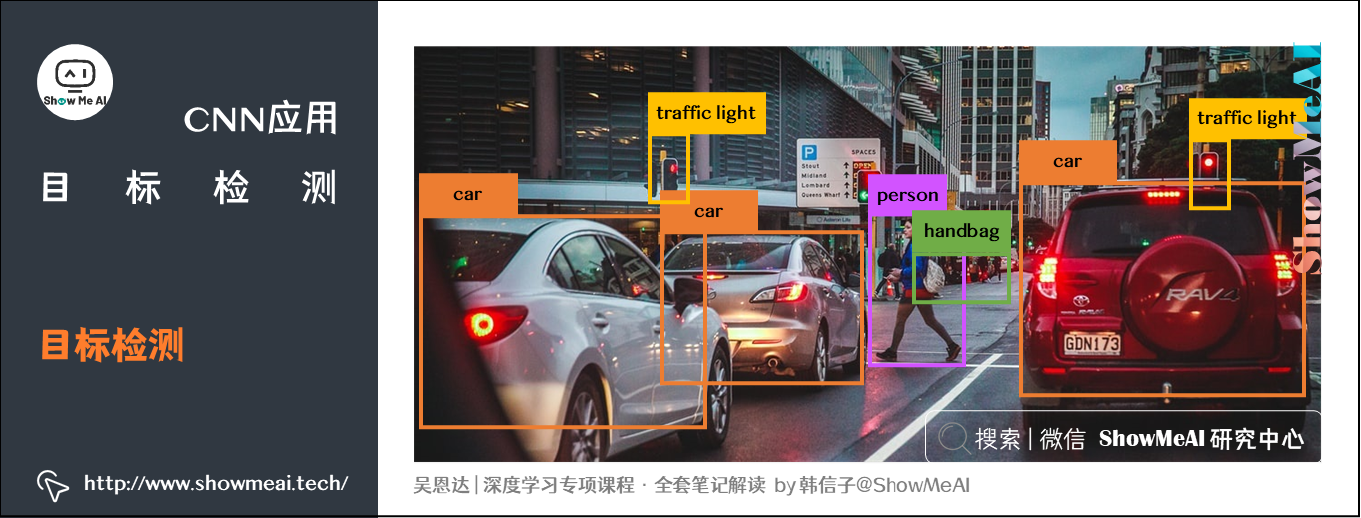

- 卷积神经网络(CNN):专门用于处理图像数据,具有卷积层和池化层。

- 循环神经网络(RNN):专门用于处理序列数据,具有反馈回路。

### 2.3 神经网络的训练和优化

神经网络的训练过程涉及调整网络中的权重和偏差,以最小化损失函数(衡量网络输出与预期输出之间的差异)。训练算法包括:

- 梯度下降:通过计算损失函数的梯度并沿着负梯度方向更新权重,来最小化损失函数。

- 反向传播:一种高效的梯度计算算法,用于多层神经网络。

- 优化器:如 Adam 和 RMSProp,用于加速训练和提高收敛性。

代码块:

```python

import numpy as np

# 定义神经网络模型

class NeuralNetwork:

def __init__(self, layers, activation_function):

self.layers = layers

self.activation_function = activation_function

def forward_pass(self, X):

# 前向传播

for layer in self.layers:

X = np.dot(X, layer.weights) + layer.biases

X = self.activation_function(X)

return X

def backward_pass(self, X, y, loss_function):

# 反向传播

dL_dX = loss_function.gradient(X, y)

for layer in reversed(self.layers):

dL_dX = np.dot(dL_dX, layer.weights.T)

dL_dX = self.activation_function.gradient(X) * dL_dX

return dL_dX

def update_weights(self, dL_dX, learning_rate):

# 更新权重

for layer in self.layers:

layer.weights -= learning_rate * dL_dX

layer.biases -= learning_rate * dL_dX

# 训练神经网络

model = NeuralNetwork([

LinearLayer(10, 20),

ActivationLayer(ReLU()),

LinearLayer(20, 10),

ActivationLayer(Sigmoid())

])

# 训练数据

X = np.array([[1, 2], [3, 4], [5, 6]])

y = np.array([0, 1, 0])

# 训练神经网络

for epoch in range(1000):

# 前向传播

y_pred = model.forward_pass(X)

# 计算损失

loss = MeanSquaredError().loss(y_pred, y)

# 反向传播

dL_dX = model.backward_pass(X, y, MeanSquaredErr

```

0

0