决策树算法大解析:ID3、C4.5与CART的优劣对比及实战选择

发布时间: 2024-09-08 08:39:28 阅读量: 204 订阅数: 62

人工智能-机器学习-决策树-决策树分类(ID3,C4.5,CART)

# 1. 决策树算法概述

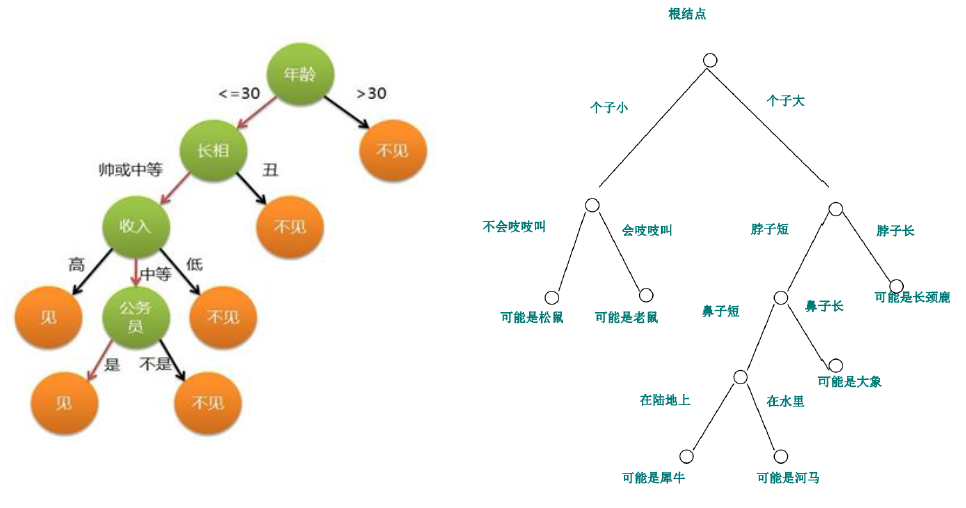

决策树算法是一种常用的机器学习方法,用于分类和回归任务。其基本思想是通过一系列的问题,对数据进行划分,直到每个子集中的所有实例都属于同一个类别或满足某个预定的停止条件。这种从根到叶节点的划分过程形成了树形结构,因而得名决策树。

在决策树算法中,每一个非叶节点代表一个属性上的判断,而每一个分支代表一个判断结果的输出。叶节点代表了最终的决策结果。通过这种方式,决策树模型可以模拟人类在决策过程中的逻辑思维,因而易于理解并解释。

决策树算法的关键在于选择合适的属性进行分割。这一章节将介绍决策树算法的基础知识,包括它的核心概念、优缺点以及在实际应用中的重要性。接着的章节会详细介绍几种流行的决策树算法(如ID3、C4.5和CART),它们在处理不同数据和问题时的策略,以及如何选择最适合特定问题的决策树算法。

# 2. ID3算法的理论与实践

## 2.1 ID3算法的基本原理

### 2.1.1 信息熵的概念及计算方法

信息熵是衡量数据集中随机变量不确定性的度量,是ID3算法的核心概念之一。它源自热力学中的熵概念,用来描述系统的混乱程度。在机器学习中,信息熵用来评估分类目标的纯度。

数学上,信息熵定义为:

\[ H(X) = -\sum_{i=1}^{n} p(x_i) \log_2 p(x_i) \]

其中,\( H(X) \) 是随机变量 \(X\) 的熵,\(p(x_i)\) 是随机变量 \(X\) 中第 \(i\) 个值发生的概率。

以二分类问题为例,设类别分布为 {P1, P2},其中P1为正类,P2为负类。信息熵可以表达为:

\[ H(P1, P2) = -P1 \log_2(P1) - P2 \log_2(P2) \]

信息熵越小,数据集分类纯度越高,信息熵越大,说明数据集的不确定性越大,分类纯度越低。

### 2.1.2 信息增益的计算与选择过程

信息增益是划分数据集前后信息熵的差值,它表示获取新信息后对数据集纯度的提升程度。一个属性的信息增益越大,意味着利用这个属性来划分数据集的效果越好。

信息增益 \( IG(S,A) \) 的计算公式为:

\[ IG(S,A) = H(S) - \sum_{t \in T} \frac{|S_t|}{|S|} H(S_t) \]

其中,\( H(S) \) 是数据集 \(S\) 的初始熵,\(T\) 是按照属性 \(A\) 划分后得到的子集集合,\(S_t\) 表示某个子集,\( |S_t| \) 和 \( |S| \) 分别是子集和原始数据集的样本数,\( H(S_t) \) 是子集 \(S_t\) 的熵。

通过计算每个属性的信息增益,ID3算法会选择信息增益最大的属性来对数据集进行划分。

## 2.2 ID3算法的实践应用

### 2.2.1 ID3算法的Python实现

ID3算法的Python实现涉及以下几个主要步骤:

1. 计算数据集的熵。

2. 计算每个属性的信息增益。

3. 选择信息增益最大的属性进行数据集的划分。

4. 递归地构建决策树。

下面是一个简单的Python代码实现示例:

```python

import numpy as np

import math

def calc_entropy(y):

class_labels = np.unique(y)

entropy = 0

for cls in class_labels:

p_cls = len(y[y == cls]) / len(y)

entropy -= p_cls * math.log2(p_cls)

return entropy

def ID3(X, y):

# X为特征数据集,y为标签

if len(np.unique(y)) == 1: # 所有实例属于同一类

return np.unique(y)[0]

elif len(X) == 0: # 没有特征可以选择

return np.unique(y)[np.argmax(np.bincount(y))]

else:

parent_entropy = calc_entropy(y)

best_idx, best_gain = None, -1

for idx in range(len(X.T)): # 对每个特征进行计算

child_entropy = 0

values, counts = np.unique(X[:, idx], return_counts=True)

for val, count in zip(values, counts):

subset = y[X[:, idx] == val]

p = len(subset) / len(y)

child_entropy += p * calc_entropy(subset)

gain = parent_entropy - child_entropy

if gain > best_gain:

best_gain = gain

best_idx = idx

if best_idx is None:

return np.unique(y)[np.argmax(np.bincount(y))]

best_feature = X[:, best_idx]

tree = {best_idx: {}}

features = np.unique(best_feature)

for val in features:

sub_X = X[X[:, best_idx] == val]

subtree = ID3(sub_X, y)

tree[best_idx][val] = subtree

return tree

# 示例数据集

X = np.array([[0, 0, 1, 1], [0, 1, 0, 1]])

y = np.array([0, 1, 0, 1])

# 构建决策树

decision_tree = ID3(X, y)

```

### 2.2.2 ID3算法在分类问题中的应用案例

考虑使用著名的鸢尾花(Iris)数据集来演示ID3算法的分类效果。数据集包含150个样本,每个样本有4个特征,并分为3个类别。

```python

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

iris = load_iris()

X_train, X_test, y_train, y_test = train_test_split(iris.data, iris.target, test_size=0.2, random_state=1)

# 转换为ID3算法能处理的离散格式

def discretize(X, bins):

return np.digitize(X, bins)

bins = [np.quantile(X_train[:,i], np.linspace(0, 1, 4)) for i in range(X_train.shape[1])]

X_train_discrete = discretize(X_train, bins)

X_test_discrete = discretize(X_test, bins)

# 使用ID3算法进行分类

iris_tree = ID3(X_train_discrete, y_train)

# 进行预测

y_pred = np.array([iris_tree[x] for x in X_test_discrete])

# 计算准确率

accuracy = accuracy_score(y_test, y_pred)

print(f"Accuracy of ID3 classifier on Iris dataset: {accuracy * 100:.2f}%")

```

通过上述步骤,我们可以构建一个ID3决策树分类器,并在鸢尾花数据集上评估其性能。

## 2.3 ID3算法的局限性与优化

### 2.3.1 连续属性的处理方法

ID3算法在处理连续属性时存在局限性,因为它本质上是针对离散属性设计的。为了解决这一问题,可以使用分裂策略,将连续属性划分为多个区间。常见的方法有:

- 二分法:将属性值分为两组,最大值和最小值分别作为分界点。

- 基于熵增益的分割:选择使得信息增益最大的阈值作为分割点。

### 2.3.2 ID3算法的剪枝策略

ID3算法容易产生过拟合,即过分拟合训练数据中的噪声和特殊性。为了提高模型的泛化能力,需要引入剪枝策略。剪枝可以通过以下两种方式实现:

- 预剪枝:在构建决策树时提前停止树的增长。

- 后剪枝:首先生成完整的决策树,然后从下至上剪去对分类结果贡献不大的树节点。

预剪枝示例:

```python

def ID3_pre_prune(X, y, max_depth=5):

# 省略前面的代码

if len(np.unique(y)) == 1 or len(X.T) == 0 or max_depth == 0:

return np.unique(y)[np.argmax(np.bincount(y))]

else:

# 省略计算信息增益的代码

if depth >= max_depth:

return np.unique(y)[np.argmax(np.bincount(y))]

# 省略构建树的代码

```

后剪枝是更复杂的处理方式,通常需要额外的验证数据集或交叉验证来确定需要剪枝的节点。

通过理解和应用这些优化方法,我们可以增强ID3算法的性能,使其适应更广泛的应用场景。

# 3. C4.5算法的深入分析

## 3.1 C4.5算法的理论基础

### 3.1.1 增益比的概念及计算

C4.5算法在决策树领域中是一个重要的进展,由Ross Quinlan开发。与ID3算法类似,C4.5利用信息增益的概念来构建决策树,但改进了ID3中的一些局限性。增益比是C4.5算法中用来衡量特征选择的重要指标,它是信息增益与特征熵的比值。

增益比的计算公式如下:

\[ GainRatio(D, A) = \frac{Gain(D, A)}{SplitInfo(D, A)} \]

其中,\( Gain(D, A) \)是特征A对数据集D的信息增益,而\( SplitInfo(D, A) \)是一个用来衡量分割数据集的“代价”的指标。

### 3.1.2 对ID3算法的改进之处

C4.5算法在理论上对ID3算法做出了多项改进,其中最主要的改进包括:

1. 处理连续属性:C4.5能够处理连续属性的特征,通过对连续属性的数值进行排序并选择最佳阈值进行分割。

2. 剪枝策略:C4.5引入了剪枝技术,来防止过拟合。它通过子树的错误率来评估子树的泛化能力。

3. 处理缺失值:C4.5算法可以处理训练数据中存在缺失值的情况,通过计算特征不缺失时的增益,然后对不缺失的概率进行加权,以估计增益比。

## 3.2 C4.5算法的实践应用

### 3.2.1 C4.5算法的Python实现

下面是一个使用Python中的`scikit-learn`库实现C4.5算法的简化示例:

```python

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 示例数据集,包含特征和目标变量

X = [[0, 0], [1, 1], [1, 0], [0, 1]]

y = [0, 1, 1, 0]

# 将数据集划分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=1)

# 创建决策树分类器实例,设置criterion为'entropy'来使用C4.5算法

clf = DecisionTreeClassifier(criterion='entropy', random_state=1)

# 训练模型

clf.fit(X_train, y_train)

# 预测测试集结果

y_pred = clf.predict(X_test)

# 计算准确率

accuracy = accuracy_score(y_test, y_pred)

print(f"模型准确率: {accuracy}")

```

在上面的代码中,`criterion='entropy'`指定了使用信息熵进行决策树的构建,从而实现C4.5算法的效果。

### 3.2.2 C4.5算法在实际问题中的应用案例

C4.5算法已被广泛应用于各类机器学习问题中。例如,在医学诊断中,可以通过已知的病人特征(如年龄、血压、胆固醇水平等)来预测病人是否患有某种疾病。

在金融领域,C4.5算法可以用来评估信贷风险,通过分析借款人的历史交易记录、收入水平和其他财务信息来决定贷款的批准与否。

## 3.3 C4.5算法的优势与注意事项

### 3.3.1 C4.5算法处理连续属性和缺失值的策略

C4.5算法在处理连续属性时,通过为每个连续值生成一个二元划分来工作。算法评估每个划分点,并选择最优的划分点作为决策节点。

对于缺失值,C4.5采用了一种较为简单但有效的方法。如果某个特征值缺失,算法会使用不包含该缺失值的训练数据来计算最佳分割。如果该特征值在测试数据中缺失,则会为每个分支赋予一个默认的平均值,然后按照这个平均值来计算最终的分类结果。

### 3.3.2 C4.5算法在大规模数据集上的性能考量

尽管C4.5算法在理论上具有很多优势,但它在大规模数据集上的表现则不尽如人意。这主要是因为C4.5算法在构建决策树的过程中需要存储大量的信息,并且在每次分割时都需要计算信息增益和增益比,这一过程在数据集庞大时会非常耗时。

在实际应用中,由于数据量的快速增长,C4.5算法的性能问题变得更加显著。因此,当面对大规模数据集时,研究者们往往倾向于使用其他更高效的算法,比如随机森林(Random Forest)或者梯度提升决策树(Gradient Boosting Decision Trees, GBDTs)。

接下来的第四章将探索另一种流行的决策树算法:CART算法,并比较它的优缺点。

# 4. CART算法的探索与应用

## 4.1 CART算法的理论框架

### 4.1.1 Gini指数的定义和作用

Gini指数,也被称为基尼不纯度,是CART算法中用来评估节点纯度的重要指标。它的定义基于从数据集中随机选择两个样本,其类别标签不一致的概率。基尼不纯度越低,样本的纯度越高,意味着样本中的类别分布越不均匀。

对于一个节点内的样本集合,基尼不纯度的计算公式如下:

\[ Gini = 1 - \sum_{i=1}^{J} p_i^2 \]

其中 \(p_i\) 是样本属于第 \(i\) 类的概率,\(J\) 是类别的总数。

基尼指数的计算方法简单直接,不需要像信息熵那样涉及到对数运算,所以在CART算法中更受欢迎。使用基尼指数可以在分类问题中快速选择最佳特征来分割数据集,并且在构建树的过程中保持高效的性能。

### 4.1.2 二叉树构建过程的介绍

CART算法的独特之处在于它总是构建二叉树,而不是像ID3和C4.5那样构建多叉树。二叉树的每一个节点都按照最优特征进行分割,分割的标准是最小化加权基尼不纯度。

构建二叉树的过程如下:

1. 从根节点开始,计算所有特征的基尼指数。

2. 选择基尼指数最小的特征以及对应的分割阈值进行分割,生成左右子节点。

3. 对每个子节点递归执行步骤1和2,直到满足停止条件:节点中的数据属于同一类别,或者节点中的数据少于预定阈值,或者达到树的最大深度等。

4. 最终形成一棵完全二叉树。

通过构建二叉树,CART算法实现了高效的数据分割,并且容易实现剪枝,避免过拟合现象。

## 4.2 CART算法的实践技巧

### 4.2.1 CART算法的Python实现

在Python中,可以使用`scikit-learn`库中的`DecisionTreeClassifier`和`DecisionTreeRegressor`来实现CART算法。以下是一个简单的示例代码:

```python

from sklearn.tree import DecisionTreeClassifier

# 假设X_train和y_train分别包含训练特征和标签

clf = DecisionTreeClassifier(criterion='gini') # 使用基尼不纯度

clf.fit(X_train, y_train)

```

在上述代码中,`DecisionTreeClassifier`是分类问题下的CART实现,而`DecisionTreeRegressor`是回归问题下的实现。通过设置`criterion='gini'`参数,我们指定了基尼指数作为分割标准。

### 4.2.2 CART算法在回归和分类问题中的应用示例

CART算法不仅在分类问题中表现出色,还能在回归问题中有效地构建预测模型。下面展示一个在分类问题中应用CART算法的示例:

```python

# 使用iris数据集

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

iris = load_iris()

X, y = iris.data, iris.target

# 分割数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 构建CART模型

clf = DecisionTreeClassifier(criterion='gini')

clf.fit(X_train, y_train)

# 预测并计算准确率

y_pred = clf.predict(X_test)

print("Accuracy:", accuracy_score(y_test, y_pred))

```

这个例子展示了如何加载数据集、分割数据、训练模型,并使用测试数据评估模型准确率。CART算法在本例中的应用证明了其在分类问题中的直观性和有效性。

## 4.3 CART与其他算法的对比

### 4.3.1 CART与ID3、C4.5的对比分析

CART算法与ID3和C4.5算法主要的不同在于树的构建方式和分割标准。ID3使用信息熵,C4.5使用增益比,而CART使用基尼不纯度。此外,CART能够处理数值型和分类型数据,且总是构建二叉树,而ID3和C4.5通常构建多叉树。

在处理连续属性时,C4.5需要对连续属性进行离散化处理,而CART可以使用分割点进行二元分割,更为灵活。在处理缺失值问题时,C4.5采用了一种基于概率的方法,而CART则可以直接处理。

### 4.3.2 CART算法在现实世界中的优势和局限

CART算法的优点包括:

- 使用基尼不纯度作为节点分割的度量标准,简化了计算过程。

- 构建二叉树,简化了模型的复杂度,易于理解和解释。

- 适应于各种类型的数据,包括分类和回归。

- 能够直接处理连续和缺失值数据。

然而,CART算法也存在一些局限:

- 在某些情况下,可能会对具有多个类别的数据过度拟合。

- 二叉树可能需要更多的树深度来拟合多类别数据,增加了计算负担。

在实际应用中,选择CART算法还是其他决策树算法,取决于具体问题的需求和数据的特性。对于需要进行回归预测的问题,CART提供了直接且有效的解决方案。

# 5. 决策树算法实战选择指南

决策树算法的选择和优化是一个复杂的过程,它需要考虑数据特性和预处理需求。此外,实际应用场景下的算法性能也是重要的考量因素。本章将为你提供一套决策树算法选择的实战指南,帮助你在面对不同问题时,能够选择最适合的算法,并结合实际情况进行优化。

## 5.1 决策树算法选择标准

### 5.1.1 数据特性对算法选择的影响

选择决策树算法前,首先要分析数据的特性。数据特性包括数据的规模、类型(连续还是离散)、是否有缺失值、数据是否平衡等因素。例如,ID3算法不适合处理连续属性,而C4.5和CART都可以。数据规模较大的情况下,可能需要考虑算法的可扩展性和计算效率。

### 5.1.2 预处理需求与算法效率考量

不同的决策树算法对数据预处理的需求不同。一些算法在面对不平衡数据集时,可能需要进行过采样或者欠采样。算法效率也是选择时的重要考量因素。对于大规模数据集,C4.5和CART算法相较于ID3,通常会有更好的性能表现。

## 5.2 案例分析:选择合适的决策树算法

### 5.2.1 案例背景与数据描述

假设我们有一个客户流失预测的业务问题,我们需要从历史数据中找出影响客户流失的关键因素。数据集包含用户的个人信息、使用习惯、交易记录等多个特征,以及一个标签(是否流失)。数据集大小为10000条记录,特征总数为30。

### 5.2.2 不同决策树算法的效果评估与比较

在此案例中,我们选择ID3、C4.5和CART算法进行实验。实验中,我们关注算法的准确率、模型构建时间和预测速度。

- ID3由于不能直接处理连续特征,需要对数据进行离散化处理,但其构建速度快。

- C4.5处理连续特征时采用分箱方法,准确率较高,但模型构建时间和预测速度相对较慢。

- CART模型对数据类型无特殊要求,能够直接处理连续变量,且模型构建和预测速度相对较快。

## 5.3 结合实际应用场景的决策树优化策略

### 5.3.1 多模型集成与决策树的结合

实际应用中,单一模型很难覆盖所有情况,多模型集成可以提升预测的准确性和鲁棒性。例如,使用随机森林(Random Forest)对多个CART决策树的预测结果进行综合。随机森林通过构建多个决策树并进行投票,可以有效降低模型的方差。

### 5.3.2 超参数调整与模型泛化能力提升

决策树模型的超参数调整对于模型性能的提升至关重要。例如,C4.5算法中的剪枝参数可以防止过拟合,而 CART 算法中的最大深度、最小样本分裂等参数可以控制树的复杂度。

```python

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import GridSearchCV

# 以CART算法为例,使用GridSearchCV进行超参数调优

parameters = {'max_depth': [3, 5, 7, 10], 'min_samples_split': [2, 5, 10]}

cart = DecisionTreeClassifier(criterion="gini")

clf = GridSearchCV(cart, parameters, cv=5)

clf.fit(X_train, y_train)

# 输出最佳参数及对应的最佳分数

print(f"Best parameters: {clf.best_params_}")

print(f"Best cross-validation score: {clf.best_score_}")

```

通过以上的分析和代码实践,我们可以看到,在面对不同的数据特性和业务需求时,选择合适的决策树算法,并进行必要的优化,可以极大提升模型的表现和应用效果。在实际工作中,我们还需要根据模型的效果进行迭代和调优,以获得最优的决策树模型。

0

0