深入探讨过拟合现象:神经网络正则化的最佳实践

发布时间: 2024-09-05 20:40:54 阅读量: 34 订阅数: 21

# 1. 过拟合现象概述

## 过拟合的定义和影响

过拟合是机器学习中常见的一个问题,特别是在深度学习领域。其定义是指模型对训练数据的学习过于精准,以至于它捕捉到了数据中的噪声和异常值,失去了泛化能力,导致在新的、未见过的数据上表现不佳。当模型过拟合时,它可能在训练集上表现得近乎完美,但在验证集和测试集上的表现却大打折扣。这种现象不仅浪费了模型的学习能力,也使得模型无法有效地用于实际预测。

## 识别过拟合的方法

识别过拟合最简单的方法是将数据集分为训练集、验证集和测试集。通过比较模型在训练集和验证集上的性能差异,可以初步判断是否存在过拟合。更进一步,绘制学习曲线也是一个有效的方法,即在训练过程中绘制训练损失和验证损失随时间的变化情况。如果训练损失持续降低,而验证损失开始上升或趋于平缓,这通常表明模型正在过拟合。另外,使用正则化技术,如L1、L2正则化和Dropout等,也有助于检测过拟合。这些技术通过限制模型复杂度来防止模型对数据的过度拟合。

# 2. 神经网络正则化理论

## 2.1 过拟合的理论基础

### 2.1.1 过拟合的定义和影响

在机器学习领域,过拟合是一个普遍存在的问题,尤其在深度学习模型中表现得尤为突出。过拟合指的是模型在训练数据上表现出极高的准确度,但对未见过的数据泛化能力差。这一现象通常是由于模型过于复杂,学习到了训练数据中的噪声和细节,而没有捕捉到数据背后的潜在规律。

过拟合导致模型在实际应用中性能下降,表现为在新的输入数据上预测能力差。在理想情况下,我们希望模型能够在训练数据上拥有良好的拟合能力,并且能够很好地泛化到新的数据上。由于过拟合的存在,模型的泛化能力被削弱,最终影响模型在实际问题中的应用价值。

### 2.1.2 识别过拟合的方法

识别过拟合通常依赖于几个核心的技术手段,包括但不限于:

1. **交叉验证**:将数据集分为训练集和验证集,训练模型在训练集上学习,同时在验证集上进行评估。如果模型在验证集上的表现明显低于训练集,这通常意味着过拟合的发生。

2. **学习曲线**:绘制训练集和验证集的损失或准确度随训练轮次变化的图表。如果两条曲线差距较大,尤其是在训练后期依然增大,可能表明过拟合。

3. **正则化指标**:正则化项的值(例如权重的L1或L2范数)如果非常高,往往意味着模型可能过于复杂,有过度拟合训练数据的风险。

过拟合不仅降低了模型的预测准确性,还可能导致模型在面对未来数据时作出不准确的预测,从而影响整个系统的稳定性和可靠性。因此,理解和识别过拟合是构建有效深度学习模型的重要一步。

## 2.2 正则化的理论框架

### 2.2.1 正则化的数学原理

正则化是解决过拟合问题的常用方法之一,其基本思想是在优化目标函数时引入额外的约束或惩罚项,以限制模型的复杂度。数学上,正则化可以表述为最小化损失函数加上一个正则化项的组合:

\[ J(\theta) = L(\theta; X, Y) + \lambda R(\theta) \]

其中,\( J(\theta) \) 是正则化后的损失函数,\( L(\theta; X, Y) \) 是无正则化下的损失函数,\( R(\theta) \) 是正则化项,而 \( \lambda \) 是正则化系数,用于平衡损失函数和正则化项。

正则化项通常包括L1正则化(权重的绝对值之和)和L2正则化(权重的平方和),它们能够有效地限制模型权重的大小,从而控制模型复杂度。

### 2.2.2 正则化与模型泛化能力

正则化对于提升模型的泛化能力有着至关重要的作用。模型在训练数据上的优化可能达到零损失,但过度优化可能导致模型无法泛化到新的、未见过的数据上。引入正则化项的目的是促使模型在保持对训练数据良好拟合的同时,限制模型复杂度,使模型能够更好地推广到新数据。

在实际应用中,通过调整正则化系数 \( \lambda \),可以在过拟合和欠拟合之间找到一个平衡点。例如,当 \( \lambda \) 过大时,模型可能会变得过于简单,导致欠拟合;相反,如果 \( \lambda \) 过小,则可能导致过拟合。

## 2.3 正则化技术的分类

### 2.3.1 L1和L2正则化

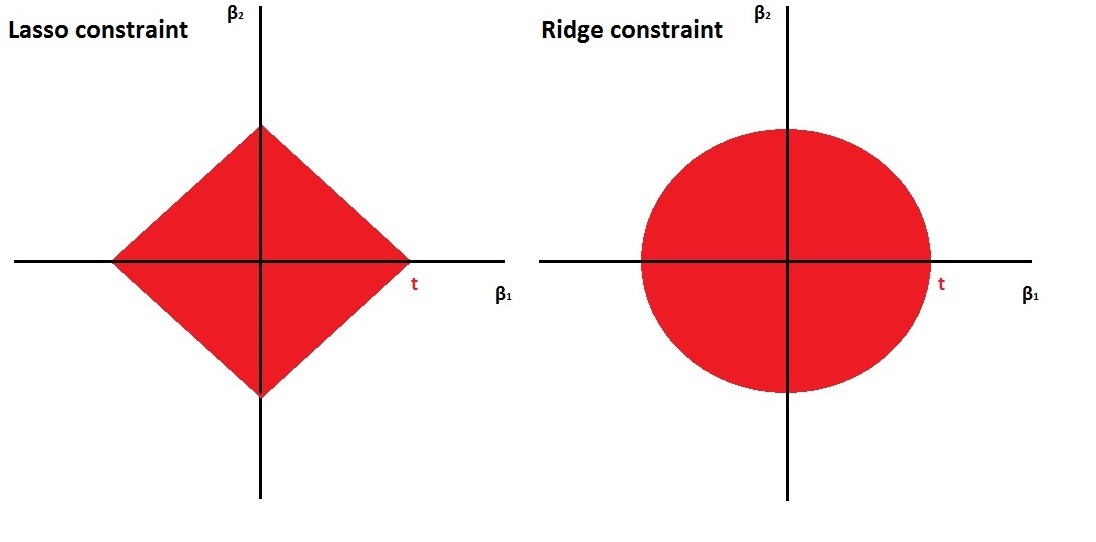

L1正则化和L2正则化是最常见的正则化方法,它们对权重向量的范数进行限制,从而抑制模型复杂度。

- **L1正则化** 强迫模型权重向量的各个分量倾向于零,从而产生稀疏权重矩阵。这种稀疏性可以用来进行特征选择,简化模型结构。

- **L2正则化** 趋于使模型权重向量的各个分量尽量小但不为零,这种方法能够使模型权重的分布更加平稳,对异常值和噪声具有一定的抵抗力。

代码示例:

```python

from sklearn.linear_model import Lasso, Ridge

# L1正则化模型

lasso = Lasso(alpha=0.1)

# L2正则化模型

ridge = Ridge(alpha=0.1)

# 用相同的数据训练模型

lasso.fit(X_train, y_train)

ridge.fit(X_train, y_train)

```

### 2.3.2 早停法(Early Stopping)

早停法是一种在训练过程中防止过拟合的简单而有效的方法。其基本思想是,在验证集上的性能开始恶化时停止训练。此方法不需要在模型训练后进行额外的正则化处理,而是直接在训练过程中进行。

代码示例:

```python

from sklearn.base import clone

# 假设model是已经定义好的模型

model = clone(some事先定义的模型)

# 分割数据为训练集和验证集

X_train, X_valid, Y_train, Y_valid = train_test_split(X, y, test_size=0.2)

# 初始化早停跟踪变量

patience = 10

best_score = -np.inf

counter = 0

for epoch in range(num_epochs):

model.fit(X_train, Y_train)

score = model.evaluate(X_valid, Y_valid)

if score > best_score:

best_score = score

counter = 0

else:

counter += 1

if counter == patience:

break

```

### 2.3.3 Dropout技术

Dropout是一种在神经网络训练时随机忽略一部分神经元的方法,它通过随机“丢弃”一些神经元来防止网络过于依赖特定的连接,从而提升泛化能力。Dropout可以视为在每次训练批次上构建一个稀疏网络,这促进了网络中的冗余特征学习,提高了网络的鲁棒性。

代码示例:

```python

from keras.layers import Dropout

from keras.models import Sequential

# 假设已有层定义好的模型,添加Dropout层

model = Sequential()

model.add(Dense(64, activation='relu', input_shape=(input_size,)))

model.add(Dropout(0.5)) # 添加Dropout层,丢弃50%的神经元

model.add(Dense(nu

```

0

0