文本挖掘中的ANOVA运用:从文本到统计分析的桥梁(数据处理高级教程)

发布时间: 2024-11-24 11:34:06 阅读量: 18 订阅数: 50

Java源码ssm框架的房屋租赁系统-合同-毕业设计论文-期末大作业.rar

# 1. 文本挖掘的基本原理和方法

## 1.1 文本挖掘的定义和发展

文本挖掘,也称为文本数据挖掘或文本知识发现,是从大量非结构化的文本数据中提取有价值信息和知识的过程。随着互联网和数字信息的爆炸性增长,文本挖掘已经成为信息检索和数据分析中不可或缺的一部分。在过去的几十年中,文本挖掘技术已从简单的关键词统计发展到复杂的自然语言处理技术。

## 1.2 文本挖掘的核心任务

文本挖掘的核心任务包括文本分类、聚类、实体识别、关系抽取等。这些任务依赖于机器学习和统计学习方法来识别和提取文本数据中的有用信息。文本分类是将文本数据分配到一个或多个类别中的过程;聚类则是将相似的文本自动聚集在一起,而不预先定义分类标准;实体识别旨在识别文本中的重要实体;关系抽取关注的是从文本中提取实体间的关系。

## 1.3 文本挖掘的方法论

实现文本挖掘的关键技术包含词频统计、主题模型、深度学习等多种方法。词频统计通过统计词的出现频率来反映文本的重要性和主题。主题模型如LDA(Latent Dirichlet Allocation)能够发现大量文档中的隐藏主题结构。而深度学习技术如卷积神经网络(CNN)和循环神经网络(RNN)已经显示出在文本表示和语义理解方面的强大能力。接下来的章节将详细探讨这些方法在实际应用中的原理和操作。

# 2. ANOVA的理论基础和应用

## 2.1 ANOVA的基本概念和原理

### 2.1.1 ANOVA的定义和作用

方差分析(ANOVA,Analysis of Variance)是一种统计方法,用于检验三个或三个以上样本均值是否存在显著差异。它是由R. A. Fisher在20世纪20年代提出的,用于处理实验设计中变量的平均数分析。ANOVA通过将数据的总变异分解为可归因于不同因素或因素之间交互作用的部分来评估组间差异,与t检验相比,ANOVA能够同时比较多个独立样本的均值差异。

ANOVA的作用不仅限于单一的比较。它能帮助我们理解数据之间的关联性,以及这些关系是否具有统计学上的显著性。在实际应用中,ANOVA是研究变量间关系、检验假设、进行实验设计和数据分析的重要工具。

### 2.1.2 ANOVA的主要类型和应用场景

ANOVA有多种类型,根据研究设计的不同,可以分为以下几种:

- 单因素ANOVA(One-Way ANOVA):研究一个独立变量对一个因变量的影响。

- 双因素ANOVA(Two-Way ANOVA):研究两个独立变量对因变量的影响,以及它们之间是否存在交互作用。

- 多因素ANOVA(Multi-Way ANOVA):研究两个以上的独立变量对因变量的影响,以及变量间的交互作用。

- 重复测量ANOVA(Repeated Measures ANOVA):用于在相同实验对象上进行多次测量的情况。

应用场景包括:

- 医学研究中,评估不同治疗方案对病人的影响。

- 心理学实验中,分析不同实验条件对被试者行为的影响。

- 市场营销中,测试不同广告策略对消费者购买决策的作用。

- 教育研究中,评估不同教学方法对学生学习成效的影响。

## 2.2 ANOVA的计算方法和步骤

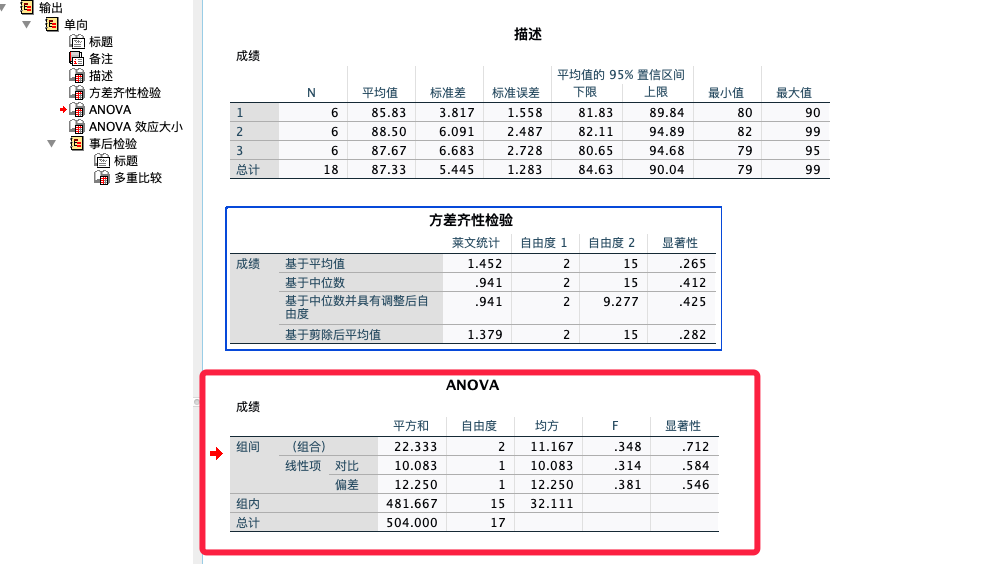

### 2.2.1 F值的计算和解读

F值是ANOVA的核心,用于衡量组间差异与组内差异的比值。计算F值的步骤如下:

1. 计算组间平方和(SSB,Sum of Squares Between-groups):衡量不同组均值之间的差异。

2. 计算组内平方和(SSW,Sum of Squares Within-groups):衡量组内个体值与组均值的差异。

3. 计算组间均方(MSB,Mean Square Between-groups)和组内均方(MSW,Mean Square Within-groups)。

4. 计算F值:F = MSB / MSW。

解读F值:

- 如果F值较小,意味着组间差异不大于组内差异,接受原假设(即不同组的均值相等)。

- 如果F值较大,则意味着组间差异大于组内差异,拒绝原假设,即不同组均值存在显著差异。

### 2.2.2 Post Hoc测试的原理和选择

Post Hoc测试是在ANOVA分析显示至少有一组均值与其他组存在显著差异后,进一步进行的事后多重比较测试。其原理是为了确定具体哪些组之间的均值存在显著差异。常见的Post Hoc测试有:

- Tukey's HSD(Honestly Significant Difference)

- Bonferroni correction

- Scheffé's method

- Dunnett's test

选择Post Hoc测试时,应考虑样本量、组数、数据特性等因素。例如,Tukey's HSD适用于组数较多时;Bonferroni correction在组数较少时更保守;Scheffé's method适用于复杂的多重比较;Dunnett's test专门用于比较对照组与其他各组。

## 2.3 ANOVA在文本挖掘中的应用实例

### 2.3.1 文本数据的预处理和转换

在文本挖掘中,数据预处理是至关重要的一步,确保数据分析的准确性和有效性。在进行ANOVA之前,文本数据需要经历以下预处理和转换步骤:

1. **文本清洗**:去除停用词、标点符号和非相关文本,例如HTML标签或特殊字符。

2. **分词**:将文本分割成词或词组。

3. **词干提取**:将词还原到词根形式。

4. **向量化**:将文本转化为数值形式,例如词频-逆文档频率(TF-IDF)或词袋模型(Bag of Words)。

### 2.3.2 ANOVA在文本分类和聚类中的应用

在文本数据经过预处理和转换后,可以应用ANOVA进行分类和聚类分析。

- **文本分类**:将文档按照类别进行分组,使用ANOVA来检验各类别中不同特征(如关键词)的频率分布是否存在显著差异。

- **文本聚类**:未标记数据的分组,使用ANOVA来分析不同聚类中心间的特征是否存在显著差异。

具体操作步骤如下:

1. 使用TF-IDF或词袋模型对文档进行向量化处理。

2. 通过ANOVA分析不同类别或聚类中心在特定特征上的均值是否存在统计学上的显著差异。

3. 根据ANOVA结果对文本数据进行更进一步的分析和解释。

接下来,我们可以用一个具体的示例来展示ANOVA在文本挖掘中的应用。

### 示例:使用ANOVA分析社交媒体中的用户评论情感

假设我们收集了一些社交媒体上的用户评论数据,并想要根据用户对产品的不同情感倾向(正面、中性、负面)来分析评论文本。首先,我们需要对评论文本进行预处理,然后使用ANOVA来检验不同情感倾向的评论在某些特定词汇的使用频率上是否存在显著差异。

以下是该示例的简化流程:

1. 文本清洗:去除所有非关键词,如停用词、URL、特殊符号等。

2. 向量化处理:使用TF-IDF模型将清洗后的文本转换为数值型数据。

3. 应用ANOVA分析:检验情感倾向(正面、中性、负面)在特定词汇(如产品名称、正面情感词、负面情感词)的TF-IDF均值是否存在统计学上的显著差异。

```python

from sklearn.feature_extraction.text import TfidfVectorizer

from scipy.stats import f_oneway

# 假设`data`是一个包含处理过的评论文本的列表

# 情感标签:正面、中性、负面

emotions = ['positive', 'neutral', 'negative']

# 分别从每个情感类别的评论中选取一定数量的样本

texts = {

'positive': [data[i] for i in range(len(data)) if labels[i] == 'positive'],

'neutral': [data[i] for i in range(len(data)) if labels[i] == 'neutral'],

'negative': [data[i] for i in range(len(data)) if labels[i] == 'negative']

}

# 向量化处理

vectorizer = TfidfVectorizer()

tfidf_matrix = vectorizer.fit_transform(texts['positive'] + texts['neutral'] + texts['negative'])

# 提取每个情感类别的TF-IDF矩阵

tfidf_positive = tfidf_matrix[:len(texts['positive'])]

tfidf_neutral = tfidf_matrix[len(texts['positive']):len(texts['positive']) + len(texts['neutral'])]

tfidf_negative = tfidf_matrix[len(texts['positive']) + len(texts['neutral']):]

# 应用ANOVA

# 假设我们关注的关键词是"good"和"bad"

good_tfidf = tfidf_matrix[:, vectorizer.vocabulary_['good']]

bad_tfidf = tfidf_matrix[:, vectorizer.vocabulary_['bad']]

# 对每个关键词进行ANOVA分析

f_value_good, p_value_good = f_oneway(good_tfidf[0:len(texts['positive'])],

good_tfidf[len(texts['positive']):len(texts['positive']) + len(texts['neutral'])],

good_tfidf[len(texts['positive']) + len(texts['neutral']):])

f_value_bad, p_value_bad = f_oneway(bad_tfidf[0:len(texts['positive'])],

bad_tfidf[len(texts['positive']):len(texts['positive']) + len(texts['neutral'])],

bad_tfidf[len(texts['positive']) + len(texts['neutral']):])

print(f'ANOVA结果: {"good":>10} {"bad":>10}')

print(f'F值: {f_value_good:10.4f} {f_value_bad:10.4f}')

print(f'P值: {p_value_good:10.4f} {p_value_bad:10.4f}')

```

在这段代码中,我们首先使用`TfidfVectorizer`将文本数据转换为TF-IDF向量形式,然后分别提取正面、中性和负面评论文本的TF-IDF矩阵。之后,我们选取了关键词"good"和"bad"作为变量进行ANOVA分析。最终输出的F值和P值将帮助我们判断不同情感倾向的评论是否在这些关键词的使用频率上存在显著差异。

### 实际操作步骤:

1. **准备数据**:搜集社交媒体上的用户评论并标注情感倾向。

2. **文本清洗**:使用Python库如`nltk`进行文本的分词、去停用词等。

3. **向量化**:应用`TfidfVectorizer`转换文本数据。

4. **执行ANOVA**:使用`scipy.stats.f_oneway`函数进行统计分析。

5. **结果解读**:根据F值和P值判断情感差异的显著性。

本例展示了ANOVA在文本挖掘中的一个应用实例,可以帮助分析用户在社交媒体上的评论情感,从而为企业提供市场决策支持。通过进一步的数据探索和分析,我们能够深入了解用户的需求和对产品的看法,这对于产品改进和市场策略制定具有重要意义。

# 3. 文本挖

0

0