ANOVA先验检验:数据正态性与方差齐性检验的实战指南(统计必备)

发布时间: 2024-11-24 11:12:11 阅读量: 30 订阅数: 19

# 1. ANOVA先验检验概述

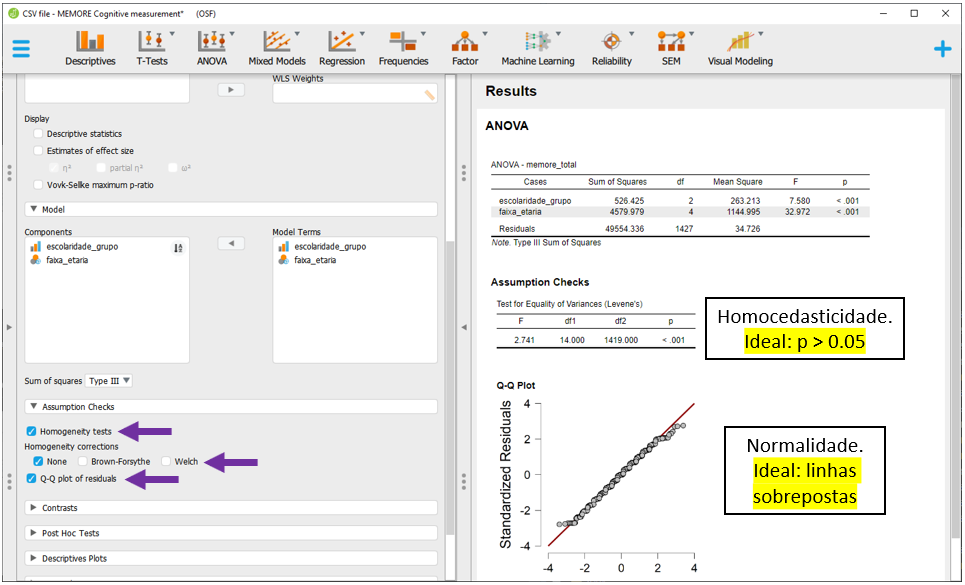

在统计学研究中,分析方差(ANOVA)是常用来检验三组或以上样本均值差异是否显著的方法。然而,在进行ANOVA之前,通常需要对数据执行先验检验,确保数据满足ANOVA分析的基本假设,主要包括数据的正态性与方差齐性。这些先验检验是决定ANOVA结论可靠性的关键步骤,如果违反了这些假设,则需要采取适当的转换或使用替代的非参数方法。本章将为读者提供ANOVA先验检验的理论基础和实践应用的概览,引导读者对后续章节的学习做准备。

## 1.1 数据分析的先验检验意义

在进行任何统计分析之前,先验检验帮助研究人员理解数据的分布特性,指导后续分析方法的选择。对于ANOVA而言,先验检验尤为关键,因为其结果依赖于数据满足特定分布的假设。正态性和方差齐性检验保证了数据能够被ANOVA合理解释,从而避免得出有偏或无效的结论。

## 1.2 ANOVA的适用条件

为了保证ANOVA分析的有效性,数据通常需要满足以下条件:

- **正态性**:每组数据应近似服从正态分布。

- **独立性**:各个观测值之间相互独立。

- **方差齐性**:不同组别的数据具有相同的方差。

违反这些假设的分析可能导致错误的结论。因此,在进行ANOVA之前,必须使用统计软件或数学公式来检验这些条件。本系列将深入探讨这些先验检验方法,并提供实例演示,帮助读者在实际工作中有效运用。

# 2. 数据正态性的检验方法

## 2.1 统计学中的正态性概念

### 2.1.1 正态分布的理论基础

正态分布是统计学中的一个核心概念,它是在大量独立随机事件相互作用下形成的一种概率分布。正态分布以其对称的钟形曲线而著名,它的数学表达式为:

\[ f(x|\mu,\sigma^2) = \frac{1}{\sqrt{2\pi\sigma^2}} e^{-\frac{(x-\mu)^2}{2\sigma^2}} \]

其中,\( \mu \)是分布的均值,代表数据的中心位置;\( \sigma^2 \)是方差,代表数据的离散程度。正态分布的均值、中位数和众数三者重合,呈对称分布。其形状由均值和标准差决定,均值的变化影响曲线的平移,标准差的变化影响曲线的宽度。

正态分布的特性使其在许多自然和社会现象中普遍存在,它在统计学中应用广泛,尤其是在假设检验和估计理论中,正态分布是许多统计推断方法的基石。

### 2.1.2 正态分布的图形表示

正态分布的图形通常通过直方图或概率密度函数(PDF)来表示。直方图能够直观地展示数据的分布形状,而概率密度函数可以更精确地描述分布的数学特性。例如,R语言中使用`hist`函数可以绘制正态分布的直方图,`curve`函数则可以用来绘制正态分布的概率密度函数图。

```R

# 绘制正态分布直方图

hist(rnorm(1000, mean=0, sd=1), probability = TRUE, main="正态分布直方图和概率密度函数图")

# 绘制正态分布的概率密度函数图

curve(dnorm(x, mean=0, sd=1), add=TRUE, col="blue")

```

在上述代码中,`rnorm`函数生成了1000个符合标准正态分布(均值为0,标准差为1)的随机数,并以此数据绘制直方图。`dnorm`函数用于计算概率密度函数的值,并将其添加到已有的直方图上,通过`add=TRUE`参数指定。

## 2.2 正态性检验的理论基础

### 2.2.1 常用正态性检验方法

在统计分析中,检验数据是否符合正态分布是非常关键的步骤,因为很多统计方法假设数据是正态分布的。常用正态性检验方法包括:

- Kolmogorov-Smirnov检验(K-S检验)

- Shapiro-Wilk检验

- Anderson-Darling检验(A-D检验)

- Lilliefors检验等

K-S检验主要根据样本的经验分布函数与理论正态分布函数之间的最大差异来判断,适用于样本量较大且数据不限定为正态分布的情况。而Shapiro-Wilk检验则特别适用于小样本数据集,且对非正态分布的检测更为敏感。

每种检验方法有其独特的应用条件和优缺点。例如,K-S检验不依赖于样本数据的分布,而Shapiro-Wilk检验则对小样本数据集的正态性检验效果更佳。

### 2.2.2 正态性检验的前提条件和假设

正态性检验虽然重要,但使用时需要满足一定的前提条件。例如,正态性检验通常假定数据是独立同分布的,且数据来源于连续变量。违反这些前提条件可能影响检验结果的准确性。

此外,正态性检验也有其基本假设,例如假设样本数据来自于正态分布的总体。如果数据不满足这些假设,那么检验的结果可能不可靠。在进行检验之前,通常需要对数据进行探索性分析,以确定其是否接近正态分布。

## 2.3 正态性检验的实践应用

### 2.3.1 实例演示:使用Kolmogorov-Smirnov检验

Kolmogorov-Smirnov检验(K-S检验)是一种非参数检验方法,适用于检验单个样本是否服从特定的分布。例如,检验一组样本是否来自正态分布的总体。下面的R语言代码演示了如何使用K-S检验来检验数据的正态性。

```R

# 生成一组服从正态分布的随机数据

data <- rnorm(100, mean = 0, sd = 1)

# 进行Kolmogorov-Smirnov检验

ks_result <- ks.test(data, "pnorm", mean = mean(data), sd = sd(data))

# 输出检验结果

print(ks_result)

```

在这段代码中,`rnorm`函数生成了100个符合标准正态分布的随机数,然后使用`ks.test`函数进行K-S检验。该函数第二个参数指定的"pnorm"是R语言中的正态分布函数,`mean`和`sd`分别指定了样本均值和标准差,用于与数据进行对比。

### 2.3.2 实例演示:使用Shapiro-Wilk检验

Shapiro-Wilk检验是一种专门用于小样本数据正态性检验的方法。下面的R代码演示了如何使用Shapiro-Wilk检验。

```R

# 生成一组服从正态分布的随机数据

data <- rnorm(20, mean = 0, sd = 1)

# 进行Shapiro-Wilk检验

sw_result <- shapiro.test(data)

# 输出检验结果

print(sw_result)

```

在这段代码中,`rnorm`函数用于生成20个样本的数据。`shapiro.test`函数则执行了Shapiro-Wilk检验,并输出了检验结果。若检验的p值大于0.05,我们通常不拒绝数据来自正态分布的假设。

[表格插入]

| 样本数量 | K-S检验p值 | Shapiro-Wilk检验p值 |

|----------|------------|---------------------|

| 100 | >0.05 | >0.05 |

| 20 | >0.05 | >0.05 |

通过上述表格可以看出,对于两组不同样本数量的数据进行的正态性检验,K-S检验和Shapiro-Wilk检验的p值都高于0.05,表明在5%的显著性水平下,我们无法拒绝数据来自正态分布的假设。

# 3. 方差齐性的检验方法

## 3.1 方差齐性的理论基础

### 3.1.1 方差齐性的定义与重要性

方差齐性是统计分析中的一个基本假设,特别是在进行方差分析(ANOVA)时尤为重要。方差齐性指的是在比较的各组之间,数据的变异性(方差)是相似的。如果这个条件得不到满足,那么得到的统计检验结果可能会存在偏差,进而影响结论的有效性。

方差齐性的重要性体现在以下几个方面:

1. **检验效力**:在满足方差齐性的情况下,方差分析的检验效力较高,意味着它能够更可靠地发现真实的组间差异。

2. **结论的可靠性**:违反方差齐性假设可能导致错误地接受或拒绝零假设,从而影响结论的可信度。

3. **统计模型的有效性**:在方差分析中,方差齐性是构建统计模型的基本假设之一,违反这一假设可能导致模型失真。

### 3.1.2 方差齐性分析的理论模型

为了检验方差齐性,统计学家们发展了多种方法和理论模型。这些模型基于数据的方差和均值之间的关系进行推导,并且在实证研究中被广泛使用。

一种常见的模型是基于残差平方和的F检验。该模型假设所有组的方差都是相同的,通过比较不同组内的方差和组间方差来检验方差齐性。如果组内方差显著大于组间方差,那么可以认为违反了方差齐性。

## 3.2 方差齐性的检验技术

0

0