Hadoop大数据处理实战指南:从原理到应用,掌握大数据处理技术

发布时间: 2024-07-14 01:05:08 阅读量: 59 订阅数: 50

大数据处理与MySQL:技术原理及实战指南

# 1. Hadoop大数据处理概述

Hadoop是一个开源的分布式数据处理框架,旨在处理海量数据。它提供了一个可扩展、可靠且经济高效的平台,用于存储、处理和分析大数据。Hadoop由Apache软件基金会开发,已成为大数据处理领域的行业标准。

Hadoop生态系统由多个组件组成,包括分布式文件系统(HDFS)、数据处理引擎(MapReduce)和一系列辅助工具。HDFS负责存储和管理大数据,而MapReduce提供了一种并行处理数据的方法。其他组件,如Hive和HBase,扩展了Hadoop的功能,使其能够执行数据仓库、分布式数据库和其他高级分析任务。

# 2. Hadoop生态系统与组件详解

Hadoop生态系统是一个庞大且相互连接的组件集合,共同协作以提供一个完整的分布式数据处理平台。本节将深入探讨Hadoop生态系统中的关键组件,包括HDFS、MapReduce和其他辅助组件。

### 2.1 Hadoop分布式文件系统(HDFS)

#### 2.1.1 HDFS架构和原理

HDFS是一个分布式文件系统,专为存储和管理海量数据而设计。它采用主从架构,其中一个NameNode负责管理文件系统元数据,而多个DataNode负责存储实际数据。

NameNode维护文件系统命名空间和文件块位置信息。当客户端写入或读取文件时,它会与NameNode交互以获取数据块的位置。DataNode负责存储数据块并响应客户端的读写请求。

#### 2.1.2 HDFS文件存储和管理

HDFS将文件存储为数据块,默认大小为128MB。数据块分布在多个DataNode上,以实现数据冗余和容错性。HDFS采用复制机制,默认情况下将每个数据块复制3次,以确保即使一个或多个DataNode发生故障,数据也不会丢失。

HDFS还支持文件分块,允许客户端将大文件分解为更小的块。这使得并行处理和数据局部性成为可能,从而提高了性能。

### 2.2 Hadoop MapReduce编程模型

#### 2.2.1 MapReduce工作原理

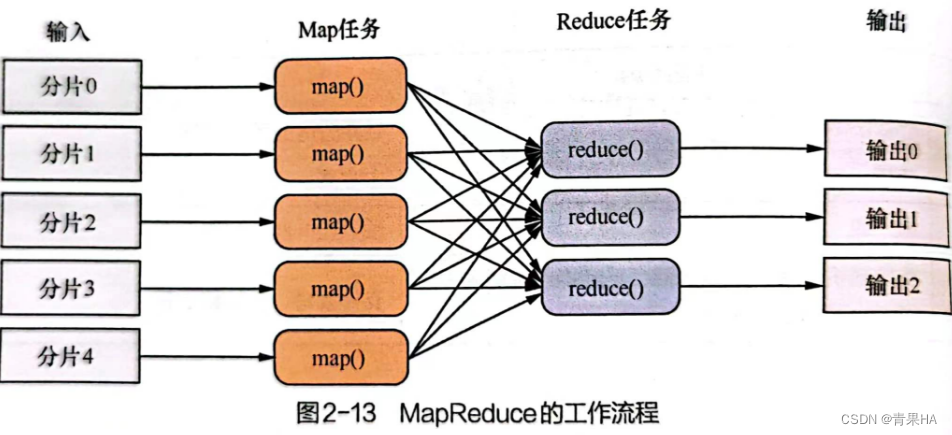

MapReduce是一种编程模型,用于处理大规模数据集。它将计算任务分解为两个阶段:

- **Map阶段:**将输入数据映射到一组键值对。

- **Reduce阶段:**对每个键的关联值进行聚合或处理。

MapReduce框架负责将任务调度到集群中的节点上,并管理数据流和容错处理。

#### 2.2.2 MapReduce编程实践

编写MapReduce程序需要实现两个接口:Mapper和Reducer。Mapper负责将输入数据映射到键值对,而Reducer负责处理每个键的关联值。

MapReduce程序通常使用以下步骤:

1. 定义Mapper类,实现map()方法。

2. 定义Reducer类,实现reduce()方法。

3. 编写Driver类,配置作业并提交到集群。

### 2.3 Hadoop生态系统其他组件

除了HDFS和MapReduce之外,Hadoop生态系统还包括其他组件,以提供额外的功能和服务:

#### 2.3.1 Hive数据仓库

Hive是一个基于SQL的数据仓库,允许用户查询和分析存储在HDFS中的数据。它提供了类似于传统关系数据库的接口,简化了对大数据的查询和分析。

#### 2.3.2 HBase分布式数据库

HBase是一个分布式、面向列的数据库,专为存储和管理大规模、稀疏的数据而设计。它提供快速、可扩展的读写访问,非常适合存储时间序列数据和社交网络数据。

# 3.1 数据清洗与预处理

**3.1.1 数据清洗技术**

数据清洗是将原始数据转换为可用于分析和挖掘的高质量数据的过程。它涉及识别和纠正数据中的错误、不一致和缺失值。常用的数据清洗技术包括:

- **数据验证:**检查数据是否符合预定义的规则和约束,例如数据类型、范围和格式。

- **数据去重:**识别并删除重复的数据记录。

- **数据转换:**将数据从一种格式转换为另一种格式,例如从文本到数字或从日期到时间戳。

- **数据填充:**使用统计方法或业务规则填充缺失值。

- **数据标准化:**将数据转换为一致的格式,例如将所有日期转换为相同的格式或将所有货币转换为相同的单位。

**3.1.2 数据预处理方法**

数据预处理是将数据转换为适合分析和挖

0

0