GANs模型调优:提升生成图像质量和多样性的专家建议

发布时间: 2024-11-20 20:34:54 阅读量: 60 订阅数: 40

花朵数据集-用于训练各种类型的生成模型

# 1. GANs模型简介及原理

## 1.1 GANs模型背景

生成对抗网络(Generative Adversarial Networks,简称GANs)是由Ian Goodfellow于2014年提出的一种深度学习模型。GANs的核心思想是通过两个网络的对抗学习来生成新的数据样本,这个过程类似于两个玩家的博弈,一个生成数据(Generator),另一个判别数据(Discriminator)。

## 1.2 GANs的工作机制

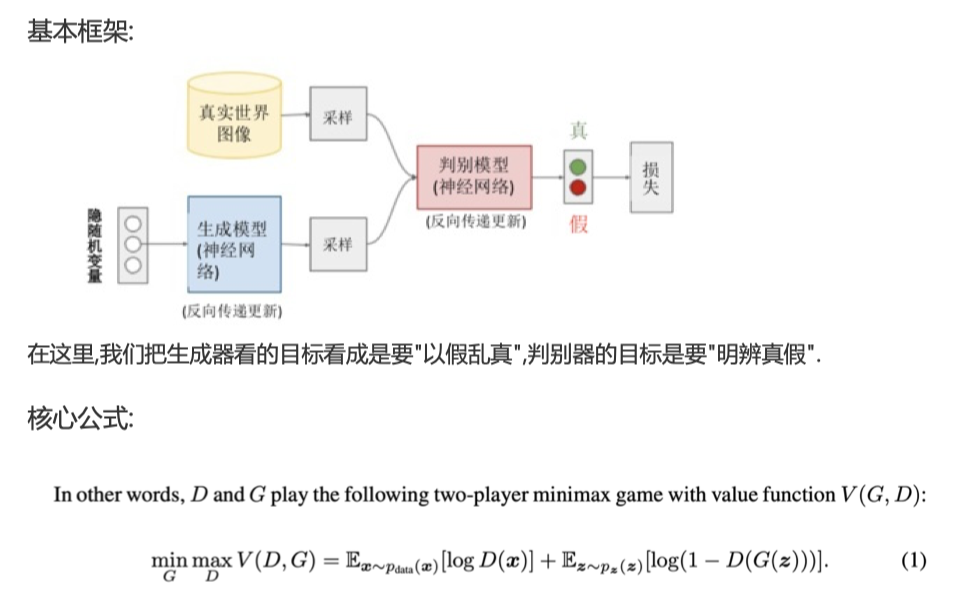

GANs的工作机制本质上是将生成器和鉴别器放在一个动态的对抗过程中。生成器尝试生成越来越真实的数据以欺骗鉴别器,而鉴别器则不断学习如何更好地辨别真实数据和生成数据。这种对抗机制使得生成器不断提高其生成数据的质量。

## 1.3 GANs的基本原理

在数学和计算的角度,GANs通过一个优化问题来训练,即最小化生成器和鉴别器之间的差异。这一过程主要通过梯度下降算法,不断调整两个网络的参数,直到生成器生成的数据足够逼真,以至于鉴别器无法有效区分。

```python

# 伪代码说明GANs的训练过程

while training:

# 训练鉴别器

real_data = load_real_samples()

fake_data = generator(noise)

discriminator_loss = train_discriminator(real_data, fake_data)

# 训练生成器

noise = generate_noise()

generator_loss = train_generator(discriminator, noise)

# 更新模型参数

update_model_parameters(discriminator, generator)

```

在这个伪代码中,`train_discriminator`和`train_generator`分别表示训练鉴别器和生成器的过程,它们通过梯度下降更新参数。生成器生成的假数据和真实数据被用来训练鉴别器,而生成器则被训练去欺骗鉴别器。

GANs模型的应用正不断扩大,从最初的图像生成扩展到语音合成、文本生成等多个领域,它的灵活性和创新性在不断地推动着AI技术的发展。

# 2. GANs模型结构深度解析

## 2.1 GANs基本模型架构

### 2.1.1 发电机和鉴别器的基本概念

生成对抗网络(GANs)由两个主要部分构成:发电机(Generator)和鉴别器(Discriminator)。发电机的目标是生成尽可能接近真实数据分布的新数据,而鉴别器的目标则是区分生成数据与真实数据,即准确识别哪个样本是真实数据,哪个是生成器创造的假数据。

发电机通过接收一个随机噪声向量作为输入,并将其转化为接近真实数据的输出。鉴别器通常采用二分类器的形式,它对数据来源进行二元判断,即输入的数据是真实数据还是由发电机生成的假数据。

在训练过程中,发电机和鉴别器相互竞争,发电机尝试通过学习欺骗鉴别器来生成越来越真实的数据,而鉴别器则努力提高其判别能力,以减少被欺骗的次数。这种对抗机制是GANs成功的关键。

### 2.1.2 损失函数与训练目标

GANs的训练过程涉及两个损失函数:一个是鉴别器的损失函数,另一个是发电机的损失函数。鉴别器的损失函数旨在最大化区分真实数据与生成数据的概率,而发电机的损失函数则希望最小化鉴别器区分出生成数据的概率。

在原版GANs中,通过博弈论中的纳什均衡来实现这一目标。具体来说,发电机与鉴别器的损失函数通常定义为对数损失:

```python

# 伪代码:损失函数定义

# Generator Loss

def generator_loss(fake_output):

return -log(sigmoid(fake_output))

# Discriminator Loss

def discriminator_loss(real_output, fake_output):

real_loss = -log(sigmoid(real_output))

fake_loss = -log(1 - sigmoid(fake_output))

total_loss = real_loss + fake_loss

return total_loss

```

在此基础上,训练目标是使鉴别器和发电机的损失函数达到平衡,使得生成数据在鉴别器眼中越来越难以与真实数据区分。

## 2.2 GANs变种模型详解

### 2.2.1 DCGAN的改进与特点

深度卷积生成对抗网络(Deep Convolutional Generative Adversarial Network,简称DCGAN)是GANs的一个重要改进,它通过引入深度卷积网络架构来提高生成图片的质量和稳定性。

DCGAN的几个关键特点包括:

- 使用卷积层替代全连接层,以减少参数数量并保持图像的空间结构信息。

- 使用批量归一化(Batch Normalization)来稳定训练过程。

- 仅使用卷积层来构建鉴别器和发电机,这样可以提供更深层的网络结构。

下面是DCGAN的简化伪代码结构:

```python

# DCGAN结构伪代码

class Discriminator(nn.Module):

def __init__(self):

super(Discriminator, self).__init__()

self.conv = nn.Sequential(...)

def forward(self, x):

return self.conv(x)

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc = nn.Sequential(...)

def forward(self, x):

return self.fc(x)

```

### 2.2.2 StyleGAN的创新点与架构

StyleGAN(Style Generative Adversarial Networks)是GANs中的一种先进架构,它在DCGAN的基础上引入了风格控制的概念。StyleGAN通过控制潜在空间(latent space)中的风格表示(style representations)来控制生成图像的样式。

主要的创新点包括:

- 映射网络(Mapping Network):将输入的潜在向量Z映射到可学习的潜在向量W,增加潜在空间的灵活性。

- 使用AdaIN(Adaptive Instance Normalization)来控制样式。

- 具有多个生成层,每层处理图像的不同部分。

```mermaid

graph TD

A[Latent Code Z] -->|映射网络| B[Potential Space W]

B --> C[生成层1]

B --> D[生成层2]

B --> E[生成层3]

C -->|AdaIN| F[图像特征1]

D -->|AdaIN| G[图像特征2]

E -->|AdaIN| H[图像特征3]

F --> I[最终图像]

G --> I

H --> I

```

### 2.2.3 其他流行的GANs变种对比

除了DCGAN和StyleGAN,还有许多其他流行的GANs变种,它们在不同的应用场景中有着卓越的表现。例如,Conditional GAN(CGAN)允许条件化控制生成的图像,Progressive GAN(PGGAN)通过逐步增长网络结构来生成高分辨率图像,BigGAN则是在大型数据集上表现出色的模型。

下面是这些模型的简要对比表:

| 模型名称 | 关键创新点 | 应用场景 | 优缺点分析 |

| -------------- | ------------------------------------------ | ----------------------------------- | ---------------------------------------------- |

| DCGAN | 卷积层,批量归一化 | 图像生成 | 稳定性强,但生成图片分辨率较低 |

| StyleGAN | 风格控制,多生成层 | 高分辨率图像,风格迁移 | 能力强大,但训练复杂且模型尺寸庞大 |

| CGAN | 条件化输入 | 条件控制下的图像生成 | 结果质量依赖于标签质量,训练数据需要配对标签 |

| PGGAN | 逐步增长网络结构 | 高分辨率图像 | 模型稳定,但训练成本高,需要特定的训练策略 |

| BigGAN | 大规模训练,自注意力机制 | 大规模数据集,高质量图像生成 | 生成效果好,但需要大量计算资源和数据集 |

## 2.3 模型训练过程的关键技术

### 2.3.1 初始化策略与权重裁剪

在GANs的训练过程中,适当的参数初始化策略对于模型的收敛至关重要。权重裁剪(Weight Clipping)是早期GANs中使用的一种策略,通过将权重限制在特定的范围内,避免训练过程中的梯度爆炸或消失问题。然而,这种方法并不总是最佳选择,特别是在DCGAN和之后的改进模型中,更倾向于使用批量归一化(Batch Normalization)来保持层间分布的一致性。

### 2.3.2 批量归一化与标签平滑技巧

批量归一化(Batch Normalization)是提高GANs训练稳定性的关键技术之一。它通过归一化网络中各层的输入,使数据分布在训练过程中保持稳定性,这有助于模型更好地学习特征并加快收敛速度。而标签平滑(Labe

0

0