GANs在自然语言处理中的潜力与挑战:深入探讨

发布时间: 2024-11-20 21:05:48 阅读量: 6 订阅数: 16

# 1. 自然语言处理与生成对抗网络(GANs)简介

## 1.1 概述

自然语言处理(NLP)是计算机科学和语言学领域的一个分支,旨在使计算机能够理解人类语言。近年来,生成对抗网络(GANs)的出现为解决NLP中的若干难题提供了新的视角。

## 1.2 生成对抗网络(GANs)简介

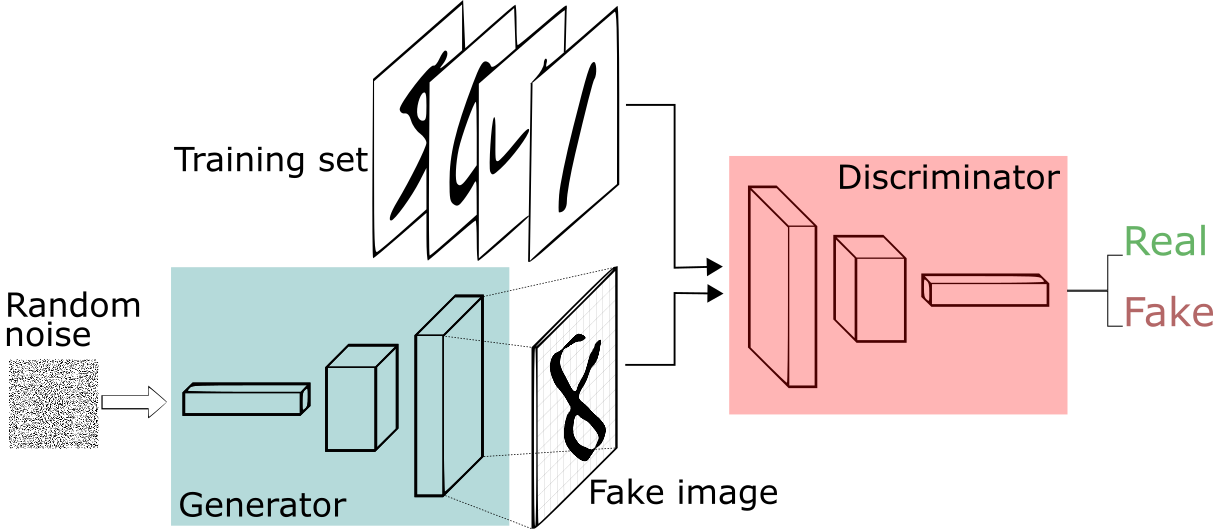

GANs是由Ian Goodfellow在2014年提出的一种深度学习模型,它由一个生成器(Generator)和一个判别器(Discriminator)组成,两者在训练过程中相互竞争、相互促进。在NLP领域,GANs能够生成高质量、连贯的文本数据,从而扩展了传统NLP方法的局限性。

## 1.3 GANs在NLP中的潜力

随着研究的深入,GANs在NLP中的潜力逐渐显现。例如,在机器翻译、自动摘要、对话系统等领域,GANs已经展示出了其在提高文本生成质量和多样性方面的优势。尽管存在挑战,GANs为NLP的发展开辟了新的可能性。

# 2. GANs在自然语言处理中的理论基础

## 2.1 生成对抗网络(GANs)的工作原理

### 2.1.1 GANs的结构和关键组成

生成对抗网络(GANs)由两个主要的神经网络组成:生成器(Generator)和判别器(Discriminator)。生成器的任务是产生尽可能接近真实数据分布的假数据,而判别器则需要区分真实数据和生成器产生的假数据。这两个网络在训练过程中相互对抗,生成器不断改进以产生更加逼真的数据,而判别器则提高自己辨别真伪的能力。

在结构上,GANs通常包含一个隐空间(Latent Space),用于采样和生成新的数据点。生成器从这个隐空间中接收一个随机噪声作为输入,并通过其网络结构将噪声转换成数据空间中的点。判别器则接收数据点(无论来自生成器还是真实数据集),并输出该点属于真实数据集的概率。

```python

# 伪代码展示GANs的生成器网络结构

def generator(z):

# z是来自隐空间的噪声样本

x = dense_layer(z, units=128, activation='relu') # 全连接层

x = dense_layer(x, units=256, activation='relu')

x = dense_layer(x, units=512, activation='relu')

output = output_layer(x) # 输出层,生成假数据

return output

```

```python

# 伪代码展示GANs的判别器网络结构

def discriminator(X):

# X是输入的数据点,可以是真实数据或生成器产生的假数据

x = dense_layer(X, units=512, activation='relu') # 全连接层

x = dense_layer(x, units=256, activation='relu')

x = dense_layer(x, units=128, activation='relu')

output = sigmoid_layer(x) # 输出层,概率值表示为真实数据的概率

return output

```

### 2.1.2 GANs的学习过程和优化策略

GANs的训练过程是一个动态平衡的过程。生成器尝试产生越来越逼真的数据以欺骗判别器,而判别器则试图越来越准确地识别出真实数据和假数据。这个过程可以用一个二人零和博弈(Minimax game)来模拟,其中生成器和判别器的目标函数是相反的。

优化策略对于训练稳定的GANs至关重要。常见的策略包括:

- **梯度惩罚(Gradient Penalty)**:通过对判别器施加额外的梯度惩罚项,来避免梯度消失或爆炸的问题。

- **Wasserstein损失**:使用Wasserstein距离作为损失函数,有助于缓解模式崩溃问题。

- **学习率调度**:调整学习率,使模型在训练过程中更好地收敛。

```python

# 伪代码展示使用梯度惩罚的GANs损失函数

def generator_loss(fake_output):

return -torch.mean(fake_output)

def discriminator_loss(real_output, fake_output, gradient_penalty):

real_loss = -torch.mean(real_output)

fake_loss = torch.mean(fake_output)

return real_loss + fake_loss + gradient_penalty

# 梯度惩罚项的计算

def gradient_penalty_term(D, real_data, fake_data):

alpha = torch.rand(batch_size, 1)

interpolates = alpha * real_data + ((1 - alpha) * fake_data)

interpolates = torch.autograd.Variable(interpolates, requires_grad=True)

D_interpolates = D(interpolates)

gradients = torch.autograd.grad(outputs=D_interpolates, inputs=interpolates,

grad_outputs=torch.ones(D_interpolates.size()),

create_graph=True, retain_graph=True, only_inputs=True)[0]

gradient_penalty = ((gradients.norm(2, dim=1) - 1) ** 2).mean() * lambda_value

return gradient_penalty

```

## 2.2 自然语言处理(NLP)的核心概念

### 2.2.1 NLP的预处理和特征表示

自然语言处理涉及从原始文本数据中提取信息并将其转换为模型可以处理的形式。预处理步骤通常包括分词(Tokenization)、去除停用词(Stop Words Removal)、词干提取(Stemming)或词形还原(Lemmatization)等。预处理的目的是简化文本数据,去除无关信息,让模型能够更专注于重要的特征。

特征表示通常采用词嵌入(Word Embeddings)技术,如Word2Vec或GloVe,它们将词语转换成稠密的向量,这些向量能够捕捉词语间的语义和语法关系。

```python

# 伪代码展示NLP中的词嵌入转换过程

def tokenize_and_embed(text, word_to_vec_map):

tokens = tokenizer(text) # 分词

embeddings = [word_to_vec_map[token] for token in tokens if token in word_to_vec_map]

return np.array(embeddings) # 将每个词转换为向量形式

```

### 2.2.2 语言模型和文本生成机制

语言模型是NLP中的一个重要组件,它能够评估一个句子出现的概率。文本生成机制通常是基于语言模型进行,如n-gram模型、隐马尔可夫模型(HMM)或者深度学习模型,如循环神经网络(RNN)、长短期记忆网络(LSTM)和Transformer。

深度学习模型能够捕捉长距离依赖关系,因此在生成文本时能够生成更加流畅和连贯的句子。然而,这些模型也存在一些挑战,如容易产生重复或无关内容的问题。

```python

# 伪代码展示基于RNN的文本生成过程

def generate_text(seed_text, model, max_length=100):

generated = seed_text

for _ in range(max_length):

x_pred = np.array([word_to_vec_map[token] for token in generated.split() if token in word_to_vec_map])[-n_previous_words:]

x_pred = x_pred.reshape((1, n_previous_words, -1))

preds = model.predict(x_pred, verbose=0)[0]

next_index = np.argmax(preds)

next_word = list(word_to_vec_map.keys())[list(word_to_vec_map.values()).index(next_index)]

generated += " " + next_word

return generated

```

## 2.3 GANs与NLP结合的理论挑战

### 2.3.1 文本数据的离散性问题

与图像数据不同,文本数据是离散的,这给GANs的训练带来了挑战。图像数据可以通过像素值的细微变化来生成逼真的图片,而文本数据中的每个单词都是一个离散的实体,生成器必须选择正确的单词顺序和语义内容以生成有意义的句子。

解决此问题的一种方法是引入连续的潜在空间表示(如Word Embeddings),或者使用序列生成模型(如SeqGAN),它们允许生成器产生一个词的概率分布,然后从中采样以生成完整的句子。

### 2.3.2 评估和质量控制

由于文本生成的主观性,评估GANs产生的文本质量是一个挑战

0

0