生成文本的艺术:GANs在文本生成中的应用与案例分析

发布时间: 2024-11-20 21:09:57 阅读量: 18 订阅数: 40

人工智能图像生成技术发展与应用研究

# 1. 生成对抗网络(GANs)简介

生成对抗网络(GANs)由Ian Goodfellow等人在2014年提出,已经成为深度学习领域的一项突破性技术,其核心思想是通过对抗过程实现数据分布的逼近。在GANs中,生成器(Generator)和判别器(Discriminator)两个网络相互竞争:生成器的目标是生成尽可能与真实数据接近的假数据,而判别器的任务是尽可能准确地区分出真实数据和生成器产生的假数据。

GANs的提出,不仅为生成逼真图像提供了新的可能性,而且在诸如文本生成、视频合成、语音合成等其他领域也展现出了巨大的潜力。由于其独特的训练机制和应用前景,GANs在近几年的研究与实际应用中得到了快速发展。

本章节将作为系列文章的开端,向读者介绍GANs的基础概念和原理,以及它的基本结构和组成部分,为后面章节中对GANs的深入探讨和应用案例分析打下坚实的基础。

# 2. GANs的基本原理与理论

## 2.1 GANs的架构与组件

### 2.1.1 生成器与判别器的角色

生成对抗网络(GANs)由生成器(Generator)和判别器(Discriminator)两个主要组件构成,它们在训练过程中相互对抗,以提升各自的能力。

生成器负责生成接近真实数据分布的假数据。它从一个随机噪声(Latent space)开始,通过多层网络结构,将这个噪声转化为具有实际意义的数据,例如图像、音频或文本。在文本生成任务中,生成器学习如何根据给定的语境,创造出逻辑连贯、语法正确的语句。

判别器的任务则是区分真实数据和生成器产生的假数据。它接收一个输入样本,并判断这个样本来自训练数据集(真实数据)还是由生成器产生的(假数据)。在判别器的训练过程中,它的目标是提高准确性,即更准确地区分真实数据和假数据。

在理想状态下,随着训练的进行,生成器会逐渐学会产生越来越难以被判别器区分的假数据,而判别器也会越来越善于识别这些假数据。这种动态平衡推动两个网络不断提高自己的能力,直至达到一个纳什均衡状态。

### 2.1.2 损失函数的作用和选择

在GANs的训练中,损失函数(Loss function)扮演着至关重要的角色,它是指导模型优化的数学表达式,能够衡量生成器和判别器性能的指标。损失函数的选择直接影响着GANs的训练效果和模型生成的质量。

在原始的GANs结构中,生成器和判别器的损失函数通常选择为对数损失函数(Logistic loss)。生成器的目标是最小化判别器正确识别假数据的概率,即最大化Logistic损失函数的负值。而判别器的目标是最大化正确分类真实数据和假数据的概率,即最大化Logistic损失函数。

然而,标准的GANs在实际应用中存在诸如模式崩溃(Mode collapse)和训练不稳定等问题。为了解决这些问题,研究者提出了一系列新的损失函数,如Wasserstein损失(也称为Earth-Mover距离),它通过测量分布之间的距离来提供更稳定的训练信号。

除了上述损失函数,还有多种改进型损失函数被提出,如LSGAN(Least Squares GAN)和Hinge损失,旨在进一步提高训练过程中的稳定性和生成数据的质量。

## 2.2 训练GANs的关键技术

### 2.2.1 模式崩溃问题的应对策略

模式崩溃是GANs训练过程中常见的一个难题,指的是生成器无法覆盖整个数据分布,而是过度专注于生成少数几种可能的输出,导致生成数据的多样性丧失。

为了解决模式崩溃问题,研究者们提出了一系列的策略。一个常用的策略是使用梯度惩罚(Gradient Penalty),它通过在损失函数中加入一个惩罚项来确保判别器的梯度在整个输入空间中都比较平滑。这样,生成器就能被迫生成更加多样化的数据。

另外一种有效的技术是特征匹配(Feature Matching),它引导生成器去复制训练集中真实数据的某些统计特征,而不是去学习如何欺骗判别器。这样,即使生成的数据在判别器眼中不那么“真实”,也能保证数据的多样性。

### 2.2.2 稳定化训练的方法与实践

除了模式崩溃之外,GANs训练的另一个挑战是如何实现稳定的训练过程。不稳定的训练可能导致生成器和判别器之间的性能差距不断扩大,或者模型无法收敛到一个合理的结果。

一个流行的稳定化训练方法是引入最小二乘损失(LSGAN)。这种损失函数通过最小化生成数据和真实数据之间的差异,而非概率分类的差异,从而提高了训练过程的稳定性。

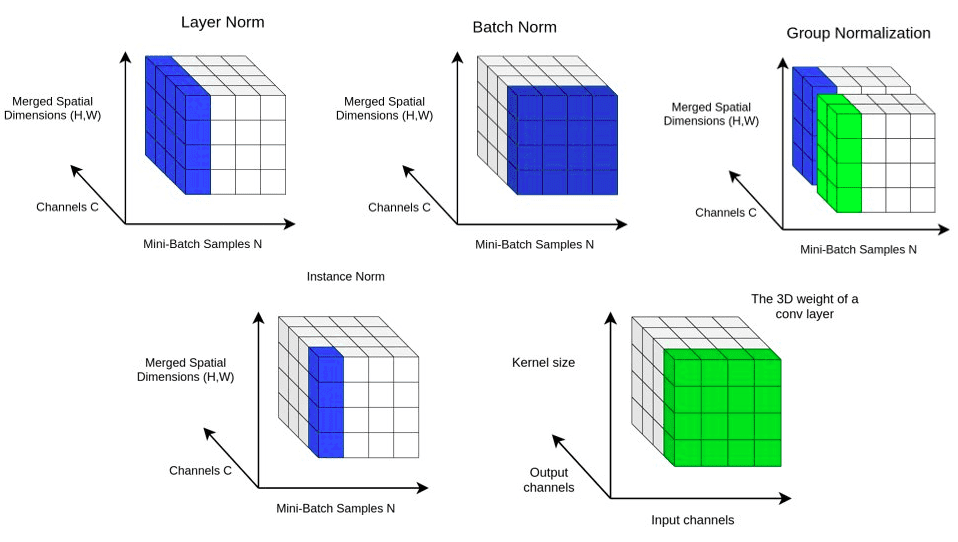

另外,批量归一化(Batch Normalization)和权重归一化(Weight Normalization)也被证明对稳定GANs训练非常有帮助。它们通过调整网络层内权重的尺度,减少了内部协变量偏移,从而提高模型的训练效率和稳定性。

还有一种方法是使用历史平均网络(Historical Average Network),它利用之前生成的假数据的平均值来指导当前的生成过程,这有助于缓解生成器的过度自信,防止其只学习如何生成易于判别器识别的假数据。

## 2.3 GANs的变体与改进

### 2.3.1 DCGAN的理论与应用

深度卷积生成对抗网络(DCGAN)是GANs的一个重要变体,它采用深度卷积神经网络(CNN)作为生成器和判别器的主体结构。DCGAN的提出为GANs在图像生成领域的成功奠定了基础,因其能够生成高质量的图像。

DCGAN的关键贡献在于它提出了网络架构设计的几个原则,比如使用卷积层和卷积转置层(反卷积层)作为生成器和判别器的构建模块,移除全连接层以增加模型的稀疏性,以及引入批量归一化来稳定训练过程。

DCGAN的应用涵盖了从艺术创作到医疗成像的广泛领域。例如,在艺术创作中,DCGAN可以用来生成新的艺术作品,或者在风格转换中,将一张照片转换为特定的艺术风格。在医疗成像领域,DCGAN可以用来合成CT或MRI图像,供进一步的医学研究和诊断使用。

### 2.3.2 其他改进型GANs的介绍

除了DCGAN之外,还有许多其他的GANs变体被提出以解决特定的问题或提高GANs的性能。例如,条件GANs(cGANs)在生成过程中引入了标签信息,使模型能够根据特定的条件或标签生成数据。cGANs在面部图像生成和图像到图像的翻译任务中表现出色。

又如Wasserstein GAN(WGAN)引入了Wasserstein损失函数,它对模型的训练提供了更加平滑的梯度信号,从而改善了训练的稳定性和生成数据的质量。

循环GAN(CycleGAN)则是用于解决无监督图像到图像翻译的问题。它通过引入一个循环一致性损失(Cycle Consistency Loss),允许模型在没有成对训练数据的情况下,学习如何将一种风格的图片翻译成另一种风格。

这些改进型GANs在不同的应用场景中展现出各自的特色和优势,为GANs技术的多样性和实用性提供了丰富的选择。

在第二章中,我们探讨了GANs的基本架构和组件,包括生成器和判别器的角色以及损失函数的选择。随后,我们分析了训练GANs过程中的关键技术和策略,如应对模式崩溃问题和稳定化训练的方法。最后,我们介绍了DCGAN和其他一些重要的GANs变体,以及它们在实际应用中的表现和贡献。

在接下来的章节中,我们将深入了解文本生成的深度学习基础,并探讨GANs在这一领域的应用和挑战。

# 3. 文本生成的深度学习基础

## 3.1 文本表示的深度学习方法

### 3.1.1 Word Embeddings与语境建模

文本作为人类交流信息的主要媒介,其内容的丰富性与复杂性使其成为了深

0

0