网格搜索与交叉验证:随机森林超参数调优秘籍

1. 随机森林算法基础与超参数概述

随机森林作为集成学习方法中的一种,以其出色的预测性能和较低的过拟合风险而备受青睐。该算法通过构建多棵决策树并结合它们的预测结果来提高整体模型的准确性和鲁棒性。随机森林的关键超参数对模型性能有着决定性影响,如树的数量、树的深度、节点划分时考虑的特征数量等。

1.1 随机森林算法概述

随机森林由多个决策树组成,每棵树都是在训练集的一个随机样本上构建的。在构建过程中,树的每个节点都会随机选择一定数量的特征,并基于这些特征进行最优分割。这种方法既保留了决策树易于理解和实现的优点,又通过集成的方法大幅提升了模型的泛化能力。

1.2 随机森林的关键超参数

在随机森林算法中,有几个核心超参数需要进行仔细调整:

- 树的数量(n_estimators):即决策树的数量,增加树的数量能够提高模型的稳定性和准确性,但同时也会增加计算成本。

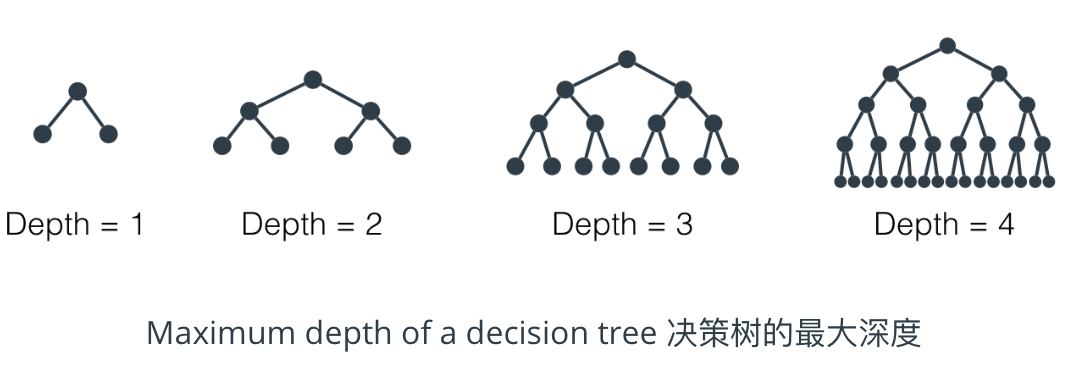

- 树的深度(max_depth):单棵树的最大深度,深度越大模型越复杂,可能会导致过拟合。

- 特征选择数量(max_features):每次分割时考虑的特征数量,这个参数会影响树的多样性和训练速度。

1.3 超参数的调整策略

调整超参数时,一般遵循以下策略:

- 理论指导:基于算法原理和已有经验预设一个参数范围。

- 实验探索:通过实际运行模型并观察性能来调整参数。

- 系统优化:使用网格搜索或随机搜索等方法来系统地寻找最佳超参数组合。

理解随机森林算法的基础和超参数的重要性,为后续章节中使用网格搜索和交叉验证进行超参数调优打下基础。接下来,我们将深入探讨这些优化技术的应用和实践。

2. 网格搜索基础与实践应用

2.1 网格搜索理论框架

2.1.1 超参数调优的必要性

在机器学习领域,模型的性能往往受到所选超参数的影响。超参数是在学习过程开始之前设置的参数,它们指导学习算法如何进行学习。与模型参数不同,模型参数是在训练过程中通过学习数据自动优化的。常见的超参数包括学习率、迭代次数、决策树的深度和叶子节点数等。调优超参数的目的是为了找到能够最大化模型性能的参数组合。

选择超参数的过程往往是经验性的,且具有一定的盲目性。如果随机选择参数组合,可能会导致模型性能不稳定或者效率低下。因此,采用系统性的方法来探索超参数空间,可以帮助我们更加高效和科学地找到最佳的模型配置。

2.1.2 网格搜索的工作原理

网格搜索(Grid Search)是一种通过枚举所有可能的参数组合来寻找最优参数的方法。它的工作原理是首先定义一个参数网格,该网格包含了所有待优化参数的可能值。然后,网格搜索会遍历这个网格,使用交叉验证对每一种参数组合进行评估,并记录下最佳的参数组合。

具体来说,网格搜索会按照参数网格中的一个维度进行循环遍历,对于每一个参数的每一个值,都会使用剩余的参数组合进行模型训练和评估。最终,网格搜索返回所有组合中表现最好的那一个作为结果。

网格搜索虽然简单直观,但也有其局限性。首先,当参数空间很大时,网格搜索会变得非常耗时。其次,它不考虑参数之间的依赖关系,可能会忽略掉一些局部最优的组合。

2.2 网格搜索的实现与优化

2.2.1 使用Python和Scikit-learn进行网格搜索

在Python中,Scikit-learn库提供了一个方便的网格搜索工具,即GridSearchCV。这个工具可以与不同的模型和交叉验证策略结合使用。下面是一个使用GridSearchCV进行网格搜索的基本示例:

在这个代码示例中,我们使用了随机森林分类器和鸢尾花数据集。我们定义了一个参数网格,然后创建了一个GridSearchCV对象。n_jobs=-1告诉GridSearchCV使用所有的CPU核心来进行并行计算,verbose=2用于控制输出的信息量。

2.2.2 针对随机森林的网格搜索实例

在使用网格搜索时,我们应该先设定一个合理的参数范围。对于随机森林而言,一些重要的参数包括:

n_estimators:森林中树的数量。max_features:在划分节点时考虑的最大特征数。max_depth:树的最大深度。min_samples_split:一个节点再划分所需的最小样本数。min_samples_leaf:一个叶子节点包含的最小样本数。

在实际应用中,我们应当根据问题的复杂性和数据集的大小来决定这些参数的范围。下面的表格展示了一个针对随机森林模型的参数网格示例:

| 参数 | 可能的值 |

|---|---|

| n_estimators | [50, 100, 200] |

| max_depth | [None, 10, 20, 30] |

| min_samples_split | [2, 5, 10] |

| min_samples_leaf | [1, 2, 4] |

| max_features | [‘auto’, ‘sqrt’, ‘log2’] |

通过设置这样的参数网格,我们可以使用GridSearchCV来探索最佳的参数组合。需要注意的是,在实际应用中,要根据数据集的特性和计算资源合理选择参数的范围和值。

2.2.3 网格搜索的性能考虑与优化策略

网格搜索虽然直观,但当参数组合非常庞大时,它会变得非常耗时。为了优化网格搜索的性能,我们可以采取以下策略:

- 限制参数值数量:只选取最重要的参数进行网格搜索,或者减少每个参数的值的数量。

- 使用随机搜索:随机搜