【预测准确性提升秘诀】:决策树与Boosting的巧妙结合

发布时间: 2024-09-05 00:49:29 阅读量: 77 订阅数: 40

机器学习中的算法:决策树模型组合之GBDT

# 1. 机器学习中的决策树和Boosting原理

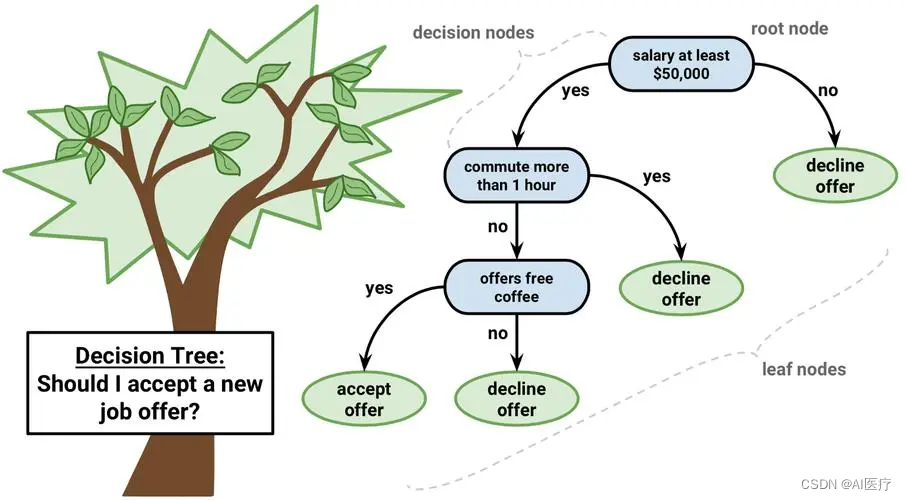

在机器学习领域,决策树和Boosting是两种非常重要的算法,它们在预测和分类任务中都有着广泛的应用。决策树以树状结构展现决策过程,通过逐层分割特征空间来构建模型,具有解释性强、易于理解和使用的特点。而Boosting是一种提高机器学习模型准确度的集成技术,它通过迭代方式,将多个弱分类器组合成一个强分类器,提高了模型的稳定性和准确性。

在理解这些概念的基础上,我们将详细探究决策树的理论基础,并展示如何使用Python构建决策树模型。接着,我们会深入探讨Boosting算法的原理,以及如何在实际应用中优化模型性能。让我们开始深入机器学习的世界,揭开决策树和Boosting的神秘面纱。

# 2. 决策树的理论基础与实践应用

## 2.1 决策树的概念和构建方法

### 2.1.1 决策树的分类和决策过程

在机器学习领域,决策树是一种广泛使用的分类和回归方法,它通过一系列规则将数据集划分成较为纯净的子集。在分类任务中,每个内部节点表示一个属性上的测试,每个分支代表测试的结果,而每个叶节点代表一个类别。

决策树的构建是从训练数据集中识别出最能代表数据分类的特征,使用这些特征对数据进行分割。这种方法的一个关键优势是它产生直观的模型,适合用于决策支持系统。

### 2.1.2 信息增益和熵的概念

信息增益是决策树构建过程中的核心概念。信息增益是指在知道某个特征的信息后使得对数据的划分更加有序的程度。具体来说,它衡量的是在知道特征 X 的条件下,使得目标变量 Y 的熵减少的程度。熵(Entropy)是度量数据集中信息的无序程度。

计算信息增益通常采用以下公式:

```python

def calculate_entropy(y):

counts = np.bincount(y)

probabilities = counts / len(y)

entropy = -np.sum([p * np.log2(p) for p in probabilities if p > 0])

return entropy

```

其中,`y` 是目标变量,`np` 是NumPy库,`bincount` 函数计算每个类别的频率。熵越小,数据集的纯度越高,信息增益越大,模型分类效果越好。

## 2.2 决策树的剪枝技术

### 2.2.1 过拟合与剪枝的关系

在决策树中,过拟合是一个常见的问题,特别是当树模型过于复杂时。此时,模型在训练数据上表现良好,但在新数据上却效果欠佳。剪枝技术被用来处理过拟合,通过减少树的复杂性来提高模型的泛化能力。

剪枝可以分为预剪枝和后剪枝。预剪枝是在构建树的过程中控制树的增长,而后剪枝是在树构建完毕之后进行的。后剪枝通常更有效,因为它在观察了全部数据之后作出剪枝决策。

### 2.2.2 剪枝策略的种类和应用

剪枝策略包括了成本复杂度剪枝(Cost Complexity Pruning),它基于树的复杂度和对数据集的拟合度之间的平衡。

为了防止过拟合,可以采用如下剪枝策略:

```python

from sklearn.tree import DecisionTreeClassifier

def pruning_strategy(tree, alpha):

# 定义成本复杂度剪枝函数

def cost_complexity_pruning_path(X, y, tree, alpha):

paths = tree.cost_complexity_pruning_path(X, y)

ccp_alphas, impurities = ***p_alphas, paths.impurities

return ccp_alphas, impurities

# 使用ccp_alphas来构建一系列树并返回

trees = []

ccp_alphas, _ = cost_complexity_pruning_path(X_train, y_train, tree, alpha)

for ccp_alpha in ccp_alphas:

tree = DecisionTreeClassifier(ccp_alpha=ccp_alpha)

tree.fit(X_train, y_train)

trees.append(tree)

return trees

# 调用函数并进行剪枝

alpha = 0.01

trees = pruning_strategy(tree, alpha)

```

以上代码片段展示了如何使用scikit-learn库实现决策树的剪枝策略。`alpha` 参数表示树的复杂度和数据拟合度之间的权衡因子。

## 2.3 决策树的Python实现

### 2.3.1 使用scikit-learn构建决策树

scikit-learn是Python中强大的机器学习库,提供了方便的接口来实现决策树模型。构建决策树非常简单,只需要几行代码即可完成:

```python

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 加载数据集并分割训练集和测试集

X, y = load_iris(return_X_y=True)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3)

# 构建决策树模型并训练

clf = DecisionTreeClassifier()

clf.fit(X_train, y_train)

# 对测试集进行预测并计算准确率

y_pred = clf.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

print(f'Accuracy: {accuracy}')

```

### 2.3.2 实际案例分析

在实际案例分析中,决策树可以处理各种分类和回归问题。例如,应用决策树解决医疗诊断问题,通过训练数据集(包含患者的症状、测试结果等)来预测患者是否患有某种疾病。

```markdown

| Patient ID | Age | Symptoms | Test Result | Disease |

|------------|-----|----------|-------------|---------|

| 001 | 35 | Fever | Positive | Yes |

| 002 | 28 | Cough | Negative | No |

| ... | ... | ... | ... | ... |

```

通过使用上述数据集,可以构建决策树模型来预测未来患者是否患有疾病。最终模型的准确度需要通过交叉验证或在独立测试集上进行评估。这样不仅有助于提升模型的泛化能力,而且为医疗机构提供了一种有效的决策支持工具。

# 3. Boosting算法的深度剖析

## 3.1 Boosting算法家族介绍

### 3.1.1 Boosting的核心思想

Boosting算法通过迭代地结合一系列弱学习器来构建一个强学习器,以此来提升模型的预测能力。核心思想是“以弱致强”,也就是通过组合多个表现平平的学习器,形成一个强大的集成模型。在每一轮迭代中,Boosting算法都会给予那些之前被错误预测的样本更高的权重,鼓励后续学习器更加关注这些“困难”样本。这种策略是基于错误的样本来不断优化模型的预测能力。

### 3.1.2 常见的Boosting算法对比

Boosting算法家族中有多种算法,包括但不限于AdaBoost、Gradient Boosting、XGBoost等。AdaBoost通过增加被错误分类样例的权重,并降低正确分类样例的权重,来调整数据分布,从而专注于解决前一个弱学习器中犯错的问题。Gradient Boosting则是通过优化损失函数的梯度来训练每个新的弱学习器,通常会使用决策树作为基学习器。XGBoost(eXtreme Gradient Boosting)在Gradient Boosting的基础上引入了正则化项来防止过拟合,同时增加了计算效率和可扩展性。

## 3.2 AdaBoost算法的原理与实践

### 3.2.1 AdaBoost的工作流程和特点

AdaBoost的工作流程如下:

1. 初始化训练数据的权重分布,每个样本赋予相同的权重。

2. 对于每个基学习器(通常是决策树):

- 根据当前权重分布训练一个基学习器,并计算出每个样本的预测错误率。

- 根据错误率调整样本权重,错误的样本权重增加,正确的样本权重减少。

3. 根据每个基学习器的表现,计算它们的权重,然后将它们组合成最终的集成模型。

AdaBoost的一个显著特点是它的简单和高效,其核心在于权重的不断调整,使得模型在每一轮迭代中都专注于被前一轮模型错误预测的数据。

### 3.2.2 Python实现和优化技巧

下面是一个使用scikit-learn实现AdaBoost分类器的代码示例,并附上注释解释:

```python

from sklearn.ensemble import AdaBoostClassifier

from sklearn.datasets import make_classification

from sklearn.model_selection import tr

```

0

0