迁移学习算法精进:如何运用领域自适应技术优化图像分类?

发布时间: 2024-09-03 16:22:07 阅读量: 107 订阅数: 46

# 1. 迁移学习与领域自适应基础

## 1.1 迁移学习的简介与重要性

迁移学习是机器学习领域中的一种策略,它允许模型将在一个任务上学到的知识应用到另一个相关但不同的任务上。这种做法在数据标注成本高昂或数据稀缺的场景下尤为重要,因为它可以显著减少对大规模标注数据的需求。例如,在医学图像分析中,一个预训练的模型可以通过迁移学习快速适应特定类型的扫描图像,而无需重新训练整个模型。

## 1.2 迁移学习的主要类型

迁移学习主要有三种类型:**无迁移学习**,直接在目标任务上从头开始训练模型;**直推式迁移学习**,在源任务上训练好模型后,仅需在目标任务上进行少量微调;以及**迁移式迁移学习**,通过在源任务上获取的特征来训练目标任务的模型。每种类型都有其独特的使用场景和优势,选择合适的类型可以优化学习效率和模型性能。

## 1.3 领域自适应的简介

领域自适应是迁移学习的一个重要分支,它关注于解决源域和目标域之间存在的数据分布差异问题。这一过程通常涉及将源域学到的知识有效转移到目标域,尤其在源域和目标域的数据具有不同的统计特征时。领域自适应在提高跨领域任务的模型泛化能力上发挥着至关重要的作用。

# 2. 迁移学习中的领域自适应理论

## 2.1 迁移学习的基本概念

### 2.1.1 迁移学习的定义与重要性

迁移学习(Transfer Learning)是机器学习领域的一个重要研究方向,其核心思想是利用一个领域(源域)所获得的知识对另一个不同但相关领域(目标域)的学习任务进行指导,以提高学习效率和效果。这种方法尤其适用于目标域的数据较少,难以通过传统监督学习方法获得有效模型的情况。迁移学习在自然语言处理、计算机视觉、生物信息学等多个领域都有广泛的应用。

迁移学习的重要性在于其对数据的高效利用,尤其是在数据稀缺的环境下,能够借助大量相关领域的数据来提升学习效果。它也符合人类学习的直观认知,即人们在学习新知识时常常会利用已有知识作为基础。

### 2.1.2 迁移学习的主要类型

迁移学习根据源域和目标域之间的关系可以分为以下几种类型:

- **同构迁移(Homogeneous Transfer)**:源域和目标域的特征空间相同,例如从一个图像数据集到另一个图像数据集的迁移。

- **异构迁移(Heterogeneous Transfer)**:源域和目标域的特征空间不同,这通常需要一些转换函数来桥接两者之间的差异。

- **归纳迁移(Inductive Transfer)**:源域和目标域的任务不同,但存在某些共同的底层结构。

- **直推迁移(Transductive Transfer)**:源域和目标域的标签空间可能不同,通过共享特征空间来实现知识迁移。

## 2.2 领域自适应的理论基础

### 2.2.1 领域自适应的定义与应用场景

领域自适应(Domain Adaptation)是迁移学习中的一个重要分支,它关注的是如何在源域和目标域存在分布差异的情况下,通过学习一个在源域上表现良好的模型,并将其应用于目标域。在实际应用中,这一概念通常用来解决数据标注成本高的问题,比如在自然语言处理中,可以从资源丰富的语言迁移至资源稀缺的语言,或者在医疗图像分析中,将从一个医疗机构获取的知识应用到另一个机构的数据上。

领域自适应的关键挑战在于数据分布的不一致性,它要求算法不仅要能处理源域和目标域特征空间的差异,还要能处理不同分布下的统计特性。

### 2.2.2 常用的领域自适应理论模型

领域自适应理论模型在发展过程中,已经涌现出了多种模型:

- **分布对齐模型(Distribution Alignment Models)**:这类模型试图通过变换或选择特征来减少源域和目标域的分布差异。

- **特征变换模型(Feature Transformation Models)**:这类模型学习一种特征变换,使得变换后的源域数据和目标域数据具有相似的分布。

- **分类器适应模型(Classifier Adaptation Models)**:这类模型通过调整分类器的参数,使其在源域和目标域上都表现良好。

## 2.3 领域自适应的关键问题

### 2.3.1 数据分布差异的衡量

衡量源域和目标域之间数据分布差异是领域自适应中的一个关键问题。一个常用的方法是最大均值差异(Maximum Mean Discrepancy, MMD),它通过度量两个分布的统计特性来计算它们之间的差异。MMD基于再生核希尔伯特空间(Reproducing Kernel Hilbert Space, RKHS)中的特征映射,可以用于衡量两个分布是否相同。

```python

from scipy.spatial.distance import pdist, squareform

from sklearn.metrics.pairwise import linear_kernel

def calculate_mmd(x, y, gamma):

"""

计算最大均值差异(MMD)。

参数:

x: 第一个分布的样本集合

y: 第二个分布的样本集合

gamma: 核函数参数

返回:

mmd: MMD值

"""

x_kernel = linear_kernel(x, gamma=gamma)

y_kernel = linear_kernel(y, gamma=gamma)

xy_kernel = linear_kernel(x, y, gamma=gamma)

mmd = (x_kernel.sum() - xy_kernel.sum()) / len(x)**2

mmd += (y_kernel.sum() - xy_kernel.sum()) / len(y)**2

return mmd

```

在上述代码中,我们使用了线性核函数来计算样本集合的核矩阵,然后基于核矩阵计算MMD值。`gamma`是核函数的一个参数,需要根据具体问题进行选择。

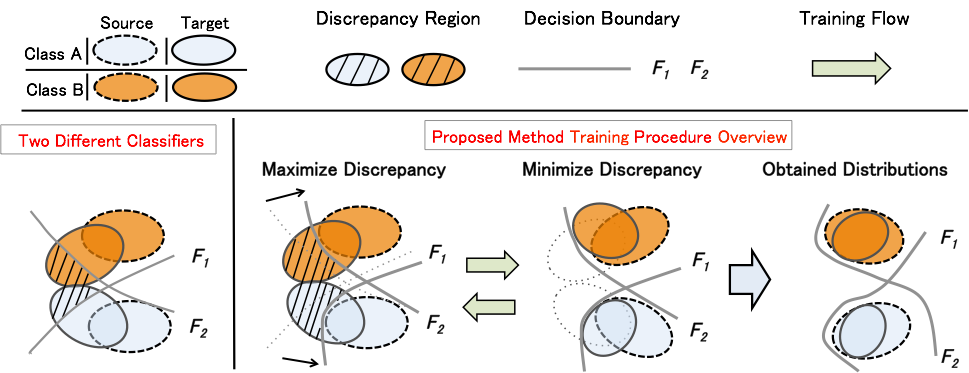

### 2.3.2 源域与目标域的对齐策略

源域和目标域数据的对齐是领域自适应的另一个关键问题。一种常见的对齐策略是通过寻找一种特征表示,使得源域和目标域数据在该特征表示下的分布尽可能相似。这种策略通常需要借助深度学习模型来实现,可以使用对抗性训练方法(如对抗网络)来迫使源域和目标域的数据特征表示不可区分。

mermaid格式流程图可以用来表示领域自适应对齐策略中的关键步骤:

```mermaid

graph LR

A[源域数据] -->|特征提取| B[特征表示]

A -->|对抗性训练| C[分类器]

B -->|分类器| D[目标域数据]

C -->|对抗性损失| B

```

在上述流程图中,源域数据通过特征提取得到特征表示,同时通过对抗性训练,分类器尝试区分源域和目标域数据,而特征表示模块则不断调整特征以迷惑分类器,最终达到对齐的目的。

# 3. 领域自适应技术在图像分类中的应用

## 3.1 领域自适应技术的实现方法

### 3.1.1 特征级别的自适应技术

领域自适应的核心在于解决不同领域(例如,源域和目标域)间数据分布的不一致性问题。特征级别的自适应技术旨在通过某种转换减少这两个领域特征分布之间的差异。一个常见方法是使用特征变换,如主成分分析(PCA)或线性判别分析(LDA),来映射数据到一个共同的特征空间,使得在这个空间内,源域和目标域的特征分布更加接近。

特征级别的自适应技术的代码示例如下:

```python

import numpy as np

from sklearn.decomposition import PCA

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis as LDA

def feature_level_adaptation(data_source, data_target):

# 假定 data_source 和 data_target 已经预处理为 NumPy 数组形式

# 使用 PCA 进行降维处理

pca = PCA(n_components=100) # 选择适当的降维数量

pca.fit(data_source)

source_features_pca = pca.transform(data_source)

target_features_pca = pca.transform(data_target)

# 或者使用 LDA 进行特征提取

lda = LDA(n_components=100) # 选择适当的类别数

source_features_lda = lda.fit_transform(data_source, source_label)

target_features_lda = lda.transform(data_target)

return source_features_pca, target_features_pca, source_features_lda, target_features_lda

# 假定已经准备了源域和目标域的数据以及源域标签

source_features_pca, target_features_pca, source_features_lda, target_features_lda = feature_level_adaptation(data_source, data_target)

```

在上述代码中,我们首先导入了必要的库,然后定义了一个 `feature_level_adaptation` 函数,该函数接受源域和目标域的数据作为输入,并分别使用PCA和LDA进行特征级别的自适应处理。PCA旨在捕捉数据的最大方差,而LDA则在减少类间距离的同时增加类内距离,这两种方法都旨在通过特征转换来缩小不同域之间的差异。

### 3.1.2 分类器级别的自适应技术

在分类器级别的自适应中,我们关注的是直接在分类器的训练过程中减少域差异。一个简单但有效的方法是加权源域数据,使得来自与目标域相似的源域样本得到更多的重视。这种方法的挑战在于,需要一种有效的度量来评估源域和目标域样本之间的相似性。使用领域知识或启发式方法可以辅助设计这种权重函数。

```python

from sklearn.ensemble import RandomForestClassifier

def classifier_level_adaptation(source_features, target_features, source_labels, target_labels):

# 初始化随机森林分类器

clf = RandomForestClassifier(n_estimators=100)

# 假设 target_weight 是一个数组,包含了目标域数据的权重

target_weight = compute_weights(target_features)

# 训练加权的随机森林分类器

clf.fit(source_f

```

0

0