【深度剖析】:卷积层在图像特征提取中的关键作用

发布时间: 2024-09-05 22:15:42 阅读量: 63 订阅数: 53

java计算器源码.zip

# 1. 卷积层基础理论

## 1.1 卷积操作的数学定义

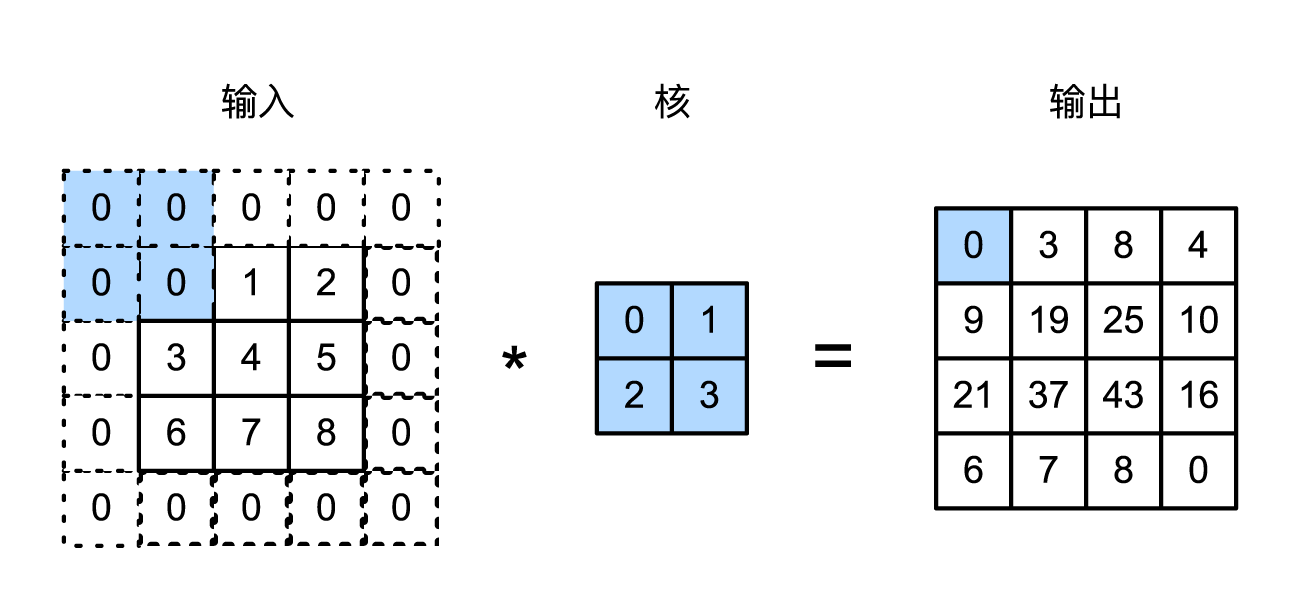

卷积操作是卷积神经网络(CNN)中不可或缺的组成部分。数学上,卷积可以被定义为两个函数的数学运算,它通过一种特殊的积分变换将一个函数和另一个函数相结合,从而产生第三个函数,表示为两个函数的“混合”结果。在图像处理中,卷积核(滤波器)在原始图像上滑动,计算重叠区域元素的加权和,以此来提取特征。

```math

(f * g)(t) = ∫ f(τ)g(t - τ)dτ

```

## 1.2 卷积层的作用

卷积层在CNN中的作用是进行特征提取。通过应用不同的卷积核,网络可以从输入图像中检测出边、角点、纹理等基本特征。随着网络层次的增加,逐渐从简单的局部特征组合成更为复杂的抽象特征。卷积层的这一特性使得它在图像识别、图像处理和计算机视觉领域得到了广泛应用。

# 2. 卷积层在图像处理中的应用

### 2.1 图像卷积操作原理

卷积操作是图像处理中的一项核心技术,尤其在深度学习中,卷积神经网络(CNN)是许多视觉任务的基础。理解卷积操作的原理,有助于我们深入挖掘图像数据的内在模式。

#### 2.1.1 离散卷积定义

离散卷积是连续卷积在离散空间的一种表现形式。对于二维图像数据,离散卷积可以定义为:

代表输入图像,\( k \) 代表卷积核,\( * \) 表示卷积操作,\( g \) 为卷积结果。卷积核在图像上滑动,逐个位置计算元素乘积和,输出新的图像矩阵。

在实际操作中,我们会加上偏置项,通过激活函数来引入非线性,使卷积层可以学习到更复杂的模式。

#### 2.1.2 卷积核的作用和选择

卷积核也被称为滤波器,负责提取图像中的特定特征。例如,常见的边缘检测卷积核,可以提取出图像中的垂直边缘、水平边缘、对角线边缘等。选择合适的卷积核对于特征提取至关重要。

卷积核的大小、形状和参数均影响着网络的学习效果。通常情况下,为了捕捉更多特征,会从浅层的简单特征到深层的复杂特征依次设计卷积核。

### 2.2 卷积层的参数学习

参数学习是卷积层核心所在,卷积核参数的初始化和更新直接影响了网络的性能和收敛速度。

#### 2.2.1 卷积层参数的初始化

合理的初始化方法能够帮助模型更快地收敛。常见的初始化方法有:

- 零初始化:所有参数均初始化为零。

- 随机初始化:参数按照一定分布(如高斯分布)随机取值。

- Xavier初始化:参数按照均值为零,方差为 \( \frac{2}{fan_{in} + fan_{out}} \) 的分布初始化。

- He初始化:Xavier初始化的变种,特别适用于ReLU激活函数,方差为 \( \frac{2}{fan_{in}} \)。

#### 2.2.2 卷积层参数的更新方法

参数更新方法是指卷积核参数随着模型训练不断调整的过程。反向传播配合梯度下降是最基本的参数更新方法。

- 随机梯度下降(SGD)

- 带动量的随机梯度下降(SGDM)

- 自适应学习率优化器(如Adam, RMSprop)

### 2.3 卷积层的深度学习框架实现

深度学习框架如TensorFlow、PyTorch提供了丰富的API来简化卷积层的实现。接下来将介绍如何在实际深度学习框架中实现卷积层。

#### 2.3.1 框架中的卷积层API

在深度学习框架中,卷积层通常是通过定义一个层类实现的。以PyTorch为例,卷积层可以定义如下:

```python

import torch.nn as nn

class ConvolutionLayer(nn.Module):

def __init__(self, in_channels, out_channels, kernel_size, stride=1, padding=0):

super(ConvolutionLayer, self).__init__()

self.conv = nn.Conv2d(in_channels, out_channels, kernel_size, stride=stride, padding=padding)

def forward(self, x):

return self.conv(x)

```

#### 2.3.2 实际代码案例分析

下面是一个使用PyTorch框架的简单卷积神经网络实现,用于处理CIFAR-10数据集:

```python

import torch

import torch.nn as nn

import torch.optim as optim

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(3, 32, 3, padding=1) # (in_channels, out_channels, kernel_size)

self.conv2 = nn.Conv2d(32, 64, 3, padding=1)

self.fc1 = nn.Linear(64 * 8 * 8, 512)

self.fc2 = nn.Linear(512, 10)

self.pool = nn.MaxPool2d(2, 2)

self.relu = nn.ReLU()

def forward(self, x):

x = self.pool(self.relu(self.conv1(x)))

x = self.pool(self.relu(self.conv2(x)))

x = x.view(-1, 64 * 8 * 8) # Flatten the tensor

x = self.relu(self.

```

0

0