【R语言数据包tm使用秘籍】:从零开始掌握文本挖掘至实战应用的全过程

1. R语言与文本挖掘概述

文本挖掘是一种从大量文本数据中提取有价值信息的技术,它涉及自然语言处理、统计学、机器学习等多个学科。R语言,作为一种统计编程语言,因其强大的数据处理和可视化能力,在文本挖掘领域占据了一席之地。它的tm包是专为文本挖掘设计的,能够简化从原始文本到信息提取的整个流程。文本挖掘不仅能够揭示用户行为模式,还能够为企业提供市场洞察和决策支持。掌握R语言与文本挖掘,对于数据分析人员而言,是提升技能的有力工具。下面章节将详细阐述tm包的安装配置、文本挖掘的理论与实践,以及如何在实际案例中应用这些技术。

2. tm包基础安装与环境配置

2.1 R语言环境的搭建

2.1.1 安装R语言与RStudio

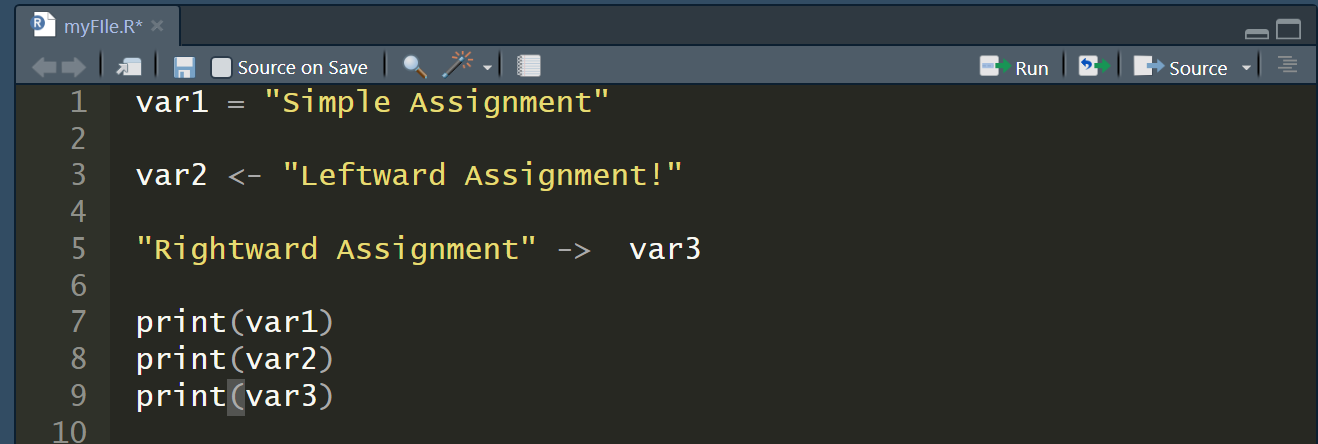

在开始使用tm包之前,我们需要确保已经搭建好R语言的运行环境。R语言可以通过其官方网站下载安装程序,支持Windows、Mac OS X以及各种Linux发行版。安装过程中,请确保选择安装所有推荐的附加包,以便使用R的全部功能。

RStudio是R语言的一个流行集成开发环境(IDE),它提供了代码编辑、图形界面、包管理以及与其他工具集成等多种功能。下载并安装RStudio,选择适当的版本以匹配你的操作系统。

安装步骤可以分解为以下几个小部分:

- 访问[The Comprehensive R Archive Network (CRAN)](***,选择对应的操作系统下载R语言安装程序。

- 运行安装程序,跟随指引完成安装。确保所有默认选项得以保留,除非你明白更改它们的含义。

- 访问[RStudio官网](***,根据你的操作系统下载RStudio安装包。

- 执行安装程序完成RStudio的安装。

安装完成后,启动RStudio,若能正常运行则表示R环境搭建成功。

- # 检查R语言版本信息

- R.Version()

- # 在RStudio中安装额外的包,例如ggplot2

- install.packages("ggplot2")

2.1.2 环境变量与包管理

安装完R和RStudio之后,我们需要配置环境变量以便在命令行中直接使用R语言。此外,包管理是R语言中使用库的关键,我们也将介绍如何管理R包。

- 在Windows系统中,环境变量配置通常在“系统属性”->“高级”->“环境变量”中进行。

- 在Mac OS X和Linux系统中,环境变量通常在终端中通过export命令设置。

- # 以Windows为例,设置环境变量

- SET PATH=%PATH%;C:\Program Files\R\R-4.0.3\bin\

- # 在RStudio中,可以使用以下R命令来管理包

- install.packages("tm") # 安装tm包

- library(tm) # 加载tm包

2.2 tm包的基本功能介绍

2.2.1 tm包的核心组件

tm包是R语言中用于文本挖掘的一个重要工具包。它提供了从文本数据的读取、预处理、分析到模型建立的全套流程支持。tm包的核心组件主要包括文本语料库(Corpus)的构建和操作,以及转换器(Transformer)用于文本的预处理。

tm包中的Corpus可以看作是一个文档集合,每个文档可以包含文字、元数据和注释等。Transformer是一系列用于清洗、转换文本数据的函数和方法。

- # 创建一个空的语料库

- empty_corpus <- Corpus(VectorSource(character()))

- # 显示语料库的结构

- print(empty_corpus)

2.2.2 文本预处理流程概述

文本预处理是文本挖掘的重要步骤,它包括去除标点符号、转换大小写、删除停用词、词干提取等。tm包通过提供一套完整的文本处理函数,使我们能够方便地对文本数据进行清洗和标准化。

预处理流程一般包括:

- **读取文本数据:**tm包支持多种格式的文本文件,可以将它们读取为文本语料库。

- **文本清洗:**包括删除数字、标点符号,转换文本为小写等。

- **文本转换:**例如,使用词干提取(stemming)来简化词的形式,或者词形还原(lemmatization)将单词转化为词典形式。

- **去除停用词:**停用词(stop words)是语言中常见的、对于文本分析意义不大的词汇,如“的”、“是”等,在分析前应予删除。

- # 示例:使用tm包的函数进行基本的文本预处理

- # 加载tm包

- library(tm)

- # 将文本数据读入语料库

- text_data <- "这里是一段示例文本。"

- corpus <- Corpus(VectorSource(text_data))

- # 文本预处理函数链

- corpus <- tm_map(corpus, content_transformer(tolower)) # 转换为小写

- corpus <- tm_map(corpus, removeNumbers) # 删除数字

- corpus <- tm_map(corpus, removePunctuation) # 删除标点

- corpus <- tm_map(corpus, removeWords, stopwords("english")) # 去除英文停用词

2.3 tm包的安装与配置

2.3.1 安装tm包的方法

安装tm包非常简单,可以通过RStudio界面的“包”菜单点击“安装”进行安装,或者使用R语言的install.packages函数来安装。确保在安装时,网络连接是稳定的,以便从CRAN中下载包。

- # 使用R语言内置的函数安装tm包

- install.packages("tm")

安装过程中可能需要选择镜像站点,尽量选择距离较近、响应速度快的站点进行下载。

2.3.2 配置tm包以支持中文等特殊字符集

默认情况下,tm包可能不支持中文字符集。为了确保能够正确处理中文文本,我们需要在进行文本预处理之前对tm包进行适当配置。这通常涉及到设置编码格式,以及确保在预处理函数中使用正确的参数。

- # 配置tm包以支持中文字符集

- Sys.setlocale("LC_ALL", "Chinese") # 设置语言环境为中文

- # 示例配置tm_map函数以包含中文停用词

- my_stopwords <- c(stopwords("en"), stopwords("fr"), stopwords("de"))

- corpus <- tm_map(corpus, removeWords, my_stopwords)

以上步骤展示了如何在R语言中安装tm包并进行基本配置,以便处理中文和其他非英文文本数据。在实际应用中,可能还需要进一步的定制化配置来满足特定需求。

3. 文本挖掘理论与实践

在文本挖掘领域,理解理论基础与实施实践同样重要。文本挖掘不仅是一门技术,也是一种解决问题的方法论,其核心是通过自动化手段,从大规模文本集合中提取信息,发现知识。

3.1 文本挖掘的基本概念

3.1.1 文本挖掘的定义与目的

文本挖掘(Text Mining)又称为文本数据挖掘(Text Data Mining),是数据挖掘(Data Mining)的一个分支。其目的是将非结构化的文本数据转换为可分析的结构化形式,并从中提取有价值的信息和知识。文本挖掘涉及自然语言处理(Natural Language Processing, NLP)、统计学、计算机语言学等多领域知识。

文本挖掘的主要目标包括:

- 自动识别和抽取文本中的模式和趋势

- 从大量未标记的文本中发现新知识

- 基于历史数据预测未来趋势或行为

- 通过数据分析支持业务决策

3.1.2 文本挖掘的主要步骤

文本挖掘的过程通常分为几个关键步骤:

- 数据收集:采集需要分析的文本数据,可能来自网页、文档、数据库等。

- 预处理:包括文本清洗(去除噪音,如无关字符、格式调整等)、分词(Tokenization)、去除停用词(Stop Words Removal)、词干提取(Stemming)等。

- 特征提取:将文本转换为可以被算法处理的数值形式,例如词频统计、TF-IDF(Term Frequency-Inverse Document Frequency)等。

- 模式识别:应用算法(如分类、聚类、关联规则等)对特征进行处理,识别其中的模式和关系。

- 知识发现与解释:将算法结果转化为业务上的决策支持和洞见。

- 结果应用:将发现的知识应用到实际业务中,如改进产品、优化服务等。

3.2 文本数据的清洗与预处理

3.2.1 文本清洗技术

文本清洗是文本挖掘的基础。在对大量文本数据进行分析之前,必须对数据进行彻底的清洗,这通常包括以下几个方面:

- 去除噪音:包括HTML标签、特殊字符、标点符号等。

- 标准化:转换为统一的格式,例如,将所有的“US”和“U.S.”统一为“United States”。

- 分词:将句子或段落切分成单独的单词或词汇单元。

- 去除停用词:这些词在文本中频繁出现,但对分析主题或内容帮助不大,如“的”,“和”等。

3.2.2 文本转换与标准化

文本转换包括词干提取、词形还原等技术,将词汇转化为基本形式。而标准化则涉及确保文本的一致性,例如:

- 大小写统一:将所有文本转换为小写,以避免同一词汇在不同大小写形式下被当作不同词汇处理。

- 语言一致性:如果分析中涉及到多语言文本,需要统一到一种语言。

- 格式统一:确保日期、数字等按照同一格式表达。

3.3 特征提取与降维技术

3.3.1 词频统计与TF-IDF

特征提取是将文本转化为机器学习算法可以处理的数值形式的过程。词频(Term Frequency, TF)统计是基础方法之一,即统计一个词在文档中出现的次数。而TF-IDF则是考虑词在文档中的重要性,通过降低常见词汇的权重,提高对文档有区分度的词汇的权重。

公式为: [ \text{TF-IDF}(t,d) = \text{TF}(t,d) \times \log\left(\frac{N}{\text{DF}(t)}\right) ] 其中:

- (\text{TF}(t,d)) 是词 (t) 在文档 (d) 中出现的频率。

- (N) 是文档总数。

- (\text{DF}(t)) 是包含词 (t) 的文档数量。

3.3.2 主题模型与LDA分析

主题模型是用于发现大量文档集中隐藏的语义结构的方法。其中,LDA(Latent Dirichlet Allocation)是一种广泛使用的主题模型算法,它假设每个文档是多个主题的混合,每个主题是多个词汇的分布。

LDA 的工作流程如下:

- 从文档词频矩阵出发。

- 随机分配每个文档中的每个词到一个主题。

- 根据当前主题分配,重新评估词和文档的主题概率。

- 循环步骤2和3,直到收敛,得到每个文档和词汇的主题分布。

LDA模型的参数解释:

- (K):主题的数量。

- (D):文档的集合。

- (V):词汇表的大小。

- (\theta_d):文档 (d) 的主题分布。

- (\phi_k):主题 (k) 的词汇分布。

- (z_{d,n}):文档 (d) 中第 (n) 个词的主题分配。

- (w_{d,n}):文档 (d) 中第 (n) 个词的词汇。

在实际操作中,可以使用R语言的topicmodels包进行LDA模型的构建与分析。下面是一个简单的示例代码块,用于展示如何在R语言中应用LDA算法:

在上述代码中,k = 5 指定了我们希望模型找到的主题数量为5。terms(lda_model, 10) 则用于提取每个主题中最相关的10个词。

通过上述步骤,文本数据可以被转换为模型可以分析的数值形式,从而为接下来的模式识别和知识发现打下坚实的基础。随着我们深入到文本挖掘的高级应用和案例分析,会看到这些基础方法是如何在实际问题中得到应用和扩展的。

4. tm包高级应用技巧

4.1 构建文本挖掘模型

文本挖掘的高级应用涉及构建模型来分析数据集。在这一部分中,我们将探讨如何使用tm包来构建文本分类模型和情感分析模型,这两种模型都是文本挖掘领域的热门应用。

4.1.1 文本分类模型的建立

文本分类是将文本数据分配到预先定义的类别中的过程。在R语言中,利用tm包,我们可以轻松地实现这一过程。

首先,我们需要准备和预处理数据集。使用tm_map函数将文本转化为小写,移除停用词、标点符号,并进行词干提取(stemming)。

- library(tm)

- # 创建语料库

- corpus <- Corpus(VectorSource(df$text))

- # 预处理文本数据

- corpus <- tm_map(corpus, content_transformer(tolower))

- corpus <- tm_map(corpus, removePunctuation)

- corpus <- tm_map(corpus, removeNumbers)

- corpus <- tm_map(corpus, removeWords, stopwords("en"))

- corpus <- tm_map(corpus, stemDocument)

- # 创建文档术语矩阵

- dtm <- DocumentTermMatrix(corpus)

接下来,使用得到的文档术语矩阵进行文本分类。假设我们有分类标签,可以应用机器学习算法如朴素贝叶斯分类器来训练模型。

- # 假设df$label是文本对应的分类标签

- # 构建训练集和测试集

- set.seed(123)

- trainingIndex <- createDataPartition(df$label, p = 0.7, list = FALSE)

- training <- dtm[trainingIndex, ]

- testing <- dtm[-trainingIndex, ]

- # 使用朴素贝叶斯分类器训练模型

- library(e1071)

- classifier <- naiveBayes(training, df$label[trainingIndex])

然后,我们可以使用建立的模型来预测测试集的分类标签。

- # 预测测试集分类

- predicted <- predict(classifier, testing)

- confusionMatrix(predicted, df$label[-trainingIndex])

4.1.2 情感分析模型的构建

情感分析是判断文本中表达的情感倾向的过程,如积极、消极或中性。tm包可以辅助我们进行情感分析,但通常需要额外的字典库,比如afinn或bing,来计算文本的情感分数。

在上面的代码中,我们使用afinn字典来计算每条记录的情感分数,并绘制了一个情感分布的直方图,这样可以直观地了解数据集中的情感倾向。

4.2 文本挖掘模型评估与优化

4.2.1 模型性能评估指标

模型评估是文本挖掘流程中关键的一步,用于量化模型性能的好坏。对于分类模型,通常使用的评估指标包括精确度(Precision)、召回率(Recall)、F1分数和ROC曲线下面积(AUC)。

在R中,我们可以使用caret包来计算这些指标。假设predicted是我们的模型预测结果,而testing_labels是真实的测试集标签。

- library(caret)

- # 计算评估指标

- confusionMatrix <- confusionMatrix(predicted, testing_labels)

- precision <- precision(predicted, testing_labels)

- recall <- recall(predicted, testing_labels)

- f1Score <- 2 * ((precision * recall) / (precision + recall))

- # ... 其他指标的计算类似

4.2.2 参数调优与模型优化

模型的性能往往受到其参数选择的影响。参数调优是指通过系统地改变模型参数值,来寻找最佳参数组合,以提升模型性能。

使用caret包进行参数调优是常见的做法。例如,使用train函数和交叉验证来找到最佳的随机森林分类器参数。

- # 使用train函数进行参数调优

- tuneGrid <- expand.grid(.mtry=c(1:5))

- rfFit <- train(training, df$label[trainingIndex], method="rf",

- trControl=trainControl(method="cv"), tuneGrid=tuneGrid)

- # 查看最佳参数

- rfFit$bestTune

4.3 tm包的拓展与自定义

4.3.1 自定义文本清洗函数

在进行文本挖掘的过程中,可能会遇到特定的需求,需要我们自定义一些文本清洗函数来处理文本数据。

例如,若我们需要一个函数去除文本中的所有非ASCII字符,可以定义如下:

- # 自定义去除非ASCII字符函数

- remove_non_ascii <- function(text) {

- iconv(text, to="ASCII//TRANSLIT")

- }

- # 应用到语料库

- corpus <- tm_map(corpus, content_transformer(remove_non_ascii))

4.3.2 集成外部算法与工具

tm包允许我们集成外部算法,比如使用text2vec包来构建Word Embeddings。下面是一个简单的例子来说明如何集成外部工具。

- library(text2vec)

- # 生成词汇表

- it <- itoken(corpus, progressbar = FALSE)

- vocab <- create_vocabulary(it)

- # 构建词汇表和词向量映射

- vectorizer <- vocab_vectorizer(vocab)

- dtm <- create_dtm(it, vectorizer)

- # 使用预训练的word2vec模型

- wv <- read.word2vec(file = "path/to/word2vec.txt", binary = TRUE)

- word_vectors <-预训练词向量模型(wv)

- # 这里省略了如何用word_vectors进一步进行文本挖掘的步骤...

通过上述内容,我们可以看到tm包在文本挖掘中的高级应用,不仅包含了模型的构建和评估,同时也涉及到了参数调优和自定义功能的扩展。这些技巧和方法让文本挖掘更加灵活和高效。

5. tm包在实际案例中的应用

在文本挖掘的实践中,应用是检验理论和工具有效性的重要环节。本章将通过两个具体案例,展示tm包如何在实际场景中发挥作用,从社交媒体文本分析到商业数据文本挖掘,我们将逐一探讨tm包在不同领域的应用技巧和分析流程。

5.1 社交媒体文本分析实例

社交媒体平台如微博、Twitter等,每天产生海量的文本数据。这些数据包含了用户的情感倾向、热点话题和各种社会现象的反映。如何从这些文本数据中提取有价值的信息,是文本挖掘的重要应用场景之一。

5.1.1 微博文本情感分析

情感分析是通过自然语言处理技术,判断文本中所含的情感倾向,通常分为正面、负面和中性。tm包提供了文本预处理和分析的基础工具,而R语言的其他包则可以用于构建情感分析模型。

数据获取与预处理

首先,我们需要从微博平台获取相关数据。可以通过API接口或者爬虫技术来实现数据的采集。以下是一个简化的代码示例,展示如何使用httr包获取微博数据:

- # 安装和加载必要的包

- if (!require('httr')) install.packages('httr')

- library(httr)

- # 获取微博数据的示例代码(此处省略API认证和数据处理细节)

- response <- GET("***",

- query = list(access_token = "YOUR_ACCESS_TOKEN",

- uid = "USER_ID"))

- weibo_data <- content(response)

获取数据后,接下来的步骤是进行文本预处理,包括去除无用的符号、空白字符和进行中文分词。

- # 安装和加载tm包

- if (!require('tm')) install.packages('tm')

- library(tm)

- # 创建文本挖掘语料库

- docs <- Corpus(VectorSource(weibo_data$text))

- # 预处理函数,包括去除标点、数字、空白等

- docs <- tm_map(docs, removePunctuation)

- docs <- tm_map(docs, removeNumbers)

- docs <- tm_map(docs, stripWhitespace)

- docs <- tm_map(docs, content_transformer(tolower))

- # 中文分词

- docs <- tm_map(docs, content_transformer(jiebaR::segment))

情感分析模型构建

在预处理完数据之后,我们可以使用R中的其他包来构建情感分析模型。例如使用sentiment包进行情感分类:

- # 安装和加载sentiment包

- if (!require('sentiment')) install.packages('sentiment')

- library(sentiment)

- # 训练情感分析模型

- sent_model <- train_sentiment_model(docs, algorithm = "text")

- # 对新的微博文本数据进行情感分类

- new_weibo <- c("今天天气真好", "好讨厌下雨天")

- predicted_sentiments <- predict(sent_model, new_weibo)

在实际应用中,可能还需要对模型进行优化,比如调整分词的精确度、使用更复杂的机器学习算法等。

5.1.2 新闻文章主题提取

新闻文章主题提取是根据文本内容识别出文章的主题,并将其归类到相应的类别中。这有助于快速了解大量文章的主要议题,或者监控特定主题的讨论热度。

文本向量化

首先,我们需要将文本转换为机器学习模型可以处理的格式。tm包中的DocumentTermMatrix函数可以帮助我们进行向量化:

- # 文档-词条矩阵

- dtm <- DocumentTermMatrix(docs)

- # 将矩阵转换为数据框,便于后续处理

- dtm_df <- as.matrix(dtm)

- dtm_df <- as.data.frame(dtm_df)

主题模型构建

接下来,我们使用topicmodels包来应用潜在狄利克雷分配(LDA)算法进行主题建模:

- # 安装和加载topicmodels包

- if (!require('topicmodels')) install.packages('topicmodels')

- library(topicmodels)

- # 设置LDA模型的主题数量

- k <- 5

- lda_model <- LDA(dtm, k = k)

- # 输出主题词

- topics <- terms(lda_model, 10)

- topics

通过输出的主题词,我们可以了解每个主题的核心词汇,进而推断新闻文章的分类。

结果分析与应用

最后,我们可以根据LDA模型的输出结果对新闻文章进行主题分类,并分析不同时间点的热点话题变化,为新闻报道或舆论监控提供数据支持。

5.2 商业数据文本挖掘实例

在商业领域,文本挖掘可以应用于客户反馈分析、产品评论情感分析等多个方面。这些分析能够帮助企业了解客户需求、改进产品和服务,增强市场竞争力。

5.2.1 客户反馈文本分析

客户反馈包含了大量关于产品和服务质量的第一手信息,通过对这些文本数据进行分析,企业可以及时调整策略以满足客户需求。

数据预处理与文本分类

在处理客户反馈数据时,可以使用tm包中的功能来进行数据清洗、分词和向量化,然后构建文本分类模型。比如使用支持向量机(SVM)对客户反馈进行情感倾向分类:

- # 安装和加载e1071包

- if (!require('e1071')) install.packages('e1071')

- library(e1071)

- # 对客户反馈进行预处理并构建SVM模型

- customer_feedback <- read.csv("customer_feedback.csv")

- preprocessed_feedback <- ... # 预处理代码

- svm_model <- svm(preprocessed_feedback, target)

- # 对新的客户反馈进行预测

- new_feedback <- c("非常喜欢这个产品", "这个服务差极了")

- predicted_feedback <- predict(svm_model, new_feedback)

分析结果的应用

分析结果可以应用于改善产品设计、提升服务质量、优化营销策略等。比如,如果反馈中有大量关于产品易用性的负面评论,企业可能需要提供更多的用户培训或改进产品设计。

5.2.2 产品评论情感分析

产品评论情感分析可以帮助企业了解消费者对产品的看法,从而调整产品定位或营销策略。这一过程和微博文本情感分析类似,但是分析对象不同,可能需要考虑行业特性对词汇的影响。

数据获取与预处理

获取电商平台的产品评论数据,进行预处理,包括中文分词、停用词过滤等:

- # 假设已有产品评论数据

- product_reviews <- read.csv("product_reviews.csv")

- docs <- Corpus(VectorSource(product_reviews$text))

- # 预处理步骤

- docs <- tm_map(docs, removePunctuation)

- docs <- tm_map(docs, removeNumbers)

- docs <- tm_map(docs, stripWhitespace)

- docs <- tm_map(docs, content_transformer(tolower))

- docs <- tm_map(docs, content_transformer(jiebaR::segment))

使用LDA模型进行主题提取

可以使用LDA模型来提取产品评论中的主题,并分析各个主题下的情感倾向:

- # 构建LDA模型

- lda_model <- LDA(dtm, k = 10)

- # 提取主题词

- topics <- terms(lda_model, 10)

- topics

- # 分析情感倾向

- sentiment_score <- function(text) {

- # 假设已有情感分析函数

- }

- sentiments <- apply(dtm_df, 1, sentiment_score)

结果分析与决策支持

通过分析每个主题下的情感分数,企业可以判断哪些方面受到消费者的喜爱或不满,从而做出相应的调整。例如,如果某个产品的特定功能总是和负面情感相关联,可能需要对产品功能进行改进。

通过以上两个实际案例的分析,我们看到了tm包在实际文本挖掘任务中的应用潜力和广泛用途。无论是社交媒体文本分析还是商业数据的文本挖掘,tm包都提供了强大的工具来支持分析过程,并能帮助用户提取出有价值的信息。

6. R语言与其他文本挖掘工具的对比

R语言在文本挖掘领域是数据分析师不可或缺的工具,但随着数据科学的发展,许多其他的工具和语言也在文本挖掘方面展现出了强大的能力。在这第六章中,我们将通过对比R语言与其他几种流行的文本挖掘工具,帮助您根据不同的需求选择合适的工具。

6.1 R语言与Python文本挖掘工具对比

6.1.1 工具的生态环境和社区支持

R语言和Python都是开源编程语言,拥有庞大的开发者社区和丰富的第三方包资源。R语言的CRAN(Comprehensive R Archive Network)提供了超过15000个包,其中包含了大量的文本挖掘和自然语言处理工具。而Python则拥有PyPI(Python Package Index),提供了超过200,000个包,覆盖了从数据分析到机器学习的广泛领域。

Python的社区支持包括了TensorFlow, Keras, Scikit-learn等强大的数据科学库,而R语言的社区也有着针对文本挖掘的专门包,如tm包和text2vec等。在社区活跃度方面,Python由于其通用性在数据科学领域的应用更广泛,社区规模较大。

6.1.2 功能及使用场景分析

在功能上,Python和R都有强大的数据处理和机器学习能力。Python因为其灵活性和多用途,广泛用于大规模数据处理和深度学习模型的构建。而R语言则因为其专门的统计包和图形分析功能,在统计建模和可视化方面表现更为出色。

在使用场景上,Python因其简洁的语法和强大的库支持,特别适合于快速开发和集成系统。R语言则更适合于学术研究和统计分析,尤其在文本挖掘和数据可视化方面,R的社区提供了一套完整的工具链。

6.2 R语言与专业文本挖掘软件对比

6.2.1 功能深度与易用性比较

相较于R语言和Python这样的通用编程语言,专业文本挖掘软件如SAS Text Miner、IBM Watson Discovery等提供了更为深入的文本挖掘功能,同时也具备较高的易用性。这些软件通常拥有图形用户界面(GUI),用户无需编写代码即可完成文本挖掘任务,非常适合于那些没有编程背景的用户。

然而,与这些软件相比,R语言和Python提供了更高的灵活性和扩展性。在处理特定需求时,可以通过编写脚本或函数来实现更为复杂的数据处理和分析任务。

6.2.2 商业应用与成本考量

专业文本挖掘软件往往价格不菲,它们提供了良好的技术支持和咨询服务,适合于企业级的应用。而R语言和Python则完全免费,这使得它们在成本敏感的环境中具有明显优势。尤其是R语言,它的社区支持强大,对于学术研究和中小型企业来说,是一种性价比非常高的选择。

在商业应用中,R语言和Python的灵活性和可扩展性让它们能够更好地适应快速变化的业务需求,而无需额外投资新的软件工具。此外,许多企业更倾向于在现有IT栈中整合开源技术,以降低总体拥有成本(TCO)。

总的来说,选择哪种文本挖掘工具,需要根据您的具体需求、技能水平以及预算来定。R语言在文本挖掘领域拥有其独特的地位,但在比较时,考虑到与其他工具的互补性,能够帮助您更好地实现数据分析的目标。