tm包与ggplot2结合:打造数据可视化的大师级作品

发布时间: 2024-11-07 00:08:45 阅读量: 17 订阅数: 28

通信与网络中的基于TM1300的可视电话终端研究

# 1. R语言中的数据可视化概览

在数据分析的领域中,数据可视化不仅是技术的展现,更是沟通的桥梁。本章将为您提供一个R语言中数据可视化技术的概览,并带您了解它在实际业务应用中的重要性以及最佳实践。

在数据分析的过程中,数据可视化可以帮助我们更好地理解数据、发现数据之间的关系、洞悉潜在的趋势和模式,并将这些复杂的信息简洁明了地传达给决策者。R语言,作为统计分析与图形表示的利器,拥有众多的包和函数,使得数据可视化变得既直观又高效。

接下来的章节,我们将逐步深入到R语言包tm(Text Mining)和ggplot2的学习中,从而掌握如何在文本挖掘和复杂数据中提取有价值的信息并以可视化的方式呈现。通过本章的阅读,您将对R语言的图形功能有一个基础的了解,为后续章节的深入学习打下坚实的基础。

# 2. tm包的基础和文本挖掘入门

## 2.1 tm包的安装与加载

### 2.1.1 R语言包管理基础

在R语言中,包管理是使用外部资源和功能扩展的主要方式。R包是一组函数、数据集和预编译代码的集合,它们被组织在一起以解决特定类型的问题。包通常通过CRAN(Comprehensive R Archive Network)发布,也可以是开发人员自行创建的个人包。

R使用内置的包管理系统,可以通过`install.packages()`函数安装新的包。安装包时,R会将包下载到本地,并将其存储在默认的库目录中。安装完成后,使用`library()`或`require()`函数加载包,以便在R会话中使用其功能。

例如,安装tm包的代码如下:

```r

install.packages("tm")

```

安装完成后,加载tm包以便后续操作:

```r

library(tm)

```

### 2.1.2 tm包的安装与库加载

tm包(文本挖掘包)是R中用于文本挖掘任务的主要包之一。它提供了一系列工具,用于文本数据的读取、处理、分析和可视化。tm包通过其一系列函数和类的集合,构建了一个功能强大的文本分析工作流。

安装tm包后,你可以使用`library()`函数来加载它:

```r

library(tm)

```

加载tm包后,即可访问其提供的函数和类,例如`Corpus`类用于创建文档集合,`TermDocumentMatrix`用于生成词项-文档矩阵等。

## 2.2 文本数据的准备和预处理

### 2.2.1 文本数据的读取

文本数据的读取是进行文本分析的第一步。tm包提供了多种读取文本数据的函数,其中`Corpus()`函数是最基础的工具。`Corpus()`函数可以创建一个文档集合对象,它将文本数据组织为可以进行后续处理的格式。

在读取文本数据时,tm包支持多种格式,包括但不限于:

- 纯文本文件(如.txt)

- HTML文件(如.html)

- PDF文件(如.pdf)

- Microsoft Word文档(如.doc, .docx)

例如,从一个本地目录中读取文本文件到`Corpus`对象:

```r

# 创建一个空白的Corpus对象

text_corpus <- Corpus(DirSource(directory = "path/to/your/text/files"))

# 查看Corpus对象中的内容

inspect(text_corpus[1:2])

```

### 2.2.2 文本清洗与预处理技巧

文本数据通常包含大量的噪声,如标点符号、特殊字符、数字等,这些都需要在分析之前进行清洗。tm包中的`tm_map()`函数是进行文本清洗和预处理的强大工具,它允许应用一系列预定义的转换函数到`Corpus`对象中的每个文档。

预处理步骤通常包括:

- 去除标点符号

- 转换为小写

- 移除停用词(例如“和”、“是”)

- 词干提取(stemming)

- 数字处理

下面是一个清洗和预处理`Corpus`对象的例子:

```r

# 将文档转换为小写

text_corpus <- tm_map(text_corpus, content_transformer(tolower))

# 移除标点符号

text_corpus <- tm_map(text_corpus, removePunctuation)

# 移除数字

text_corpus <- tm_map(text_corpus, removeNumbers)

# 移除停用词

text_corpus <- tm_map(text_corpus, removeWords, stopwords("english"))

# 词干提取

text_corpus <- tm_map(text_corpus, stemDocument)

# 查看清洗后的Corpus对象中的内容

inspect(text_corpus[1:2])

```

## 2.3 文本数据的初步分析

### 2.3.1 词频分析

词频分析(Term Frequency Analysis)是文本挖掘中的一项基础工作,用于了解文本中哪些词出现的频率最高,从而发现文本的主题或重点。在tm包中,可以通过构建词项-文档矩阵(Term-Document Matrix)来执行词频分析。

词项-文档矩阵是一个矩阵,其中行表示词汇,列表示文档,矩阵中的元素表示词汇在各个文档中的频率或权重。`TermDocumentMatrix`函数可以用来创建这样的矩阵。

以下是一个创建词项-文档矩阵并分析词频的例子:

```r

# 创建词项-文档矩阵

tdm <- TermDocumentMatrix(text_corpus)

# 查看词项-文档矩阵的前5行5列

inspect(tdm[1:5, 1:5])

# 提取词频数据并排序

findFreqTerms(tdm, lowfreq = 5)

# 绘制词频条形图

freq_terms <- findFreqTerms(tdm, lowfreq = 5)

term_matrix <- as.matrix(TermDocumentMatrix(text_corpus, control = list(dictionary = freq_terms)))

barplot(sort(rowSums(term_matrix), decreasing = TRUE), las = 2, cex.names = 0.7,

main = "Most Frequent Terms", xlab = "Frequency")

```

### 2.3.2 词云的生成与解读

词云(Word Cloud)是一种数据可视化技术,可以直观地展示文本数据中词频的分布情况。在R中,可以使用`wordcloud()`函数生成词云,这个函数位于wordcloud包中,因此需要安装并加载该包。

以下是如何生成词云的步骤:

```r

# 安装wordcloud包(如果尚未安装)

install.packages("wordcloud")

# 加载wordcloud包

library(wordcloud)

# 使用TermDocumentMatrix中的词频数据生成词云

wordcloud(names(freq_terms), freq_terms, min.freq = 5, max.words = 100,

random.order = FALSE, rot.per = 0.35,

colors = brewer.pal(8, "Dark2"))

```

生成的词云中,词汇的大小通常与词频成正比,颜色也可以按照一定规则区分不同的词频区间。通过词云,研究者和分析师可以快速识别出文本中的关键词和重要概念。

在以上章节中,我们介绍了tm包的安装与加载,文本数据的读取、预处理和初步分析。这些基础技能是文本挖掘和分析的起点,对于理解文本数据的结构和内容至关重要。在下一章节中,我们将继续深入探讨tm包与ggplot2结合的实践案例,以及如何通过这些工具构建复杂的文本可视化报告。

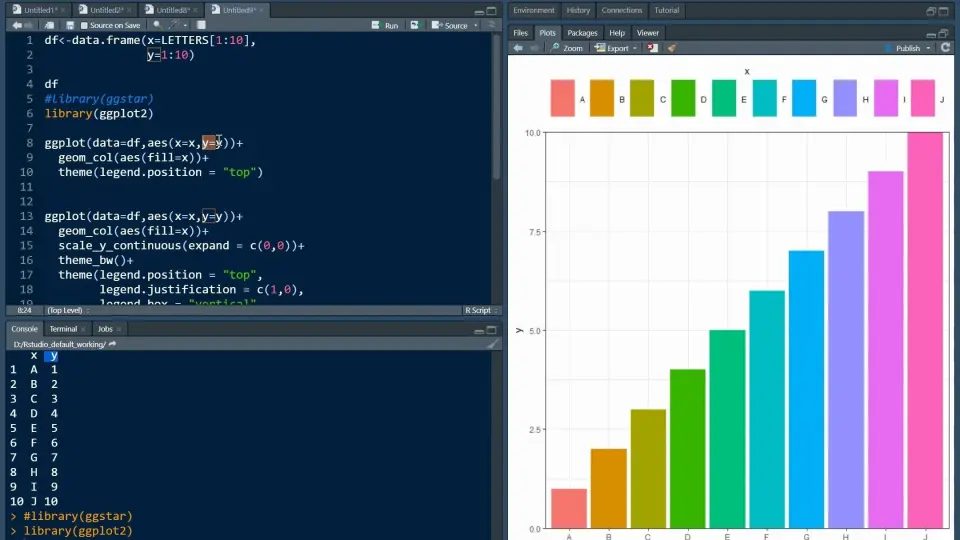

# 3. ggplot2在数据可视化中的应用

## 3.1 ggplot2的基础语法

ggplot2是R语言中最流行的图形库之一,广泛应用于数据可视化领域。它通过图层的概念,使得创建复杂图形变得简单、直观。ggplot2的基础语法主要涉及两个方面:图层概念和基本图形的绘制方法。

### 3.1.1 ggplot2的图层概念

ggplot2的图层模型将图形

0

0