独热编码全面解析:揭秘其必要性及最佳实践方法

发布时间: 2024-11-23 00:16:49 阅读量: 43 订阅数: 32

C++ 中 std::tuple 与 std::pair 的全面解析与应用实践

# 1. 独热编码的概念与重要性

## 1.1 独热编码的定义

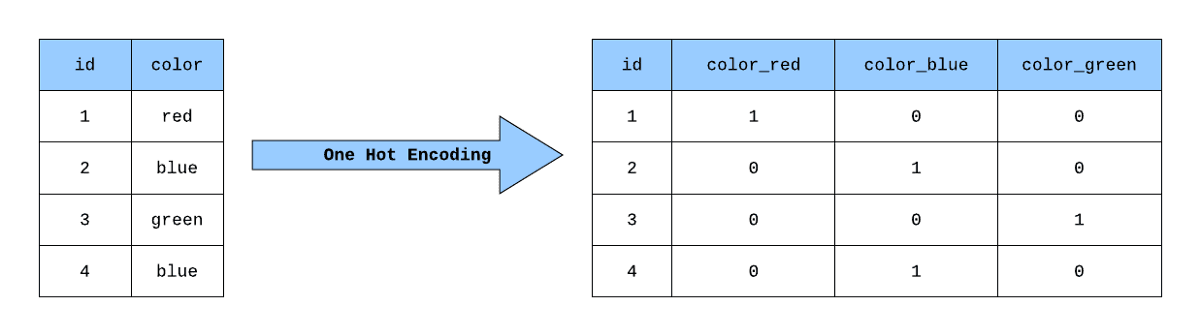

独热编码(One-Hot Encoding),是一种将分类变量转换为机器学习算法可以理解的数字形式的技术。在这一过程中,每个分类值被转换为一个二进制向量,其中只有一个位置为1,其余位置为0。这种编码方式能够直观地表达数据的类别信息,为算法提供了处理类别数据的基础。

## 1.2 独热编码的重要性

独热编码在数据分析和机器学习领域具有重要地位。它能够有效地将非数值型的数据转换为模型能够处理的数值型输入,从而扩展了算法的应用范围。特别在处理类别特征时,独热编码不仅能帮助模型学习到类别之间的差异性,还能避免一些数值排序带来的误导。

## 1.3 独热编码的应用

在实际应用中,独热编码常用于解决分类问题。比如,在自然语言处理中,将单词转换为独热向量来表示其在词汇表中的位置;在图像处理中,独热编码可用于对不同颜色通道的数据进行分类。除此之外,独热编码在推荐系统、异常检测等多类问题中都有其独特的应用场景。随着技术的发展,独热编码的优化方法也在不断演进,以适应更大的数据集和更复杂的数据结构。

# 2. 独热编码的理论基础

## 2.1 独热编码的定义与工作原理

### 2.1.1 独热编码在数据处理中的作用

独热编码(One-Hot Encoding)是一种将分类变量转换为机器学习模型可以理解的形式的过程。它通过创建一个二进制向量来表示分类变量中的每个类别,其中只有一位是1,其余位都是0。这种编码方式在数据处理中非常重要,因为它允许算法处理类别数据,且每个类别都被赋予了等同的数值权重,消除了不同类别间的大小关系。

在机器学习中,许多算法,尤其是基于距离的算法如K-最近邻(K-NN)和支持向量机(SVM),要求输入数据是数值型的。独热编码就是将类别数据转换为数值型的一种方式。此外,它也解决了类别数据中的隐含顺序问题,比如月份中的“1月”和“2月”在数值上是连续的,但实际上并无逻辑上的顺序关系。

### 2.1.2 独热编码与其他编码方式的比较

独热编码虽然在处理类别数据方面非常有用,但它也有一些局限性,特别是在类别数量很多的情况下。例如,如果有数以千计的类别,那么独热编码会生成一个非常稀疏的矩阵,不仅占用了大量的内存,也降低了算法的效率。在这种情况下,标签编码(Label Encoding)可能更高效,它仅仅将每个类别转换为一个唯一的整数。

对于一些需要保持类别之间相对顺序的场景,序数编码(Ordinal Encoding)会是一个更好的选择。序数编码同样将类别转换为整数,但是它保留了类别间的顺序关系。

## 2.2 独热编码的数学基础

### 2.2.1 线性代数在独热编码中的应用

独热编码过程中,会经常用到线性代数中的矩阵操作。例如,对于一个有N个类别的分类变量,独热编码会创建一个N维的向量空间,每个向量对应一个类别。在这个空间中,每个数据点可以被表示为一个向量,向量中的每个元素都是0或1。

矩阵运算中的向量点乘可以用来计算两个独热编码向量之间的相似度。比如,如果我们有两个类别A和B的独热编码向量,我们可以通过计算它们的点乘来找出它们的相似度。如果结果是1,表示两个类别相同;如果是0,则表示两个类别不同。这样的计算可以帮助模型理解不同类别之间的差异。

### 2.2.2 独热编码在机器学习模型中的数学表达

在机器学习模型中,独热编码可以被视为一种特征转换的手段。例如,在逻辑回归模型中,每个特征的独热编码向量会作为模型的一个参数。这样的转换允许模型为每个特征的每个类别学习一个权重。

举个例子,如果我们有“颜色”这个特征,它包含“红色”、“蓝色”和“绿色”三个类别,它们将被转换为三个独热编码向量。逻辑回归模型会为“红色”、“蓝色”和“绿色”各自学习一个权重系数。这样,当模型在做出预测时,就可以根据不同的颜色来调整其预测结果。

## 2.3 独热编码的应用场景分析

### 2.3.1 适用于独热编码的数据类型

独热编码适用于任何分类变量,无论它们是有序的还是无序的。例如,产品类别、国家、性别等都可以通过独热编码进行处理。对于某些特定类型的数据,比如颜色(红、黄、蓝),独热编码可以直观地表达每种颜色的存在性。

然而,独热编码并不适用于高基数的分类数据。当类别数量非常庞大时,独热编码将变得非常低效。这时,可以考虑其他编码策略,如散列技巧(Hashing Trick)或者嵌入式表示(Embeddings)。

### 2.3.2 独热编码在不同领域的具体应用案例

在医学领域,独热编码可以用来处理疾病分类的问题。例如,不同的疾病编码可以用作训练数据,通过独热编码转换后,机器学习模型可以对新病例进行分类预测。

在金融领域,独热编码可以用于信用评分。客户的信用状态,如“高”、“中”、“低”,可以通过独热编码转换为模型可以理解的数值形式,进而用来预测信贷风险。

### 代码实现和逻辑分析

下面是使用Python中`pandas`库对分类变量进行独热编码的一个例子:

```python

import pandas as pd

# 假设有一个包含分类数据的DataFrame

data = {'Color': ['Red', 'Blue', 'Green', 'Blue']}

df = pd.DataFrame(data)

# 使用get_dummies函数进行独热编码

df_encoded = pd.get_dummies(df, columns=['Color'])

print(df_encoded)

```

执行上述代码后,得到的`df_encoded` DataFrame将包含三列:Color_Red、Color_Blue和Color_Green。每个类别将对应一列,其中只有一项为1,其他为0。例如,'Red'对应的行,在Color_Red列将是1,在Color_Blue和Color_Green列将是0。这样就完成了从原始分类数据到独热编码的转换。

此代码中,`get_dummies`函数创建了一个新的DataFrame,其中包含了原始分类数据的独热编码表示。这使得原始数据可以用于诸如机器学习这样的数值计算。

# 3. 实现独热编码的实践技巧

在数据预处理的众多技术中,独热编码(One-Hot Encoding)是一种极其重要且常用的技巧,特别是在机器学习和数据分析领域。它是将分类变量转换为一种形式,使得机器学习算法可以更好地处理这些特征。本章节将深入探讨如何在不同编程语言中实现独热编码,以及在实践过程中的一些技巧、性能优化方法和工具。

## 3.1 编程语言中的独热编码实现

在编码实践中,独热编码的实现依赖于特定的编程语言和库。Python和R语言是两个广受数据科学家喜爱的语言,本节将分别展示如何在这两种语言中实现独热编码。

### 3.1.1 Python中的独热编码实现步骤

Python广泛应用于数据科学,其中Pandas库提供了直接对分类数据进行独热编码的功能。以下是使用Pandas进行独热编码的基本步骤。

```python

import pandas as pd

# 假设有一个简单的数据集

data = pd.DataFrame({

'Color': ['Red', 'Blue', 'Green', 'Green', 'Blue']

})

# 使用Pandas的get_dummies函数进行独热编码

one_hot_encoded = pd.get_dummies(data['Color'], prefix='Color')

print(one_hot_encoded)

```

#### 代码逻辑解读

- 首先,我们导入Pandas库,并创建一个包含颜色数据的DataFrame。

- 使用`pd.get_dummies()`函数,将分类变量`'Color'`转换为独热编码。

- `prefix`参数用于指定独热编码的列前缀,避免和其他特征重复。

独热编码完成后,每个颜色类别都会被表示为一个独立的列,其中的值为0或1。1表示该行数据属于该类别。

### 3.1.2 R语言中的独热编码函数应用

R语言在统计分析领域有着悠久的历史,其中的`model.matrix`函数是一个强大的工具,可以用于实现独热编码。

```r

# 创建一个包含颜色数据的向量

color_vector <- c('Red', 'Blue', 'Green', 'Green', 'Blue')

# 使用model.matrix函数创建独热编码矩阵

one_hot_encoded <- model.matrix(~ color_vector - 1)

print(one_hot_encoded)

```

#### 代码逻辑解读

- 我们首先创建了一个包含颜色类别的向量。

- `model.matrix`函数用于生成一个设计矩阵,`~ color_vector - 1`参数指定生成独热编码,减去1表示不创建截距项。

- 输出的矩阵展示了独热编码的结果,每种颜色对应一列。

R语言通过这种方式将分类变量转换为适用于统计模型的数据格式。

## 3.2 独热编码的库和工具

独热编码的库和工具在处理大量数据或进行复杂数据预处理时特别有用。本节将介绍一些常用的库和工具,并比较它们的优缺点。

### 3.2.1 介绍常用的独热编码库和工具

在Python中,除了Pandas之外,Scikit-learn也提供了独热编码的工具。在R语言中,`caret`包是另一个常用的选择。这里重点介绍Scikit-learn和`caret`的使用。

```python

from sklearn.preprocessing import OneHotEncoder

# 假设有一个二维数组,第一列是分类变量

data = [[1, 'Red'], [2, 'Blue'], [3, 'Green'], [4, 'Green'], [5, 'Blue']]

# 创建独热编码器实例

encoder = OneHotEncoder(sparse=False)

# 拟合并转换数据

encoded_data = encoder.fit_transform([[x] for x, _ in data])

print(encoded_data)

```

```r

library(caret)

# 创建一个包含颜色数据的因子向量

color_factor <- as.factor(c('Red', 'Blue', 'Green', 'Green', 'Blue'))

# 使用train函数来进行独热编码

one_hot_encoded <- dummyVars(~., data.frame(color_factor))

# 转换数据

one_hot_encoded_data <- data.frame(predict(one_hot_encoded, newdata=data.frame(color_factor=color_factor)))

print(one_hot_encoded_data)

```

在Python中,Scikit-learn的`OneHotEncoder`可以对带标签的数据进行独热编码。在R语言中,`caret`包的`dummyVars`函数同样提供了灵活的方式来生成独热编码。

### 3.2.2 库和工具的比较与选择

选择合适的独热编码库和工具需要考虑数据的规模、库的性能、易用性等因素。

- Pandas提供快速直接的方法处理较小的数据集,易于上手。

- Scikit-learn的`OneHotEncoder`适合集成到更复杂的机器学习管道中。

- `caret`包是R语言中一个功能强大的数据预处理工具,适合对大规模数据集进行复杂的转换。

## 3.3 独热编码的性能优化

随着数据集规模的增大,独热编码可能会导致维度灾难。优化独热编码的性能是数据科学家不可忽视的任务。

### 3.3.1 独热编码在大数据集上的处理优化

对于大规模数据集,常见的优化方法包括:

- **稀疏矩阵**:使用稀疏矩阵来存储独热编码数据可以显著减少内存的使用,因为大多数独热编码后的数据为0。

- **特征选择**:通过特征选择去除不必要的独热编码特征,可以减少计算量并提升模型性能。

- **降维技术**:应用PCA、t-SNE等降维技术压缩独热编码后的数据。

### 3.3.2 优化算法的选择与实现

优化算法的选择需要基于具体的数据集特性和需求。例如,如果数据集中类别变量非常多,可能需要采用一些更高级的编码方法,如目标编码(Target Encoding)。

```python

from sklearn.preprocessing import LabelEncoder

# 假设有一个包含类别标签的列表

category_labels = ['Red', 'Blue', 'Green', 'Green', 'Blue']

# 创建标签编码器

label_encoder = LabelEncoder()

# 将类别标签编码为整数

encoded_labels = label_encoder.fit_transform(category_labels)

print(encoded_labels)

```

在这个例子中,我们使用`LabelEncoder`将类别标签编码为一个整数序列。这种方法在处理大规模类别特征时可以节省内存空间。

为了更深入地理解独热编码在实践中如何应用,让我们探索一些更具体的应用场景和技巧。

至此,本章节通过代码示例、逻辑分析和性能优化的讨论,已经较为全面地展示了独热编码的实现技巧。下一章将通过案例分析来进一步说明独热编码在数据预处理和机器学习模型中的最佳实践。

# 4. 独热编码最佳实践案例分析

### 4.1 数据预处理中的独热编码应用

在数据分析和机器学习的流程中,数据预处理是至关重要的一步。独热编码作为数据预处理中常用的技术之一,能够将分类变量转换为模型可理解的数值形式,这对于提高模型性能至关重要。本节将探讨独热编码在数据预处理中的应用,以及如何有效地将特征选择与独热编码结合。

#### 4.1.1 数据集特征工程中的独热编码实例

特征工程是机器学习模型成功的关键,而独热编码在特征工程中的作用是将类别型变量转换为数值型变量。例如,在一个零售数据集中,商品分类是一个重要的特征,我们可以使用独热编码将这些类别转换为0和1的格式,以便算法能够处理。

以Python中的Pandas库和Scikit-learn库为例,下面的代码展示了如何在数据集中实现独热编码:

```python

import pandas as pd

from sklearn.preprocessing import OneHotEncoder

# 创建一个简单的DataFrame来展示独热编码

data = {

'Product_Type': ['Electronics', 'Books', 'Home Appliances', 'Books'],

'Product_Price': [150, 20, 300, 25]

}

df = pd.DataFrame(data)

# 使用Pandas的get_dummies方法实现独热编码

df_one_hot = pd.get_dummies(df, columns=['Product_Type'], prefix=['Product_Type'])

# 或者使用Scikit-learn的OneHotEncoder

encoder = OneHotEncoder(sparse=False)

product_types = df[['Product_Type']]

product_types_encoded = encoder.fit_transform(product_types)

# 将数组转换回DataFrame以便展示

product_types_encoded_df = pd.DataFrame(product_types_encoded, columns=encoder.get_feature_names_out(['Product_Type']))

# 展示编码后的数据集

df_one_hot.join(product_types_encoded_df)

```

#### 4.1.2 特征选择与独热编码的结合

在实施特征选择时,我们往往会考虑到哪些特征对于模型的预测有贡献。独热编码不仅仅可以转换类别数据,还可以与特征选择方法结合,帮助我们分析和挑选最有用的特征。

特征选择的一个简单例子是使用卡方检验(Chi-Squared Test)来确定哪些特征与目标变量之间有统计意义上的相关性。在使用独热编码后,可以通过卡方检验来评估独热编码后的新特征与目标变量的关系。

```python

from sklearn.feature_selection import SelectKBest, chi2

# 假设目标变量为y,并假设y已经与df对齐

# 使用SelectKBest选择与y最相关的k个特征

chi_selector = SelectKBest(chi2, k='all')

X_new = chi_selector.fit_transform(df_one_hot.drop('Product_Price', axis=1), y)

# 展示选择后的特征

selected_columns = df_one_hot.drop('Product_Price', axis=1).columns[chi_selector.get_support()]

print(selected_columns)

```

### 4.2 独热编码在机器学习模型中的实践

独热编码不仅在数据预处理中有应用,在构建机器学习模型时,它也是重要的一步。在分类问题和回归问题中,独热编码有助于改进模型的性能。

#### 4.2.1 独热编码在分类问题中的应用

在分类问题中,独热编码可以将类别标签转换为一个或多个二进制列,从而使分类算法能够处理。例如,在信用卡欺诈检测问题中,交易类型是一个关键特征。通过独热编码,我们可以将这些类型转换为可训练的数值特征。

假设我们有以下交易类型的分类数据:

```python

# 示例交易类型数据

transactions = ['online', 'store', 'store', 'online']

```

我们可以使用以下代码将其转换为独热编码:

```python

import pandas as pd

from sklearn.preprocessing import OneHotEncoder

# 将数据转换为Pandas Series

transactions_series = pd.Series(transactions)

# 使用OneHotEncoder进行独热编码

encoder = OneHotEncoder()

encoded_transactions = encoder.fit_transform(transactions_series.values.reshape(-1,1))

# 展示编码后的数据

encoded_transactions.toarray()

```

#### 4.2.2 独热编码在回归问题中的应用

尽管独热编码通常用于分类问题,但在某些情况下,它也可以用于回归问题。例如,如果我们有一个包含多个类别型自变量的线性回归模型,可以将这些类别型自变量转换为独热编码形式,并将其包含在模型中。

以一个简单的线性回归问题为例,考虑一个包含“城市”变量的数据集,其中“城市”是一个类别型变量。我们可以对这个变量进行独热编码,然后将其作为特征之一加入到线性回归模型中:

```python

import pandas as pd

from sklearn.linear_model import LinearRegression

# 假设数据集包含“城市”和“房价”两个特征

data = {

'City': ['CityA', 'CityB', 'CityC', 'CityA'],

'House_Price': [300000, 450000, 200000, 330000]

}

df = pd.DataFrame(data)

# 独热编码“城市”变量

city_encoded = pd.get_dummies(df['City'], drop_first=True)

# 将编码后的数据与原始数据合并

df_encoded = pd.concat([df.drop('City', axis=1), city_encoded], axis=1)

# 创建线性回归模型并拟合数据

model = LinearRegression()

model.fit(df_encoded.drop('House_Price', axis=1), df_encoded['House_Price'])

# 输出模型的系数

print(model.coef_)

```

### 4.3 独热编码常见问题及解决方案

#### 4.3.1 遇到的常见问题分析

在应用独热编码时,可能会遇到一些问题,这些问题包括:独热编码可能引起的维度爆炸问题、处理未知类别、以及独热编码与正则化之间的关系等。解决这些问题对于提升模型的性能至关重要。

- 维度爆炸:独热编码可能会导致数据集的特征数量急剧增加,这对于算法的训练效率和模型的泛化能力都有负面影响。在这种情况下,可以采用特征选择技术来减少不必要的特征,或者使用嵌入式方法(如使用L1正则化的线性模型)进行特征选择和压缩。

- 未知类别问题:在实际应用中,新的类别可能会在测试阶段出现。如果在训练阶段没有遇到这些类别,独热编码就会失败。针对这个问题,可以使用一些策略,比如在训练数据中预留一部分类别未编码,或者在编码过程中加入一个默认的“未知”类别。

- 独热编码与正则化的关系:独热编码会增加模型的复杂度,若没有适当的正则化,模型可能会过拟合。通过加入正则化项,如L1或L2,可以帮助模型在高维特征空间中避免过拟合。

#### 4.3.2 解决方案和调试技巧

针对上述提到的常见问题,我们提供以下解决方案和调试技巧:

- **维度压缩**:使用特征选择方法来减少特征的数量,或者采用降维技术(如主成分分析,PCA)来减少特征维度。

- **添加未知类别处理**:为独热编码设置一个默认的“未知”类别,确保在测试数据中遇到新类别时,模型不会因为找不到对应编码而失败。

- **正则化应用**:在模型训练时加入正则化项,尤其是针对高维特征空间,以防止过拟合问题。

调试技巧包括:

- **交叉验证**:使用交叉验证来评估模型在不同数据子集上的性能,以确保模型具有良好的泛化能力。

- **特征重要性分析**:分析不同特征对模型预测的影响,理解哪些特征对于模型最为关键。

- **使用专门的库**:利用如`Featuretools`和`Category_encoders`等专门的库来进行特征工程,这些库能够提供更多的功能和更好的调试接口。

通过这些解决方案和技巧,我们可以有效地利用独热编码来改善机器学习模型的性能,并解决在实践中可能遇到的问题。

# 5. 展望独热编码的未来趋势

## 5.1 独热编码的发展前景

### 5.1.1 当前技术限制与改进方向

独热编码虽然在数据处理和机器学习中有着广泛的应用,但也存在一些技术限制。其中最显著的问题之一就是高维稀疏性,这会导致模型训练效率的下降,尤其是在需要处理大规模数据集的情况下。另一个问题是它不携带任何关于类别间关系的信息,因此在处理类别之间存在自然顺序或层级关系时效果不佳。

为应对这些限制,研究者们正在探索多种改进方法。一种策略是使用哈希技巧将类别特征映射到低维空间,从而减少计算复杂度和存储空间需求。另一种方法是采用多热编码(multi-hot encoding),允许一个样本对应多个类别标签,这样可以在一定程度上捕捉类别之间的关系。

### 5.1.2 未来研究和应用的新趋势

随着深度学习技术的发展,独热编码的未来趋势可能与深度学习结合得更加紧密。例如,嵌入式学习(Embedding Layers)已经在很多深度学习框架中作为处理类别特征的首选方法,它通过学习一个稠密的低维表示来克服独热编码的一些缺点。此外,随着联邦学习(Federated Learning)和隐私保护计算(Privacy-Preserving Computing)的兴起,独热编码也可能与这些技术相结合,以提供安全、有效的数据处理方案。

## 5.2 独热编码与其他技术的融合

### 5.2.1 独热编码与深度学习的结合

深度学习模型通常处理的是连续的数据,但是独热编码的加入可以使得深度学习模型能够处理类别数据。结合深度学习的独热编码可以在模型中创造一个嵌入层,该层通过学习来降低高维独热向量的维度,同时提取出有用的特征表示。这种技术结合不仅保持了类别数据的性质,同时通过学习过程赋予了这些数据更加丰富的语义信息。

### 5.2.2 独热编码在新兴领域的潜在应用

独热编码作为一种有效的数据预处理手段,在生物信息学、自然语言处理、推荐系统等新兴领域也展现出了巨大的应用潜力。例如,在基因表达数据分析中,独热编码可以帮助将基因名称转换为机器可理解的格式;在推荐系统中,用户的历史行为数据可以通过独热编码转换为特征向量,以训练预测模型。随着这些领域数据量的不断增长,独热编码方法也需要不断进化,以适应更加复杂的数据结构和分析需求。

在未来,独热编码与其他技术的融合可能会开辟更多的研究领域和应用空间,同时也将带来新的挑战,例如如何在保持模型性能的同时减少计算资源的消耗,以及如何更有效地融合独热编码与其他先进的机器学习技术。随着技术的发展,我们有理由相信独热编码将在数据科学的各个领域发挥更加重要的作用。

0

0