特征工程进阶:独热编码与嵌入式表示的融合秘籍

发布时间: 2024-11-23 00:47:38 阅读量: 34 订阅数: 21

嵌入式系统的热管理:策略、实践与代码示例

# 1. 特征工程概述与重要性

## 1.1 特征工程的定义与目的

特征工程是数据科学领域的重要环节,它涉及选择、修改和创建变量的过程,旨在提高预测模型的性能和准确性。通过转化原始数据为模型可以有效学习的形式,特征工程有助于提升模型的解释力和泛化能力。

## 1.2 特征工程在机器学习中的角色

在机器学习流程中,特征工程通常是迭代的过程,其重要性仅次于数据收集阶段。通过精心设计的特征,可以使得简单模型达到复杂模型的性能,甚至通过特征的深入挖掘,能够揭露数据间不为人知的模式。

## 1.3 特征工程的挑战与未来趋势

尽管特征工程具有显著的重要性,但其过程往往复杂且耗时,需要深度的领域知识和经验。随着人工智能技术的发展,特征工程正逐步走向自动化和智能化,使得在不同领域中广泛应用成为可能。

# 2. 独热编码的理论与实践

## 2.1 独热编码的概念和原理

### 2.1.1 分类变量与编码

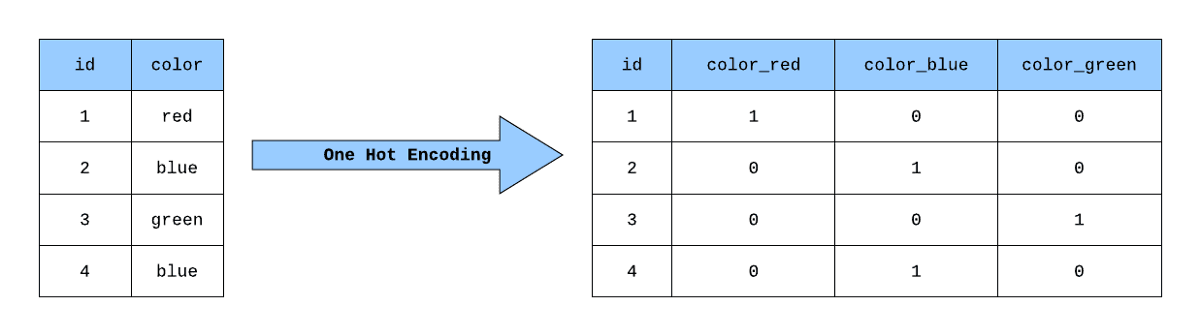

分类变量是数据分析中常见的变量类型,它们代表了不同类别的属性,例如性别(男、女)、颜色(红、蓝、绿)等。与数值型变量不同,分类变量无法进行算术运算。为了在机器学习模型中使用这些变量,我们需要一种方法将它们转换为数值形式。这就是独热编码(One-Hot Encoding)发挥作用的地方。

独热编码通过创建一个新的二进制列来表示每个类别值,每个类别值在这些列中只有一个“1”,其余为“0”。这样,模型就可以将这些列作为输入,而不会误认为数字大小有特别的意义。例如,对于性别变量,我们可以创建两个列:`is_male`和`is_female`。对于一个男性样本,`is_male`将是1,`is_female`将是0;反之亦然。

### 2.1.2 独热编码的优势和局限性

独热编码的一个主要优势在于它的简单直观。它允许分类数据在不影响原始类别意义的情况下被处理和分析。此外,它也支持基于模型的特征选择方法,例如线性模型或树模型。

然而,独热编码也有其局限性,尤其在类别值较多的情况下。当类别数量庞大时,独热编码会生成大量的新特征,这将导致“维度灾难”,并可能增加模型训练的难度和计算资源的消耗。同时,独热编码也会引入所谓的“稀疏性”问题,大多数值为0,这使得特征矩阵变得非常稀疏,可能影响模型的泛化能力。

## 2.2 独热编码的实现技术

### 2.2.1 传统编程方法

在传统编程中,我们可以使用如Python中的Pandas库来手动实现独热编码。以下是一个简单的示例:

```python

import pandas as pd

# 假设有一个分类变量的DataFrame列

data = {'Color': ['Red', 'Green', 'Blue', 'Green']}

df = pd.DataFrame(data)

# 手动进行独热编码

one_hot_encoded = pd.get_dummies(df['Color'])

print(one_hot_encoded)

```

上述代码将`Color`列转换为独热编码形式,并且输出一个新的DataFrame。输出的结果将如下:

```

Blue Green Red

0 0 0 1

1 0 1 0

2 1 0 0

3 0 1 0

```

### 2.2.2 使用机器学习框架进行独热编码

现代机器学习框架,如scikit-learn,提供了独热编码的简便方法。`OneHotEncoder`类可以很容易地集成到数据预处理流程中。例如:

```python

from sklearn.preprocessing import OneHotEncoder

# 创建OneHotEncoder实例

encoder = OneHotEncoder()

# 为编码器提供数据

X = df[['Color']].values

encoder.fit(X)

# 变换数据

one_hot_encoded = encoder.transform(X).toarray()

print(one_hot_encoded)

```

### 2.2.3 独热编码在不同数据集上的应用

在不同的数据集上应用独热编码时,需要考虑数据集的特性,比如类别值的分布和频率。有时,会使用带有权重的独热编码来给予某些类别更高的重要性。此外,当类别不平衡时,可以考虑使用`RareLabelEncoder`或`TargetEncoder`等编码技术。

## 2.3 独热编码的挑战与解决方案

### 2.3.1 高维度问题与解决方案

面对高维度问题,可以采用特征选择技术减少维度,或者使用嵌入式表示方法,如词嵌入技术。此外,维度缩减技术如主成分分析(PCA)也可以用来降低特征空间的维度。

### 2.3.2 独热编码的性能优化

独热编码的性能优化通常涉及减少不必要的特征,例如通过特征选择或特征提取方法来减少稀疏性。还可以使用模型的正则化技术来抑制模型对噪音的敏感度。在某些情况下,使用`TargetEncoder`代替`OneHotEncoder`可以提高模型性能,尤其是当类别标签也是数值型时。

现在,让我们更详细地探讨独热编码的实现技术。

# 3. 嵌入式表示的理论与实践

## 3.1 嵌入式表示的原理与数学基础

在机器学习和深度学习领域,数据表示的方式直接影响模型的性能。传统的数据表示往往依赖于人工特征工程,但在许多情况下,能够自动生成和优化特征的嵌入式表示技术逐渐成为研究和应用的热点。嵌入式表示可以看作是一种将数据点映射到一个新的空间中的方法,该空间能够捕捉原始数据中的重要特征,同时减少噪声和冗余信息。

### 3.1.1 词嵌入的概念

以自然语言处理(NLP)为例,词嵌入是嵌入式表示的一种具体应用。它将词语通过向量的形式表达在多维空间中,词语之间的语义关系通过向量间的距离来体现。词嵌入技术的出现,让深度学习模型可以高效地处理词语之间的关系,进而改善语言模型的性能。

### 3.1.2 嵌入式表示在高维数据中的作用

嵌入式表示不仅仅适用于文本数据,同样在图像、声音、传感器数据等高维数据中有着广泛的应用。在高维数据中,嵌入式表示的作用主要体现在两个方面:降维和特征提取。降维可以减少计算复杂度,提升模型的运行速度;特征提取则增强了模型对关键信息的捕捉能力。

## 3.2 嵌入式表示的构建方法

构建嵌入式表示的方法可以分为无监督学习方法和监督学习方法两大类。不同的构建方法在不同的应用场景下有不同的表现。

### 3.2.1 无监督学习方法

无监督学习方法中最著名的当属Word2Vec和GloVe,它们通过分析文本数据中的词语上下文关系,自动学习词语的嵌入表示。以下是使用Gensim库实现Word2Vec的一个简单示例:

```python

from gensim.models import Word2Vec

# 示例数据集

sentences = [['this', 'is', 'a', 'sample'], ['this', 'is', 'another', 'example']]

# 构建Word2Vec模型

model = Word2Vec(sentences, vector_size=100, window=5, min_count=1, workers=4)

# 获取词向量

vector = model.wv['example']

print(vector)

```

在这个例子中,我们首先导入了Gensim库中的

0

0