避免独热编码陷阱:专家指导常见错误及预防

发布时间: 2024-11-23 00:28:49 阅读量: 49 订阅数: 33

# 1. 独热编码的基本概念与应用

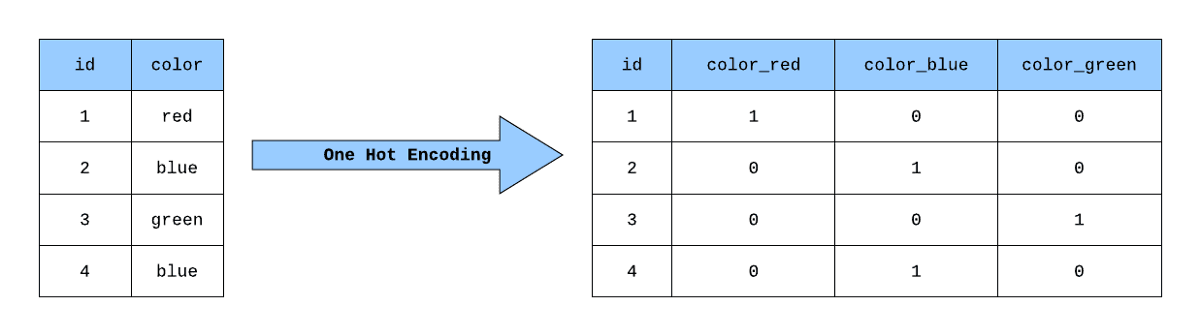

在机器学习和数据科学领域,数据预处理是一个重要的步骤。独热编码(One-Hot Encoding)是处理类别特征的一种常用技术,它将分类变量转换为机器学习算法能够理解的格式。独热编码通过为每一个类别特征创建一个二进制向量来实现,这些向量中的元素为0或1,只有一个位置为1,表示该样本属于某一类别。

## 独热编码的工作原理

独热编码的工作原理相对简单,但非常有效。例如,对于一个特征“颜色”,它可能有三个类别“红”,“蓝”,“绿”,独热编码会为这三个类别分别创建三个新的列,对于颜色为“红”的样本,新的“红色”列会被标记为1,其余为0。

## 独热编码的应用场景

在很多机器学习模型中,如逻辑回归、支持向量机和神经网络,独热编码的应用非常广泛。它允许算法区分和处理类别数据,从而进行有效的预测。例如,在处理客户购买行为的数据集时,通过独热编码可以将性别、产品类别等特征有效转换,以便模型可以学习和预测。

总结起来,独热编码是类别数据预处理的一个关键步骤,能够极大地增强机器学习模型处理分类数据的能力。在接下来的章节中,我们将详细探讨独热编码的错误分析、优化策略和高级应用案例。

# 2. 独热编码常见错误分析

## 2.1 错误的场景应用

### 2.1.1 数据分布不均导致的问题

在机器学习中,数据的分布对于模型的预测能力至关重要。不均匀的数据分布可能会导致模型对某些类别产生偏见,从而降低模型的泛化能力。在使用独热编码时,这种不均匀性可能会被进一步放大。举个例子,如果在数据集中某一类别的样本数量远远超过其他类别,那么在转换成独热编码形式后,这一类别会在特征空间中占据更大的比重,进而导致模型在这个方向上过拟合。

为了避免这种情况,可以采取以下措施:

1. 重新采样:通过过采样少数类别或欠采样多数类别的方法,使数据在类别上的分布更加均匀。

2. 使用类别权重:在训练模型时给不同类别的样本分配不同的权重,以此来平衡类别间的差异。

### 2.1.2 维度灾难与计算资源浪费

独热编码的一个主要缺点是它会导致维度的急剧增加。尤其是当类别变量的数量非常大时,这种编码方式会产生大量的稀疏特征,使得模型的训练和推断变得非常缓慢,并且会消耗大量内存资源。在极端情况下,这种维度灾难会导致“维数的诅咒”,即随着特征数量的增加,模型性能可能会下降。

为了缓解维度灾难,可以尝试以下策略:

1. 特征选择:通过各种算法(如基于模型的特征选择)来识别和删除不重要的特征。

2. 维度缩减:利用PCA、t-SNE等技术来降低特征空间的维度。

## 2.2 编码实现过程中的失误

### 2.2.1 缺少归一化处理的后果

在对特征进行独热编码之后,由于每个特征向量都是稀疏的且每个类别都是二进制表示,它们不再具有相似的尺度。这将导致在模型训练过程中,具有更多类别的特征会主导损失函数,从而影响模型的收敛和性能。因此,在应用独热编码之后,通常需要进行归一化处理,使得每个特征在模型训练中具有相等的重要性。

归一化的常见方法包括:

1. Min-Max归一化:将数据缩放到[0,1]区间内。

2. Z-score标准化:通过减去均值并除以标准差,使得数据具有0均值和单位方差。

### 2.2.2 错误的数据类型和大小处理

在独热编码过程中,正确处理数据类型和大小是至关重要的。如果数据类型不正确或者数据没有正确地转换为整数形式,可能会导致编码失败或生成错误的编码结果。此外,如果数据集很大,错误的大小处理可能会导致内存不足或者计算资源的浪费。

为了避免这种情况,应该注意以下几点:

1. 确保输入数据为整数形式,这是大多数独热编码函数的要求。

2. 对于大型数据集,可以考虑使用在线编码方法来避免内存问题。

## 2.3 结果解释与模型性能评估

### 2.3.1 模型性能下降的信号

模型性能的下降可能是由多种因素导致的,其中独热编码的不当使用是其中之一。如果在模型评估阶段发现性能不佳,应该回过头来检查特征工程环节是否有误。性能下降的常见信号包括但不限于:

1. 分类不准确:模型在特定类别的预测上表现不佳。

2. 过拟合:模型在训练集上表现良好但在验证集上表现差。

3. 训练时间过长:由于维度增多,可能导致训练时间显著增加。

通过识别这些信号,我们可以进一步调试特征处理过程,并对模型做出相应的调整。

### 2.3.2 预测结果的误解和误差来源

在进行独热编码之后,每个类别被转换为一个新的特征维度,这可能会导致模型预测结果的误解。例如,如果模型预测结果中的某一类别的概率特别高,并不代表这个类别一定是对的,因为可能存在其他类别在原始特征空间中具有更高的区分度。

为了减少误解和误差来源,应该:

1. 仔细审查模型的预测输出。

2. 使用交叉验证来评估模型性能的稳定性。

3. 进行错误分析来找出导致预测错误的根本原因。

以上内容涵盖了独热编码在应用时常见的错误场景和失误,并提供了相应的预防和解决策略。在下一章节中,我们将深入探讨如何通过数据预处理和编码技巧来预防这些问题,以及如何选择合适的机器学习模型。

# 3. 独热编码错误的预防与解决方案

## 3.1 数据预处理的优化策略

### 3.1.1 特征选择对独热编码的影响

在机器学习的预处理阶段,特征选择是一个关键步骤,它直接影响到独热编码的有效性和模型性能。特征选择指的是从原始数据集中选择一个子集,该子集包含最能代表数据特性的特征。一个良好的特征选择能够减少模型训练和预测的时间,同时减少内存占用,提高模型的准确性和泛化能力。

独热编码作为一种将类别型特征转换为机器学习模型可以处理的数值型特征的方法,其效率和结果的优劣在很大程度上取决于特征选择的质量。如果选择的特征包含大量噪声或者与目标变量不相关,则可能会导致模型性能下降。反之,如果只选取与目标变量高度相关的特征,则有助于提升模型的预测能力。

```python

from sklearn.feature_selection import SelectKBest, chi2

# 示例数据集

X = [[1, 2, 3], [4, 5, 6]]

y = [1, 0]

selector = SelectKBest(chi2, k=2)

selector.fit(X, y)

```

在上述代码中,使用了`SelectKBest`方法配合`chi2`检验来选择最好的两个特征。`chi2`是一种统计检验方法,用于衡量特征和目标变量之间的独立性。在实际应用中,根据数据集的不同,选择合适的特征选择方法对于提升独热编码后的效果至关重要。

### 3.1.2 数据标准化和归一化的应用

数据标准化和归一化是预处理步骤中不可或缺的一部分,尤其在使用独热编码时,它们可以显著影响模型训练的效率和质量。标准化是将数据按比例缩放,使之落入一个小的特定区间。而归一化是将数据按比例缩放,使之落入[0,1]区间。

数据标准化和归一化可以减少不同特征之间的量级差异,使模型训练过程中各特征的梯度下降速率大体一致,从而加速模型的收敛。在独热编码中,如果存在数值范围差异极大的特征,没有适当的归一化或标准化,那么模型可能会对数值大的特征过分敏感,导致学习过程不稳定。

```python

from sklearn.preprocessing import StandardScaler

# 示例数据集

X = [[1, 2, 3], [4, 5, 6]]

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

```

如上代码所示,我们使用了`StandardScaler`对数据进行了标准化处理。经过标准化处理后的数据,各特征的均值变为0,方差变为1,这有助于独热编码后的特征更加均匀地参与到模型训练中。

## 3.2 编码技巧与实践

### 3.2.1 使用LabelEncoder与OneHotEncoder

在`scikit-learn`中,`LabelEncoder`和`OneHotEncoder`是处理类别特征最常用的工具。`LabelEncoder`可以将类别标签转换成从0开始的整数索引,而`OneHotEncoder`可以将这些整数索引进一步转换为独热编码形式。`OneHotEncoder`通常用于将类别数据转换为模型可以直接处理的格式。

使用`LabelEncoder`时,需要注意的是,它仅适用于二分类问题中的目标变量编码。对于多分类问题,如果直接应用`LabelEncoder`可能会导致不必要的类别顺序,进而影响模型性能。而`OneHotEncoder`则避免了这种问题,因为它是以无序的方式将类别转换为独热编码。

```python

from sklearn.preprocessing import OneHotEncoder, LabelEncoder

# 示例数据集

features = ['red', 'green', 'blue']

encoder = OneHotEncoder()

encoded_features = encoder.fit_transform(features.reshape(-1, 1)).toarray()

```

上述代码展示了如何使用`OneHotEncoder`将颜色标签转换为独热编码。独热编

0

0