:旋转目标检测YOLO的代码实现:从头开始构建你的模型

发布时间: 2024-08-15 22:39:49 阅读量: 46 订阅数: 26

目标检测+旋转目标框+YOLO+小目标检测

# 1. 旋转目标检测概述**

旋转目标检测是一种计算机视觉任务,它旨在检测和定位图像或视频中旋转的物体。与传统的目标检测不同,旋转目标检测需要考虑物体的旋转角度,以获得更准确的定位结果。

旋转目标检测在许多实际应用中具有重要意义,例如:

- 交通监控:检测和跟踪道路上旋转的车辆。

- 工业自动化:检测和定位生产线上的旋转部件。

- 医疗成像:检测和分割医学图像中旋转的解剖结构。

# 2. YOLO算法原理

### 2.1 YOLOv1:单次卷积神经网络

YOLOv1(You Only Look Once)算法于2015年提出,是目标检测领域的一个突破性进展。它首次提出了一种单次卷积神经网络,可以同时预测图像中的所有目标及其位置。

**网络结构:**

YOLOv1采用Darknet-19作为Backbone网络,该网络由19个卷积层和5个池化层组成。在网络的最后,添加了一个全连接层,用于预测目标的边界框和类别。

**目标预测:**

YOLOv1将输入图像划分为7×7的网格,每个网格单元负责预测该区域内的目标。对于每个网格单元,YOLOv1预测:

- 2个边界框(x, y, w, h)

- 20个类别概率

**损失函数:**

YOLOv1使用一个复合损失函数,包括:

- 边界框回归损失:衡量预测边界框与真实边界框之间的距离

- 置信度损失:衡量网格单元中存在目标的概率

- 类别损失:衡量预测类别与真实类别的距离

### 2.2 YOLOv2:改进的网络结构和训练方法

YOLOv2于2016年提出,对YOLOv1进行了多项改进,包括:

**网络结构:**

- 采用Darknet-53作为Backbone网络,该网络具有更深的层数和更多的特征提取能力。

- 在网络中添加了Batch Normalization层,提高了网络的稳定性和训练速度。

**训练方法:**

- 使用了Anchor Box机制,为每个网格单元预定义了一组候选边界框。

- 采用了k-means聚类算法,优化了Anchor Box的尺寸和形状。

- 使用了多尺度训练,提高了模型对不同大小目标的检测能力。

### 2.3 YOLOv3:Anchor Box和损失函数的优化

YOLOv3于2018年提出,进一步优化了YOLO算法,主要包括:

**Anchor Box优化:**

- 引入了3个尺度的Anchor Box,提高了模型对不同大小目标的检测能力。

- 使用了kmeans++算法,优化了Anchor Box的初始化。

**损失函数优化:**

- 重新设计了边界框回归损失,使其更加鲁棒。

- 引入了GIOU损失,衡量预测边界框与真实边界框之间的重叠面积。

- 采用了Focal Loss,降低了负样本对训练的影响。

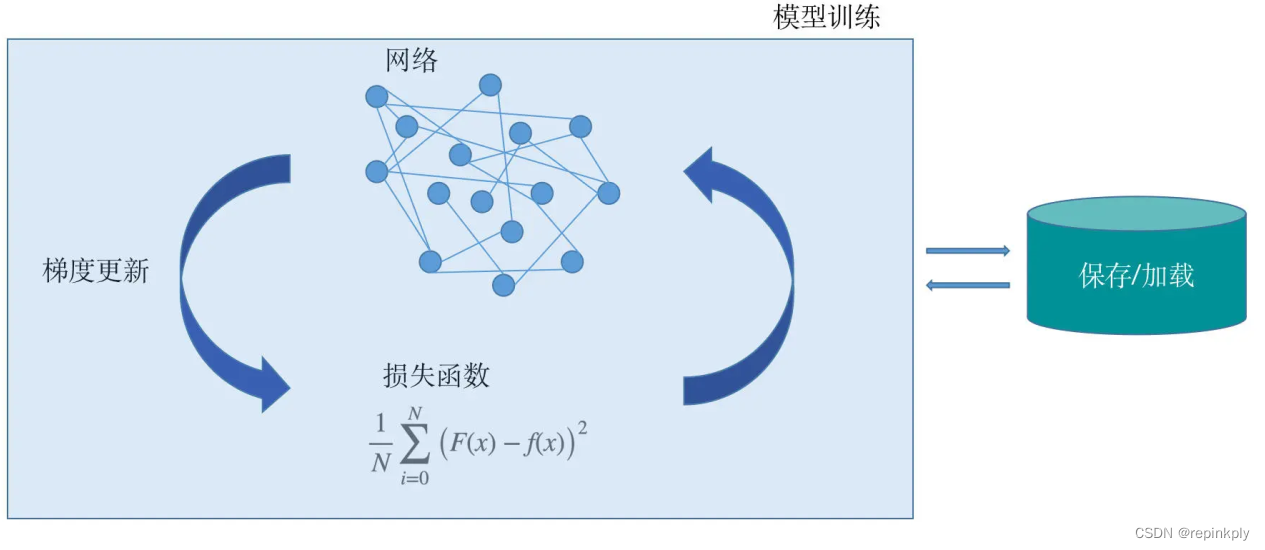

# 3. YOLO代码实现

### 3.1 数据预处理和增强

YOLO算法对数据预处理和增强提出了较高的要求,以保证模型的泛化能力和鲁棒性。数据预处理主要包括图像缩放、裁剪、翻转和颜色抖动等操作,以增强图像的多样性,防止模型过拟合。

### 3.2 网络结构搭建

YOLOv3网络结构主要由主干网络、卷积层、全连接层和输出层组成。主干网络负责提取图像特征,卷积层负责空间特征的提取,全连接层负责分类和回归,输出层负责生成最终的检测结果。

```python

import torch

import torch.nn as nn

class YOLOv3(nn.Module):

def __init__(self, num_classes):

super(YOLOv3, self).__init__()

# 主干网络

self.backbone = ...

# 卷积层

self.conv1 = nn.Conv2d(...)

self.conv2 = nn.Conv2d(...)

# 全连接层

self.fc1 = nn.Linear(...)

self.fc2 = nn.Linear(...)

# 输出层

self.output = n

```

0

0