【高级技能】:Robust Scaler与Quantile Transformer的实战应用

发布时间: 2024-11-20 00:12:12 阅读量: 2 订阅数: 4

# 1. 数据预处理的重要性与挑战

数据预处理是数据科学和机器学习中不可或缺的一环,它的重要性不言而喻。原始数据往往包含许多噪声和不一致性,而预处理工作能够帮助我们清洗和转换数据,以满足后续分析和模型训练的需求。然而,在实际操作中,数据预处理也面临着诸多挑战。数据量的庞大、数据类型和质量的差异性、以及异常值和缺失值的处理等问题,都是数据科学家们需要面对的。

在本章中,我们将探讨数据预处理的基本概念,并深入分析在处理不同数据集时可能遇到的挑战。通过掌握数据预处理的核心技巧,读者将能够更好地准备数据,为建立精确的预测模型打下坚实的基础。接下来的章节将详细介绍一些先进的预处理技术,并通过案例分析展示其在实际应用中的效果和优势。

# 2. Robust Scaler技术深度解析

## 2.1 Robust Scaler基本原理

### 2.1.1 中位数和四分位数的概念

在统计学中,中位数是一组数据值排序后位于中间位置的数值,若数据量为奇数,则为中间的数;若为偶数,则为中间两个数的平均值。它是一种位置度量,能够提供数据集中趋势的信息,相比平均值,中位数对异常值具有更好的鲁棒性。

四分位数是一种分位数,将一组数据分为四个等分,Q1(第一四分位数)是25%的数据点小于它的值,Q3(第三四分位数)是75%的数据点小于它的值。四分位距(IQR)是第三四分位数与第一四分位数的差,用来衡量数据的离散程度,并且在统计学中常被用来识别数据中的异常值。

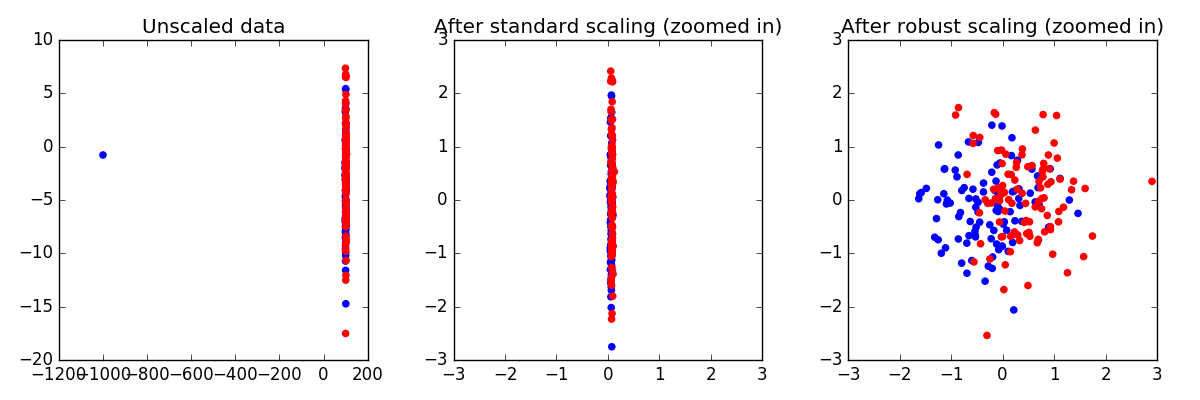

### 2.1.2 Robust Scaler对异常值的处理

Robust Scaler是一种数据预处理技术,主要用于去除数据的单位限制并让特征以统一的尺度进行比较。它不同于标准化(StandardScaler)会受到异常值的影响,Robust Scaler移除了均值和标准差,转而采用中位数和四分位距进行变换。这意味着在数据预处理的过程中,它对于分布中的离群点或异常值具有天然的鲁棒性。

Robust Scaler算法通过减去中位数并除以四分位距来缩放数据,使数据在0附近分布,具有以下特点:

- 对离群点不敏感。

- 保留数据的分布,包括形状和异常值。

- 可以用于各种分布类型的特征,包括高斯分布、非高斯分布等。

## 2.2 Robust Scaler算法实现

### 2.2.1 算法步骤详解

为了深入理解Robust Scaler的实现,可以将其简化为以下几个步骤:

1. 计算数据集中的中位数和四分位数。

2. 对于每个特征值,减去相应特征的中位数。

3. 将步骤2中的结果除以相应特征的四分位距。

4. 将经过以上两步缩放的数据用于后续的分析或模型训练。

### 2.2.2 代码实践:Python中的应用

以下是使用Python中的`sklearn`库进行Robust Scaler操作的一个实例:

```python

from sklearn.preprocessing import RobustScaler

# 假设X是我们的特征矩阵

X = [[10.0, 1200.0], [8.0, 1000.0], [12.0, 1300.0]]

# 初始化RobustScaler

robust_scaler = RobustScaler()

# 训练RobustScaler并转换数据

X_scaled = robust_scaler.fit_transform(X)

# 查看转换后的数据

print(X_scaled)

```

执行逻辑说明:

- 首先,我们导入了`RobustScaler`类。

- 创建一个`RobustScaler`的实例。

- 使用`fit_transform`方法训练模型并转换数据。该方法会计算每个特征的中位数和四分位数,并对数据进行缩放。

- 最后打印出缩放后的数据。

在上述代码中,RobustScaler会计算出每个特征的中位数和四分位距,然后应用公式进行变换。由于它基于位置度量进行缩放,因此不会受到异常值的严重影响。

## 2.3 Robust Scaler的应用案例

### 2.3.1 数据预处理实例分析

为了说明Robust Scaler的实际应用,我们可以考虑一个具体的场景:假设我们正在处理一个金融数据集,其中包含有关客户支出的信息。该数据集包含异常值,如某些异常高的支出记录,这些值可能是由于输入错误或欺诈行为产生的。在这种情况下,Robust Scaler将非常适合,因为它不会让这些异常值对我们的模型产生太大影响。

### 2.3.2 机器学习模型性能提升探讨

当使用Robust Scaler对数据进行预处理后,可以显著提升某些机器学习算法的性能。以支持向量机(SVM)为例,SVM对数据的缩放非常敏感,使用Robust Scaler可以确保每个特征都在一个相似的尺度上被处理,从而可能提高模型的准确性和鲁棒性。

例如,通过下面的Python代码,我们可以构建一个SVM分类器,并使用Robust Scaler对数据进行预处理:

```python

from sklearn.svm import SVC

from sklearn.pipeline import make_pipeline

# 假设X_train和y_train是训练数据集和标签集

# X_train = [...]

# y_train = [...]

# 创建一个管道,将RobustScaler和SVC串联起来

pipeline = make_pipeline(RobustScaler(), SVC())

# 训练管道模型

pipeline.fit(X_train, y_train)

# 评估模型性能

# score = pipeline.score(X_test, y_test)

```

以上代码展示了如何将RobustScaler和SVC结合,用于构建一个对异常值不敏感的机器学习模型。通过这种方式,我们可以减少异常值对模型性能的不利影响,从而提高模型的泛化能力。

# 3. Quantile Transformer的机制与应用

## 3.1 Quantile Transformer原理

### 3.1.1 分位数转换的数学基础

Quantile Transformer通过将数据转换到特定的分位数分布上,以此达到对数据分布的规范化处理。分位数是指将一组数据从小到大排列后,每个数值所占据的位置,如果我们将数据分为100等份,每一份的界限点就称之为百分位数。Quantile Transformer的核心在于将原始数据转换为均匀分布或正态分布,这种转换依赖于累积分布函数(CDF)。

在实际操作中,Quantile Transformer使用经验累积分布函数(ECDF),通过ECDF,我们可以获得数据点在样本中的累积概率。然后,这个累积概率通过特定分布的逆函数进行转换,使得数据点映射到新分布上。例如,如果我们将ECDF应用到均匀分布的逆函数上,原始数据将被转换为均匀分布。

### 3.1.2 对数据分布的影响

使用Quantile Transformer可以显著地改变数据的分布形态。比如,在机器学习模型中,很多算法假定输入数据服从某种分布,如高斯分布。如果数据本身不是这样的分布,这可能会影响模型的学习效率和预测精度。

通过分位数转换,我们可以将数据转换成符合模型假设的分布,提高模型的泛化能力。此外,分位数转换还可以对数据进行非线性变换,这对于那些对数据分布特别敏感的算法,如核方法(如SVM)或者基于距离的算法(如K-最近邻),可以带来性能上的提升。

## 3.2 Quantile Transformer的实现步骤

### 3.2.1 参数调优和应用场景

Quantile Transformer在scikit-learn库中通过`QuantileTransformer`类实现。它有两个主要参数:`n_quantiles`和`output_distribution`。`n_quantiles`定义了要使用的分位数的数量,这个数量决定了ECDF曲线的平滑程度;`output_distribution`参数用于指定输出数据的目标分布,可以是`uniform`(均匀分布)或`normal`(正态分布)。

在应用Quantile Transformer之前,我们应根据数据的特征和后续模型的需求来调优这些参数。如果数据中存在极端的异常值,使用均匀分布进行转换可能会更有效,因为它可以减少异常值对模型的影响。如果模型假设输入数据服从正态分布,那么将`output_distribution`设置为`normal`会更合适。

### 3.2.2 代码实践:Python中的应用

```python

from sklearn.preprocessing import QuantileTransformer

import numpy as np

# 创建一些非正态分布的数据

data = np.random.exponential(size=100)

# 实例化QuantileTransformer,并指定输出为均匀分布

qt = QuantileTransformer(output_

```

0

0