揭秘LSTM:长短期记忆网络,解决RNN梯度消失问题

发布时间: 2024-08-22 11:25:06 阅读量: 42 订阅数: 45

一文搞懂 LSTM(长短期记忆网络).rar

# 1. 长短期记忆网络(LSTM)概述

长短期记忆网络(LSTM)是一种强大的循环神经网络(RNN),专门设计用于处理时序数据。与传统的RNN不同,LSTM能够学习长期依赖关系,克服了RNN中常见的梯度消失问题。

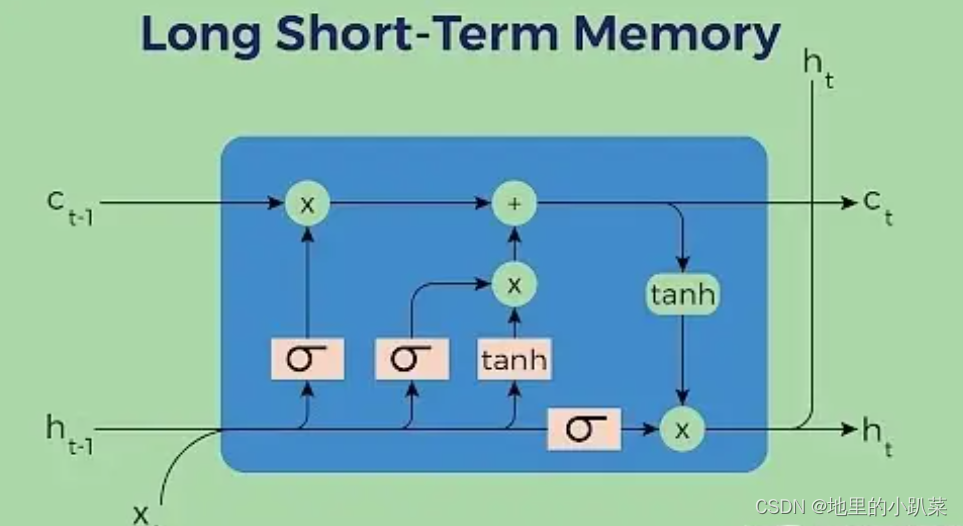

LSTM的基本单元由三个门组成:输入门、遗忘门和输出门。输入门控制新信息的流入,遗忘门决定丢弃哪些信息,输出门决定输出哪些信息。通过这种机制,LSTM可以有效地记住相关信息,同时忘记不相关的信息。

LSTM在自然语言处理、时间序列预测等领域取得了显著的成功。在自然语言处理中,LSTM被用于文本分类、情感分析、机器翻译和文本摘要。在时间序列预测中,LSTM被用于股票价格预测、经济预测、医疗诊断和疾病预测等任务。

# 2. LSTM的理论基础

### 2.1 LSTM的结构和原理

#### 2.1.1 LSTM单元的组成和功能

长短期记忆网络(LSTM)是一种特殊的循环神经网络(RNN),专门设计用于解决RNN中存在的梯度消失问题。LSTM单元是LSTM网络的基本组成单元,它包含三个门控结构:输入门、遗忘门和输出门。

* **输入门:**决定哪些新信息将被添加到单元状态中。

* **遗忘门:**决定哪些现有信息将被从单元状态中遗忘。

* **输出门:**决定哪些信息将被输出到下一个单元。

LSTM单元的状态是一个向量,它存储着网络在当前时间步的记忆。输入门和遗忘门共同控制着状态的更新,而输出门控制着状态输出的信息。

#### 2.1.2 LSTM的训练过程

LSTM的训练过程与其他RNN类似,使用反向传播算法。然而,由于LSTM单元的复杂结构,其训练过程可能更加复杂。

* **前向传播:**输入序列被逐个馈送到LSTM网络中。每个LSTM单元计算其状态和输出。

* **反向传播:**计算损失函数关于网络权重的梯度。

* **权重更新:**使用梯度下降法更新网络权重,以最小化损失函数。

### 2.2 LSTM与RNN的比较

#### 2.2.1 梯度消失问题的产生和影响

在RNN中,随着时间步的增加,梯度会指数级地消失或爆炸。这使得RNN难以学习长期依赖关系。

梯度消失问题产生的原因是RNN中权重的重复乘法。当权重小于1时,随着时间步的增加,权重相乘的结果会越来越小,导致梯度消失。

#### 2.2.2 LSTM如何解决梯度消失问题

LSTM通过其门控结构解决了梯度消失问题。输入门和遗忘门可以控制信息在单元状态中的流动,防止梯度消失。

* **输入门:**允许新信息进入单元状态,从而防止梯度消失。

* **遗忘门:**选择性地遗忘不相关的信息,从而防止梯度爆炸。

通过这种方式,LSTM能够有效地学习长期依赖关系,克服了RNN的局限性。

# 3.1 自然语言处理

LSTM在自然语言处理领域得到了广泛的应用,主要体现在以下两个方面:

#### 3.1.1 文本分类和情感分析

文本分类是指将文本内容自动归类到预定义的类别中,例如新闻、体育、娱乐等。情感分析是指识别文本中表达的情感,例如积极、消极或中立。

LSTM在文本分类和情感分析中表现出色,因为它能够有效地捕获文本中的长期依赖关系。例如,在情感分析中,LSTM可以识别文本中具有相反含义的单词,例如“不”和“好”,并将其对文本情感的影响考虑在内。

**代码示例:**

```python

import tensorflow as tf

# 创建LSTM模型

model = tf.keras.models.Sequential([

tf.keras.layers.Embedding(10000, 128),

tf.keras.layers.LSTM(128),

tf.keras.layers.Dense(2, activation='softmax')

])

# 训练模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

model.fit(X_train, y_train, epochs=10)

# 评估模型

model.evaluate(X_test, y_test)

```

**逻辑分析:**

* **Embedding层:**将单词转换为稠密向量,捕获单词的语义信息。

* **LSTM层:**学习文本中的长期依赖关系,识别文本中的模式和特征。

* **Dense层:**将LSTM层的输出映射到文本分类或情感分析的类别。

#### 3.1.2 机器翻译和文本摘要

机器翻译是指将一种语言的文本翻译成另一种语言。文本摘要是指将长文本缩减为更短、更简洁的摘要。

LSTM在机器翻译和文本摘要中发挥着重要作用,因为它能够处理复杂的长文本序列。LSTM可以学习不同语言之间的语法和语义规则,并生成流畅、准确的翻译或摘要。

**代码示例:**

```python

import tensorflow as tf

# 创建LSTM模型

encoder = tf.keras.models.Sequential([

tf.keras.layers.Embedding(10000, 128),

tf.keras.layers.LSTM(128)

])

decoder = tf.keras.models.Sequential([

tf.keras.layers.Embedding(10000, 128),

tf.keras.layers.LSTM(128)

])

# 训练模型

encoder.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

decoder.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

encoder.fit(X_train, y_train, epochs=10)

decoder.fit(X_test, y_test, epochs=10)

# 评估模型

encoder.evaluate(X_test, y_test)

decoder.evaluate(X_test, y_test)

```

**逻辑分析:**

* **编码器:**将源语言文本转换为中间表示,捕获文本的语义信息。

* **解码器:**使用编码器的输出生成目标语言文本或文本摘要。

* **LSTM层:**在编码器和解码器中学习文本序列中的长期依赖关系。

# 4. LSTM的进阶技巧

### 4.1 双向LSTM

**4.1.1 双向LSTM的结构和优势**

双向LSTM(Bidirectional LSTM)是一种LSTM变体,它可以同时处理序列的正向和反向信息。双向LSTM的结构与标准LSTM类似,但它有两个隐藏层:一个处理正向信息,另一个处理反向信息。

双向LSTM的优势在于,它可以利用序列中的上下文信息,这在处理自然语言处理和时间序列预测等任务时非常有用。通过同时考虑序列的过去和未来信息,双向LSTM可以捕获更丰富的特征表示。

**4.1.2 双向LSTM在文本处理中的应用**

双向LSTM在文本处理任务中得到了广泛的应用,例如:

- **文本分类:**双向LSTM可以捕获文本中前后文的语义信息,从而提高文本分类的准确性。

- **情感分析:**双向LSTM可以同时考虑文本中的积极和消极情绪,从而提高情感分析的性能。

- **机器翻译:**双向LSTM可以利用目标语言的上下文信息来生成更准确的翻译。

### 4.2 注意力机制

**4.2.1 注意力机制的原理和实现**

注意力机制是一种神经网络技术,它允许模型重点关注输入序列中的特定部分。在LSTM中,注意力机制可以帮助模型识别序列中对预测最重要的元素。

注意力机制的实现通常涉及以下步骤:

1. **计算注意力权重:**模型计算每个输入元素的注意力权重,表示该元素对预测的重要性。

2. **加权求和:**模型将注意力权重与输入元素相乘,然后求和,得到一个加权表示。

3. **输出:**加权表示作为LSTM单元的输入,用于生成预测。

**4.2.2 注意力机制在LSTM中的应用**

注意力机制在LSTM中的应用包括:

- **时间序列预测:**注意力机制可以帮助LSTM识别时间序列中最重要的时间步,从而提高预测的准确性。

- **自然语言处理:**注意力机制可以帮助LSTM专注于文本中的关键单词和短语,从而提高文本理解和生成任务的性能。

### 代码示例

**双向LSTM文本分类**

```python

import tensorflow as tf

# 定义双向LSTM模型

model = tf.keras.models.Sequential()

model.add(tf.keras.layers.Bidirectional(tf.keras.layers.LSTM(128), input_shape=(None, 100)))

model.add(tf.keras.layers.Dense(1, activation='sigmoid'))

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(X_train, y_train, epochs=10)

```

**注意力机制时间序列预测**

```python

import tensorflow as tf

# 定义注意力机制LSTM模型

model = tf.keras.models.Sequential()

model.add(tf.keras.layers.LSTM(128, return_sequences=True))

model.add(tf.keras.layers.Attention())

model.add(tf.keras.layers.Dense(1))

# 编译模型

model.compile(optimizer='adam', loss='mean_squared_error', metrics=['accuracy'])

# 训练模型

model.fit(X_train, y_train, epochs=10)

```

### 表格:LSTM进阶技巧总结

| 技巧 | 描述 | 优势 |

|---|---|---|

| 双向LSTM | 同时处理序列的正向和反向信息 | 利用上下文信息,提高准确性 |

| 注意力机制 | 关注输入序列中的特定部分 | 识别重要元素,提高性能 |

### 流程图:LSTM进阶技巧应用

[mermaid]

graph LR

subgraph 双向LSTM应用

A[文本分类] --> B[情感分析] --> C[机器翻译]

end

subgraph 注意力机制应用

D[时间序列预测] --> E[自然语言处理]

end

# 5. LSTM的未来发展和应用前景

LSTM作为一种强大的神经网络模型,在自然语言处理和时间序列预测等领域取得了显著的成功。随着人工智能技术的不断发展,LSTM的未来发展和应用前景广阔。

### 1. 多模态学习

随着多模态数据的兴起,LSTM将被广泛用于处理来自不同模态(如文本、图像、音频)的数据。通过整合多模态信息,LSTM可以更好地理解和处理复杂的数据,从而提高模型的性能。

### 2. 时序数据的建模

LSTM在时序数据建模方面具有独特的优势。未来,LSTM将被用于处理更复杂和长期的时序数据,例如视频序列、传感器数据和医疗记录。通过对时序数据的深入分析,LSTM可以帮助我们更好地理解和预测未来的趋势。

### 3. 知识图谱增强

知识图谱可以为LSTM提供丰富的背景知识和语义信息。通过将LSTM与知识图谱相结合,我们可以创建更智能的模型,能够推理和解释复杂的知识。

### 4. 可解释性增强

尽管LSTM模型的性能强大,但其可解释性一直是一个挑战。未来,研究人员将致力于开发新的方法来提高LSTM的可解释性,以便我们更好地理解模型的决策过程。

### 5. 硬件加速

随着硬件技术的进步,LSTM模型的训练和推理速度将得到显著提高。专用硬件(如GPU和TPU)的出现将使LSTM能够处理更大规模的数据集,从而进一步提升模型的性能。

### 6. 自动化机器学习

自动化机器学习(AutoML)技术可以简化LSTM模型的构建和优化过程。未来,AutoML将使非专业人士也能够轻松地使用LSTM模型解决实际问题。

### 7. 医疗保健

LSTM在医疗保健领域具有巨大的潜力。通过分析医疗记录、传感器数据和图像,LSTM可以帮助诊断疾病、预测治疗效果和个性化治疗方案。

### 8. 金融科技

LSTM在金融科技领域也具有广泛的应用。通过分析市场数据和交易记录,LSTM可以帮助预测股价、识别欺诈行为和优化投资组合。

总之,LSTM作为一种强大的神经网络模型,在未来具有广阔的发展和应用前景。通过持续的研究和创新,LSTM将继续推动人工智能技术的发展,为各个领域带来新的突破和变革。

0

0